EFK的搭建(未完成)

EFK 是ELK 日志分析的一个变种,能够更好的来实现日志分析。

首先我们先准备3台 centos7的服务器,在给他们调成2核2G的状态打开。

| 软件 | 版本号 |

| zookeeper | 3.4.14 |

| Kafka | 2.2.0 |

| logstash | 6.6.0 |

| elasticsearch | 6.6.2 |

| jdk | jdk-8u131-linux-x64_.rpm |

| kibana | 6.6.2 |

我的三台服务器分别为

192.168.153.171 安装了jdk,zookeeper,kafka,filebeat,nginx

192.168.153.172 安装了jdk,zookeeper,kafka,logstash

192.168.153.173 安装了jdk,zookeeper,kafka,elasticsearch,kibana

1 . 首先我们先在每台服务器上安装jdk

cd /usr/local/src

rpm -ivh jdk-8u131-linux-x64_.rpm

2 . 关闭防火墙和selinux

systemctl stop firewalld

setenforce 0

3 . 上传需要使用的安装包到/usr/local/src下

cd /usr/local/src

rz (zookeeper,kafka)

4 . 解压zookeeper,kafka 到/usr/local/下

tar zxf zookeeper-3.4.14.tar.gz

tar zxf kafka_2.11-2.2.0.tgz mv kafka_2.11-2.2.0 /usr/local/kafka

mv zookeeper-3.4.14 /usr/local/zookeeper

5 . 进入 /usr/local/zookeeper

mkdir {zkdata,zkdatalog}

进入/usr/local/zookeeper/conf/

cp zoo_sample.cfg zoo.cfg

6 . 编辑zoo.cfg

vim zoo.cfg

--------------------------------------------------------

tickTime=2000 //zookeeper服务器之间的心跳时间

initLimit=10 //zookeeper的最大链接失败时间

syncLimit=5 //zookeeper的同步通信时间

dataDir=/usr/local/zookeeper/zkdata //zookeeper的存放快照日志的绝对路径

dataLogDir=/usr/local/zookeeper/zkdatalog //zookeeper的存放事物日志的绝对路径

clientPort=2181 //zookeeper与客户端建立连接的端口

server.1=192.168.153.171:2888:3888 //服务器及其编号,服务器IP地址,通信端口,选举端口

server.2=192.168.153.172:2888:3888

server.3=192.168.153.173:2888:3888

----------------------------------------------------------

7 . 在每台机器上写上自己的id

echo '1/2/3' > /usr/local/zookeeper/zkdata/myid

我写的是171为1 172为2 173为3

8 . 开启zookeeper服务

cd /usr/local/zookeeper/bin/

./zkServer.sh start

./zkServer.sh status //Mode: leader为主节点,Mode: follower为从节点,zk集群一般只有一个leader,多个follower,主一般是响应客户端的读写请求,而从主同步数据,当主挂掉之后就会从follower里投票选举一个leader出来。

如果查看状态时为error 我们看一下端口起没起来,zookeeper开启时的顺序是( 1 2 3 ),把 /usr/local/zookeeper/zkdata 下的文件删除,只保留一个我们设置的myid,在进行重启

到此为止 zookeeper 配置完成

搭建kafka

1 . 编辑kafka的配置文件

第一台

cd /usr/local/kafka/config

vim server.properties

*********************

broker.id=1

advertised.listeners=PLAINTEXT://kafka01:9092

zookeeper.connect=192.168.153.171:2181,192.168.153.172:2181,192.168.153.173:2181 (三台服务器的IP地址) 第2台

cd /usr/local/kafka/config

vim server.properties

*********************

broker.id=2

advertised.listeners=PLAINTEXT://kafka02:9092

zookeeper.connect=192.168.153.171:2181,192.168.153.172:2181,192.168.153.173:2181 (三台服务器的IP地址) 第3台

cd /usr/local/kafka/config

vim server.properties

*********************

broker.id=3

advertised.listeners=PLAINTEXT://kafka03:9092

zookeeper.connect=192.168.153.171:2181,192.168.153.172:2181,192.168.153.173:2181 (三台服务器的IP地址)

2 . vim /etc/hosts

192.168.153.171 kafka01

192.168.153.172 kafka02

192.168.153.173 kafka03

3 . 每一台服务器都要启动kafka

cd /usr/local/kafka/bin

./kafka-server-start.sh -daemon ../config/server.properties // 以后台模式启动kafka

4 . 启动之后查看端口是否成功启动

ss -ntlp | grep 9092

5 . 创建主题topics

cd /usr/local/kafka/bin

./kafka-topics.sh --create --zookeeper 192.168.153.171:2181 --replication-factor 2 --partitions 3 --topic wg007 //因为我只做第一台服务器的日志收集,所以我的IP地址为第一台的

6 . 查看主题 如果可以显示出我们所创建的topics 就代表我们创建成功了

7 . 模拟生产者 执行代码之后就会有一个>

cd /usr/local/kafka/bin

./kafka-console-producer.sh --broker-list 192.168.153.171:9092 --topic wg007

>

>

在第二台上模拟消费者

/usr/local/kafka/bin/kafka-console-consumer.sh --bootstrap-server 192.168.153.172:9092 --topic wg007 --from-beginning //可以在任意服务器上执行

写一个脚本用来创建kafka的topic

cd /usr/local/kafka/bin

vim kafka-create-topics.sh

#################################

#!/bin/bash

read -p "请输入一个你想要创建的topic:" topic

cd /usr/local/kafka/bin

./kafka-topics.sh --create --zookeeper 192.168.153.171:2181 --replication-factor 2 --partitions 3 --topic ${topic}

创建一个新的yum源

vim /etc/yum.repo.d/filebeat.repo

***加入以下内容

[filebeat-6.x]

name=Elasticsearch repository for 6.x packages

baseurl=https://artifacts.elastic.co/packages/6.x/yum

gpgcheck=1

gpgkey=https://artifacts.elastic.co/GPG-KEY-elasticsearch

enabled=1

autorefresh=1

type=rpm-md

安装filebeat

yum -y install filebeat

编辑filebeat的配置文件

cd /etc/filebeat

vim filebeat.yml

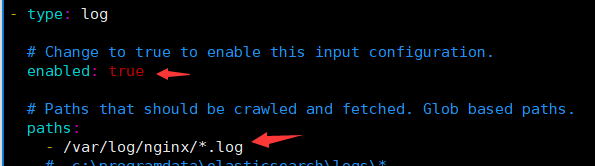

修改以下内容 enabled: true paths:

- /var/log/nginx/*.log //写这个路径的前提是安装nginx output.kafka:

enabled: true

# Array of hosts to connect to.

hosts: ["192.168.153.171:9092","192.168.153.172:9092","192.168.153.173:9092"]

topic: nginx1 //写这个nginx1 的前提是有nginx1的topic 上面有生产者的脚本

安装nginx

yum -y install epel*

yum -y install nginx

启动nginx和filebeat

systemctl start filebeat

systemctl enable filebeat

systemctl start nginx

可以给ningx生产一些数据

yum -y install httpd-tools

ab -n1000 -c 200 http://127.0.0.1/cccc //这条命令可以多执行几次

-----------------------------------------------------------------

curl -I 192.168.18.140:80 然后再检验看日志是否可以同步

现在开始收集多个日志 system nginx secure 和日志 编辑filebeat的配置文件

#讲filebeat的input改成下面的样子 filebeat.inputs:

#这个是收集nginx的日志

- type: log

enabled: true

paths:

- /var/log/nginx/*.log //nginx的日志文件

fields:

log_topics: nginx1 //这个是收集nginx的topic #这个是收集system的日志

- type: log

enabled: true

paths:

- /var/log/messages //system的日志文件目录

fields:

log_topics: messages //这个是收集system的topic #收集secure的日志

- type: log

enabled: true

paths:

- /var/log/secure //secure的日志文件

fields:

log_topics: secure //这个是收集secure的topic output.kafka:

enabled: true

hosts: ["192.168.153.171:9092","192.168.153.172:9092","192.168.153.173:9092"]

topic: '%{[fields][log_topics]}'

注意:一点更要创建三个topic 就是上面的配置文件提到的topic 可以使用上面的脚本创建topic 重启filebeat

systemctl restart filebeat

接下来在第二台安装logstash 在第三台安装ES集群(就是elasticsearch和kibana)

EFK的搭建(未完成)的更多相关文章

- EFK日志搭建

安装java 安装java1.8以上的版本并验证 [root@localhost ~]# yum install java [root@localhost ~]# java -version open ...

- 自己编写k8s

## 基于Docker和Kubernetes的企业级DevOps实践训练营 ### 课程准备 1. 离线镜像包 百度:https://pan.baidu.com/s/1N1AYGCYftYGn6L0Q ...

- Kubernetes 系列(八):搭建EFK日志收集系统

Kubernetes 中比较流行的日志收集解决方案是 Elasticsearch.Fluentd 和 Kibana(EFK)技术栈,也是官方现在比较推荐的一种方案. Elasticsearch 是一个 ...

- centos7搭建EFK日志分析系统

前言 EFK可能都不熟悉,实际上EFK是大名鼎鼎的日志系统ELK的一个变种 在没有分布式日志的时候,每次出问题了需要查询日志的时候,需要登录到Linux服务器,使用命令cat -n xxxx|grep ...

- 转载他人的efk搭建文章后边有链接和地址

EFK教程 - EFK快速入门指南 通过部署elasticsearch(三节点)+filebeat+kibana快速入门EFK,并搭建起可用的demo环境测试效果 目录 ▪ 用途▪ 实验架构▪ E ...

- 搭建ELK和EFK

公司突然发下任务让我搭建elk和efk,于是做完之后写入了博客,生产环境下,亲测可用哦 搭建ELK 一共两台服务器,一个节点(logstash) 主服务器上 修改最大链接和最大打开的文件 1.临时修改 ...

- kubernetes集群EFK日志系统搭建

日志收集架构 Kubernetes 集群本身不提供日志收集的解决方案,一般来说有主要的3种方案来做日志收集: 在节点上运行一个 agent 来收集日志 在 Pod 中包含一个 sidecar 容器来收 ...

- Docker搭建EFK日志收集系统,并自定义es索引名

EFK架构图 一.EFK简介 EFK不是一个软件,而是一套解决方案,并且都是开源软件,之间互相配合使用,完美衔接,高效的满足了很多场合的应用,是目前主流的一种日志系统. EFK是三个开源软件的缩写,分 ...

- Kubernetes 日志:搭建 EFK 日志系统

Kubernetes 中比较流行的日志收集解决方案是 Elasticsearch.Fluentd 和 Kibana(EFK)技术栈,也是官方现在比较推荐的一种方案. Elasticsearch 是一个 ...

随机推荐

- this绑定方式总结

最近在回顾js的一些基础知识,把<你不知道的js>系列又看了一遍,this始终是重中之重,还是决定把this相关知识做一个系统的总结,也方便自己日后回顾. this的四条绑定规则 1.默认 ...

- 如何编译和使用自定义Qt动态链接库 | how to build and use user-defined qt library

本文首发于个人博客https://kezunlin.me/post/cf628dd8/,欢迎阅读! guide to build qt library and use in another proje ...

- 程序员用于机器学习编程的Python 数据处理库 pandas 入门教程

入门介绍 pandas适合于许多不同类型的数据,包括: · 具有异构类型列的表格数据,例如SQL表格或Excel数据 · 有序和无序(不一定是固定频率)时间序列数据. · 具有行列标签的任意矩阵数据( ...

- 正则表达式 第六篇:调用CLR函数执行正则查询

在SQL Server数据库中可以执行模糊查询,像like子句,和全文查询(Fulltext search),但是无法直接执行正则查找,SQL Server没有执行正则表达式的内置函数,但是我们可以创 ...

- Webstrom怎么修改主题

开发Node.js程序,当选首选的是webstorm IDE工具,这个不用解释.但是可能很多习惯其它IDE的同学在使用Webstorm的时候,后感觉webstorm的主题,并不怎么适合自己的审美.就 ...

- AVLTree的Python实现

AVLTree 自己最近在学习数据结构,花了几天理解了下AVLTree的实现,简单一句话概括就是先理解什么是旋转,然后弄明白平衡因子在各种旋转后是如何变化的.最后整理了下学习的过程,并尽量用图片解释, ...

- c语言l博客作业09

问题 答案 这个作业属于那个课程 C语言程序设计II 这个作业要求在哪里 https://edu.cnblogs.com/campus/zswxy/CST2019-2/homework/8655 我在 ...

- .NET进阶篇06-async异步、thread多线程4

知识需要不断积累.总结和沉淀,思考和写作是成长的催化剂 梯子 一.锁1.lock2.Interlocked3.Monitor4.SpinLock5.Mutex6.Semaphore7.Events1. ...

- Spring面试题集锦(精选)

以下来自网络收集,找不到原文出处.此次主要为了面试收集,希望对大家有所帮助~~~~ 1.什么是Spring? Spring是一个开源的Java EE开发框架.Spring框架的核心功能可以应用在任何J ...

- redis与memcached区别

不同点: (1) redis中并不是所有数据在有效期内只能常驻内存的(如果需要,可定期同步持久化到磁盘),这是和memcached相比一个最大的区别(memcached中的数据在有效期内是以键值对的形 ...