Scala,Java,Python 3种语言编写Spark WordCount示例

首先,我先定义一个文件,hello.txt,里面的内容如下:

hello spark

hello hadoop

hello flink

hello storm

Scala方式

scala版本是2.11.8。

配置maven文件,三个依赖:

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>2.6.0-cdh5.7.0</version>

</dependency>

<dependency>

<groupId>org.scala-lang</groupId>

<artifactId>scala-library</artifactId>

<version>2.11.8</version>

</dependency>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-core_2.11</artifactId>

<version>2.2.0</version>

</dependency>

package com.darrenchan.spark

import org.apache.spark.{SparkConf, SparkContext}

object SparkCoreApp2 {

def main(args: Array[String]): Unit = {

val sparkConf = new SparkConf().setMaster("local[2]").setAppName("WordCountApp")

val sc = new SparkContext(sparkConf)

//业务逻辑

val counts = sc.textFile("D:\\hello.txt").

flatMap(_.split(" ")).

map((_, 1)).

reduceByKey(_+_)

println(counts.collect().mkString("\n"))

sc.stop()

}

}

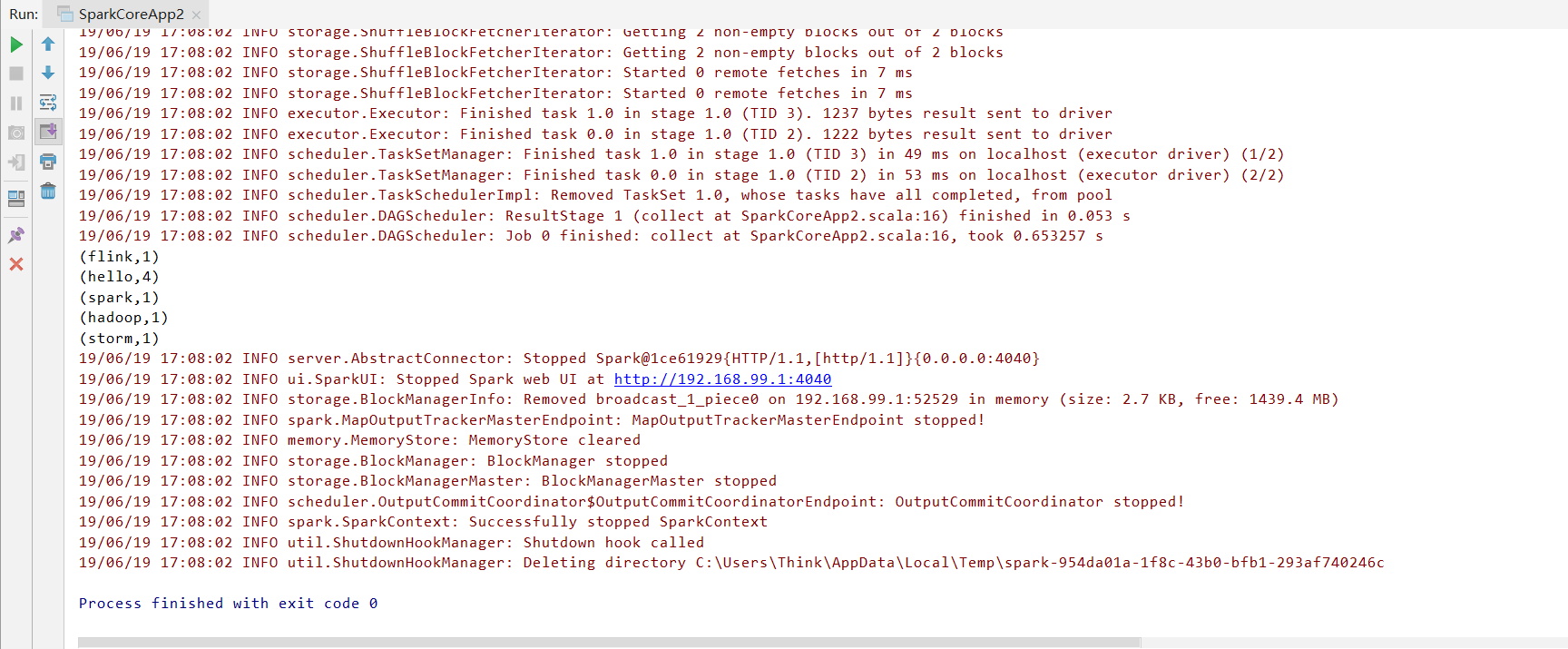

运行结果:

Java方式

Java8,用lamda表达式。

package com.darrenchan.spark.javaapi; import org.apache.spark.SparkConf;

import org.apache.spark.SparkContext;

import org.apache.spark.api.java.JavaPairRDD;

import org.apache.spark.api.java.JavaRDD;

import org.apache.spark.api.java.JavaSparkContext;

import org.apache.spark.sql.SparkSession;

import scala.Tuple2; import java.util.Arrays; public class WordCountApp2 {

public static void main(String[] args) {

SparkConf sparkConf = new SparkConf().setMaster("local[2]").setAppName("WordCountApp");

JavaSparkContext sc = new JavaSparkContext(sparkConf); //业务逻辑

JavaPairRDD<String, Integer> counts =

sc.textFile("D:\\hello.txt").

flatMap(line -> Arrays.asList(line.split(" ")).iterator()).

mapToPair(word -> new Tuple2<>(word, 1)).

reduceByKey((a, b) -> a + b); System.out.println(counts.collect()); sc.stop();

}

}

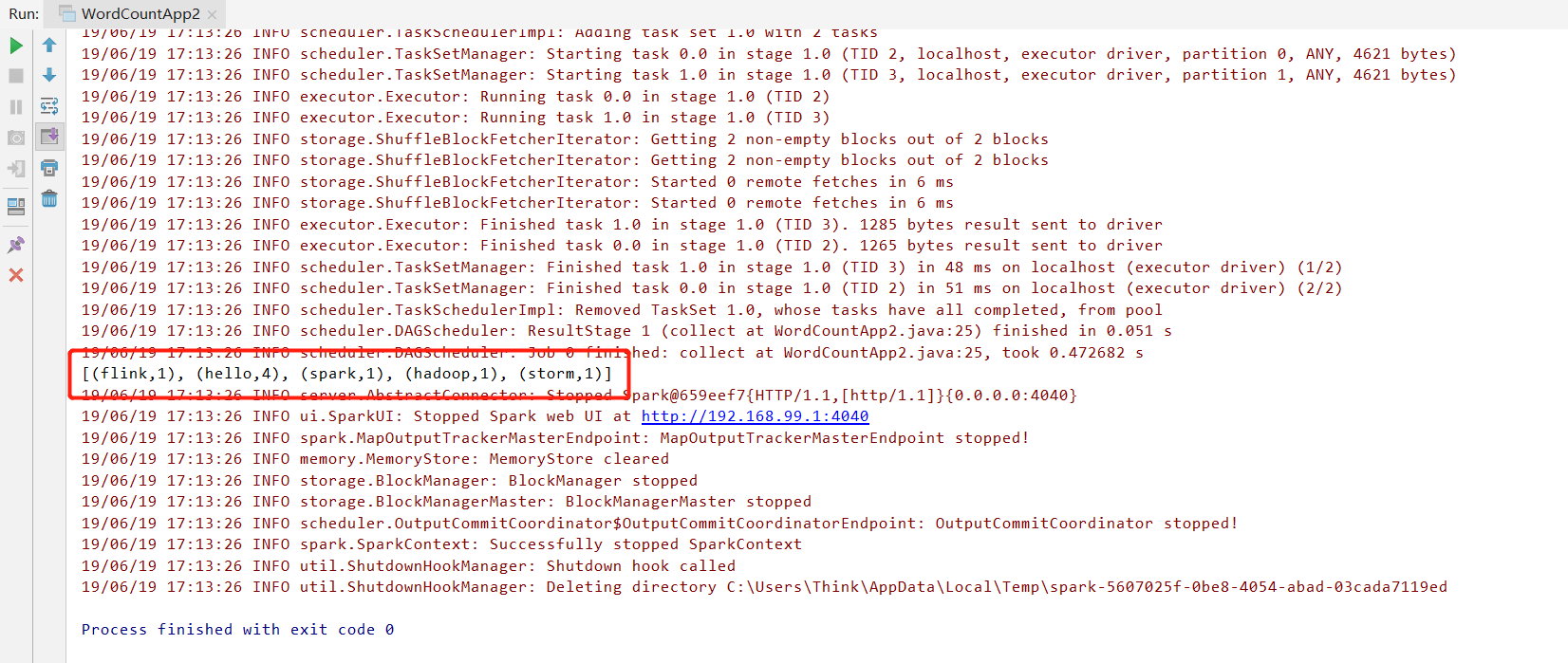

运行结果:

Python方式

Python 3.6.5。

from pyspark import SparkConf, SparkContext def main():

# 创建SparkConf,设置Spark相关的参数信息

conf = SparkConf().setMaster("local[2]").setAppName("spark_app")

# 创建SparkContext

sc = SparkContext(conf=conf) # 业务逻辑开发

counts = sc.textFile("D:\\hello.txt").\

flatMap(lambda line: line.split(" ")).\

map(lambda word: (word, 1)).\

reduceByKey(lambda a, b: a + b) print(counts.collect()) sc.stop() if __name__ == '__main__':

main()

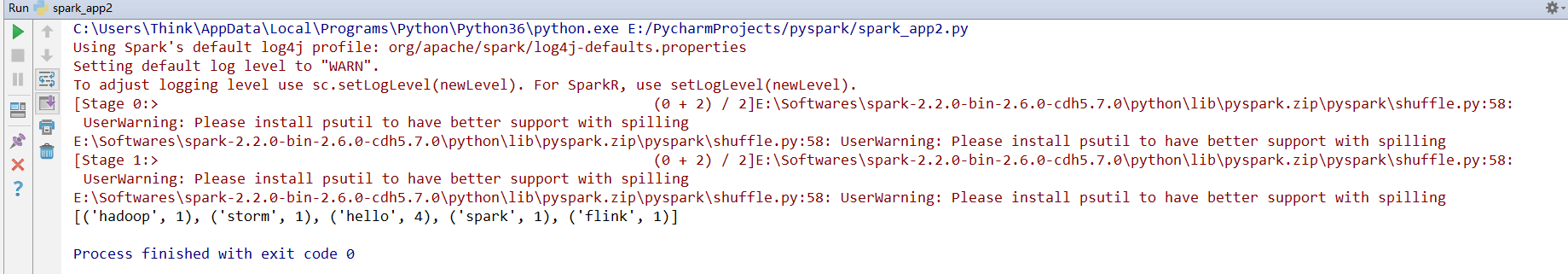

运行结果:

使用Python在Windows下运行Spark有很多坑,详见如下链接:

http://note.youdao.com/noteshare?id=aad06f5810f9463a94a2d42144279ea4

Scala,Java,Python 3种语言编写Spark WordCount示例的更多相关文章

- 插入算法分别从C,java,python三种语言进行书写

真正学懂计算机的人(不只是“编程匠”)都对数学有相当的造诣,既能用科学家的严谨思维来求证,也能用工程师的务实手段来解决问题——而这种思维和手段的最佳演绎就是“算法”. 作为一个初级编程人员或者说是一个 ...

- 梯度迭代树(GBDT)算法原理及Spark MLlib调用实例(Scala/Java/python)

梯度迭代树(GBDT)算法原理及Spark MLlib调用实例(Scala/Java/python) http://blog.csdn.net/liulingyuan6/article/details ...

- 近50种语言编写的“Hello, World”,你会几种?可不要贪杯哦~

本文转自公众号CSDN(ID:CSDNnews)作者:Sylvain Saurel,译者:风车云马

- 三种文本特征提取(TF-IDF/Word2Vec/CountVectorizer)及Spark MLlib调用实例(Scala/Java/python)

https://blog.csdn.net/liulingyuan6/article/details/53390949

- spark Using MLLib in Scala/Java/Python

Using MLLib in ScalaFollowing code snippets can be executed in spark-shell. Binary ClassificationThe ...

- 朴素贝叶斯算法原理及Spark MLlib实例(Scala/Java/Python)

朴素贝叶斯 算法介绍: 朴素贝叶斯法是基于贝叶斯定理与特征条件独立假设的分类方法. 朴素贝叶斯的思想基础是这样的:对于给出的待分类项,求解在此项出现的条件下各个类别出现的概率,在没有其它可用信息下,我 ...

- Spark机器学习1·编程入门(scala/java/python)

Spark安装目录 /Users/erichan/Garden/spark-1.4.0-bin-hadoop2.6 基本测试 ./bin/run-example org.apache.spark.ex ...

- idea配置scala编写spark wordcount程序

1.创建scala maven项目 选择骨架的时候为org.scala-tools.archetypes:scala-aechetype-simple 1.2 2.导入包,进入spark官网Docum ...

- Java用n种方法编写实现双色球随机摇号案例

方法清单 规则 实现方式一 实现方式二 实现方式三 实现方式四 实现方法五 之前我用JavaScript编写过一个实现双色球随机摇号的案例, 点击此处查看,今天我再用Java语言来实现这一效果. 规则 ...

随机推荐

- 华为hcnp r&s考试一共有三门,R&S-IERS,R&S-IENP,R&S-IEEP

大纲1.HCNP-R&S-IEEP V2.0考试大纲 考试内容:HCNP-R&S-IEEP考试覆盖对企业网络的规划.设计.实施.维护.排障.优化以及网络割接等. 知识点: 网络规划:1 ...

- git版本对比

1.git diff版本比对 (未添加到暂存区间之前的区别对比) 未进行修改,则显示为空 进行文件修改,再执行git diff 当执行git add . 之后,再次git diff则为空 缓存和提交 ...

- jmeter相关知识学习记录

基于Jmeter5.2.1 断言之响应断言 响应断言:对服务器的响应接口进行断言校验,来判断接口测试得到的接口返回值是否正确. 测试字段就是指要断言的内容的匹配处. 响应文本:就是响应的body部分: ...

- acwing 850. Dijkstra求最短路 II 模板

地址 https://www.acwing.com/problem/content/description/852/ 给定一个n个点m条边的有向图,图中可能存在重边和自环,所有边权均为非负值. 请你求 ...

- ansible+playbook 搭建lnmp环境

用三台机器 做ansible+playbook 搭建lnmp环境 IP分配 ansible 主机192.168.202.132 lnmp第一台主机 192.168.202.131 lnmp第一台主机 ...

- 深度学习VGG16模型核心模块拆解

原文连接:https://blog.csdn.net/qq_40027052/article/details/79015827 注:这篇文章是上面连接作者的文章.在此仅作学习记录作用. 如今深度学习发 ...

- ASP.NET Server对象

Server.HtmlEncode() 执行文本代码Server.HtmlDecode()可以将代码显示 而不是执行它 但是ASP.NET会认为恶意 我们可以将aspx代码开头添加validateRe ...

- date:显示与设置系统时间

功能: date命令用于显示当前的系统时间或设置系统时间 语法格式: date [option] [+format] date [选项] [+日期格式] 参数选项: option 参数选项: -d ...

- ASP.NET MVC教程二:ASP.NET MVC应用程序结构详解

在上一篇文章中,讲解了一些MVC的概念,并且创建了第一个ASP.NET MVC项目,这篇文章将讲解ASP.NET MVC程序中的代码解构,新创建的MVC应用程序解构如下图所示: 一.App_Data ...

- 基于JWT的Token登录认证

1.JWT简介 JSON Web Token(缩写 JWT),是目前最流行的跨域认证解决方案. 2.JWT的原理 JWT的原理是,服务器认证以后,生成一个JSON格式的对象,发回给客 ...