HDFS存入文件的整个流程

本文结合HDFS的副本和分块从宏观上描述HDFS存入文件的整个流程。HDFS体系中包含Client、NameNode、DataNode、SeconderyNameode四个角色,其中Client是客户端,NN负责管理,DN负责存储、SN协助管理。

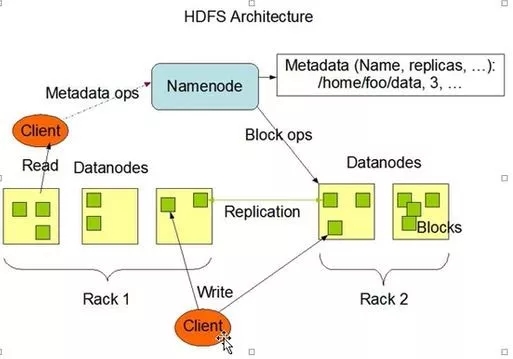

先来看一个官网上的图

# 图 0 -HDFS的体系结构

HDFS的副本存储有如下规则:

1.client将第一副本放到最靠近的一台DN

2.第二副本优先放到另一个机架

3.以此类推,尽量保证副本放在不同的机架

由于副本和分块机制的存在,当从本地文件系统向HDFS上传文件时,其内部的流程相对比较复杂,可以通过下图及步骤说明进行理解。

# 图 1-1 -hdfs副本存储机制(3副本)

A.对于可存于单块的小文件:

1.client向NN(NameNode)发起存储请求,

2.NN查找自身是否已有相应的文件,

3.若无则,NN向client返回DN1(DataNode)路径,

4.client向DN1传送副本,

5.DN1通过管道异步向DN2传副本,

6.DN2通过管道异步向DN3传副本,

7.DN3通知DN2接收完成,

8.DN2通知DN1接收完成,

9.DN1通知NN接收完成。

B.对于需要分块的大文件:

大致流程同上,但在步骤3NN还会进行块的划分,随后步骤4client会将各块分别发送到分配的DN执行步骤4~9

从前述可见,在向HDFS传输文件的过程中,NameNode节点至关重要。NN负责掌管元数据。其作用相当于物理硬盘中的文件分配表FAT,NN中的数据如果发生丢失,DN中存储的数据也就没有了意义。

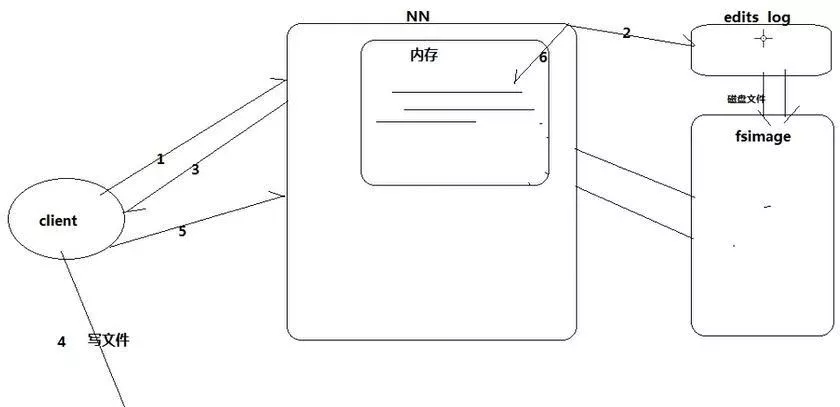

# 图 1-2 -NN元数据存储机制

1.client向NN请求写,

2.NN将分配block写入editslog文件,

3.NN响应client,

4.client向DN写文件,

5.client通知NN写完成,

6.NN将editslog更新到内存。

ps:常用及最新元数据放在内存,最新元数据放editslog,老元数据放fsimage,editslog写满之前将edits log(新元数据)转换并合并到fsimage。

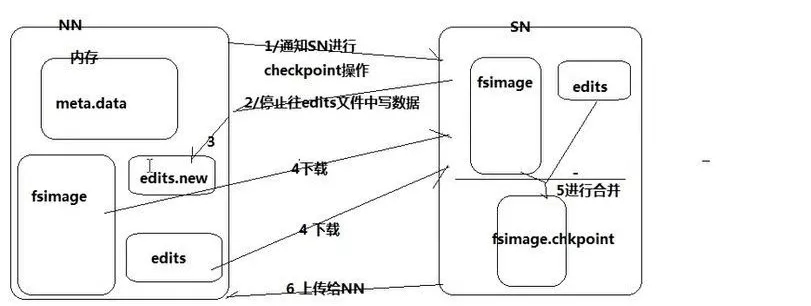

# 图 1-3 -edits log合并机制

当editslog写满:

1.NN通知SecondryNameNode执行checkpoint操作,

2.NN停止向已满editslog写入,

3.NN创建新edits log维持写入,

4.SN下载NN的fsimage和已满editslog,

5.SN执行合并生成fsimage。checkpoint,

6.SN向NN上传fsi。cp,

7.NN将fsi。cp改名fsimage,

8.NN删除已满editslog。

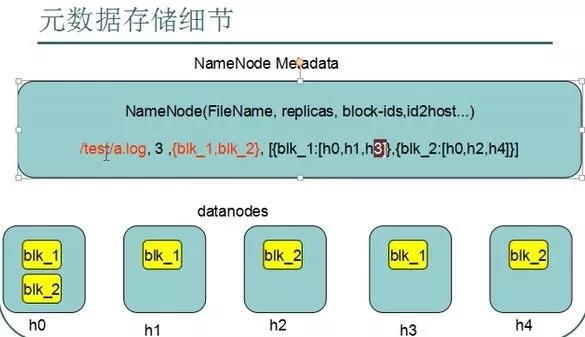

# 图3 -元数据格式:文件全路径,副本数,块编号,块-所在DN的映射。

HDFS存入文件的整个流程的更多相关文章

- hadoop 提高hdfs删文件效率----hadoop删除文件流程解析

前言 这段时间在用hdfs,由于要处理的文件比较多,要及时产出旧文件,但是发现hdfs的blocks数一直在上涨,经分析是hdfs写入的速度较快,而block回收较慢,所以分心了一下hadoop删文件 ...

- 【Hadoop】HDFS - 创建文件流程详解

1.本文目的 通过解析客户端创建文件流程,认知hadoop的HDFS系统的一些功能和概念. 2.主要概念 2.1 NameNode(NN): HDFS系统核心组件,负责分布式文件系统的名字空间管理.I ...

- hadoop学习笔记(六):HDFS文件的读写流程

一.HDFS读取文件流程: 详解读取流程: Client调用FileSystem.open()方法: 1 FileSystem通过RPC与NN通信,NN返回该文件的部分或全部block列表(含有blo ...

- HDFS写文件过程分析

转自http://shiyanjun.cn/archives/942.html HDFS是一个分布式文件系统,在HDFS上写文件的过程与我们平时使用的单机文件系统非常不同,从宏观上来看,在HDFS文件 ...

- 使用oracle的大数据工具ODCH访问HDFS数据文件

软件下载 Oracle Big Data Connectors:ODCH 下载地址: http://www.oracle.com/technetwork/bdc/big-data-connectors ...

- (转)distcp从ftp到hdfs拷贝文件

link :http://blog.csdn.net/sptoor/article/details/11523469 distcp从ftp到hdfs拷贝文件: hadoop distcp ftp:// ...

- Spark中加载本地(或者hdfs)文件以及SparkContext实例的textFile使用

默认是从hdfs读取文件,也可以指定sc.textFile("路径").在路径前面加上hdfs://表示从hdfs文件系统上读 本地文件读取 sc.textFile("路 ...

- HDFS的Java客户端操作代码(HDFS删除文件或目录)

1.HDFS删除文件或目录 package Hdfs; import java.io.IOException; import java.net.URI; import org.apache.hadoo ...

- Hadoop HDFS分布式文件系统设计要点与架构

Hadoop HDFS分布式文件系统设计要点与架构 Hadoop简介:一个分布式系统基础架构,由Apache基金会开发.用户可以在不了解分布式底层细节的情况下,开发分布式程序.充分利用集群 ...

随机推荐

- SI522和RC522/ZS3801/FM17520的区别

小编最近在测试一颗新的芯片,是国内知名厂家中科微研发的,主打超低功耗的厂家. 经过测试和比较小编发现 相对于MFRC522,SI522可以完全替换,不需要做任何更改,同时接受模式下功耗低10mA左右, ...

- Xcode 10 Error: Multiple commands produce

目录 Xcode 9.4.1运行react-native 可以,但是在Xcode 10运行报错,报错信息如下: 解决方法 1. 选择 File > Project Settings (或者 Fi ...

- django学习03-模版

新手做的笔记,很可能会有理解错误的地方.欢迎拍砖. 在polls/views.py中增加下面内容,完善功能. def detail(request, question_id): return Http ...

- 每周一练 之 数据结构与算法(Tree)

这是第六周的练习题,最近加班比较多,上周主要完成一篇 GraphQL入门教程 ,有兴趣的小伙伴可以看下哈. 下面是之前分享的链接: 1.每周一练 之 数据结构与算法(Stack) 2.每周一练 之 数 ...

- Mechanical Design Optimization with Abaqus and Isight

一.项目背景 本项目为"ME327机械优化设计方法"课程项目. 如何合理利用更轻更强的材料,是机器人结构设计值得深究的问题.在驱动的功率一定的情况下,更轻的机械结构意味着电机承受更 ...

- django甜甜的弹窗

GitHub中甜甜的弹窗地址: https://github.com/lipis/bootstrap-sweetalert 直接简单粗暴选择右下角的download,下载到本地一份文件 小猿取经中的相 ...

- Mybatis使用心德

什么是Mybatis? Mybatis是一个半ORM(对象关系映射)框架,它内部封装了JDBC,开发时只需要关注SQL语句本身,不需要花费精力去处理加载驱动.创建连接.创建statement等繁杂的过 ...

- Python面向对象-多重继承之MixIN

以Animal类为例,假设要实现以下4种动物: Dog(狗).Bat(蝙蝠).Parrot(鹦鹉)和Ostrich(鸵鸟) 如果按照哺乳类和鸟类来区分的话,可以这样设计: Animal: |--Mam ...

- CSS 选择器、字体/文本、背景

CSS的基本使用 直接写在标签内 <p style="color: red; font-size: 40px;">段落</p> 写在 style 标签内 & ...

- 第01讲 Android开发系列---Activity

一. Android系统版本及详细信息 最新数据 https://developer.android.com/about/dashboards/ 二. Android项目初探 1. 使用a ...