一个简单的java爬虫

直接上代码:

package com.jeecg.util; import java.io.BufferedReader;

import java.io.IOException;

import java.io.InputStream;

import java.io.InputStreamReader;

import java.io.OutputStream;

import java.net.HttpURLConnection;

import java.net.MalformedURLException;

import java.net.URL;

import java.util.LinkedHashMap;

import java.util.Map;

import java.util.regex.Matcher;

import java.util.regex.Pattern; import javax.net.ssl.HttpsURLConnection;

import javax.net.ssl.SSLContext;

import javax.net.ssl.SSLSocketFactory;

import javax.net.ssl.TrustManager; public class WebCrawlerDemo {

public static void main(String[] args) {

WebCrawlerDemo webCrawlerDemo = new WebCrawlerDemo();

webCrawlerDemo.myPrint("https://kyfw.12306.cn/");

}public void myPrint(String baseUrl) {

Map<String, Boolean> oldMap = new LinkedHashMap<String, Boolean>();

// 存储链接-是否被遍历

// 键值对

String oldLinkHost = ""; // host

Pattern p = Pattern.compile("(https?://)?[^/\\s]*");

// 比如:http://www.zifangsky.cn

Matcher m = p.matcher(baseUrl);

if (m.find()) {

oldLinkHost = m.group();

}

oldMap.put(baseUrl, false);

oldMap = crawlLinks(oldLinkHost, oldMap);

//oldMap = crawlLinks(baseUrl, oldMap);

for (Map.Entry<String, Boolean> mapping : oldMap.entrySet()) {

System.out.println("链接:" + mapping.getKey());

}

} /**

* * 抓取一个网站所有可以抓取的网页链接,在思路上使用了广度优先算法 *

* 对未遍历过的新链接不断发起GET请求,一直到遍历完整个集合都没能发现新的链接 * 则表示不能发现新的链接了,任务结束 * * @param

* oldLinkHost 域名,如:http://www.zifangsky.cn * @param oldMap 待遍历的链接集合 *

* * @return 返回所有抓取到的链接集合 *

*/

private Map<String, Boolean> crawlLinks(String oldLinkHost, Map<String, Boolean> oldMap) {

Map<String, Boolean> newMap = new LinkedHashMap<String, Boolean>();

String oldLink = "";

for (Map.Entry<String, Boolean> mapping : oldMap.entrySet()) {

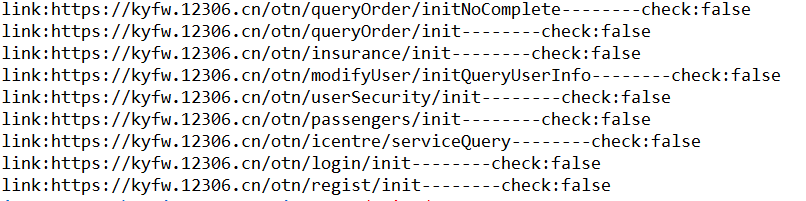

System.out.println("link:" + mapping.getKey() + "--------check:" + mapping.getValue());

// 如果没有被遍历过

if (!mapping.getValue()) {

oldLink = mapping.getKey();

// 发起GET请求

try {

URL url = new URL(oldLink);

HttpURLConnection connection = (HttpURLConnection) url.openConnection();

connection.setRequestMethod("GET");

connection.setConnectTimeout(2000);

connection.setReadTimeout(2000);

if (connection.getResponseCode() == 200) {

InputStream inputStream = connection.getInputStream();

BufferedReader reader = new BufferedReader(new InputStreamReader(inputStream, "UTF-8"));

String line = "";

Pattern pattern = Pattern.compile("<a.*?href=[\"']?((https?://)?/?[^\"']+)[\"']?.*?>(.+)</a>");

Matcher matcher = null;

while ((line = reader.readLine()) != null) {

matcher = pattern.matcher(line);

if (matcher.find()) {

String newLink = matcher.group(1).trim();

// 链接

// String title = matcher.group(3).trim(); //标题

// 判断获取到的链接是否以http开头

if (!newLink.startsWith("http")) {

if (newLink.startsWith("/"))

newLink = oldLinkHost + newLink;

else

newLink = oldLinkHost + "/" + newLink;

}

// 去除链接末尾的 /

if (newLink.endsWith("/"))

newLink = newLink.substring(0, newLink.length() - 1);

// 去重,并且丢弃其他网站的链接

if (!oldMap.containsKey(newLink) && !newMap.containsKey(newLink)

&& newLink.startsWith(oldLinkHost)) {

// System.out.println("temp2: " + newLink);

newMap.put(newLink, false);

}

}

}

}

} catch (MalformedURLException e) {

e.printStackTrace();

} catch (IOException e) {

e.printStackTrace();

}

try {

Thread.sleep(1000);

} catch (InterruptedException e) {

e.printStackTrace();

} oldMap.put(oldLink, true);

}

}

// 有新链接,继续遍历

if (!newMap.isEmpty()) {

oldMap.putAll(newMap);

oldMap.putAll(crawlLinks(oldLinkHost, oldMap));

// 由于Map的特性,不会导致出现重复的键值对

}

return oldMap;

} }

运行结果如下:

一个简单的java爬虫的更多相关文章

- Java实现一个简单的网络爬虫

Java实现一个简单的网络爬虫 import java.io.BufferedReader; import java.io.BufferedWriter; import java.io.FileWri ...

- 超简单的java爬虫

最简单的爬虫,不需要设定代理服务器,不需要设定cookie,不需要http连接池,使用httpget方法,只是为了获取html代码... 好吧,满足这个要求的爬虫应该是最基本的爬虫了.当然这也是做复杂 ...

- 一个简单的Java web服务器实现

前言 一个简单的Java web服务器实现,比较简单,基于java.net.Socket和java.net.ServerSocket实现: 程序执行步骤 创建一个ServerSocket对象: 调用S ...

- Java学习笔记 11/15:一个简单的JAVA例子

首先来看一个简单的 Java 程序. 来看下面这个程序,试试看是否看得出它是在做哪些事情! 范例:TestJava.java // TestJava.java,java 的简单范例 public ...

- Java入门篇(一)——如何编写一个简单的Java程序

最近准备花费很长一段时间写一些关于Java的从入门到进阶再到项目开发的教程,希望对初学Java的朋友们有所帮助,更快的融入Java的学习之中. 主要内容包括JavaSE.JavaEE的基础知识以及如何 ...

- 一个简单的python爬虫程序

python|网络爬虫 概述 这是一个简单的python爬虫程序,仅用作技术学习与交流,主要是通过一个简单的实际案例来对网络爬虫有个基础的认识. 什么是网络爬虫 简单的讲,网络爬虫就是模拟人访问web ...

- python实现的一个简单的网页爬虫

学习了下python,看了一个简单的网页爬虫:http://www.cnblogs.com/fnng/p/3576154.html 自己实现了一个简单的网页爬虫,获取豆瓣的最新电影信息. 爬虫主要是获 ...

- Ant—使用Ant构建一个简单的Java工程(两)

博客<Ant-使用Ant构建一个简单的Java项目(一)>演示了使用Ant工具构建简单的Java项目,接着这个样例来进一步学习Ant: 上面样例须要运行多条ant命令才干运行Test类中的 ...

- 一个简单的C#爬虫程序

这篇这篇文章主要是展示了一个C#语言如何抓取网站中的图片.实现原理就是基于http请求.C#给我们提供了HttpWebRequest和WebClient两个对象,方便发送请求获取数据,下面看如何实 1 ...

随机推荐

- layui加载显示问题

1.layui.config({ base: '../layuiadmin/' //静态资源所在路径 }).extend({ index: 'lib/index' //主入口模块 }).use(['i ...

- Java开发环境之Eclipse

查看更多Java开发环境配置,请点击<Java开发环境配置大全> 拾壹章:Eclipse安装教程 1)去官网下载安装包 http://www.eclipse.org/downloads/ ...

- 一、Linux_文件操作

1.复制文件到当前目录: # 复制文件到当前目录下, ./表示当前目录 $ cp /home/book/poems.tar.gz ./ # 复制并改名,并存放在当前目录下 (cp源文件名 新文件名) ...

- Multi-Task Feature Learning for Knowledge Graph Enhanced Recommendation(知识图谱)

知识图谱(Knowledge Graph,KG)可以理解成一个知识库,用来存储实体与实体之间的关系.知识图谱可以为机器学习算法提供更多的信息,帮助模型更好地完成任务. 在推荐算法中融入电影的知识图谱, ...

- django-列表分页和排序

视图函数views.py # 种类id 页码 排序方式 # restful api -> 请求一种资源 # /list?type_id=种类id&page=页码&sort=排序方 ...

- Sql语句中Like嵌套用法

一般的Like用法: SELECT U_NAME FROM T_USER WHERE U_NAME LIKE '%A%' 但是,我此次like关键字后面的对应值是一个变量,需要用select语句来实现 ...

- Python中如何使用线程池和进程池?

进程池的使用 为什么要有进程池?进程池的概念. 在程序实际处理问题过程中,忙时会有成千上万的任务需要被执行,闲时可能只有零星任务. 那么在成千上万个任务需要被执行的时候,我们就需要去创建成千上万个进程 ...

- 2020年假期sql excel文件 获取

下载地址: https://files.cnblogs.com/files/shmily3929/2020.zip 说明:sql 不区分节假期和周六周末 excel文件区分节假日和周六周末

- oracle 游标使用详解

-- 声明游标:CURSOR cursor_name IS select_statement--For 循环游标--(1)定义游标--(2)定义游标变量--(3)使用for循环来使用这个游标decla ...

- 洛谷 P1063 能量项链 题解

P1063 能量项链 题目描述 在\(Mars\)星球上,每个\(Mars\)人都随身佩带着一串能量项链.在项链上有\(N\)颗能量珠.能量珠是一颗有头标记与尾标记的珠子,这些标记对应着某个正整数.并 ...