python爬虫requests模块

requests库的七个主要方法

1. requests.requests(method, url, **kwargs)

构造一个请求,支撑以下各方法的基础方法

method:请求方式,对应get/put/post等七中方法;

url:拟获取页面的url链接;

**kwargs:控制访问的参数,共13个;

method:请求方式

GET:请求获取url位置的资源;

HEAD:获得该资源的头部信息;

POST:请求向url位置的资源后附加新的数据;

PUT:请求向url位置存储一个资源,覆盖原url位置的资源;

PATCH:请求局部更新url位置的资源,即改变该处资源的部分内容;

DELETE:请求删除url位置存储的资源;

**kwargs:控制访问的参数,均为可选

params:字典或字节序列,作为参数增加到url中;

data:字典,字节序列或文件对象,作为Requests的内容;

json:Json格式的数据,作为Requests的内容;

headers:字典,HTTP定制头;

cookies:字典或cookiejar,Requests中的cookie;

auth:元组,支持HTTP认证功能;

files:字典类型,传输文件;

timeout:设定超超时时间,秒为单位;

proxies:字典类型,设定访问代理服务器,可以增加登记认证;

allow_redirests:True/Flase,默认为True,重定向开关;

stream:True/False,默认为True,获取内容立即下载开关;

verify:True/False,默认为True,认证SSL证书开关;

cert:本地SSL证书路径;

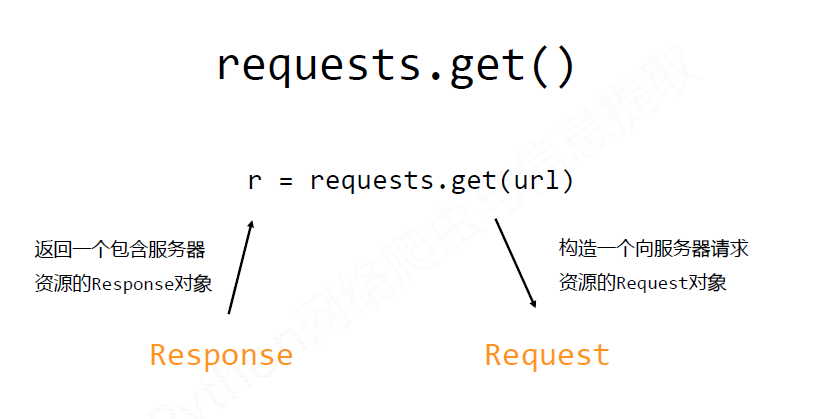

2. request.get(url, params=None, **kwargs)

获取HTML网页的主要方法,对应HTTP的GET;

params:url中额外参数,字典或字节流格式,可选;

**kwargs:12个控制访问参数;

3.requests.head(url, **kwargs)

获取HTML网页头信息方法,对应HTTP的HEAD;

**kwarge:12个控制访问参数;

4.requests.post(url, data=None, json=None, **kwargs)

向HTML网页提交post请求的方法,对应HTTP的POST;

data;字典、字节序列或文件,Requests的内容;

json:Json格式的数据,Requests的内容;

**kwargs:12个控制访问参数;

5.requests.put(url, data=None, **kwargs)

向HTML网页提交PUT请求方法,对应HTTP的PUT;

data:字典、字节序列或文件,Requests的内容;

**kwargs:12个控制访问参数;

6. requests.patch(url, data=None, **kwargs)

向HTML页面提交局部修请求,对应HTTP的PATCH;

data:字典、字节序列或文件,Requests的内容;

**kwagrs:12个控制访问参数;

7. requests.delete(uel, **kwagrs)

向HTML页面提交删除请求,对对应HTTP的DELETE;

**kwagrs:12个访问控制的参数;

requests库的两个重要的对象

Response对象的属性

1. r.status_code

HTTP请求的返回状态,200表示链接成功,404或其他表示失败;

2. r.text

HTTP响应内容的字符串形式,即url对应的页面内容;

3. r.encoding

从HTTP header中猜测的响应内容编码方式;

如果header中不存在charset,则认为编码为ISO-8859-1,r.text根据r.encoding显示网页内容;

4. r.apparent_encoding

从内容中分析出的响应内容编码方式(备选编码方式);

5. r.content

HTTP响应内容的二进制形式;

Requests库的异常

1. requests.ConnectionError

网络连接错误异常,如DNS查询失败,拒绝链接等;

2. requests.HTTPError

HTTP错误异常;

3. requests.URLRequired

url缺失异常;

4.requests.TooManyRedirects

超出最大重定向次数,产生重定向异常;

5. requests.ConnectTimeout

连接远程服务器超时异常;

6. requests.Timeout

请求url超时,产生超时异常;

7.r.raise_for_status()

如果不是200,产生异常requests.HTTPError;

爬取网页的通用代码框架

import requests

def getHTMLText(url):

try:

r = requests.get(url, timeout=30)

r.raise_for_status()

#RU如果状态不是200,引发HTTPError异常

r.encoding() = r.appearent_conding()

return r.text

except:

return "产生异常"

if __name__ == "__main__":

url = "www.baidu.com"

print(getHTMLText(url))

python爬虫requests模块的更多相关文章

- python 爬虫 requests模块 目录

requests模块(response常用属性) 基于requests模块的get请求 基于requests模块发起ajax的get请求 基于requests模块发起ajax的post请求

- python 爬虫 requests模块(response常用属性)

response常用属性 content获取的response对象中的二进制(byte)类型的页面数据response.content 返回响应状态码response.status_code 200 ...

- Python爬虫之使用Fiddler+Postman+Python的requests模块爬取各国国旗

介绍 本篇博客将会介绍一个Python爬虫,用来爬取各个国家的国旗,主要的目标是为了展示如何在Python的requests模块中使用POST方法来爬取网页内容. 为了知道POST方法所需要传 ...

- Python爬虫—requests库get和post方法使用

目录 Python爬虫-requests库get和post方法使用 1. 安装requests库 2.requests.get()方法使用 3.requests.post()方法使用-构造formda ...

- python爬虫 urllib模块url编码处理

案例:爬取使用搜狗根据指定词条搜索到的页面数据(例如爬取词条为‘周杰伦'的页面数据) import urllib.request # 1.指定url url = 'https://www.sogou. ...

- python 爬虫 urllib模块 目录

python 爬虫 urllib模块介绍 python 爬虫 urllib模块 url编码处理 python 爬虫 urllib模块 反爬虫机制UA python 爬虫 urllib模块 发起post ...

- Python之requests模块-hook

requests提供了hook机制,让我们能够在请求得到响应之后去做一些自定义的操作,比如打印某些信息.修改响应内容等.具体用法见下面的例子: import requests # 钩子函数1 def ...

- Python之requests模块-cookie

cookie并不陌生,与session一样,能够让http请求前后保持状态.与session不同之处,在于cookie数据仅保存于客户端.requests也提供了相应到方法去处理cookie. 在py ...

- Python之requests模块-session

http协议本身是无状态的,为了让请求之间保持状态,有了session和cookie机制.requests也提供了相应的方法去操纵它们. requests中的session对象能够让我们跨http请求 ...

随机推荐

- C#理解AutoResetEvent和ManualResetEvent

当在C#使用多线程时就免不了使用AutoResetEvent和ManualResetEvent类,可以理解这两个类可以通过设置信号来让线程停下来或让线程重新启动,其实与操作系统里的信号量很相似(汗,考 ...

- Python爬取豆瓣指定书籍的短评

Python爬取豆瓣指定书籍的短评 #!/usr/bin/python # coding=utf-8 import re import sys import time import random im ...

- 使用 OpenSSL 创建私有 CA:1 根证书

OpenSSL 创建私有 CA 三部曲:使用 OpenSSL 创建私有 CA:1 根证书使用 OpenSSL 创建私有 CA:2 中间证书使用 OpenSSL 创建私有 CA:3 用户证书 OpenS ...

- Centos7 下SVN迁移

SVN迁移需要做如下操作: 1. 将原来的Repository导出 . #svnadmin dump 原有repos的目录路径 > dumpfile (不同服务器安装目录不同,根据具体情况调整) ...

- 牛客练习赛35 C.函数的魔法

链接 [https://ac.nowcoder.com/acm/contest/32] 题意 题目描述 一位客人来到了此花亭,给了女服务员柚一个数学问题:我们有两个函数,F(X)函数可以让X变成(XX ...

- 同步和异步概念(由DZW前端框架引发的百度地图api无法加载问题总结)

首先概念: 在计算机领域,同步就是指一个进程在执行某个请求的时候,若该请求需要一段时间才能返回信息,那么这个进程将会一直等待下去,直到收到返回信息才继续执行下去:异步是指进程不需要一直等下去,而是继续 ...

- Elasticsearch之配置详解

Cluster 集群名称,默认为elasticsearch: cluster.name: elasticsearch 设置一个节点的并发数量,有两种情况,一种是在初始复苏过程中: cluster.ro ...

- siteServer创建网站中Mysql和SqlServer的区别

mysql中使用本地数据库时使用:localhost sqlserver使用本地数据库时使用:(local)

- c++ 单引号"字符串" 用法

__int64 flag; //赋值超过4字节,编译错误 //flag = 'ABCDE'; //低于4字节,高位补 0 //flag = 'BCDE'; flag = 'A' << 24 ...

- Bootstrap知识记录:排版样式

---恢复内容开始--- 一.页面排版Bootstrap 提供了一些常规设计好的页面排版的样式供开发者使用.1.页面主体Bootstrap 将全局font-size 设置为14px,line-heig ...