kafka安装与简单使用

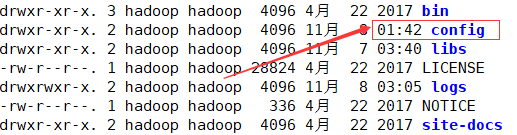

文件的详细属性为:

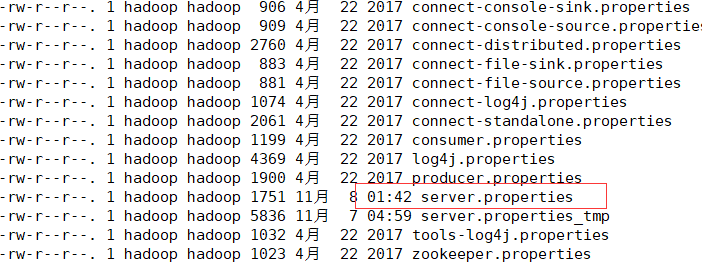

#broker的全局唯一编号,不能重复

broker.id= #用来监听链接的端口,producer或consumer将在此端口建立连接

port= #处理网络请求的线程数量

num.network.threads= #用来处理磁盘IO的线程数量

num.io.threads= #发送套接字的缓冲区大小

socket.send.buffer.bytes= #接受套接字的缓冲区大小

socket.receive.buffer.bytes= #请求套接字的缓冲区大小

socket.request.max.bytes= #kafka消息存放的路径

log.dirs=/export/servers/logs/kafka #topic在当前broker上的分片个数

num.partitions= #用来恢复和清理data下数据的线程数量

num.recovery.threads.per.data.dir= #segment文件保留的最长时间,超时将被删除

log.retention.hours= #滚动生成新的segment文件的最大时间

log.roll.hours= #日志文件中每个segment的大小,默认为1G

log.segment.bytes= #周期性检查文件大小的时间

log.retention.check.interval.ms= #日志清理是否打开

log.cleaner.enable=true #broker需要使用zookeeper保存meta数据

zookeeper.connect=192.168.52.106:,192.168.52.107:,192.168.52.108: #zookeeper链接超时时间

zookeeper.connection.timeout.ms= #partion buffer中,消息的条数达到阈值,将触发flush到磁盘

log.flush.interval.messages= #消息buffer的时间,达到阈值,将触发flush到磁盘

log.flush.interval.ms= #删除topic需要server.properties中设置delete.topic.enable=true否则只是标记删除

delete.topic.enable=true #此处的host.name为本机IP(重要),如果不改,则客户端会抛出:Producer connection to localhost: unsuccessful 错误!

host.name=spark101

ok,根据上面的配置修改自己的配置i文件,切记broker.id属性,全局唯一

然后分发文件,分发后修改broker.id和host.name属性

二、简单的使用

注意:kafka的使用,需要zookeeper的支持,请切记在启动kafka之前,zookeeper集群已启动完毕。

首先,启动kafka,启动成功后会jps查看会有一个kafka进程,若是启动失败,请仔细检查配置文件。

./bin/kafka-server-start.sh -daemon config/server.properties

创建topic

./bin/kafka-topics.sh --create --zookeeper spark101:,spark102:,spark103: --partition --replication-factor --topic test01

查看topic

./bin/kafka-topics.sh --list --zookeeper spark101:2181,spark102:2181,spark103:2181

查看详情

./bin/kafka-topics.sh --describe --zookeeper spark101:,spark102:,spark103: --topic test01

删除(若是配置文件中delete.topic.enable属性为true会直接删除,若是没有配置默认只是标记,并未真正删除)

./bin/kafka-topics.sh --delete --zookeeper spark101:,spark102:,spark103: --topic test01

说明:若是没有true,同时又想删除干净的话,逐步删除一下文件

1、删除配置真实数据目录下的数据文件

2、然后删除zookeeper下面的信息

rmr /admin/delete_topics/topicname

rmr /config/topics/topicname

rmr /brokers/topics/topicname

三、API的使用,消费者和生产者之间的简单通信

生产者:(spark101节点)

./bin/kafka-console-producer.sh --broker-list spark101:,spark102:,spark103: --topic test03

消费者:

.bin/kafka-console-consumer.sh --zookeeper spark101:,spark102:,spark103: --topic test03 --from-beginning

然后在生产者中输入数据,会在消费者那里接收到

kafka安装与简单使用的更多相关文章

- kafka安装和简单测试

kafka安装和简单测试 # 安装zookeeper(apache-zookeeper-3.5.6-bin)https://archive.apache.org/dist/zookeeper/zook ...

- 【Apache Kafka】二、Kafka安装及简单示例

(一)Apache Kafka安装 1.安装环境与前提条件 安装环境:Ubuntu16.04 前提条件: ubuntu系统下安装好jdk 1.8以上版本,正确配置环境变量 ubuntu系统下安 ...

- kafka集群安装及简单使用

关于kafka是什么及原理,请参考kafka官方文档的介绍:http://kafka.apache.org/documentation/#introduction ,英文不好的同学可以看这里http: ...

- kafka可视化工具安装及简单使用

一.安装 双击kafkatool_64bit.exe安装kafka可视化工具,并且C:\Windows\System32\drivers\etc配置HOSTS,打开HOSTS并添加: HOSTS添加: ...

- kafka安装与使用

一.下载 下载地址: http://kafka.apache.org/downloads.html kafka目录结构 目录 说明 bin 操作kafka的可执行脚本,还包含windows下脚本 co ...

- Spark简介安装和简单例子

Spark简介安装和简单例子 Spark简介 Spark是一种快速.通用.可扩展的大数据分析引擎,目前,Spark生态系统已经发展成为一个包含多个子项目的集合,其中包含SparkSQL.Spark S ...

- kafka安装和使用

kafka安装和启动 kafka的背景知识已经讲了很多了,让我们现在开始实践吧,假设你现在没有Kafka和ZooKeeper环境. Step 1: 下载代码 下载0.10.0.0版本并且解压它. &g ...

- Kafka安装教程(详细过程)

安装前期准备: 1,准备三个节点(根据自己需求决定) 2,三个节点上安装好zookeeper(也可以使用kafka自带的zookeeper) 3,关闭防火墙 chkconfig iptables o ...

- Zookeeper 安装与简单使用

一.安装Zookeeper 其实Zookeeper的安装特别简单,也不能算安装了,只需要将Zookeeper下载后解压,就完成了安装操作. 下载地址:http://zookeeper.apache.o ...

随机推荐

- uart通讯协议

本次设计的源码在http://download.csdn.net/detail/noticeable/9912383 下载 实验目的:通过uart通讯协议的编写,了解FPGA的通讯协议编写的方法. 实 ...

- Itween的代码使用方法 - 01

BB:Itween是真心不好用! - 透明度动画 void Start () { //键值对儿的形式保存iTween所用到的参数 Hashtable args = new Hashtable(); / ...

- 再谈控制 cxGrid 的行列颜色

1. [转]CxGrid 改变某行或单元格的颜色 (2016-01-19 09:37:19) 转载▼ 标签: it delphi 分类: Delphi 一个表(T)的结构结构如下. ID Test 1 ...

- confluence与jira账号对接、查看到期时间及问题总结

前面介绍了对于confluence和jira的破解版安装记录,下面简单记录下confluence和jira结合配置:安装顺序:先安装Jira,然后安装Confluence,在Confluence安装过 ...

- 牛客JS编程大题(一)

1.找出元素 item 在给定数组 arr 中的位置 function indexOf(arr,item){ return arr.indexOf(item);} 2.计算给定数组 arr 中所有元素 ...

- javascript从作用域到闭包-笔记

读<你不知道的javascript>一书做个笔记;编译原理: js是一门编译型的语言,与传统编译语言类似,传统编译的过程分为三个阶段 ; 1. 分词/词法分析; 2.解析/语 ...

- Eclipse 刚检出的项目 Build path 的时候提示 No action available

问题: 从SVN检出来的项目发现无法进行build path,也不报错,任何类之间也无法关联(Ctrl+右键无法点进去). 原因: .classpath是Eclipse的工程文件,别人没有将工程的信息 ...

- typescript handbook 学习笔记4

概述 这是我学习typescript的笔记.写这个笔记的原因主要有2个,一个是熟悉相关的写法:另一个是理清其中一些晦涩的东西.供以后开发时参考,相信对其他人也有用. 学习typescript建议直接看 ...

- [Swift]扩展UIImage :获取图片指定像素的颜色值

对[UIImage]进行扩展 import UIKit extension UIImage{ /** 根据坐标获取图片中的像素颜色值 */ subscript (x: Int, y: Int) -&g ...

- php使用curl模拟登录带验证码的网站[开发篇]

需求是这样的,需要登录带验证码的网站,获取数据,但是不可能人为一直去记录数据,想通过自动采集的方式进行,如下是试验出来的结果代码!有需要的可以参考下! <?php namespace Home\ ...