Trident学习笔记(二)

aggregator

------------------

聚合动作;聚合操作可以是基于batch、stream、partiton

[聚合方式-分区聚合]

partitionAggregate

分区聚合;基于分区进行聚合运算;作用于分区而不是batch。

mystream.partitionAggregate(new Fields("x"), new Count(), new Fields("count"));

[聚合方式-batch聚合]

aggregate

批次聚合;先将同一batch的所有分区的tuple进行global再分区,将其汇集到一个分区中,再进行聚合运算。

.aggregate(new Fields("a"), new Count(), new Fields("count")); // 批次聚合

聚合函数

[ReducerAggregator]

init();

reduce();

Aggregator

CombinerAggregator

import org.apache.storm.trident.operation.ReducerAggregator;

import org.apache.storm.trident.tuple.TridentTuple; /**

* 自定义sum聚合函数

*/

public class SumReducerAggregator implements ReducerAggregator<Integer> { private static final long serialVersionUID = 1L; @Override

public Integer init() {

return 0;

} @Override

public Integer reduce(Integer curr, TridentTuple tuple) {

return curr + tuple.getInteger(0) + tuple.getInteger(1);

} }

分区聚合

import net.baiqu.shop.report.trident.demo01.PrintFunction;

import org.apache.storm.Config;

import org.apache.storm.LocalCluster;

import org.apache.storm.trident.Stream;

import org.apache.storm.trident.TridentTopology;

import org.apache.storm.trident.testing.FixedBatchSpout;

import org.apache.storm.tuple.Fields;

import org.apache.storm.tuple.Values; public class TridentTopologyApp4 { public static void main(String[] args) {

// 创建topology

TridentTopology topology = new TridentTopology(); // 创建spout

FixedBatchSpout testSpout = new FixedBatchSpout(new Fields("a", "b"), 4,

new Values(1, 2),

new Values(2, 3),

new Values(3, 4),

new Values(4, 5)); // 创建流

Stream stream = topology.newStream("testSpout", testSpout);

stream.partitionAggregate(new Fields("a", "b"), new SumReducerAggregator(), new Fields("sum"))

.shuffle().each(new Fields("sum"), new PrintFunction(), new Fields("result")); // 本地提交

LocalCluster cluster = new LocalCluster();

cluster.submitTopology("TridentDemo4", new Config(), topology.build());

} }

[ReducerAggregator]

init();

reduce();

public interface ReducerAggregator<T> extends Serializable {

T init();

T reduce(T curr, TridentTuple tuple);

}

[Aggregator]

描述同ReducerAggregator.

public interface Aggregator<T> extends Operation {

// 开始聚合之间调用,主要用于保存状态。共下面的两个方法使用

T init(Object batchId, TridentCollector collector);

// 迭代batch的每个tuple, 处理每个tuple后更新state的状态。

void aggreate(T val, TridentTuple tuple, TridentCollector collector);

// 所有tuple处理完成后调用,返回单个tuple给每个batch。

void complete(T val, TridentCollector collector);

}

CombinerAggregator

import org.apache.storm.trident.operation.BaseAggregator;

import org.apache.storm.trident.operation.TridentCollector;

import org.apache.storm.trident.tuple.TridentTuple;

import org.apache.storm.tuple.Values; import java.io.Serializable; /**

* 批次求和函数

*/

public class SumAggregator extends BaseAggregator<SumAggregator.State> { private static final long serialVersionUID = 1L; static class State implements Serializable {

private static final long serialVersionUID = 1L;

int sum = 0;

} @Override

public SumAggregator.State init(Object batchId, TridentCollector collector) {

return new State();

} @Override

public void aggregate(SumAggregator.State state, TridentTuple tuple, TridentCollector collector) {

state.sum = state.sum + tuple.getInteger(0) + tuple.getInteger(1);

} @Override

public void complete(SumAggregator.State state, TridentCollector collector) {

collector.emit(new Values(state.sum));

} }

批次聚合

package net.baiqu.shop.report.trident.demo04; import net.baiqu.shop.report.trident.demo01.PrintFunction;

import org.apache.storm.Config;

import org.apache.storm.LocalCluster;

import org.apache.storm.trident.Stream;

import org.apache.storm.trident.TridentTopology;

import org.apache.storm.trident.testing.FixedBatchSpout;

import org.apache.storm.tuple.Fields;

import org.apache.storm.tuple.Values; public class TridentTopologyApp4 { public static void main(String[] args) {

// 创建topology

TridentTopology topology = new TridentTopology(); // 创建spout

FixedBatchSpout testSpout = new FixedBatchSpout(new Fields("a", "b"), 4,

new Values(1, 2),

new Values(2, 3),

new Values(3, 4),

new Values(4, 5)); // 创建流

Stream stream = topology.newStream("testSpout", testSpout);

stream.aggregate(new Fields("a", "b"), new SumAggregator(), new Fields("sum"))

.shuffle().each(new Fields("sum"), new PrintFunction(), new Fields("result")); // 本地提交

LocalCluster cluster = new LocalCluster();

cluster.submitTopology("TridentDemo4", new Config(), topology.build());

} }

运行结果

PrintFunction:

PrintFunction:

PrintFunction:

......

平均值批次聚合函数

import org.apache.storm.trident.operation.BaseAggregator;

import org.apache.storm.trident.operation.TridentCollector;

import org.apache.storm.trident.tuple.TridentTuple;

import org.apache.storm.tuple.Values; import java.io.Serializable; /**

* 批次求平均值函数

*/

public class AvgAggregator extends BaseAggregator<AvgAggregator.State> { private static final long serialVersionUID = 1L; static class State implements Serializable {

private static final long serialVersionUID = 1L;

// 元组值的总和

float sum = 0;

// 元组个数

int count = 0;

} /**

* 初始化状态

*/

@Override

public AvgAggregator.State init(Object batchId, TridentCollector collector) {

return new State();

} /**

* 在state变量中维护状态

*/

@Override

public void aggregate(AvgAggregator.State state, TridentTuple tuple, TridentCollector collector) {

state.count = state.count + 2;

state.sum = state.sum + tuple.getInteger(0) + tuple.getInteger(1);

} /**

* 处理完成所有元组之后,返回一个具有单个值的tuple

*/

@Override

public void complete(AvgAggregator.State state, TridentCollector collector) {

collector.emit(new Values(state.sum / state.count));

} }

批次聚合求平均值

import net.baiqu.shop.report.trident.demo01.PrintFunction;

import org.apache.storm.Config;

import org.apache.storm.LocalCluster;

import org.apache.storm.trident.Stream;

import org.apache.storm.trident.TridentTopology;

import org.apache.storm.trident.testing.FixedBatchSpout;

import org.apache.storm.tuple.Fields;

import org.apache.storm.tuple.Values; public class TridentTopologyApp4 { public static void main(String[] args) {

// 创建topology

TridentTopology topology = new TridentTopology(); // 创建spout

FixedBatchSpout testSpout = new FixedBatchSpout(new Fields("a", "b"), 4,

new Values(1, 2),

new Values(2, 3),

new Values(3, 4),

new Values(4, 5)); // 创建流

Stream stream = topology.newStream("testSpout", testSpout);

stream.aggregate(new Fields("a", "b"), new AvgAggregator(), new Fields("avg"))

.shuffle().each(new Fields("avg"), new PrintFunction(), new Fields("result")); // 本地提交

LocalCluster cluster = new LocalCluster();

cluster.submitTopology("TridentDemo4", new Config(), topology.build());

} }

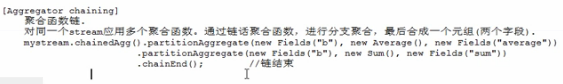

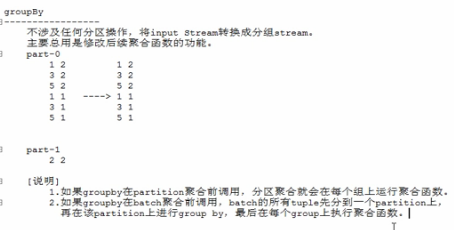

[CombinerAggregator]

在每个partition运行分区聚合,然后再进行global再分区将同一对batch的所有tuple分到一个partition中,最后再这一个partition中进行聚合运算,并产生结果进行输出。

该种方式的网络流量占用少于前两种方式。

public interface CombinerAggregator<T> extents Serializable {

// 在每个tuple上运行,并接受字段值

T init(TridentTuple tuple);

// 合成tuple的值,并输出一个值的tuple

T combine(T val1, T vak2);

// 如果分区不含有tuple,调用该方法.

T zero();

}

合成聚合函数

import clojure.lang.Numbers;

import org.apache.storm.trident.operation.CombinerAggregator;

import org.apache.storm.trident.tuple.TridentTuple; /**

* 合成聚合函数

*/

public class SumCombinerAggregator implements CombinerAggregator<Number> { private static final long serialVersionUID = 1L; @Override

public Number init(TridentTuple tuple) {

return (Number) tuple.getValue(0);

} @Override

public Number combine(Number val1, Number val2) {

return Numbers.add(val1, val2);

} @Override

public Number zero() {

return 0;

} }

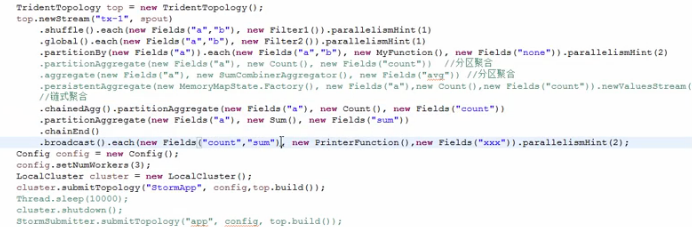

topology

import net.baiqu.shop.report.trident.demo01.PrintFunction;

import org.apache.storm.Config;

import org.apache.storm.LocalCluster;

import org.apache.storm.trident.Stream;

import org.apache.storm.trident.TridentTopology;

import org.apache.storm.trident.testing.FixedBatchSpout;

import org.apache.storm.tuple.Fields;

import org.apache.storm.tuple.Values; public class TridentTopologyApp4 { public static void main(String[] args) {

// 创建topology

TridentTopology topology = new TridentTopology(); // 创建spout

FixedBatchSpout testSpout = new FixedBatchSpout(new Fields("a", "b"), 4,

new Values(1, 2),

new Values(2, 3),

new Values(3, 4),

new Values(4, 5)); // 创建流

Stream stream = topology.newStream("testSpout", testSpout);

stream.aggregate(new Fields("a", "b"), new SumCombinerAggregator(), new Fields("sum"))

.shuffle().each(new Fields("sum"), new PrintFunction(), new Fields("result")); // 本地提交

LocalCluster cluster = new LocalCluster();

cluster.submitTopology("TridentDemo4", new Config(), topology.build());

} }

输出结果

PrintFunction:

PrintFunction:

PrintFunction:

......

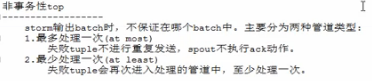

Trident学习笔记(二)的更多相关文章

- WPF的Binding学习笔记(二)

原文: http://www.cnblogs.com/pasoraku/archive/2012/10/25/2738428.htmlWPF的Binding学习笔记(二) 上次学了点点Binding的 ...

- AJax 学习笔记二(onreadystatechange的作用)

AJax 学习笔记二(onreadystatechange的作用) 当发送一个请求后,客户端无法确定什么时候会完成这个请求,所以需要用事件机制来捕获请求的状态XMLHttpRequest对象提供了on ...

- [Firefly引擎][学习笔记二][已完结]卡牌游戏开发模型的设计

源地址:http://bbs.9miao.com/thread-44603-1-1.html 在此补充一下Socket的验证机制:socket登陆验证.会采用session会话超时的机制做心跳接口验证 ...

- JMX学习笔记(二)-Notification

Notification通知,也可理解为消息,有通知,必然有发送通知的广播,JMX这里采用了一种订阅的方式,类似于观察者模式,注册一个观察者到广播里,当有通知时,广播通过调用观察者,逐一通知. 这里写 ...

- java之jvm学习笔记二(类装载器的体系结构)

java的class只在需要的时候才内转载入内存,并由java虚拟机的执行引擎来执行,而执行引擎从总的来说主要的执行方式分为四种, 第一种,一次性解释代码,也就是当字节码转载到内存后,每次需要都会重新 ...

- Java IO学习笔记二

Java IO学习笔记二 流的概念 在程序中所有的数据都是以流的方式进行传输或保存的,程序需要数据的时候要使用输入流读取数据,而当程序需要将一些数据保存起来的时候,就要使用输出流完成. 程序中的输入输 ...

- 《SQL必知必会》学习笔记二)

<SQL必知必会>学习笔记(二) 咱们接着上一篇的内容继续.这一篇主要回顾子查询,联合查询,复制表这三类内容. 上一部分基本上都是简单的Select查询,即从单个数据库表中检索数据的单条语 ...

- NumPy学习笔记 二

NumPy学习笔记 二 <NumPy学习笔记>系列将记录学习NumPy过程中的动手笔记,前期的参考书是<Python数据分析基础教程 NumPy学习指南>第二版.<数学分 ...

- Learning ROS for Robotics Programming Second Edition学习笔记(二) indigo tools

中文译著已经出版,详情请参考:http://blog.csdn.net/ZhangRelay/article/category/6506865 Learning ROS for Robotics Pr ...

- Redis学习笔记二 (BitMap算法分析与BitCount语法)

Redis学习笔记二 一.BitMap是什么 就是通过一个bit位来表示某个元素对应的值或者状态,其中的key就是对应元素本身.我们知道8个bit可以组成一个Byte,所以bitmap本身会极大的节省 ...

随机推荐

- javascript:json对象和json字符串的相互转换

json对象和字符串的相互转换 //使用json中的parser方法转换: var str='{"name":"fendouer", "age&quo ...

- union和struct的区别之处,在于内存的共享上

首先看看union,在c++中,union可能没有多大用处,在c语言中,可能我们要借助其完成很多巧妙的设计,下面是其一个完整的定义: union UTest { ...

- [转]用jwplayer+Nginx搭建视频点播服务器,解决拖动加载慢的问题

flv视频可以采用两种方式发布: 一.普通的HTTP下载方式 二.基于Flash Media Server或Red5服务器的rtmp/rtmpt流媒体方式. 多数知名视频网站都采用的是前一种方式. 两 ...

- IOS 计算文字尺寸(UILabel)

方式1 :普通用法 #define MJNameFont [UIFont systemFontOfSize:14] /** * 计算文字尺寸 * * @param text 需要计算尺寸的文字 * ...

- 数据库连接-ADO.NET

版权声明:本文为博主原创文章,未经博主同意不得转载. https://blog.csdn.net/huo065000/article/details/25830291 非常早就知道了ADO ...

- HDU(4394),数论上的BFS

题目链接:http://acm.hdu.edu.cn/showproblem.php?pid=4394 思路很巧妙,要找到m,可以这样思考,n的个位是有m的个位决定的,从0-9搜一遍,满足情况的话就继 ...

- PASCAL VOC数据集分析

http://blog.csdn.net/zhangjunbob/article/details/52769381

- 安装juicer

由于我第一次安装 JUICER时遇到了很多问题,现在把这些问题都记录下来,给同样第一次安装使用的同学一点借鉴. 前面已经安装了Torch3和Tracter,这都是为安装Juicer做的准备,现在安装J ...

- HTTP 之缓存

这是一篇知识性的文档,主要目的是为了让Web缓存相关概念更容易被开发者理解并应用于实际的应用环境中.为了简要起见,某些实现方面的细节被简化或省略了.如果你更关心细节实现则完全不必耐心看完本文,后面参考 ...

- js动画效果

js能够按照预定的时间间隔重复调用一个函数,而这意味着我们可以随着时间的推移而不断改变某个元素的样式.动画是样式随时间变化的完美例子之一. js函数setTimeout能够让某个函数在经过一段预定的时 ...