线上ES集群参数配置引起的业务异常案例分析

作者:vivo 互联网数据库团队- Liu Huang

本文介绍了一次排查Elasticsearch node_concurrent_recoveries 引发的性能问题的过程。

一、故障描述

1.1 故障现象

1. 业务反馈

业务部分读请求抛出请求超时的错误。

2. 故障定位信息获取

故障开始时间

19:30左右开始

故障抛出异常日志

错误日志抛出timeout错误。

故障之前的几个小时业务是否有进行发版迭代。

未进行相关的发版迭代。

故障的时候流量是否有出现抖动和突刺情况。

内部监控平台观察业务侧并没有出现流量抖动和突刺情况。

故障之前的几个小时Elasticsearch集群是否有出现相关的变更操作。

Elasticsearch集群没有做任何相关的变更操作。

1.2 环境

Elaticsearch的版本:6.x。

集群规模:集群数据节点超过30+。

二、故障定位

我们都知道Elasticsearch是一个分布式的数据库,一般情况下每一次查询请求协调节点会将请求分别路由到具有查询索引的各个分片的实例上,然后实例本身进行相关的query和fetch,然后将查询结果汇总到协调节点返回给客户端,因此存在木桶效应问题,查询的整体性能则是取决于是查询最慢的实例上。所以我们需要确认导致该故障是集群整体的问题还是某些实例的问题导致的。

2.1 集群还是实例的问题

1. 查看所有实例的关键监控指标

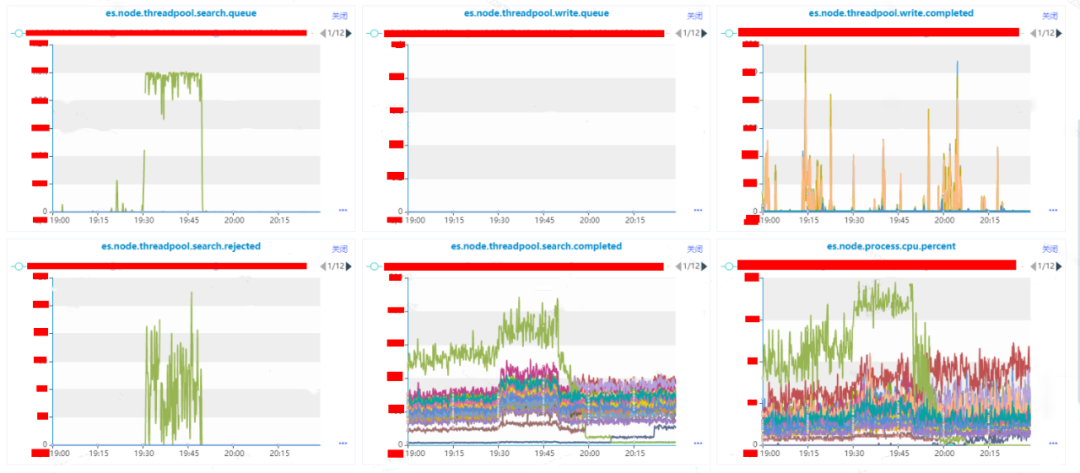

从监控图可以很明显的绿色监控指标代表的实例在19:30左右开始是存在异常现象,在这里我们假设该实例叫做A。

实例A的指标es.node.threadpool.search.queue的值长时间达到了1000,说明读请求的队列已经满了。

实例A的指标es.node.threadpool.search.rejected的值高峰期到了100+,说明实例A无法处理来自于业务的所有请求,有部分请求是失败的。

集群整体的指标es.node.threadpool.search.completed有出现增长,经过业务沟通和内部平台监控指标的观察,业务流量平缓,并没有出现抖动现象,但是客户端有进行异常重试机制,因此出现增长是因为重试导致。

实例A的指标es.node.threadpool.search.completed相比集群其他实例高50%以上,说明实例A上存在一个到多个热点索引。

实例A的指标es.node.threadpool.cpu.percent的值有50%以上的增长。

可通过指标es.node.indices.search.querytime和es.node.indices.search.querytimeinmillis的趋势可实例级别的请求耗时大致情况。

通过上面的分析,我们能给确认的是实例A是存在异常,但是导致业务请求超时是否是实例A异常导致,还需进一步分析确认。

2.2 实例异常的原因

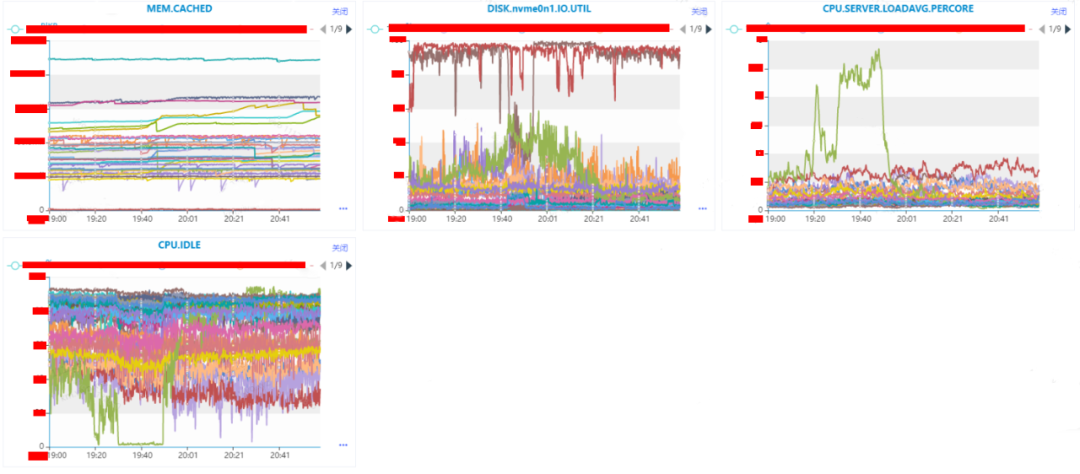

到了这一步,我们能够非常明确实例是存在异常情况,接下来我们需要定位是什么导致实例异常。在这里我们观察下实例所在机器的MEM.CACHED、DISK.nvme0n1.IO.UTIL、CPU.SERVER.LOADAVG.PERCORE、CPU.IDLE这些CPU、MEMMORY、DISK IO等指标。

1. CPU or IO

通过监控,我们可以很明显的看得到,DISK.nvme0n1.IO.UTIL、CPU.SERVER.LOADAVG.PERCORE、CPU.IDLE这三个监控指标上是存在异常情况的。

DISK.nvme0n1.IO.UTIL上深红色和深褐色指标代表的机器IO使用率存在异常,在这里我们假设深红色的机器叫做X,深褐色的机器叫做Y。

CPU.SERVER.LOADAVG.PERCORE和CPU.IDLE这俩个反应CPU使用情况的指标上代表绿色的机器在存在异常,在这里我们假设绿色的机器叫做Z。

机器X的IO在故障时间之前就处于满载情况,机器X在整个过程当中是没有出现波动,因此可移除机器X可能导致集群受到影响。

机器Y的IO在故障时间之前是处于满载情况,但是在故障期间IO使用率差不多下降到了50%,因此可移除机器Y可能导致集群受到影响。

机器Z的CPU使用率在在故障期间直线下降,CPU.IDLE直接下降到个位数;CPU.SERVER.LOADAVG.PERCORE(是单核CPU的平均负载,2.5表示当前负载是CPU核数*2.5)直接增长了4倍,此时整个机器几乎都是处于阻塞的情况;DISK.nvme0n1.IO.UTIL则是从20%增长到了50%左右。其中CPU的指标是直线增长,IO的指标则是一个曲线增长。

异常实例A所在的机器是Z,目前机器Z的CPU和IO都存在增长情况,其中CPU已经到了系统的瓶颈,系统已经受到了阻塞,IO的利用率从20%增长到了50%,虽然有所增长,但是还未到达磁盘的瓶颈。

通过上面的分析,我们比较倾向于机器Z的CPU的异常导致了实例A的异常。这个时候我们需要确认是什么原因导致了机器Z的CPU异常,这个时候可通过内部监控平台的快照查看机器Z的快照信息。

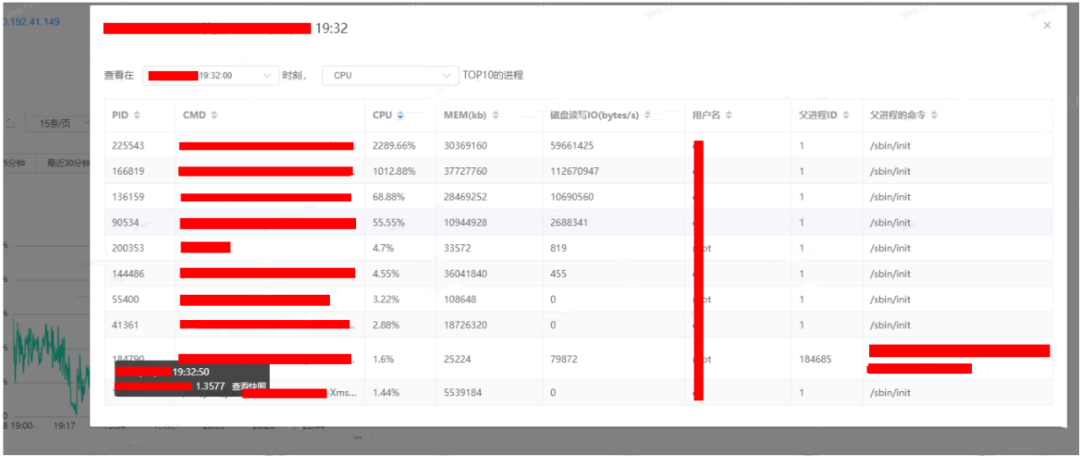

通过内部监控平台的快照,我们可以看到PID为225543的CPU使用率是2289.66%,166819的CPU的使用率是1012.88%。需要注意的是我们机器Z的逻辑核是32C,因此我们可认为CPU机器CPU的使用率理论上最高是3200%。但是使用率CPU最高的俩个实例的值加起来已经是超过了这个值,说明CPU资源已经是完全被使用完毕了的。

通过登陆机器Z,查询获取得到PID为225543的进程就是实例A的elasticsearch进程。

2. 实例CPU异常的原因

其实Elasticsearch本身是有接口提供获取实例上的热点进程,但是当时执行接口命令的时候长时间没有获取到结果,因此只能从其他方案想办法了。

获取实例上的热点进程:

curl -XGET /_nodes/xx.xx.xx.xx/hot_threads?pretty -s实例A的CPU使用率高一般导致这个情况原因一个是并发过高导致实例处理不过来,另外一个则是存在任务长时间占据了进程资源,导致无多余的资源处理其他的请求。所以我们首先基于这俩个情形进行分析。

(1)是否并发度过高引起实例CPU异常

从之前的分析我们可以得知业务侧的流量是没有出现突增,search.completed的增长只是因为业务重试机制导致的,因此排除并发过高的原因了,那么剩下的就只有存在长任务的原因了。

(2)是否长任务导致实例CPU异常

根据_cat/tasks查看当前正在执行的任务,默认会根据时间进行排序,任务running时间越长,那么就会排到最前面,上面我们得知异常的实例只有A,因此我们可以只匹配实例A上的任务信息。

curl -XGET '/_cat/tasks?v&s=store' -s | grep A一般情况下大部分任务都是在秒级以下,若是出现任务执行已超过秒级或者分钟级的任务,那么这个肯定就是属于长任务。

(3)什么长任务比较多

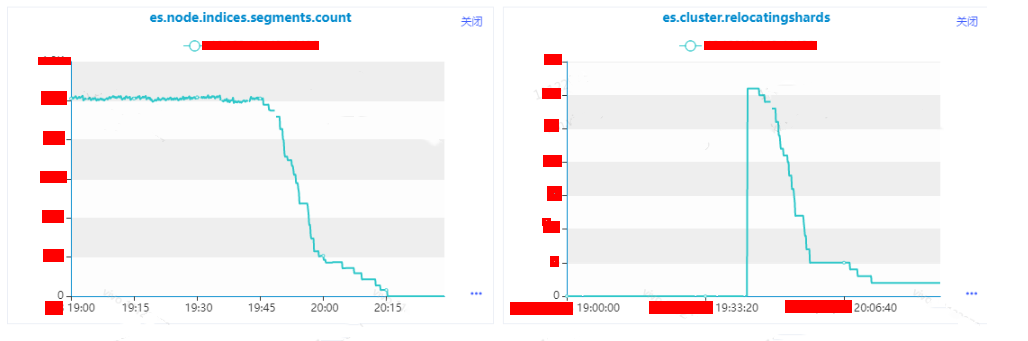

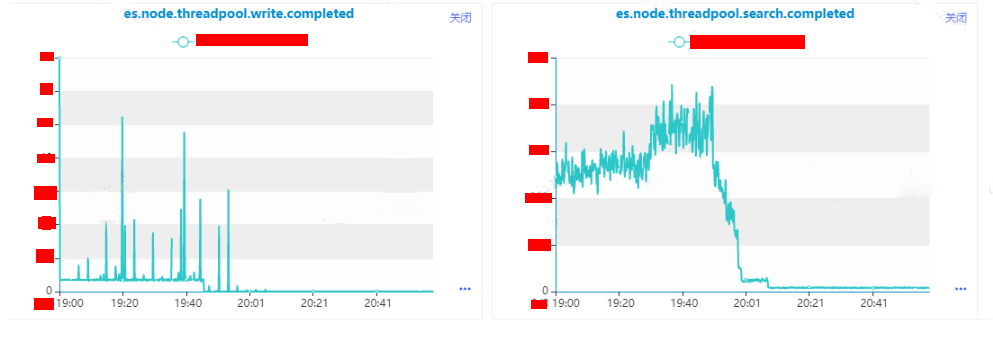

根据接口可以看得到耗时较长的都是relocate任务,这个时候使用查看接口/_cat/shards查看分片迁移信息,并且并发任务还很多,持续时间相较于其他任务来说很长。

curl -XGET '/_cat/shards?v&s=store' -s | grep A由于当时是优先恢复业务,因此没有截图,最后只能从监控获取得到这个时间是有进行relocate分片的迁移操作:

es.node.indices.segment.count:实例级别segment的个数。

es.cluster.relocatingshards:集群级别正在进行relocate的分片数量。

(4)什么原因导致了分片迁移变多

根据日常的运维,一般出现分片迁移的情况有:

实例故障。

人工进行分片迁移或者节点剔除。

磁盘使用率达到了高水平位。

根据后续的定位,可以排除实例故障和人工操作这俩项,那么进一步定位是否由于磁盘高水平位导致的。

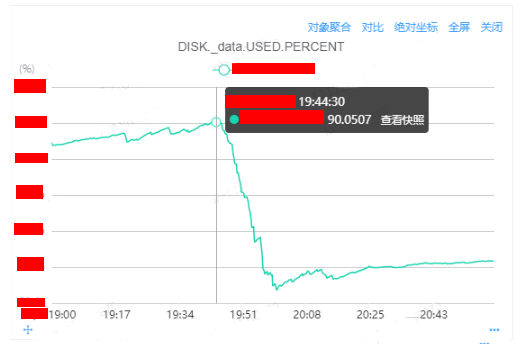

查看实例级别的监控:

查看master的日志:

[xxxx-xx-xxT19:43:28,389][WARN ][o.e.c.r.a.DiskThresholdMonitor] [master] high disk watermark [90%] exceeded on [ZcphiDnnStCYQXqnc_3Exg][A][/xxxx/data/nodes/0] free: xxxgb[9.9%], shards will be relocated away from this node

[xxxx-xx-xxT19:43:28,389][INFO ][o.e.c.r.a.DiskThresholdMonitor] [$B] rerouting shards: [high disk watermark exceeded on one or more nodes]根据监控和日志能够进一步确认是磁盘使用率达到了高水平位从而导致的迁移问题。

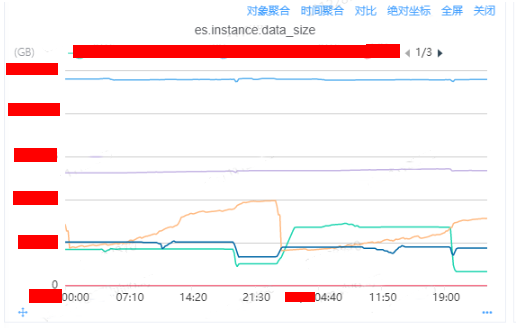

(5)确认引起磁盘上涨的实例

通过内部监控平台的DB监控,查看机器级别上所有实例的监控指标

es.instance.data_size:

通过监控我们分析可以得到浅黄色、深蓝色、浅绿色三个实例是存在较大的磁盘数据量大小的增长情况,可以比较明显导出磁盘增长到90%的原因是浅黄色线代表的实例导致的原因。

2.3 根因分析

针对实例A磁盘波动情况进行分析:

查看这个监控图,你会发现存在异常:

磁盘数据量的下降和上升并不是一个缓慢的曲线。

2023-02-07 19:20左右也发生过磁盘下降的情况。

出现磁盘的下降和趋势一次性比较多的情况,根据以往的经验存在:

大规模的刷数据。

relocate的分片是一个大分片。

relocate并发数比较大。

第一个排除了,大规模的刷数据只会导致数据上升,并不会出现数据下降的情况,因此要么就是大分片,要么就是并发较大。

查看是否存在大分片:

# curl -XGET '/_cat/shards?v&s=store' -s | tail

index_name 4 r STARTED 10366880 23.2gb

index_name 4 p STARTED 10366880 23.2gb

index_name 0 r STARTED 10366301 23.2gb

index_name 0 p STARTED 10366301 23.2gb

index_name 3 p STARTED 10347791 23.3gb

index_name 3 r STARTED 10347791 23.3gb

index_name 2 p STARTED 10342674 23.3gb

index_name 2 r STARTED 10342674 23.3gb

index_name 1 r STARTED 10328206 23.4gb

index_name 1 p STARTED 10328206 23.4gb查看是否存在重定向并发数较大:

# curl -XGET '/_cluster/settings?pretty'

{

... ...

"transient" : {

"cluster" : {

"routing" : {

"allocation" : {

"node_concurrent_recoveries" : "5",

"enable" : "all"

}

}

}

}

}发现参数cluster.allocation.node_concurrent_recoveries设置成了5,我们看下官方针对这个参数的解释:https://www.elastic.co/guide/en/elasticsearch/reference/6.3/shards-allocation.html

大致意思是同一个时间允许多个的分片可以并发的进行relocate或者recovery,我们就按照较大的分片数量20G*5,差不多就是100G左右,这个就解释了为什么data_size的增长和下降短时间内非常大的数据量的原因了。

到目前为止,我们能够确认的是因为分片迁移的问题消耗了实例A很大的CPU资源,从而导致实例A的CPU指标非常的高。

三、解决方案

基于上面的分析,我们假设由于实例A的异常导致集群整的异常;基于这种假设,我们尝试将实例A剔除集群,观察集群和业务的请求是否能够恢复。

3.1 猜想验证

将实例的分片迁移到其他的实例上,执行以下命令之后,可以明显的发现实例上的请求基本上下降为零了,并且业务反馈超时也在逐步的减少,基于这个情况验证了我们的猜想,是实例A的异常导致了业务的请求超时的情况。

curl -XPUT /_cluster/settings?pretty -H 'Content-Type:application/json' -d '{

"transient":{

"cluster.routing.allocation.exclude._ip": "xx.xx.xx.xx"

}

}'

3.2 根本解决

猜想验证确认之后,那我们现在基于实例A的CPU的异常结果进行相关的优化:

修改参数cluster.routing.allocation.node_concurrent_recoveries

该参数默认值是2,一般是不建议修改这个参数,但是有需要快速迁移要求的业务可以动态修改这个参数,建议不要太激进,开启之后需要观察实例、机器级别的CPU、磁盘IO、网络IO的情况。

修改参数cluster.routing.use_adaptive_replica_selection

开启该参数之后,业务针对分片的读取会根据请求的耗时的响应情况选择下次请求是选择主分片还是副分片。

6.3.2版本默认是关闭了该参数,业务默认会轮询查询主副分片,这在部分实例异常的情况会影响集群的整体性能。针对生产环境、单机多实例混合部署的情况下,建议开启该参数,对集群的性能有一定的提高。

7.x的版本默认是开启了这个参数。

curl -XPUT /_cluster/settings?pretty -H 'Content-Type:application/json' -d '{

"transient":{

"cluster.routing.allocation.node_concurrent_recoveries": 2,

"cluster.routing.use_adaptive_replica_selection":true

}

}'直接扩容或者迁移实例也是比较合适的。

四、总结

在本次故障,是由于集群参数配置不正确,导致集群的一个实例出现异常从而导致了业务的请求异常。但是在我们在进行故障分析的时候,不能仅仅只是局限于数据库侧,需要基于整个请求链路的分析,从业务侧、网络、数据库三个方面进行分析:

业务侧:需确认业务的所在的机器的CPU、网络和磁盘IO、内存是否使用正常,是否有出现资源争用的情况;确认JVM的gc情况,确认是否是因为gc阻塞导致了请求阻塞;确认流量是否有出现增长,导致Elasticsearch的瓶颈。

网络侧:需确认是否有网络抖动的情况。

数据库侧:确认是Elasticsearch是否是基于集群级别还是基于实例级别的异常;确认集群的整体请求量是否有出现突增的情况;确认异常的实例的机器是否有出现CPU、网络和磁盘IO、内存的使用情况。

确认哪方面的具体故障之后,就可以进一步的分析导致故障的原因。

参数控制:

Elasticsearch本身也有一些参数在磁盘使用率达到一定的情况下来控制分片的分配策略,默认该策略是开启的,其中比较重要的参数:

cluster.routing.allocation.disk.threshold_enabled:默认值是true,开启磁盘分分配决策程序。

cluster.routing.allocation.disk.watermark.low:默认值85%,磁盘使用低水位线。达到该水位线之后,集群默认不会将分片分配达到该水平线的机器的实例上,但是新创建的索引的主分片可以被分配上去,副分片则不允许。

cluster.routing.allocation.disk.watermark.high:默认值90%,磁盘使用高水位线。达到该水位线之后,集群会触发分片的迁移操作,将磁盘使用率超过90%实例上的分片迁移到其他分片上。

cluster.routing.allocation.disk.watermark.high:默认值95%。磁盘使用率超过95%之后,集群会设置所有的索引开启参数read_only_allow_delete,此时索引是只允许search和delete请求。

补充:

一旦一台机器上的磁盘使用率超过了90%,那么这台机器上所有的ES实例所在的集群都会发起分片的迁移操作,那么同一时间发起并发的最大可能是:ES实例数*cluster.routing.allocation.node_concurrent_recoveries,这个也会导致机器的CPU、IO等机器资源进一步被消耗,从而所在的实例性能会更差,从而导致路由到机器上实例的分片的性能会更差。

一旦一台机器上磁盘使用率超过95%,那么这台机器上所有的实例所在的集群都会开启集群级别的参数read_only_allow_delete,此时不仅仅是一个集群,而是一个或者多个集群都无法写入,只能进行search和delete。

线上ES集群参数配置引起的业务异常案例分析的更多相关文章

- Windows下同一台机器上elasticsearch集群的配置以及elasticsearch-head插件的使用

ElasticSearch是一个基于Lucene的开源搜索服务器,现已经被越来越多的企业运用于项目当中,笔者为了学习es在自己机器上简单的搭建了一个es集群,此文权当记录. 1.我用到的压缩包 下载地 ...

- 线上 ELK 集群健康值 red 状态问题排查与解决

之前一直运行正常的数据分析平台,最近一段时间没有注意发现日志索引数据一直未生成,大概持续了n多天,当前状态: 单台机器, Elasticsearch(下面称ES)单节点(空集群),1000+shrad ...

- Hadoop集群参数和常用端口

一.Hadoop集群参数配置 在hadoop集群中,需要配置的文件主要包括四个,分别是core-site.xml.hdfs-site.xml.mapred-site.xml和yarn-site.xml ...

- elasticsearch(es) 集群恢复触发配置(Local Gateway参数)

elasticsearch(es) 集群恢复触发配置(Local Gateway) 当你集群重启时,几个配置项影响你的分片恢复的表现. 首先,我们需要明白如果什么也没配置将会发生什么. 想象一下假设你 ...

- ES 30 - Elasticsearch生产集群的配置建议

目录 1 服务器的内存 2 服务器的CPU 3 服务器的磁盘 4 集群的网络 5 集群的节点个数 6 JVM的参数设置 7 集群的数据量 8 总结 在生产环境中, 要保证服务在各种极限情况下的稳定和高 ...

- ES 集群上,业务单点如何优化升级?

摘要: 原创出处 https://www.bysocket.com 「公众号:泥瓦匠BYSocket 」欢迎关注和转载,保留摘要,谢谢! ES 基础 ES 集群 ES 集群上业务优化 一.ES 基础 ...

- Elasticsearch 节点磁盘使用率过高,导致ES集群索引无副本

目录 一.问题 二.问题的原因 三.问题解决的办法 1. 扩大磁盘 2. 删除部分历史索引 3. 更改es设置 四.扩展 一.问题 最近在查看线上的 es,发现最近2天的索引没有副本,集群的状态也是为 ...

- RocketMQ集群部署配置

目标,使用2台机器部署RocketMQ多Master多Slave模式,异步复制集群模式. 第一步,修改/etc/hosts文件 192.168.116.115 rocketmq1 192.168.11 ...

- elasticsearch系列八:ES 集群管理(集群规划、集群搭建、集群管理)

一.集群规划 搭建一个集群我们需要考虑如下几个问题: 1. 我们需要多大规模的集群? 2. 集群中的节点角色如何分配? 3. 如何避免脑裂问题? 4. 索引应该设置多少个分片? 5. 分片应该设置几个 ...

- ES集群

1. ElasticSerach集群安装 修改配置文件elasticserach.yml [elk@localhost config]$ vi elasticsearch.yml # ------- ...

随机推荐

- VMware三种连接模式的区别

安装了vm软件后,该软件会虚拟出两张虚拟网卡vmnet1和vmnet8 网卡在控制面板->网络和internet->更改适配器设置 三种网络连接模式: 桥接模式:使用主机的无线网卡或者有线 ...

- SpringCloudAlibaba框架学习

遇到问题找了各种办法都没有解决,就reload maven,再不行就重启idea,重启电脑.(有奇效,我好几次就这么解决的,可能是我电脑配置太拉了) 注册中心 - Nacos 配置文件优先级:本地配置 ...

- 通过替换dll实现后门功能的恶意代码

通过替换Kernel32.dll来实现的后门功能的恶意代码. 该恶意代码存在一个exe可执行文件和一个dll动态链接库,需要分别进行分析 一.待解决问题 这个恶意代码执行了什么功能? 通过什么方式实现 ...

- 浅谈 Linux 下 vim 的使用

Vim 是从 vi 发展出来的一个文本编辑器,其代码补全.编译及错误跳转等方便编程的功能特别丰富,在程序员中被广泛使用. Vi 是老式的字处理器,功能虽然已经很齐全了,但还有可以进步的地方.Vim 可 ...

- 银河麒麟使用kickstart二次打包制作安装镜像ISO

系统:银河麒麟 V10 SP2 服务器:百信恒山 TS02F-F30 安装方式:服务器挂载ISO镜像进行安装 1.安装 mkisofs 软件包: #yum install genisoimage 2. ...

- 其它——Redis与Mysql双写一致性方案解析

文章目录 一 前言 二 一致性方案 三 先更新数据库,再更新缓存 四 先删缓存,再更新数据库 五 先更新数据库,再删缓存 一 前言 首先,缓存由于其高并发和高性能的特性,已经在项目中被广泛使用.在读取 ...

- 前端三件套系例之CSS——CSS3基础布局

文章目录 css基础布局 1.布局相关的标签 2.盒子模型 2-1 什么是盒子模型 2-2 margin外边距 2-3 padding内填充 2-4 案例 3.浮动(float) 3-1 什么是浮动 ...

- 深入理解java和dubbo的SPI机制

1 SPI简介 1.1 SPI(Service Provider Interface) 本质:将接口实现类的全限定名配置在文件中,并由服务加载器读取配置文件,加载实现类.这样可以在运行时,动态为接口替 ...

- 基于 Python 和 Vue 的在线评测系统

基于 Docker,真正一键部署 前后端分离,模块化编程,微服务 ACM/OI 两种比赛模式.实时/非实时评判 任意选择 丰富的可视化图表,一图胜千言 支持 Template Problem,可以添加 ...

- ERROR: Command errored out with exit status 1:

Looking in indexes: https://pypi.tuna.tsinghua.edu.cn/simple Collecting CairoSVG==2.4.2 Using cached ...