IntelliJ IDEA Windows下Spark开发环境部署

0x01 环境说明

1.1 本地

OS: windows 10

JDK: jdk1.8.0_121

Scala: scala-2.11.11

IDE: IntelliJ IDEA ULTIMATE 2017.2.1

1.2 服务器

OS: CentOS_6.5_x64

JDK: jdk1.8.111

Hadoop: hadoop-2.6.5

Spark: spark-1.6.3-bin-hadoop2.6

Scala: scala-2.11.11

0x02 windows端配置

2.1 安装JDK

配置环境变量

JAVA_HOME

CLASSPATH

Path

2.2 配置hosts

文件位置

C:\Windows\System32\drivers\etc

新增如下内容(和集群的hosts文件内容一样,根据自己集群的实际情况修改)

192.168.1.10 master

192.168.1.11 slave1

192.168.1.12 slave2

2.3 安装IntelliJ IDEA

- 注意插件安装

Maven

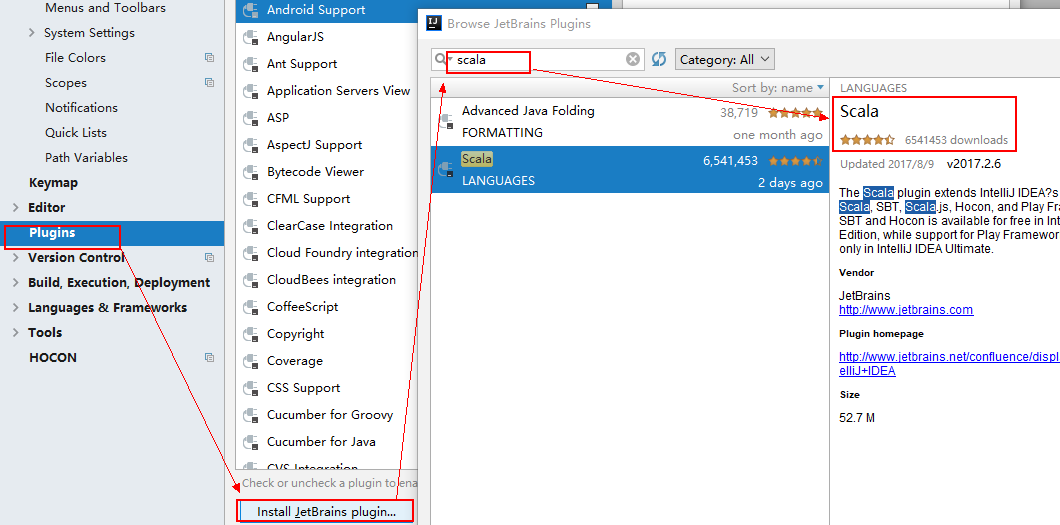

2.4 IDEA中安装scala插件

0x03 服务器端配置

3.1 安装JDK

3.2 安装Hadoop

3.3 安装Spark

0x04 测试

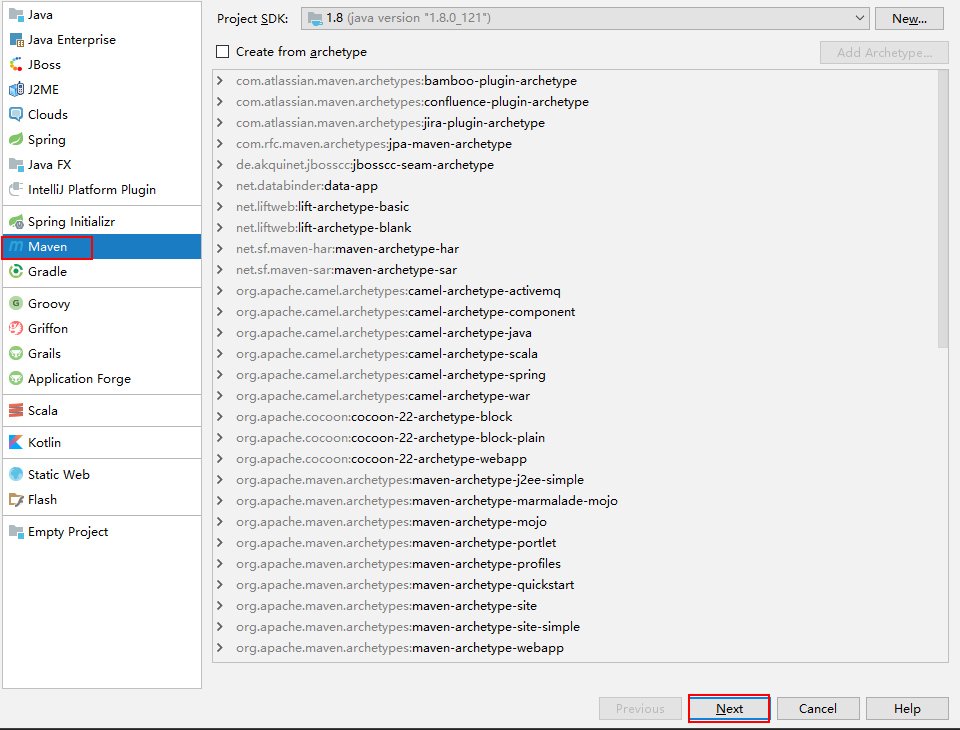

4.1 新建maven项目

4.2 添加依赖包

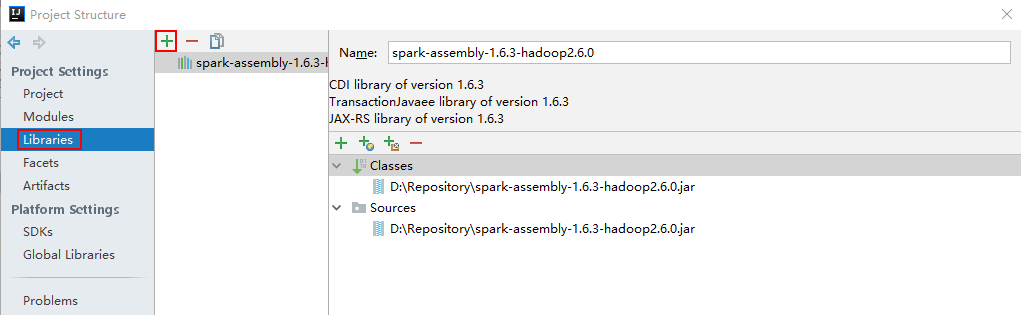

File -> Project Structure -> Libraries添加spark-assembly-1.6.3-hadoop2.6.0.jar(位置在服务器端spark/lib/下)

4.3 新建ConnectionUtil类

在src\main\java目录下新建java类ConnectionUtil

import org.apache.spark.SparkConf;

import org.apache.spark.api.java.JavaSparkContext;

public class ConnectionUtil {

public static final String master = "spark://master:7077";

public static void main(String[] args) {

SparkConf sparkConf = new SparkConf().setAppName("demo").setMaster(master);

JavaSparkContext javaSparkContext = new JavaSparkContext(sparkConf);

System.out.println(javaSparkContext);

javaSparkContext.stop();

}

}

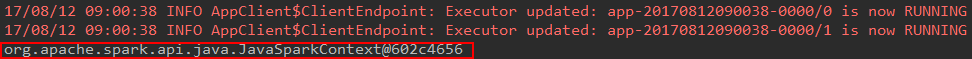

4.4 编译运行

如果出现上图结果则证明,运行正确。

4.5 运行JavaWordCount

- 数据准备,随便准备一个文档格式不限,上传到

hdfs上。

$ vim wordcount.txt

hello Tom

hello Jack

hello Ning

# 上传文件

$ hadoop fs -put wordcount.txt /user/hadoop/

# 查看文件是否上传成功

$ hadoop fs -ls /user/hadoop/

- 代码(

spark安装包中的example,指定了jar包和输入文件的路径)

import scala.Tuple2;

import org.apache.spark.SparkConf;

import org.apache.spark.api.java.JavaPairRDD;

import org.apache.spark.api.java.JavaRDD;

import org.apache.spark.api.java.JavaSparkContext;

import org.apache.spark.api.java.function.FlatMapFunction;

import org.apache.spark.api.java.function.Function2;

import org.apache.spark.api.java.function.PairFunction;

import java.util.Arrays;

import java.util.List;

import java.util.regex.Pattern;

public final class JavaWordCount {

private static final Pattern SPACE = Pattern.compile(" ");

public static void main(String[] args) throws Exception {

// if (args.length < 1) {

// System.err.println("Usage: JavaWordCount <file>");

// System.exit(1);

// }

SparkConf sparkConf = new SparkConf().setAppName("JavaWordCount")

.setMaster("spark://master:7077")

.set("spark.executor.memory", "512M");

JavaSparkContext ctx = new JavaSparkContext(sparkConf);

ctx.addJar("D:\\workspace\\spark\\JavaWordCount.jar");

String path = "hdfs://master:9000/user/hadoop/wordcount.txt";

JavaRDD<String> lines = ctx.textFile(path);

JavaRDD<String> words = lines.flatMap(new FlatMapFunction<String, String>() {

@Override

public Iterable<String> call(String s) {

return Arrays.asList(SPACE.split(s));

}

});

JavaPairRDD<String, Integer> ones = words.mapToPair(new PairFunction<String, String, Integer>() {

@Override

public Tuple2<String, Integer> call(String s) {

return new Tuple2<String, Integer>(s, 1);

}

});

JavaPairRDD<String, Integer> counts = ones.reduceByKey(new Function2<Integer, Integer, Integer>() {

@Override

public Integer call(Integer i1, Integer i2) {

return i1 + i2;

}

});

List<Tuple2<String, Integer>> output = counts.collect();

for (Tuple2<?,?> tuple : output) {

System.out.println(tuple._1() + ": " + tuple._2());

}

ctx.stop();

}

}

- 打包非常重要,否则运行会出现各种错误,甚至无法运行

在File -> Project Structure ->Artifacts点击绿色“+”,Add-->JAR-->From Modules with Dependencies

输入main class入口函数名,将Output Layout下所有jar包删掉(因为spark运行环境已经包含了这些包),如果已经存在META-INF要先将这个文件夹删除。然后Apply,OK

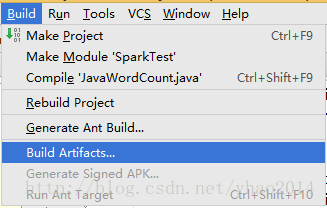

编译程序:Build-->Build Artifacts...,然后选择要编译的项目进行编译

在当前工程生成的out目录下就可以找到输出的jar包,放到程序中指定的位置(就是addJar()方法中所设置的路径)

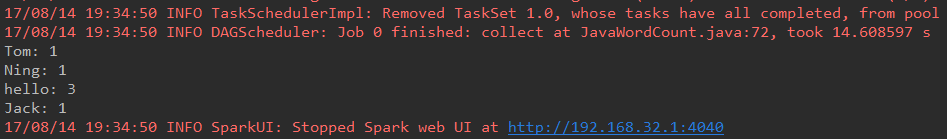

- 运行程序,结果如下

0x05 出现的问题

5.1 无法访问scala.Cloneable

java: 无法访问scala.Cloneable找不到scala.Cloneable的类文件

原因:原来使用的是spark-2.1.0-bin-hadoop2.4没有spark-assembly-1.6.3-hadoop2.6.0.jar依赖包所致。

解决:因为原来是用的hadoop版本为2.5.2相应的依赖包官网已经不再支持,所以更新的平台的hadoop环境为2.6.5,spark 2.X相应的文档很少,更改版本为1.6.3。

Create: 2017-08-12 10:33:55 星期六

Update1: 2017-08-14 20:10:47 星期一

IntelliJ IDEA Windows下Spark开发环境部署的更多相关文章

- windows下spark开发环境配置

http://www.cnblogs.com/davidwang456/p/5032766.html windows下spark开发环境配置 --本篇随笔由同事葛同学提供. windows下spark ...

- windows下go开发环境部署 (sublime+gosublime+geocode)

1.下载git.go和sublime免安装版 go下载地址:http://pan.baidu.com/s/1hq1mrDM#path=%252Fgo%252F1.5.2sublime下载地址:http ...

- 分布式版本库——Windows下Git的环境部署以及在GitHub上开源自己的项目

分布式版本库--Windows下Git的环境部署以及在GitHub上开源自己的项目 这几天着实忙的焦头烂额,可惜不是搞技术,今天周日,难得闲下来,写篇大家都想学习的Git教程,其实廖雪峰老师的网站已经 ...

- 【Objective-C】Windows下Objective-C开发环境配置

[Objective-C]Windows下Objective-C开发环境配置 ftp://ftpmain.gnustep.org/pub/gnustep/binaries/windows/ 最近打 ...

- windows下STM32开发环境的搭建

一.概述 1.说明 笔者已经写了一篇Linux下STM32开发环境的搭建 ,这两篇文章的最区别在于开发环境所处的系统平台不一样,而其实这个区别对于开发环境的搭建其实影响不大,制作局部上的操作上发生了改 ...

- QT + OpenCV + MinGW 在windows下配置开发环境

由于研究项目需要,最近开始接触C++界面设计,关于“QT + OpenCV + MinGW在windows下配置开发环境”着实让人头疼,单次配置时间相当长,也十分不容易,本人第一次配置成 ...

- Metabase在Windows下的开发环境配置

Metabase在Windows下的开发环境配置 */--> pre.src {background-color: #292b2e; color: #b2b2b2;} Metabase在Wind ...

- Windows 下 Ionic 开发环境搭建

Ionic 介绍 首先,Ionic 是什么. Ionic 是一款基于 Cordova 及 Angular 开发 Hybrid/Web APP 的前端框架,类似的其他框架有:Intel XDK等. 简单 ...

- NDK在windows下的开发环境搭建及开发过程

在Android应用的开发工程中,不管是游戏还是普通应用,都时常会用到.so即动态链接库,关于.so是什么玩意儿,有什么好处,这个大家可以在网上查一下,本人不做过多解释..so本是linux下的文件类 ...

随机推荐

- 详解ASP.NET MVC 控制器

1 概述 在阅读本篇博文时,建议结合上篇博文:详解ASP.NET MVC 路由 一起阅读,效果可能会更好些. Controller(控制器)在ASP.NET MVC中负责控制所有客户端与服务端的 ...

- vijos1046题解

题目: 学校里面有N个景点.两个景点之间可能直接有道路相连,用Dist[I,J]表示它的长度:否则它们之间没有直接的道路相连.这里所说的道路是没有规定方向的,也就是说,如果从I到J有直接的道路,那么从 ...

- Spring MVC 基本注解

1. Spring MVC 常用到的注解: @Controller @RequestMapping @RequestParam @RequestHeader @ModelAttribute @Path ...

- 面向对象15.3String类-常见功能-判断

/*3.判断 * 3.1两个字符串内容是否相同? * boolean equals(Object obj)(参数是Object,不是String,因为equals是覆盖Object里面的equals方 ...

- Azkaban使用简单笔记

官方文档:http://azkaban.github.io/ Azkaban主要的组成:1. 关系型数据库--MySQL2. AzkabanWebServer3. AzkabanExcutorServ ...

- Java并发编程笔记——技术点汇总

目录 · 线程安全 · 线程安全的实现方法 · 互斥同步 · 非阻塞同步 · 无同步 · volatile关键字 · 线程间通信 · Object.wait()方法 · Object.notify() ...

- mysql浅龟定

一,尽量不字啊数据库做运算 1,尽量不再数据库做运算, 2,将复杂运算移动到cpu 3,尽可能简单应用mysql 二,控制表数据量 1,纯 int不超过1000w 2,含char不超过500w 3,建 ...

- tensorflow 实现神经网络

import tensorflow as tf import numpy as np # 添加层 def add_layer(inputs, in_size, out_size, activation ...

- JavaScript 学习推荐

主要是个人的学习网站,书籍推荐,还有个人学习经历,以及一些学习经验或技巧 JavaScript学习网站推荐 如果想快速入门,这些是很推荐的网站 快速入门,很快能让你了解前端,有什么,做什么, ...

- Java 9 揭秘(17. Reactive Streams)

Tips 做一个终身学习的人. 在本章中,主要介绍以下内容: 什么是流(stream) 响应式流(Reactive Streams)的倡议是什么,以及规范和Java API 响应式流在JDK 中的AP ...