python网络爬虫之解析网页的XPath(爬取Path职位信息)[三]

@

前言

本章同样是解析网页,不过使用的解析技术为XPath。

相对于之前的BeautifulSoup,我感觉还行,也是一个比较常用的一种解析方式

,

并且更加的符合我们之前的一个逻辑思维,不过看情况吧,看各位准备怎么用吧。

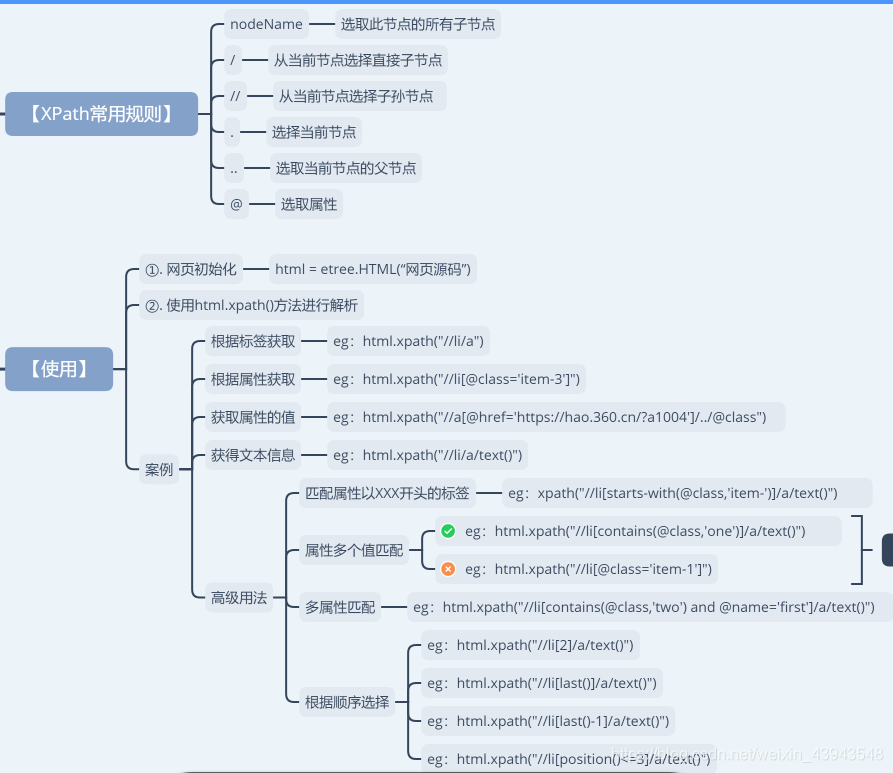

XPath的使用方法

同样的先下载lxml插件,并且导入里面的etree

"""

XPath的学习

"""

from lxml import etree

# 案例文件

html_doc = """

<div>

<ul>

<li class="item-0"><a href="www.baidu.com">baidu</a>

<li class="item-1 one" name="first"><a href="https://blog.csdn.net/qq_25343557">myblog</a>

<li class="item-1 two" name="first"><a href="https://blog.csdn.net/qq_25343557">myblog2</a>

<li class="item-2"><a href="https://www.csdn.net/">csdn</a>

<li class="item-3"><a href="https://hao.360.cn/?a1004">bbb</a>

<li class="aaa"><a href="https://hao.360.cn/?a1004">aaa</a>

"""

html = etree.HTML(html_doc)

# 1、获取所有li下的所有a标签

print(html.xpath("//li/a"))

#2、获取指定的li标签item-0

print(html.xpath("//li[@class='item-0']"))

#3、获取指定的li标签item-0下面的a标签

print(html.xpath("//li[@class='item-0']/a"))

#4、获取指定的li标签item-0下面的a标签里面的内容

print(html.xpath("//li[@class='item-0']/a/text()"))

# 高级进阶用法

# 1、匹配属性以什么类型开头的class(starts-with())

print(html.xpath("//li[starts-with(@class,'item-')]"))

# 2、匹配里面所有相同的item-1,(contains())

print(html.xpath("//li[contains(@class,'item-1')]"))

# 3、多属性的匹配(and)

print(html.xpath("//li[contains(@class,'one') and contains(@name,'first')]/a/text()"))

# 4、按顺序来排序

# 第2个

print(html.xpath("//li[2]/a/text()"))

# 最后一个

print(html.xpath("//li[last()]/a/text()"))

# 最后一个-1个

print(html.xpath("//li[last()-1]/a/text()"))

# 小于等于3的序号li

print(html.xpath("//li[position()<=3]/a/text()"))

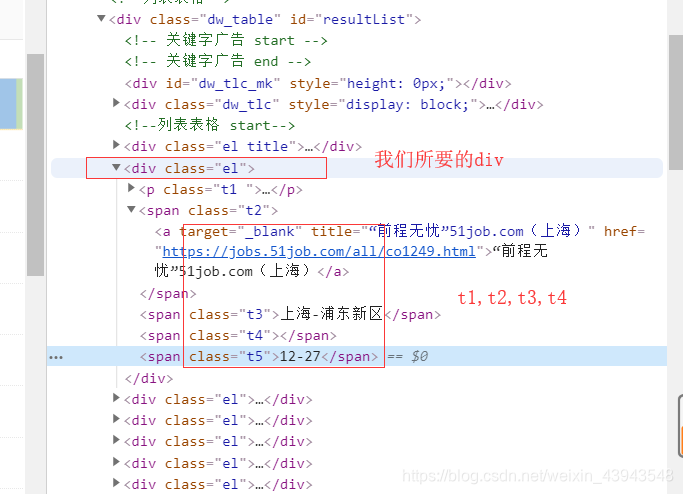

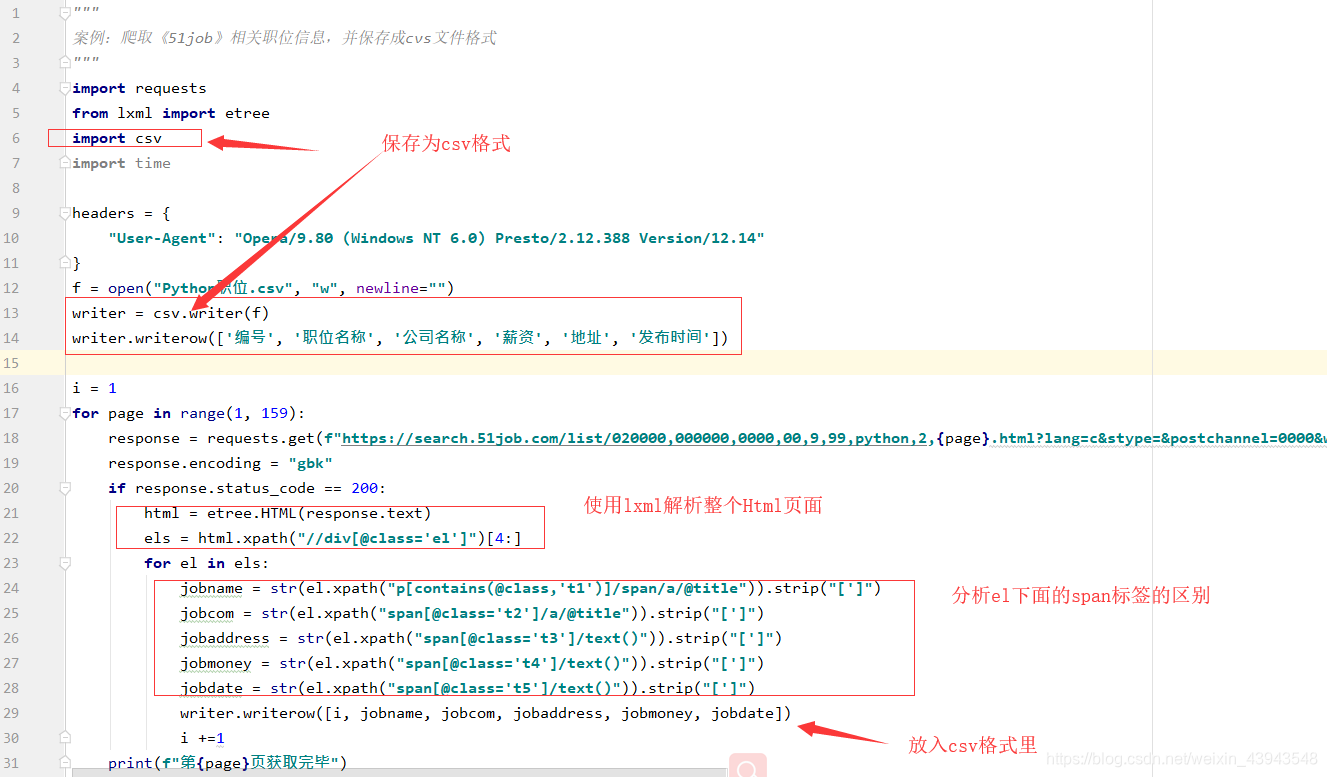

XPath爬取数据

"""

案例:爬取《51job》相关职位信息,并保存成cvs文件格式

"""

import requests

from lxml import etree

import csv

import time

headers = {

"User-Agent": "Opera/9.80 (Windows NT 6.0) Presto/2.12.388 Version/12.14"

}

f = open("Python职位.csv", "w", newline="")

writer = csv.writer(f)

writer.writerow(['编号', '职位名称', '公司名称', '薪资', '地址', '发布时间'])

i = 1

for page in range(1, 159):

response = requests.get(f"https://search.51job.com/list/020000,000000,0000,00,9,99,python,2,{page}.html?lang=c&stype=&postchannel=0000&workyear=99&cotype=99°reefrom=99&jobterm=99&companysize=99&providesalary=99&lonlat=0%2C0&radius=-1&ord_field=0&confirmdate=9&fromType=&dibiaoid=0&address=&line=&specialarea=00&from=&welfare=", headers=headers)

response.encoding = "gbk"

if response.status_code == 200:

html = etree.HTML(response.text)

els = html.xpath("//div[@class='el']")[4:]

for el in els:

jobname = str(el.xpath("p[contains(@class,'t1')]/span/a/@title")).strip("[']")

jobcom = str(el.xpath("span[@class='t2']/a/@title")).strip("[']")

jobaddress = str(el.xpath("span[@class='t3']/text()")).strip("[']")

jobmoney = str(el.xpath("span[@class='t4']/text()")).strip("[']")

jobdate = str(el.xpath("span[@class='t5']/text()")).strip("[']")

writer.writerow([i, jobname, jobcom, jobaddress, jobmoney, jobdate])

i +=1

print(f"第{page}页获取完毕")

后言

多学一种解析网页的方式多一种选择

python网络爬虫之解析网页的XPath(爬取Path职位信息)[三]的更多相关文章

- python网络爬虫之解析网页的BeautifulSoup(爬取电影图片)[三]

目录 前言 一.BeautifulSoup的基本语法 二.爬取网页图片 扩展学习 后记 前言 本章同样是解析一个网页的结构信息 在上章内容中(python网络爬虫之解析网页的正则表达式(爬取4k动漫图 ...

- python网络爬虫之解析网页的正则表达式(爬取4k动漫图片)[三]

前言 hello,大家好 本章可是一个重中之重,因为我们今天是要爬取一个图片而不是一个网页或是一个json 所以我们也就不用用到selenium模块了,当然有兴趣的同学也一样可以使用selenium去 ...

- 爬虫系列2:Requests+Xpath 爬取租房网站信息

Requests+Xpath 爬取租房网站信息 [抓取]:参考前文 爬虫系列1:https://www.cnblogs.com/yizhiamumu/p/9451093.html [分页]:参考前文 ...

- Python 网络爬虫 007 (编程) 通过网站地图爬取目标站点的所有网页

通过网站地图爬取目标站点的所有网页 使用的系统:Windows 10 64位 Python 语言版本:Python 2.7.10 V 使用的编程 Python 的集成开发环境:PyCharm 2016 ...

- (转)Python网络爬虫实战:世纪佳缘爬取近6万条数据

又是一年双十一了,不知道从什么时候开始,双十一从“光棍节”变成了“双十一购物狂欢节”,最后一个属于单身狗的节日也成功被攻陷,成为了情侣们送礼物秀恩爱的节日. 翻着安静到死寂的聊天列表,我忽然惊醒,不行 ...

- 爬虫系列3:Requests+Xpath 爬取租房网站信息并保存本地

数据保存本地 [抓取]:参考前文 爬虫系列1:https://www.cnblogs.com/yizhiamumu/p/9451093.html [分页]:参考前文 爬虫系列2:https://www ...

- 爬虫系列4:Requests+Xpath 爬取动态数据

爬虫系列4:Requests+Xpath 爬取动态数据 [抓取]:参考前文 爬虫系列1:https://www.cnblogs.com/yizhiamumu/p/9451093.html [分页]:参 ...

- 【图文详解】scrapy爬虫与动态页面——爬取拉勾网职位信息(2)

上次挖了一个坑,今天终于填上了,还记得之前我们做的拉勾爬虫吗?那时我们实现了一页的爬取,今天让我们再接再厉,实现多页爬取,顺便实现职位和公司的关键词搜索功能. 之前的内容就不再介绍了,不熟悉的请一定要 ...

- Python开发爬虫之BeautifulSoup解析网页篇:爬取安居客网站上北京二手房数据

目标:爬取安居客网站上前10页北京二手房的数据,包括二手房源的名称.价格.几室几厅.大小.建造年份.联系人.地址.标签等. 网址为:https://beijing.anjuke.com/sale/ B ...

随机推荐

- quartus在线调试的方法

quartus在线调试的方法 在Quartus II Version 7.2 Handbook Volume 3: Verification中的Section V. In-System Design ...

- 常用统计分析python包开源学习代码 numpy pandas matplotlib

常用统计分析python包开源学习代码 numpy pandas matplotlib 待办 https://github.com/zmzhouXJTU/Python-Data-Analysis

- Django_后台管理

1. 站点管理 2. 创建超级管理员 3. 添加自己的数据模型 默认是打印字符串的 4. 个性化站点管理的定制 4.1 个性化规则 admin.py 4.2 布尔值定制显示 4.3 插入班级的时候同时 ...

- (c#)亲密字符串

题目 解

- winform学习(1)初识winform

winform是Windows窗体应用程序 在窗体设计界面 单击鼠标右键--查看代码,即可转到Form1.cs的代码界面 从代码界面转到窗体设计界面的三种快捷方法:①双击解决方案资源管理器的 For ...

- mysql和oracle建表语句以及数据类型的区别

1.mysql和oracle建表语句的区别 mysql DROP TABLE IF EXISTS `order`;CREATE TABLE `order` ( `id` int(11) NOT NU ...

- xml配置文件中对于Shiro 权限管理filterChainDefinitions过滤器配置

博客转载:http://blog.csdn.net/userrefister/article/details/47807075 /** * Shiro-1.2.2内置的FilterChain * @s ...

- jsp页面直接读取mysql数据库数据显示

jsp页面直接读取mysql数据库数据显示: <%@page import="java.sql.ResultSet"%> <%@page import=" ...

- springmvc、 springboot 项目全局异常处理

异常在项目中那是不可避免的,通常情况下,我们需要对全局异常进行处理,下面介绍两种比较常用的情况. 准备工作: 在捕获到异常的时候,我们通常需要返回给前端错误码,错误信息等,所以我们需要手动封装一个js ...

- 【转载】Java容器的线程安全

转自:http://blog.csdn.net/huilangeliuxin/article/details/12615507 同步容器类 同步容器类包括Vector和Hashtable(二者是早期J ...