大数据- 自定义Log4j日记

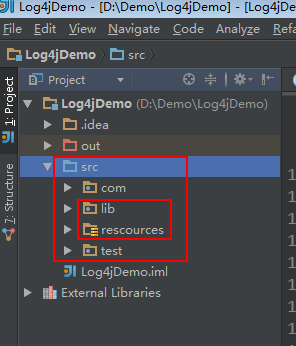

1.新建一个java project,在src下新建一个lib文件夹和 rescources 文件夹,resources文件夹不能命名错误。

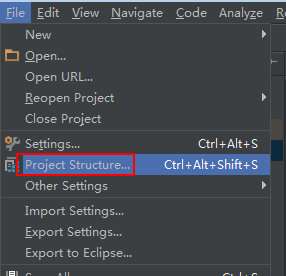

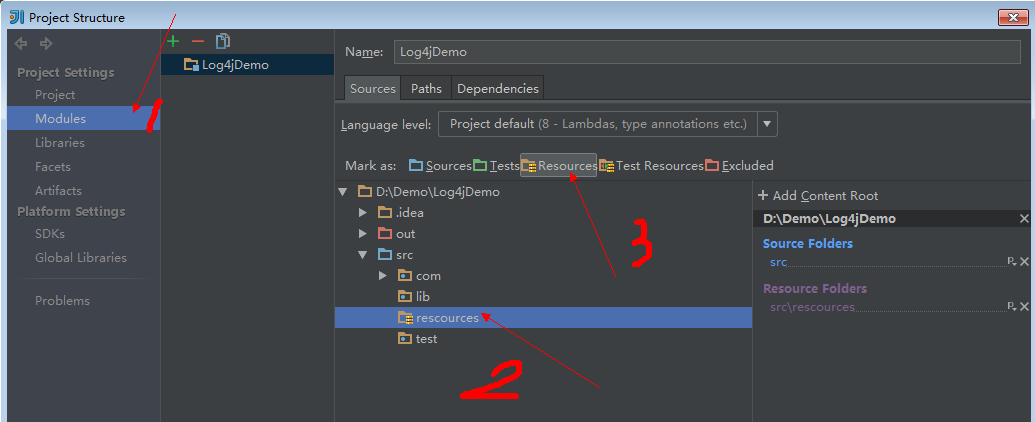

点击File——》project Structure...打开根据下图操作

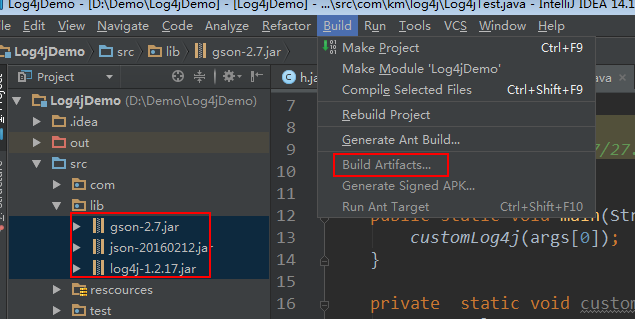

把相关jar包放进lib文件夹里并绑定。

新建一个java文件 Log4jTest.java 和 HadoopLog4j.java

package com.km.log4j; import org.apache.log4j.DailyRollingFileAppender;

import org.apache.log4j.Logger;

import org.apache.log4j.PatternLayout; /**

* Created by 166 on 2017/7/27.

*/

public class Log4jTest {

public static void main(String[] args) {

customLog4j(args[0]);

} /**

* control configuration file

*/

private static void customLog4j(String num){

Logger logger = Logger.getLogger(Log4jTest.class);

for (int i=0;i<Integer.parseInt(num);i++){

try {

Thread.sleep(200);

logger.info("this is a test");

} catch (InterruptedException e) {

e.printStackTrace();

}

}

}

新建一个

package com.km.log4j; import org.apache.log4j.AppenderSkeleton;

import org.apache.log4j.spi.LoggingEvent; /**

* Created by 166 on 2017/7/28.

*/

public class HadoopLog4j extends AppenderSkeleton{

private String context; public String getContext() {

return context;

} public void setContext(String context) {

this.context = context;

} @Override

protected void append(LoggingEvent loggingEvent) {

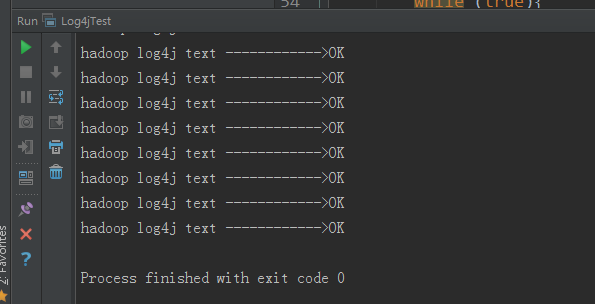

System.out.println(String.format("hadoop log4j text ------------>%s",context));

} @Override

public void close() { } @Override

public boolean requiresLayout() {

return false;

}

}

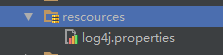

在resources文件夹下新建一个log4j.properties配置文件

#Set custom logger level to INFO and its only appender to hadoop.

#log4j.logger指定你按哪个包打日志

log4j.logger.com.km.log4j.Log4jTest=INFO,hadoop //log4j.logger.包名.类 = 日志等级,输出打印位置 log4j.appender.hadoop=com.km.log4j.HadoopLog4j //log4j.appender.打印输出位置=appender的实现类(常用DailyRollingFileAppender)

log4j.appender.hadoop.context=OK //context调用appender实现类的setContext,设置传入参数为OK

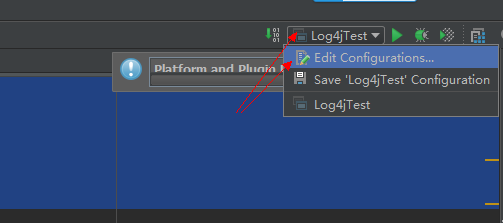

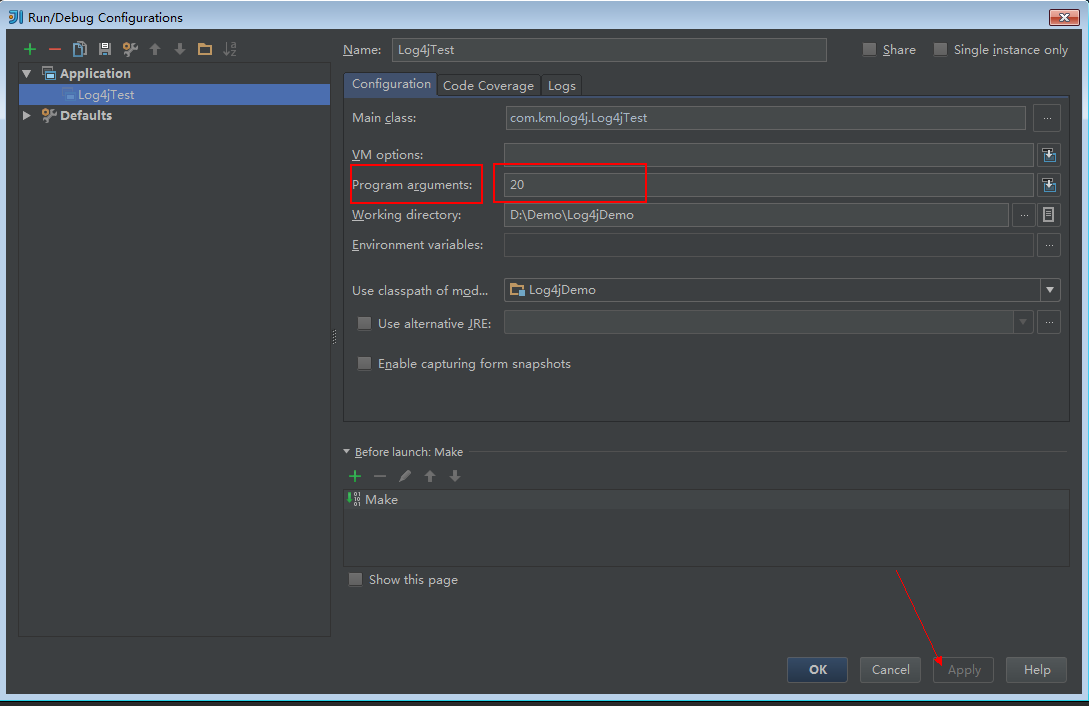

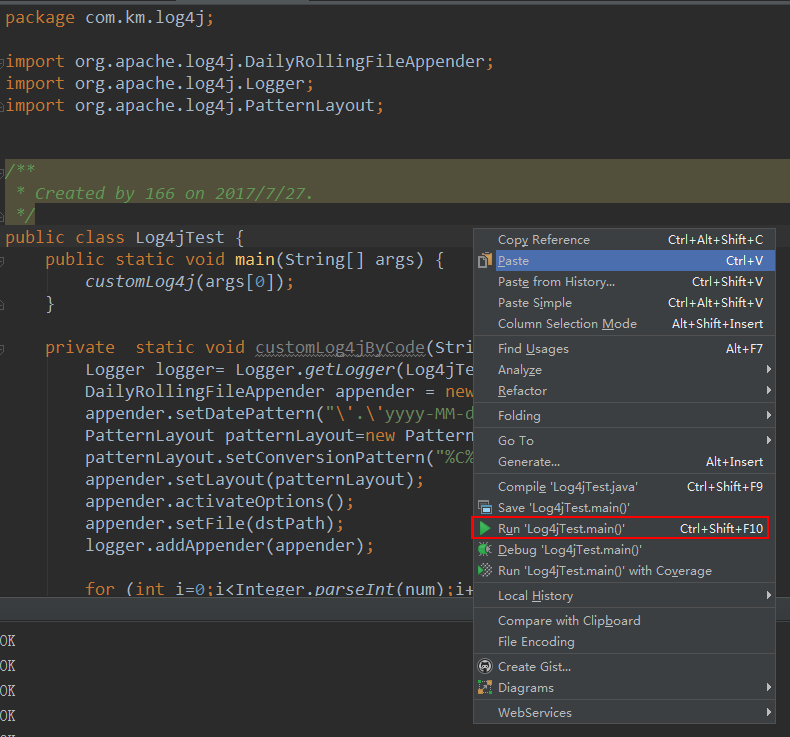

打开调试配置窗口,输入变量的值

大数据- 自定义Log4j日记的更多相关文章

- 大数据技术之_09_Flume学习_Flume概述+Flume快速入门+Flume企业开发案例+Flume监控之Ganglia+Flume高级之自定义MySQLSource+Flume企业真实面试题(重点)

第1章 Flume概述1.1 Flume定义1.2 Flume组成架构1.2.1 Agent1.2.2 Source1.2.3 Channel1.2.4 Sink1.2.5 Event1.3 Flum ...

- 大数据量场景下storm自定义分组与Hbase预分区完美结合大幅度节省内存空间

前言:在系统中向hbase中插入数据时,常常通过设置region的预分区来防止大数据量插入的热点问题,提高数据插入的效率,同时可以减少当数据猛增时由于Region split带来的资源消耗.大量的预分 ...

- 大数据学习day29-----spark09-------1. 练习: 统计店铺按月份的销售额和累计到该月的总销售额(SQL, DSL,RDD) 2. 分组topN的实现(row_number(), rank(), dense_rank()方法的区别)3. spark自定义函数-UDF

1. 练习 数据: (1)需求1:统计有过连续3天以上销售的店铺有哪些,并且计算出连续三天以上的销售额 第一步:将每天的金额求和(同一天可能会有多个订单) SELECT sid,dt,SUM(mone ...

- java 与大数据学习较好的网站

C# C#中 Thread,Task,Async/Await,IAsyncResult 的那些事儿!https://www.cnblogs.com/doforfuture/p/6293926.html ...

- 【大数据】Hive学习笔记

第1章 Hive基本概念 1.1 什么是Hive Hive:由Facebook开源用于解决海量结构化日志的数据统计. Hive是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张表, ...

- 大数据入门第五天——离线计算之hadoop(上)概述与集群安装

一.概述 根据之前的凡技术必登其官网的原则,我们当然先得找到它的官网:http://hadoop.apache.org/ 1.什么是hadoop 先看官网介绍: The Apache™ Hadoop® ...

- 自定义log4j日志级别

转载自: http://blog.csdn.net/seven_cm/article/details/26849821 自定义log4j日志级别 参考了网上资料:http://www.360doc. ...

- 大数据初级笔记二:Hadoop入门之Hadoop集群搭建

Hadoop集群搭建 把环境全部准备好,包括编程环境. JDK安装 版本要求: 强烈建议使用64位的JDK版本,这样的优势在于JVM的能够访问到的最大内存就不受限制,基于后期可能会学习到Spark技术 ...

- 大数据学习笔记——Hadoop编程实战之HDFS

HDFS基本API的应用(包含IDEA的基本设置) 在上一篇博客中,本人详细地整理了如何从0搭建一个HA模式下的分布式Hadoop平台,那么,在上一篇的基础上,我们终于可以进行编程实操了,同样,在编程 ...

随机推荐

- Linux的经常使用命令(2) - 关机

关机命令 shutdown‑h now 马上进行关机 shutdown‑r now 如今又一次启动计算机 -t sec : -t后面加秒数,即"过几秒后关机" -k : ...

- apue学习笔记(第九章 进程关系)

本章将详细地说明进程组以及POSIX.1引入的会话的概念.还将介绍登录shell和所有从登录shell启动的进程之间的关系 终端登录 BSD终端登录.系统管理者创建通常名为/etc/ttys的文件,其 ...

- 配置fio支持rbd測试引擎

fio的rbd測试引擎能够非常方便的对rbd进行測试.以下示范怎样安装fio支持rbd引擎. git clone git://git.kernel.dk/fio.git $ cd fio $ ./co ...

- jQuery Mobile开发的新闻阅读器,适应iphone和android手机

程序猿都非常赖.你懂的! 我们常常上新浪,腾讯.雅虎等各大站点上面看新闻.他们也都各自推出了自家的手机新闻阅读器.今天我自己使用jQuery Mobile 来实现这一功能.图片大小上传限制了大小250 ...

- initramfs扫描磁盘前改变磁盘上电顺序

背景: 机械硬盘需要12V 5V电源,此前设计是硬件电路默认5V有效.12V无效,然后系统通过驱动上12V电,对磁盘来说相当于先上5V后上12V,这种方式对大部分磁盘是可以的,但对于日立 HGST磁盘 ...

- 如何在cmd中启动redis

首先要指定redis安装的目录,然后输入: redis-server.exe redis.windows.conf 如果成功,则会出现redis的标志,失败的话 请转帖到: http://www.cn ...

- mycat可以干什么

单纯的读写分离,此时配置最为简单,支持读写分离,主从切换 分表分库,对于超过 1000 万的表进行分片,最大支持 1000 亿的单表分片 多租户应用,每个应用一个库,但应用程序只连接 Myca ...

- ubuntu16.04 下安装opencv2.4.9

准备工作,安装环境 sudo apt-get install build-essential cmake libgtk2.0-dev pkg-config python-dev python-nump ...

- opencl教程

http://www.altera.com.cn/corporate/news_room/releases/2013/products/nr-opencl-sdk-13.0.html http://w ...

- 想全面理解JWT?一文足矣!

有篇关于JWT的文章,叫"JWT: The Complete Guide to JSON Web Tokens",写得全面细致.为了自己能更清晰理解并惠及更多人,我把它大致翻译了过 ...