论文解读(GLA)《Label-invariant Augmentation for Semi-Supervised Graph Classification》

论文信息

论文标题:Label-invariant Augmentation for Semi-Supervised Graph Classification

论文作者:Han Yue, Chunhui Zhang, Chuxu Zhang, Hongfu Liu

论文来源:2022,NeurIPS

论文地址:download

论文代码:download

1 Introduction

我们提出了一种图对比学习的标签不变增强策略,该策略涉及到下游任务中的标签来指导对比增强。值得注意的是,我们不生成任何图形数据。相反,我们在训练阶段直接生成标签一致的表示作为增广图。

2 Methodology

2.1 Motivation

数据增强在神经网络训练中起着重要的作用。它不仅提高了学习表示的鲁棒性,而且为训练提供了丰富的数据。

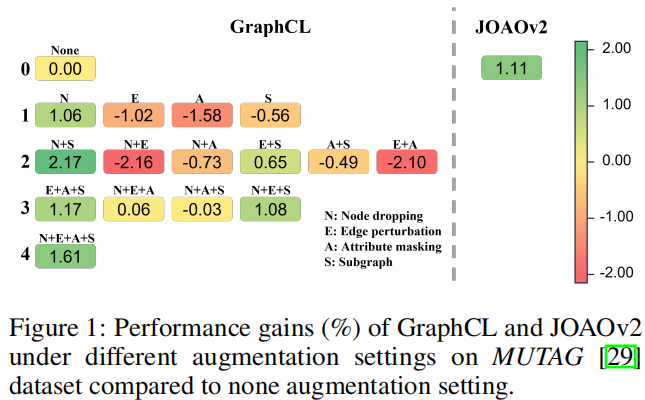

例子:(使用 $50%$ 的标签做监督信息。数据增强:node dropping, edge perturbation, attribute masking, subgraph sampling)

显然有些数据增强策略(或组合)对于模型训练又负面影响。本文进一步使用 MUTAG 中的 $100%$ 标签训练模型,然后以每种数据增强抽样概率 $0.2$ 选择数据增强图,发现 80% 的数据增强图和原始图标签一致,约 $20%$ 的数据增强图和原始图标签不一致。

2.2 Label-invariant Augmentation

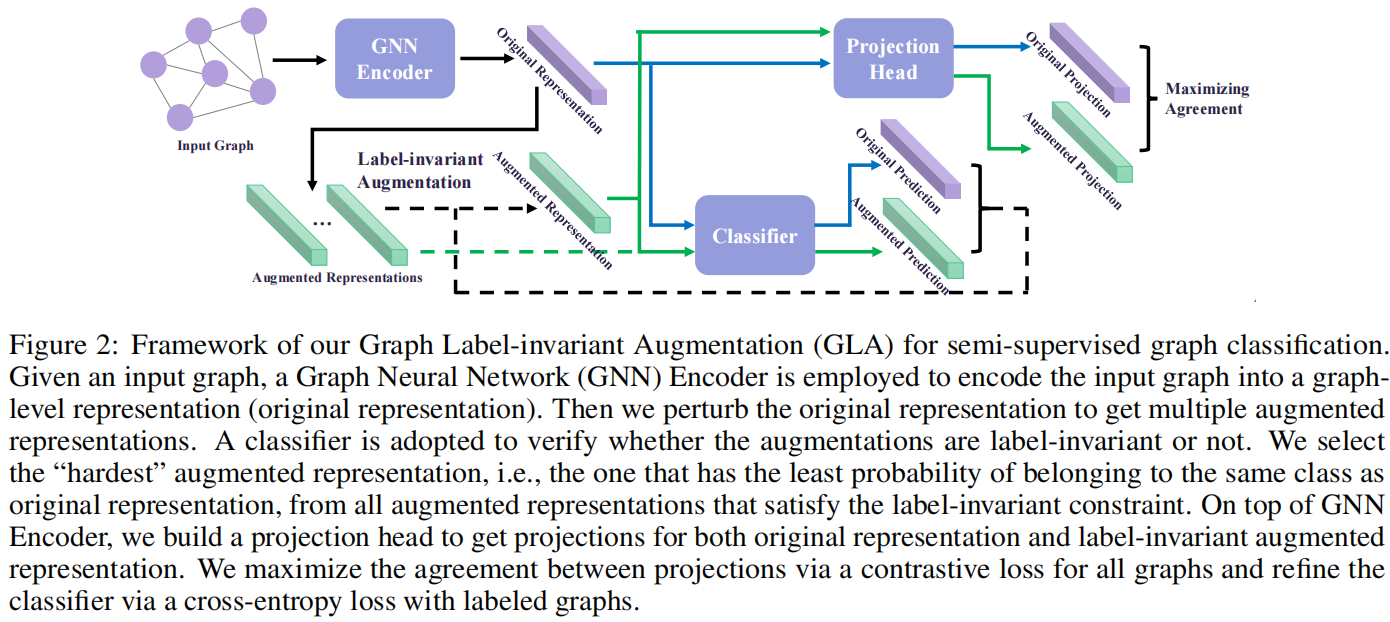

整体框架:

四个组成部分:

- Graph Neural Network Encoder

- Classifier

- Label-invariant Augmentation

- Projection Head

出发点:对于一个有标记的图,我们期望由增强表示预测的标签与地面真实标签相同。

2.2.1 Graph Neural Network Encoder

GCN layer :

其中:

- $G^{(l)}$ denotes the matrix in the l -th layer, and $G^{(0)}=X$

- $\sigma(\cdot)=\operatorname{ReLU}(\cdot)$

池化 (sum):

$H=\operatorname{Pooling}(G)\quad\quad\quad\quad(2)$

2.2.2 Classifier

基于图级表示,我们使用带有参数 $\theta_{C}$ 的全连接层进行预测:

$C^{(l+1)}=\operatorname{Softmax}\left(\sigma\left(C^{(l)} \cdot \theta_{C}^{(l)}\right)\right)\quad\quad\quad\quad(3)$

其中,$C^{(l)}$ 表示第 $l$ 层的嵌入,输入层 $C^{(0)}=H^{O}$ 或 $C^{(0)}=H^{A}$ 分别表示原始表示和增强图表示。实验中,采用了一个 2 层多层感知器,得到了对原始表示 $H^{O}$ 和增强表示 $H^{A}$ 的预测 $C^{O}$ 和 $C^{A}$。

2.2.3 Label-invariant Augmentation

不对图级表示做数据增强,而是在原始图级表示$H^{O}$上做微小扰动得到增强图级表示。

在实验中,首先计算所有图的原始表示的质心,得到每个原始表示与质心之间的欧氏距离的平均值为 $d$,即:

$d=\frac{1}{N} \sum_{i=1}^{N}\left\|H_{i}^{O}-\frac{1}{N} \sum_{j=1}^{N} H_{j}^{O}\right\|\quad\quad\quad\quad(4)$

然后计算增强图表示 $H^{A}$:

$H^{A}=H^{O}+\eta d \Delta\quad\quad\quad\quad(5)$

其中 $\eta$ 缩放扰动的大小,$\Delta$ 是一个随机单位向量。

为实现标签不变增强,每次,随机生成多个扰动,并选择符合标签不变属性的合格候选增强。在这些合格的候选对象中,选择了最困难的一个,即最接近分类器的决策边界的一个,以提高模型的泛化能力。

2.2.4 Projection Head

使用带有参数 $\theta_{P}$ 的全连接层,从图级表示中得到对比学习的投影,如下所示:

$P^{(l+1)}=\sigma\left(P^{(l)} \cdot \theta_{P}^{(l)}\right) \quad\quad\quad\quad(6)$

采用一个 2 层多层感知器,从原始表示 $H^{O}$ 和增广表示 $H^{A}$ 中得到投影 $P^{O}$ 和 $P^{A}$。

2.2.5 Objective Function

目标函数包括对比损失和分类损失。对比损失采用 NT-Xent,但只保留正对部分如下:

$\mathcal{L}_{P}=\frac{-\left(P^{O}\right)^{\top} P^{A}}{\left\|P^{O}\right\|\left\|P^{A}\right\|} \quad\quad\quad\quad(7)$

对于分类损失,采用交叉熵,其定义为:

$\mathcal{L}_{C}=-\sum_{i=1}^{c}\left(Y_{i}^{O} \log P_{i}^{O}+Y_{i}^{O} \log P_{i}^{A}\right) \quad\quad\quad\quad(8)$

其中,$Y^{O}$ 是输入图的标签,$c$ 是图类别的数量。本文只计算带标签的图的 $\mathcal{L}_{C}$。$\text{Classifier}$ 的改进将有助于标签不变的增强,反过来有利于分类器的训练。

结合等式 $\text{Eq.7}$ 和 $\text{Eq.8}$ ,总体目标函数可以写成如下:

$\underset{\Theta}{\text{min}} \quad\mathcal{L}_{P}+\alpha \mathcal{L}_{C}\quad\quad\quad\quad(9)$

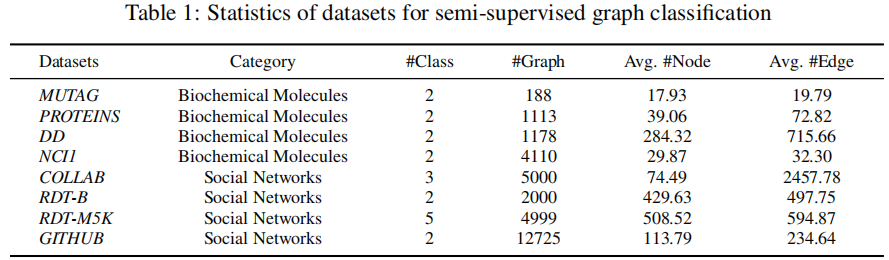

3 Experiments

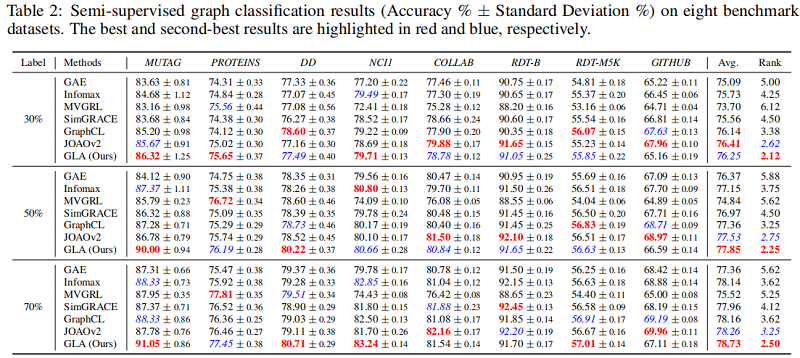

3.2 Semi-supervised graph classification results

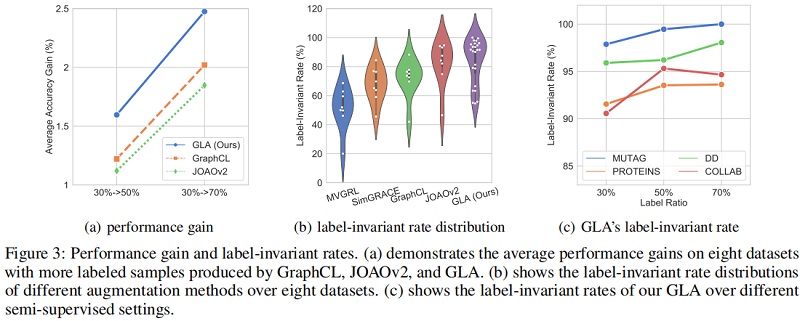

3.3 Algorithmic Performance

3.4 In-depth Exploration

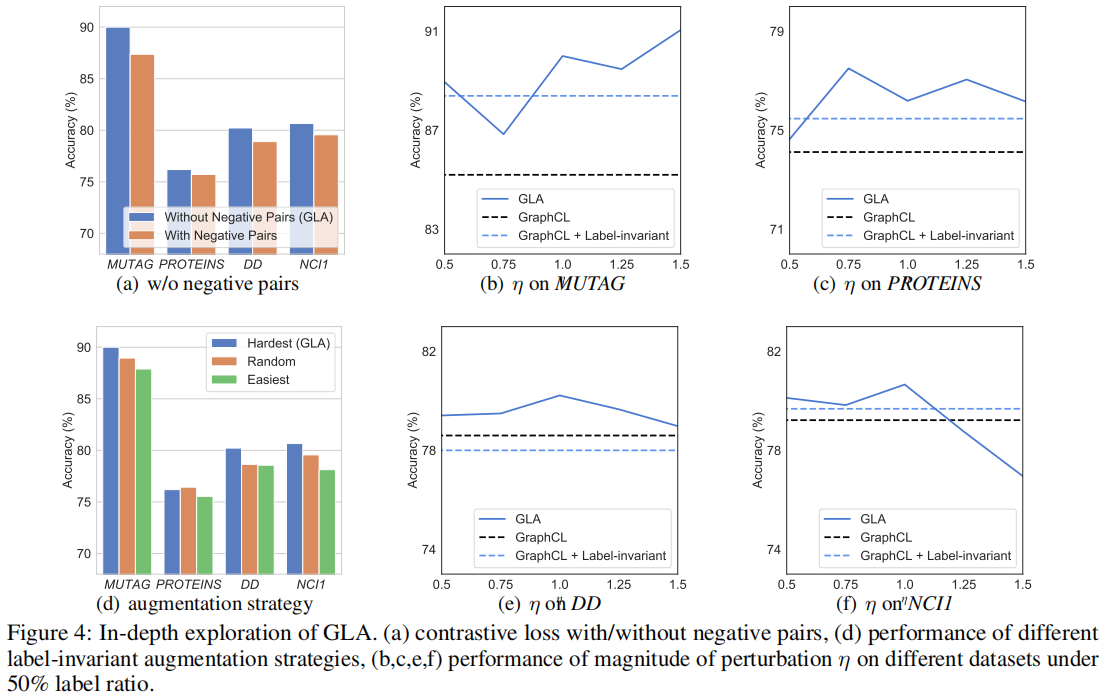

现有的图对比学习方法将来自不同源样本的增广图视为负对,并对这些负对采用实例级判别。由于这些方法分离了 pre-train 阶段和 fine-tuning 阶段,因此负对包含了来自不同源样本的增强样本,但在下游任务中具有相同的类别。

Figure 4(a) 显示了我们在四个数据集上有负对和没有负对的 GLA 的性能。可以看到,与没有负对的默认设置相比,有负对的性能显著下降,而负对在所有四个数据集上都表现一致。与现有的图对比方法不同,GLA 集成了预训练阶段和微调阶段,其中以自监督的方式设计的负对不利于下游任务。这一发现也与最近的[10,9]在视觉对比学习领域的研究结果相一致。

4 Conclusion

本文研究了图的对比学习问题。从现有的方法和训练前的方法不同,我们提出了一种新的图标签不变增强(GLA)算法,该算法集成了训练前和微调阶段,通过扰动在表示空间中进行标签不变增强。具体来说,GLA首先检查增广表示是否服从标签不变属性,并从合格的样本中选择最困难的样本。通过这种方法,GLA在不生成任何原始图的情况下实现了对比增强,也增加了模型的泛化。在8个基准图数据集上的半监督设置下的广泛实验证明了我们的GLA的有效性。此外,我们还提供了额外的实验来验证我们的动机,并深入探讨了GLA在负对、增强空间和策略效应中的影响因素。

论文解读(GLA)《Label-invariant Augmentation for Semi-Supervised Graph Classification》的更多相关文章

- 论文解读(GraphDA)《Data Augmentation for Deep Graph Learning: A Survey》

论文信息 论文标题:Data Augmentation for Deep Graph Learning: A Survey论文作者:Kaize Ding, Zhe Xu, Hanghang Tong, ...

- 论文解读(GIN)《How Powerful are Graph Neural Networks》

Paper Information Title:<How Powerful are Graph Neural Networks?>Authors:Keyulu Xu, Weihua Hu, ...

- 论文解读(GraphMAE)《GraphMAE: Self-Supervised Masked Graph Autoencoders》

论文信息 论文标题:GraphMAE: Self-Supervised Masked Graph Autoencoders论文作者:Zhenyu Hou, Xiao Liu, Yukuo Cen, Y ...

- 论文解读(SEP)《Structural Entropy Guided Graph Hierarchical Pooling》

论文信息 论文标题:Structural Entropy Guided Graph Hierarchical Pooling论文作者:Junran Wu, Xueyuan Chen, Ke Xu, S ...

- 论文解读(SUBLIME)《Towards Unsupervised Deep Graph Structure Learning》

论文信息 论文标题:Towards Unsupervised Deep Graph Structure Learning论文作者:Yixin Liu, Yu Zheng, Daokun Zhang, ...

- 论文解读(GSAT)《Interpretable and Generalizable Graph Learning via Stochastic Attention Mechanism》

论文信息 论文标题:Interpretable and Generalizable Graph Learning via Stochastic Attention Mechanism论文作者:Siqi ...

- 论文解读(GMT)《Accurate Learning of Graph Representations with Graph Multiset Pooling》

论文信息 论文标题:Accurate Learning of Graph Representations with Graph Multiset Pooling论文作者:Jinheon Baek, M ...

- 论文解读(ClusterSCL)《ClusterSCL: Cluster-Aware Supervised Contrastive Learning on Graphs》

论文信息 论文标题:ClusterSCL: Cluster-Aware Supervised Contrastive Learning on Graphs论文作者:Yanling Wang, Jing ...

- 论文解读(PPNP)《Predict then Propagate: Graph Neural Networks meet Personalized PageRank》

论文信息 论文标题:Predict then Propagate: Graph Neural Networks meet Personalized PageRank论文作者:Johannes Gast ...

- 论文解读(DropEdge)《DropEdge: Towards Deep Graph Convolutional Networks on Node Classification》

论文信息 论文标题:DropEdge: Towards Deep Graph Convolutional Networks on Node Classification论文作者:Yu Rong, We ...

随机推荐

- R型医用变压器为什么越来越受大众喜爱?

传统的家用电器.手机行业在2018年给电子变压器领域产生重要的冲击性,现如今,智能医疗领域日渐增加,正好是R型医疗变压器行业转型的突破口. 近些年,在我国医疗器械领域因为一个新的科技进步和工程设计持续 ...

- Little Girl and Problem on Trees

题意 给定一棵无边权的树,最多只有一个点度数超过2,有两种操作 1)(0 u x d)将距离u节点d距离之内的节点的值加上x 2)(1 u)询问u节点的值 n<=100000,q<=100 ...

- 《吐血整理》进阶系列教程-拿捏Fiddler抓包教程(17)-Fiddler如何充当第三者,再识AutoResponder标签-下篇

1.简介 上一篇宏哥主要讲解的一些在电脑端的操作和应用,今天宏哥讲解和分享一下,在移动端的操作和应用.其实移动端和PC端都是一样的操作,按照宏哥前边抓取移动端包设置好,就可以开始实战了. 2.界面功能 ...

- KingbaseES 如何把一个schema下的所有对象访问权限授权给其他用户

用户需求:新建一个用户 B,需要能够查询A用户的所有表,并且对以后新建的表也要有select权限. 问题分析:对于现有的表可以通过动态sql批量进行授权,但是未来新建的表要如何进行授权呢? 查询了帮助 ...

- OpenFOAM编程 | Hello OpenFOAM

写在前面 OpenFOAM 是一个非常好用的开源程序包,笔者一直在研究和使用,其编程语言是笔者非常喜欢使用的 C++.但是笔者不是很喜欢 OpenFOAM 自己的构建工具 wmake,更倾向于使用 C ...

- JS数据结构之 Map

JS数据结构之 Map Map介绍 Map(映射)是ES6引入的一种数据结构.这是一种存储键值对列表很方便的方法,类似于其他编程语言的哈希表. HashMap(哈希表),也叫做散列表.是根据关键码值 ...

- 装饰Hexo博客以及部署个人站点

我的博客最开始采用的是Hexo+hexo-theme-next搭建的,使用GitHub Pages托管并进行自动化部署,写文发布的流程非常简单方便,云端写作发布也轻而易举. 本来事情到这里就应该结束了 ...

- 《Java基础——抽象与接口》

Java基础--抽象与接口 一.抽象: 规则: 关键字 abstract 修饰的类称为抽象类. 子类通过关键字extends实现继承. 关键字 abstract 修饰的方法称为抽象方法,抽 ...

- MySQL数据备份 mysqldump 详解

MySQL数据备份流程 1 打开cmd窗口 通过命令进行数据备份与恢复: 需要在Windows的命令行窗口中进行: l 开始菜单,在运行中输入cmd回车: l 或者win+R,然后输入cmd回车,即可 ...

- k8s实际操作中的小知识点

1.批量执行yaml文件 # 把所有要执行的yaml文件放在同一个目录下,并且切换到这个目录下 kubectl apply -f . 2.利用pod的亲和和反亲和功能把pod调度到不同的node上 亲 ...