搭建一套完整的ELK系统

ELK日志收集系统介绍

一 简单介绍

ELK部署搭建有很多成型的方案,这里推荐一种比较中规中矩的方案,它整合了logstash比较消耗资源以及当服务端临时宕机的时候出现数据丢失的问题,主要由filebeat+redis+logstash+elasticsearch+kibana构成,在每个需要收集日志的机器上面下发filebeat作为日志收集端,redis作为消息队列,并且设置集群,设置高可用,logstatsh作为所有收集到的日志筛选,清洗端,而elasticsearch作为所有的日志的存储端,kibana作为日志的展示平台,展示所有的收集日志并提供图标等。

二 搭建介绍

这里准备了三台本地虚拟机,他们的信息以及将要部署的软件如下所示。

| 名称 | ip地址 | 角色 | 部署应用 | 备注 |

| devops1 | 172.16.173.141 | 日志客户端,消息队列缓存端,日志集中处理端,日志分布存储端,日志展示端 | filebeat,redis,logstash,elasticsearch,kibana | 服务端 |

| devops2 | 172.16.173.142 | 日志客户端,消息队列缓存端,日志分布存储端 | filebeat,redis,elasticsearch | 客户端 |

| devops3 | 172.16.173.143 | 日志客户端,消息队列缓存端,日志分布存储端 | filebeat,redis,elasticsearch | 客户端 |

注意: 所有部署的应用都是以systemctl的形式进行管理

三 在每台服务器上面开始部署日志收集端,这里使用ansible的脚本形式对服务器进行批量部署(ansible相关的知识自己补充学习)

3.1 安装filebeat并将其使用systemctl进行部署

3.1.1 提前下载好需要安装的filebeat的文件以及service,这里是rpm包为 filebeat-7.7.0-x86_64.rpm

3.1.2 service文件是

[Unit]

Description=Filebeat sends log files to Logstash or directly to Elasticsearch.

Documentation=https://www.elastic.co/products/beats/filebeat

Wants=network-online.target

After=network-online.target [Service] Environment="BEAT_LOG_OPTS="

Environment="BEAT_CONFIG_OPTS=-c /etc/filebeat/filebeat.yml"

Environment="BEAT_PATH_OPTS=-path.home /usr/share/filebeat -path.config /etc/filebeat -path.data /var/lib/filebeat -path.logs /var/log/filebeat"

ExecStart=/usr/share/filebeat/bin/filebeat -environment systemd $BEAT_LOG_OPTS $BEAT_CONFIG_OPTS $BEAT_PATH_OPTS

Restart=always [Install]

WantedBy=multi-user.target

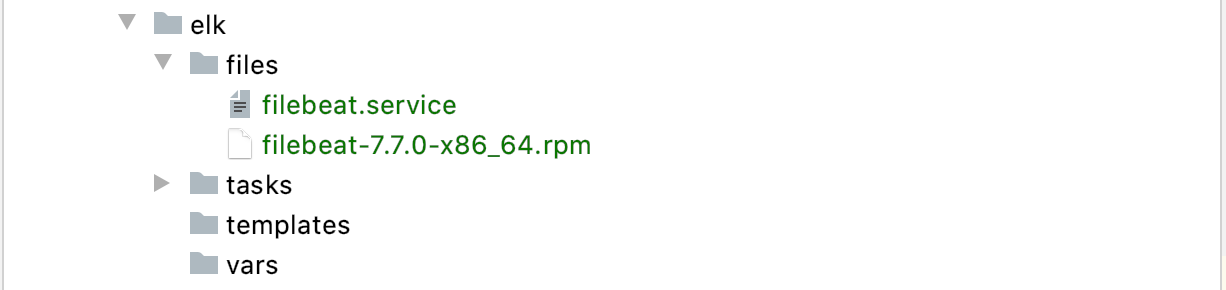

3.1.3 按照ansible工程组织如下所示

3.1.4 最后就是filebeat的安装playbook

- name: copy filebeat rpm to remote

copy: src=filebeat-7.7.0-x86_64.rpm dest=/root mode=755 force=yes - name: rpm install filebeat rpm

shell: rpm -ivh filebeat-7.7.0-x86_64.rpm

args:

chdir: /root - name: copy service to remote

copy: src=filebeat.service dest=/usr/lib/systemd/system/filebeat.service force=yes mode=755 - name: start filebeat service

systemd: name=filebeat state=restarted enabled=yes

3.2 在每台服务器安装redis中间件作为消息队列,防止在logstatsh在意外中断的时候出现日志文件丢失,前面的工程结构以及ansible不再追述,这里只介绍如何使用ansible安装redis消息中间件

- name: install wget

yum: name=wget state=present - name: install redis

shell: "wget http://download.redis.io/releases/redis-4.0.6.tar.gz"

args:

chdir: /usr/local

ignore_errors: false - name: tar redis

shell: "tar -zxvf redis-4.0.6.tar.gz"

args:

chdir: /usr/local - name: install gcc

yum: name=gcc state=present - name: make

shell: "make MALLOC=libc"

args:

chdir: /usr/local/redis-4.0.6 - name: make install

shell: "make install"

args:

chdir: /usr/local/redis-4.0.6/src - name: remove old redis config

lineinfile:

path: /usr/local/redis-4.0.6/redis.conf

regexp: '^#*?daemonize no|^#*?daemonize yes'

state: absent - name: add new redis config

lineinfile:

path: /usr/local/redis-4.0.6/redis.conf

line: "daemonize yes"

state: present - name: start redis

shell: "/usr/local/bin/redis-server /usr/local/redis-4.0.6/redis.conf"

args:

chdir: /root

ignore_errors: true

3.3 在devops1上面部署logstash

搭建一套完整的ELK系统的更多相关文章

- 基于springboot+bootstrap+mysql+redis搭建一套完整的权限架构【六】【引入bootstrap前端框架】

https://blog.csdn.net/linzhefeng89/article/details/78752658 基于springboot+bootstrap+mysql+redis搭建一套完整 ...

- 搭建一套完整的Mysql5.7innodbcluster(GroupReplication+mysqlrouter)

先说三个大步骤: 搭Mysql5.7 Group Replication ,配置成单主模式 安装Mysqlshell,配innodbcluster 安装Mysql-router 第一步:搭Mysql5 ...

- 使用express+shell在服务器上搭建一套简单的前端部署系统

前言 个人项目越来越多,部署需要频繁操作服务器,所以手动搭建一套简单的部署系统. 效果如图 其中包含 原生html+css+js项目,单页面react, vue, angular项目,实现了一键打包发 ...

- Docker笔记(十):使用Docker来搭建一套ELK日志分析系统

一段时间没关注ELK(elasticsearch —— 搜索引擎,可用于存储.索引日志, logstash —— 可用于日志传输.转换,kibana —— WebUI,将日志可视化),发现最新版已到7 ...

- 本地搭建ELK系统

ELK系统主要由三部分组成,各自是elasticsearch.logstash.kibana. ELK系统收到推送过来的日志后.首先由logstash解析日志中的字段,分解成一个一个的关键字. ela ...

- ELK系统搭建流程

ELK系统搭建流程 1. Logstash 1.1 安装 注:安装在需要收集日志的机器上. cd /data/softs sudo wget https://download.elastic.co/l ...

- 用ELK搭建简单的日志收集分析系统【转】

缘起 在微服务开发过程中,一般都会利用多台服务器做分布式部署,如何能够把分散在各个服务器中的日志归集起来做分析处理,是一个微服务服务需要考虑的一个因素. 搭建一个日志系统 搭建一个日志系统需要考虑一下 ...

- 手把手搭建一套基于 Sentry 的异常监控系统

手把手搭建一套基于 Sentry 的异常监控系统 Sentry 开源版 DevOps refs https://github.com/getsentry/sentry sentry-anomaly-m ...

- 手把手0基础项目实战(一)——教你搭建一套可自动化构建的微服务框架(SpringBoot+Dubbo+Docker+Jenkins)...

原文:手把手0基础项目实战(一)--教你搭建一套可自动化构建的微服务框架(SpringBoot+Dubbo+Docker+Jenkins)... 本文你将学到什么? 本文将以原理+实战的方式,首先对& ...

- 部署一套完整的Kubernetes高可用集群(二进制,v1.18版)

一.前置知识点 1.1 生产环境可部署Kubernetes集群的两种方式 目前生产部署Kubernetes集群主要有两种方式: kubeadm Kubeadm是一个K8s部署工具,提供kubeadm ...

随机推荐

- Java 编程指南:入门,语法与学习方法

Java 是什么? Java 是一种流行的编程语言,诞生于 1995 年.由 Oracle 公司拥有,运行在超过 30 亿台设备上.Java 可以用于: 移动应用程序(尤其是 Android 应用) ...

- 当使用git出现提示untracked files时怎么办?

当使用 git 出现提示 untracked files 时怎么办? 背景介绍: 在使用 git 工具时,遇到如下错误. 报错内容: $ git status On branch master No ...

- linux下升级openssh参考[不建议采用此法安装]

本人不见一采用这种方法安装,只是当遇到问题时候有一定的参考意义,所以贴了上来.建议使用yum方式安装,详见在下另一篇博文: http://blog.csdn.net/lqzixi/article/de ...

- redis 简单整理——redis shell[九]

前言 简单介绍一下redis的shell命令. 正文 redis 提供了一些工具,如redis-cli.redis-server.redis-benchmark等. redis-cli -r 对red ...

- Java入门02:IDEA安装教程

Java入门02:IDEA安装教程 下载IDEA 首先进入官网进行下载,地址:https://www.jetbrains.com/idea/download/#section=windows 我这里选 ...

- dom4j 通用解析器,解析成List<Map<String,Object>>

import java.io.InputStream; import java.util.Iterator; import java.util.LinkedHashMap; import java.u ...

- vue项目node-scss装不上问题( vue执行npm install报错: Can‘t find Python executable “python“, you can set the PYTHON env variable

一.描述从网上下载的一个Vue模板项目,导入VsCode,执行npm install命令后,报错了,报错的信息是node-sass安装失败,同时提示需要python环境的错误信息,这是因为安装node ...

- Node 中的 Stream ?应用场景?

一.是什么 流(Stream),是一种数据传输手段,是端到端信息交换的一种方式,是有顺序的,是逐块读取数据.处理内容,用于顺序读取输入或写入输出 在很多时候,流(Stream)是字节流(Byte St ...

- 三款免费强大的SSH工具食用指南

食用清单 XShell FinalShell Electerm 食用方案 XShell 先说说老牌ssh工具XShell吧,用过很多年,说实话没啥别的毛病挺好用的.不过,还是有些地方有待加强,比如文件 ...

- 力扣609(java&python)-在系统中查找重复文件(中等)

给你一个目录信息列表 paths ,包括目录路径,以及该目录中的所有文件及其内容,请你按路径返回文件系统中的所有重复文件.答案可按 任意顺序 返回. 一组重复的文件至少包括 两个 具有完全相同内容的文 ...