Hadoop 单节点(或集群)基本配置信息

1. 默认配置文件: 存放于Hadoop对应的jar包中

core-default.xmlhdfs-default.xmlyarn-default.xmlmapred-default.xml

2. 自定义配置文件: $HADOOP_HOME/etc/hadoop

core-site.xmlhdfs-site.xmlyarn-site.xmlmapred-site.xml

2.1 core-site.xml

<configuration>

<property>

<!-- 指定HDFS中NameNode的地址 -->

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

<!-- 指定Hadoop运行时产生文件的存储目录,hadoop启动时,会自动创建 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/(自定义路径)/hadoop-2.8.5/data/tmp</value>

</property>

</configuration>

2.2 hadoop-env.sh

export JAVA_HOME=服务器java环境变量

2.3 hdfs-site.xml

<configuration>

<!-- nameNode 文件的副本数量 -->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<!-- nameNode 的访问地址-->

<property>

<name>dfs.namenode.rpc-bind-host</name>

<value>0.0.0.0</value>

</property>

</configuration>

2.4 yarn-site.xml

<configuration>

<!-- Reducer 获取数据的方式-->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>0.0.0.0</value>

</property>

<!-- 指定YARN 的 ResourceManager 的地址-->

<property>

<name>yarn.resourcemanager.webapp.address</name>

<value>${yarn.resourcemanager.hostname}:8090</value>

</property>

<!-- 开启日志聚集功能 -->

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<!-- 日志保留7天 -->

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>604800</value>

</property>

</configuration>

2.5 yarn-env.sh 配置

export JAVA_HOME=服务器java环境变量

2.6 mapred-site.xml

<configuration>

<!-- 指定MR运行在YARN上 -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<!-- 历史记录服务器端地址 -->

<property>

<name>mapreduce.jobhistory.address</name>

<value>localhost:10020</value>

</property>

<!-- 历史服务器web端地址 -->

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>0.0.0.0:8091</value>

</property>

</configuration>

2.7 mapred-env.sh 配置

export JAVA_HOME=服务器java环境变量

3. Hadoop 集群配置

3.1 节点内容预览

| 节点1 | 节点2 | 节点3 | |

|---|---|---|---|

| HDFS | NameNode DataNode |

DataNode | SecondaryNameNode DataNode |

| YARN | NodeManager | ResourceManager NodeManager |

NodeManager |

3.2 core-site.xml 配置

<configuration>

<property>

<!-- 指定HDFS中NameNode的地址 -->

<name>fs.defaultFS</name>

<value>hdfs://节点1:9000</value>

</property>

<!-- 指定Hadoop运行时产生文件的存储目录,hadoop启动时,会自动创建 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/(自定义路径)/hadoop-2.8.5/data/tmp</value>

</property>

</configuration>

3.3 hadoop-env.sh 配置

export JAVA_HOME=服务器java环境变量

3.4 hdfs-site.xml 配置

<configuration>

<!-- nameNode 文件的副本数量 -->

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

<!-- 指定 Hadoop 辅助名称节点主机配置(SecondaryNameNode) -->

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>节点3主机名称:端口号</value>

</property>

</configuration>

3.5 yarn-env.sh 配置

export JAVA_HOME=服务器java环境变量

3.6 yarn-site.xml 配置

<configuration>

<!-- Reducer 获取数据的方式-->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>节点2</value>

</property>

<!-- 指定YARN 的 ResourceManager 的地址-->

<property>

<name>yarn.resourcemanager.webapp.address</name>

<value>${yarn.resourcemanager.hostname}:8090</value>

</property>

<!-- 开启日志聚集功能 -->

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<!-- 日志保留7天 -->

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>604800</value>

</property>

</configuration>

3.7 mapred-env.sh 配置

export JAVA_HOME=服务器java环境变量

3.8 mapred-site.xml 配置

<configuration>

<!-- 指定MR运行在YARN上 -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

3.9 slaves 配置

节点1

节点2

节点3

4. 常用命令

bin/hdfs namenode -format: 格式化命令;执行命令前,需要将单节点(或集群)中的/data,/logs目录删除。bin/hdfs dfs -put 待上传文件 上传的目的地:将本地文件上传至hdfs中。sbin/hadoop-daemon.sh start(stop) namenode: 启动(或停止)单节点NameNode。sbin/hadoop-daemon.sh start(stop) datanode: 启动(或停止)单节点DataNode。sbin/yarn-daemon.sh start(stop) resourcemanager: 启动(或停止)单节点ResourceManager。sbin/yarn-daemon.sh start(stop) nodemanager: 启动(或停止)单节点NodeManager。sbin/mr-jobhistory-daemon.sh start(stop) historyserver: 启动(或停止)单节点History记录。sbin/start-dfs.sh: 启动HDFS集群(注意:所有节点均已配置"Hadoop目录/etc/hadoop/slaves")。sbin/start-yarn.sh: 启动YARN集群(注意:所有节点均已配置"Hadoop目录/etc/hadoop/slaves"; 另外,需要在ResourceManager服务器启动)。sbin/stop-dfs.sh: 停止HDFS集群。sbin/stop-yarn.sh: 停止YARN集群。

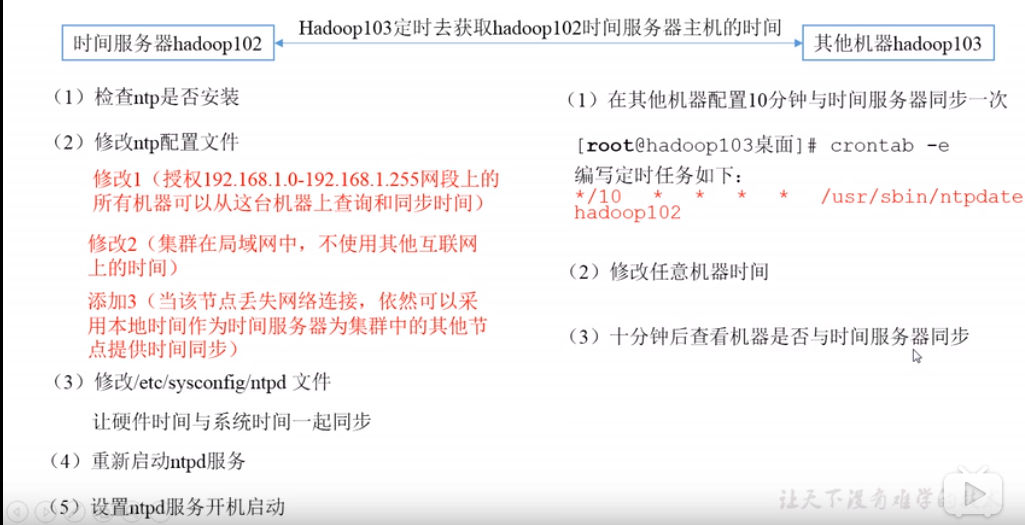

5. 集群时间同步

- 时间同步的方式:找一个机器, 作为时间服务器,所有机器与这台集群时间进行定时的同步;

- 检查

ntp是否安装rpm -qa|grep ntp; - 修改

ntp配置文件/etc/ntp.conf; - 修改

/etc/sysconfig/ntpd文件;- 让硬件时间与系统时间一起同步;

- 重启

ntpd服务; - 设置

ntpd服务开机启动;

- 检查

**参考资料:**

- [设置集群时间同步](https://www.bilibili.com/video/av32081351/?p=44)

- [rpm命令](http://man.linuxde.net/rpm)

Hadoop 单节点(或集群)基本配置信息的更多相关文章

- 使用Minikube运行一个本地单节点Kubernetes集群(阿里云)

使用Minikube运行一个本地单节点Kubernetes集群中使用谷歌官方镜像由于某些原因导致镜像拉取失败以及很多人并没有代理无法开展相关实验. 因此本文使用阿里云提供的修改版Minikube创建一 ...

- Hadoop 2.6.1 集群安装配置教程

集群环境: 192.168.56.10 master 192.168.56.11 slave1 192.168.56.12 slave2 下载安装包/拷贝安装包 # 存放路径: cd /usr/loc ...

- Kafka单节点及集群配置安装

一.单节点 1.上传Kafka安装包到Linux系统[当前为Centos7]. 2.解压,配置conf/server.property. 2.1配置broker.id 2.2配置log.dirs 2. ...

- K8s二进制部署单节点 etcd集群,flannel网络配置 ——锥刺股

K8s 二进制部署单节点 master --锥刺股 k8s集群搭建: etcd集群 flannel网络插件 搭建master组件 搭建node组件 1.部署etcd集群 2.Flannel 网络 ...

- Hadoop安装教程_集群/分布式配置

配置集群/分布式环境 集群/分布式模式需要修改 /usr/local/hadoop/etc/hadoop 中的5个配置文件,更多设置项可点击查看官方说明,这里仅设置了正常启动所必须的设置项: slav ...

- 1.如何在虚拟机ubuntu上安装hadoop多节点分布式集群

要想深入的学习hadoop数据分析技术,首要的任务是必须要将hadoop集群环境搭建起来,可以将hadoop简化地想象成一个小软件,通过在各个物理节点上安装这个小软件,然后将其运行起来,就是一个had ...

- ActiveMQ的单节点和集群部署

平安寿险消息队列用的是ActiveMQ. 单节点部署: 下载解压后,直接cd到bin目录,用activemq start命令就可启动activemq服务端了. ActiveMQ默认采用61616端口提 ...

- 使用Minikube运行一个本地单节点Kubernetes集群

使用Minikube是运行Kubernetes集群最简单.最快捷的途径,Minikube是一个构建单节点集群的工具,对于测试Kubernetes和本地开发应用都非常有用. ⒈安装Minikube Mi ...

- CentOS系统下Hadoop 2.4.1集群安装配置(简易版)

安装配置 1.软件下载 JDK下载:jdk-7u65-linux-i586.tar.gz http://www.oracle.com/technetwork/java/javase/downloads ...

- Hadoop 2.5.1集群安装配置

本文的安装只涉及了hadoop-common.hadoop-hdfs.hadoop-mapreduce和hadoop-yarn,并不包含HBase.Hive和Pig等. http://blog.csd ...

随机推荐

- C# 使用多线程,在关闭窗体时 怎么关闭窗体的所有线程,使程序退出。

this.Close(); 只是关闭当前窗口,若不是主窗体的话,是无法退出程序的,另外若有托管线程(非主线程),也无法干净地退出: Application.Exit(); 强制所有消息中止,退出 ...

- 034_非交互自动生成 SSH 密钥文件

#!/bin/bash#-t 指定 SSH 密钥的算法为 RSA 算法;-N 设置密钥的密码为空;-f 指定生成的密钥文件存放在哪里 rm -rf ~/.ssh/{known_hosts,id_rsa ...

- 03_每周 5 使用 tar 命令备份/var/log 下的所有日志文件

]# vim /root/logbak.shtar -czf log-`date +%Y%m%d`.tar.gz /var/log ]# crontab -e -u root00 03 * * 5 / ...

- 牛客练习赛55 E-树 树形DP

题意 你有一颗大小为\(n\)的树,点从\(1\)到\(n\)标号. 设\(dis(x,y)\)表示\(x\)到\(y\)的距离. 求\(\sum_{i=1}^{n}\sum_{j=1}^{n}di ...

- Appium获取toast消息

Android获取toast,需要在参数里设置automationName:Uiautomator2 设置设备的信息 desired_caps = { 'platformName': 'Android ...

- 2019.6.28 校内测试 T2 【音乐会】二重变革

看到这个题之后,一个很暴力很直接的想法就是贴上题目中的代码然后交上去走人,但是很显然这是会TLE+MLE的,想想谁会这么傻把主要代码给你QwQ~: 其实这段代码是想告诉你一件事:用序列中的大数减去小数 ...

- PG数据库创建并执行存储过程批量插入数据

记录一下PG数据库创建并执行存储过程批量插入数据的SQL: create or replace function addId() returns boolean AS $BODY$ declare i ...

- 重读APUE(12)-SIGCHLD与僵尸进程

SIGCHLD信号是当子进程终止时向父进程发送的信号:它的语义如下: 如果进程明确的将该信号设置为SIG_IGN,则调用进程不会产生僵尸进程:这种情况下,wait是等不到给子进程收尸的,所以wait阻 ...

- 003-jdk-数据结构-HashMap、HashTable、ConcurrentHashMap、TreeMap、LinkedHashMap、Set

一.Map概述 Map:“键值”对映射的抽象接口.该映射不包括重复的键,一个键对应一个值. 1.1.HashTable[不常用] 基于“拉链法”实现的散列表. 底层数组+链表实现,无论key还是val ...

- mac下不允许安装除了app store之外的软件设置:

1.dock栏的系统偏好设置. 2.找到安全性与隐私 3.点击面板中的通用,在点击左小角的锁按钮, 4.选择任何来源,确定就可以了.[如果只有两个选项,而没有任何来源的话,打开终端,执行:sudo s ...