python爬虫概述

爬虫的使用:爬虫用来对网络的数据信息进行爬取,通过URL的形式,将数据保存在数据库中并以文档形式或者报表形式进行展示。

爬虫可分为通用式爬虫或特定式爬虫,像我们经常用到的搜索引擎就属于通用式爬虫,如果针对某一特定主题或者新闻进行爬取,则属于特定式爬虫。

一般用到的第三方库有urllib、request、BeautifuiSoup。经常用到的框架为Scrapy和PySpider

爬虫的爬取步骤:

- 获取指定的url链接,获得链接网址上的所有代码信息。

- 通过python的正则表达式,将嵌套的HTML代码和数据进行分离。

- 获取数据后,保存在文档或者数据库中。方便后续的展示。

正常的网络传输大致分为Request(请求)和Response(响应)两类。

正常的HTTP请求一般分为get和post方法#

#使用urllib2编写最简单的爬虫代码

from urllib import request as urllib2

#在进行url请求时,应该添加User-Agent头进行识别

header = {"User-Agent" : "Mozilla/5.0 (compatible; MSIE 9.0; Window

s NT 6.1; Trident/5.0;"}

request = urllib2.Request("http://www.baidu.com",headers=header )

response = urllib2.urlopen(request)

html = response.read()

print (html)

我们爬取的数据可分为结构化和非结构化两种

- 结构化数据:XML\JSON格式文件

- 非结构化数据:文本、图片、HTML文件

lxml VS BeautifulSoup

lxml为局部遍历,效率较高。而BeautifulSoup为全局遍历,基于HTML DOM的,性能较差。

#使用requests编写爬虫代码

import requests

r = requests.get("http://www.baidu.com")

print(r.status_code) #输出状态码

print(r.text) #输出返回文本

print(r.json) #输出json格式文件

print(r.url) #输出访问的url地址

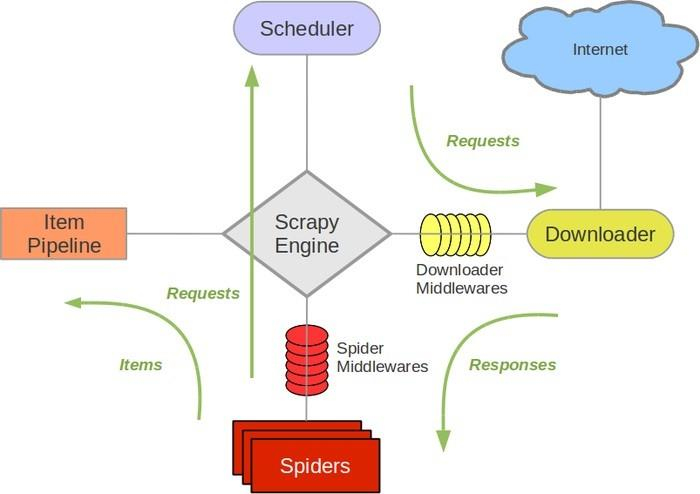

Scrapy架构图

Engine:负责其他组件的运转流程调度。

Scheduler:接收引擎发过来的request请求,并对其进行整理排列。当需要时返还。

Downloader:下载引擎所发送的Requests请求,并将获得的Response交给引擎,由Spider来处理。

Spider:负责从Response中提取Item中需要的数据,并将其他的URL提交给引擎,再转交给Scheduler。

Item PipeLine:负责处理Spider中的Item,并进行后期处理。

Downloader Middlewares:扩展下载功能组件

Spider Middlewares:扩展引擎和Spider通信的功能组件

Scrapy不支持分布式,Scrapy-redis提供了以redis为基础的组件

反爬虫策略:

- 动态设置User-Agent(浏览器识别)

- 禁用cookies

- 使用VPN和代理IP

反爬虫科普:https://segmentfault.com/a/1190000005840672

python爬虫概述的更多相关文章

- 【网络爬虫】【python】网络爬虫(一):python爬虫概述

python爬虫的实现方式: 1.简单点的urllib2 + regex,足够了,可以实现最基本的网页下载功能.实现思路就是前面java版爬虫差不多,把网页拉回来,再正则regex解析信息--总结起来 ...

- 芝麻软件: Python爬虫进阶之爬虫框架概述

综述 爬虫入门之后,我们有两条路可以走. 一个是继续深入学习,以及关于设计模式的一些知识,强化Python相关知识,自己动手造轮子,继续为自己的爬虫增加分布式,多线程等功能扩展.另一条路便是学习一些优 ...

- Python爬虫进阶一之爬虫框架概述

综述 爬虫入门之后,我们有两条路可以走. 一个是继续深入学习,以及关于设计模式的一些知识,强化Python相关知识,自己动手造轮子,继续为自己的爬虫增加分布式,多线程等功能扩展.另一条路便是学习一些优 ...

- Python爬虫之12306-分析请求总概述

python爬虫也学了一段时间了.也爬过不少网站,最后我想用12306抢票器这个项目做一个对之前的学习的效果成见也是一个目标(开始学爬虫的时候,看到说,会爬12306,就会爬80%的网站),本人纯自学 ...

- python爬虫Scrapy(一)-我爬了boss数据

一.概述 学习python有一段时间了,最近了解了下Python的入门爬虫框架Scrapy,参考了文章Python爬虫框架Scrapy入门.本篇文章属于初学经验记录,比较简单,适合刚学习爬虫的小伙伴. ...

- 一个简单的python爬虫程序

python|网络爬虫 概述 这是一个简单的python爬虫程序,仅用作技术学习与交流,主要是通过一个简单的实际案例来对网络爬虫有个基础的认识. 什么是网络爬虫 简单的讲,网络爬虫就是模拟人访问web ...

- 【Python】【爬虫】如何学习Python爬虫?

如何学习Python爬虫[入门篇]? 路人甲 1 年前 想写这么一篇文章,但是知乎社区爬虫大神很多,光是整理他们的答案就够我这篇文章的内容了.对于我个人来说我更喜欢那种非常实用的教程,这种教程对于想直 ...

- python爬虫的教程

来源:http://cuiqingcai.com/1052.html 大家好哈,我呢最近在学习Python爬虫,感觉非常有意思,真的让生活可以方便很多.学习过程中我把一些学习的笔记总结下来,还记录了一 ...

- Python爬虫系列 - 初探:爬取旅游评论

Python爬虫目前是基于requests包,下面是该包的文档,查一些资料还是比较方便. http://docs.python-requests.org/en/master/ POST发送内容格式 爬 ...

随机推荐

- javaScript--for循环的性能提升

//为什么性能提升? //第一种写法每次循环时都需要从内存中取出students.length并判断条件是否成立 //第二种写法只需要取一次students.length就可以 //第二种方式弊端:l ...

- HDU-3336-Count the string(扩展KMP)

链接: https://vjudge.net/problem/HDU-3336 题意: It is well known that AekdyCoin is good at string proble ...

- HTML的多媒体属性

㈠什么是多媒体? 多媒体来自多种不同的格式.它可以是听到或看到的任何内容,文字.图片.音乐.音效.录音.电影.动画等等. Web 上的多媒体指的是音效.音乐.视频和动画. 确定媒体类型的最常用的方法是 ...

- 2019牛客暑期多校训练营(第二场)D bitset

题意 给一个n个结点的带点权的图,找到第k小的团的权值 分析 用bitset表示团的状态,一个结点必须和团里的每个结点都连边才能加进去,所以可以直接用\(\&\)运算来判断一个结点是否能加进去 ...

- 排序学习(learning to rank)中的ranknet pytorch简单实现

一.理论部分 理论部分网上有许多,自己也简单的整理了一份,这几天会贴在这里,先把代码贴出,后续会优化一些写法,这里将训练数据写成dataset,dataloader样式. 排序学习所需的训练样本格式如 ...

- codeforces gym #101873B. Buildings(Polya定理)

参考博客: https://blog.csdn.net/liangzhaoyang1/article/details/72639208 题目链接: https://codeforces.com/gym ...

- JIRA备份,数据迁移以及小问题

Jira的备份(切记将许可证号备份) Jira默认会打开自动备份的功能,备份路径为/var/atlassian/application-data/jira/export 管理员账号登录Jira,点击右 ...

- BZOJ2208连通数

还是挺简单的tarjan. 判断时可能重复,直接bitset搞定. 首先tarjan缩点,每个scc的内部肯定能互相到达,更一下,而且一个scc里的各个点的贡献肯定是一样的,topsort,更新答案就 ...

- 【Amaple教程】3. 模板指令与状态数据(state)

一个模块的template模板.JavaScript和css之间的关系其实可以如下图表示: 如果你了解Angular.Vue动态模板,那你将会对Amaple的模板感到很熟悉,在Amaple中,temp ...

- 小程序支持npm包