NLP 基于kashgari和BERT实现中文命名实体识别(NER)

准备工作,先准备 python 环境,下载 BERT 语言模型

- Python 3.6 环境

需要安装kashgari

| Backend | pypi version desc |

|---|---|

| TensorFlow 2.x | pip install ‘kashgari>=2.0.0’ coming soon |

| TensorFlow 1.14+ | pip install ‘kashgari>=1.0.0,<2.0.0’ current version |

| Keras | pip install ‘kashgari<1.0.0’ legacy version |

- BERT, Chinese 中文模型

我选择的是工大的BERT-wwm-ext模型

在此感谢上述作者

数据集准备

from kashgari.corpus import ChineseDailyNerCorpus

train_x, train_y = ChineseDailyNerCorpus.load_data('train')

valid_x, valid_y = ChineseDailyNerCorpus.load_data('validate')

test_x, test_y = ChineseDailyNerCorpus.load_data('test')

print(f"train data count: {len(train_x)}")

print(f"validate data count: {len(valid_x)}")

print(f"test data count: {len(test_x)}")

train data count: 20864

validate data count: 2318

test data count: 4636

采用人民日报标注的数据集,格式为:

海 O

钓 O

比 O

赛 O

地 O

点 O

在 O

厦 B-LOC

门 I-LOC

与 O

金 B-LOC

门 I-LOC

之 O

间 O

的 O

海 O

域 O

。 O

创建 BERT embedding

import kashgari

from kashgari.embeddings import BERTEmbedding

bert_embed = BERTEmbedding('chinese_wwm_ext_L-12_H-768_A-12',

task=kashgari.LABELING,

sequence_length=100)

创建模型并训练

from kashgari.tasks.labeling import BiLSTM_CRF_Model

# 还可以选择 `CNN_LSTM_Model`, `BiLSTM_Model`, `BiGRU_Model` 或 `BiGRU_CRF_Model`

model = BiLSTM_CRF_Model(bert_embed)

model.fit(train_x,

train_y,

x_validate=valid_x,

y_validate=valid_y,

epochs=20,

batch_size=512)

model.save('ner.h5')

模型评估

model.evaluate(test_x, test_y)

BERT + B-LSTM-CRF 模型效果最好。详细得分如下:

| precision | recall | f1-score | support |

|---|---|---|---|

| LOC | 0.9208 | 0.9324 | 0.9266 |

| ORG | 0.8728 | 0.8882 | 0.8804 |

| PER | 0.9622 | 0.9633 | 0.9627 |

| avg / total | 0.9169 | 0.9271 | 0.9220 |

模型使用

# -*- coding: utf-8 -*-

import kashgari

import re

loaded_model = kashgari.utils.load_model('per_ner.h5')

def cut_text(text, lenth):

textArr = re.findall('.{' + str(lenth) + '}', text)

textArr.append(text[(len(textArr) * lenth):])

return textArr

def extract_labels(text, ners):

ner_reg_list = []

if ners:

new_ners = []

for ner in ners:

new_ners += ner;

for word, tag in zip([char for char in text], new_ners):

if tag != 'O':

ner_reg_list.append((word, tag))

# 输出模型的NER识别结果

labels = {}

if ner_reg_list:

for i, item in enumerate(ner_reg_list):

if item[1].startswith('B'):

label = ""

end = i + 1

while end <= len(ner_reg_list) - 1 and ner_reg_list[end][1].startswith('I'):

end += 1

ner_type = item[1].split('-')[1]

if ner_type not in labels.keys():

labels[ner_type] = []

label += ''.join([item[0] for item in ner_reg_list[i:end]])

labels[ner_type].append(label)

return labels

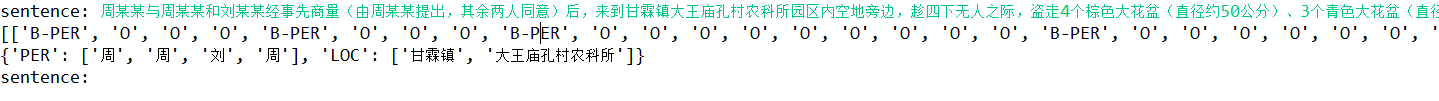

while True:

text_input = input('sentence: ')

texts = cut_text(text_input, 100)

ners = loaded_model.predict([[char for char in text] for text in texts])

print(ners)

labels = extract_labels(text_input, ners)

print(labels)

参考文献

Chinese-BERT-wwm:https://github.com/ymcui/Chinese-BERT-wwm

Kashgari:https://github.com/BrikerMan/Kashgari

NLP 基于kashgari和BERT实现中文命名实体识别(NER)的更多相关文章

- 基于 bi-LSTM和CRF的中文命名实体识别

follow: https://github.com/zjy-ucas/ChineseNER 这里边主要识别的实体如图所示,其实也就主要识别人名PER,机构ORG和地点LOC: B表示开始的字节,I ...

- 基于BERT预训练的中文命名实体识别TensorFlow实现

BERT-BiLSMT-CRF-NERTensorflow solution of NER task Using BiLSTM-CRF model with Google BERT Fine-tuni ...

- DL4NLP —— 序列标注:BiLSTM-CRF模型做基于字的中文命名实体识别

三个月之前 NLP 课程结课,我们做的是命名实体识别的实验.在MSRA的简体中文NER语料(我是从这里下载的,非官方出品,可能不是SIGHAN 2006 Bakeoff-3评测所使用的原版语料)上训练 ...

- NLP入门(八)使用CRF++实现命名实体识别(NER)

CRF与NER简介 CRF,英文全称为conditional random field, 中文名为条件随机场,是给定一组输入随机变量条件下另一组输出随机变量的条件概率分布模型,其特点是假设输出随机 ...

- 命名实体识别(NER)

一.任务 Named Entity Recognition,简称NER.主要用于提取时间.地点.人物.组织机构名. 二.应用 知识图谱.情感分析.机器翻译.对话问答系统都有应用.比如,需要利用命名实体 ...

- pytorch 文本情感分类和命名实体识别NER中LSTM输出的区别

文本情感分类: 文本情感分类采用LSTM的最后一层输出 比如双层的LSTM,使用正向的最后一层和反向的最后一层进行拼接 def forward(self,input): ''' :param inpu ...

- 使用Standford coreNLP进行中文命名实体识别

因为工作需要,调研了一下Stanford coreNLP的命名实体识别功能. Stanford CoreNLP是一个比较厉害的自然语言处理工具,很多模型都是基于深度学习方法训练得到的. 先附上其官网链 ...

- 『深度应用』NLP命名实体识别(NER)开源实战教程

近几年来,基于神经网络的深度学习方法在计算机视觉.语音识别等领域取得了巨大成功,另外在自然语言处理领域也取得了不少进展.在NLP的关键性基础任务—命名实体识别(Named Entity Recogni ...

- 零基础入门--中文命名实体识别(BiLSTM+CRF模型,含代码)

自己也是一个初学者,主要是总结一下最近的学习,大佬见笑. 中文分词说到命名实体抽取,先要了解一下基于字标注的中文分词.比如一句话 "我爱北京天安门”. 分词的结果可以是 “我/爱/北京/天安 ...

随机推荐

- [String.Format(转换时间格式)]

string.Format("{0:d}", System.DateTime.Now); // 2017/6/2; string.Format("{0:D}" ...

- leetcode124二叉树最大路径和

第一选择是将其转化成图用动态规划,但这样还是太麻烦 使用递归的思路,对于当前的节点root,分别求左右孩子到当前节点的单项路径权值最大的路径权值,然后记包含当前节点的路径权值为 path_price= ...

- Vue avoid mutating a prop directly since the value will be overwritten

<!DOCTYPE html> <html> <head> <meta charset="UTF-8"> <title> ...

- Android和jS互调技术Demo实现

package com.loaderman.webviewdemo; import android.os.Bundle; import android.support.v7.app.AppCompat ...

- JavaScript DOM 编程艺术(第二版) 有待解决的问题

原书 P181,var repeat = "moveElement('"+elementID+"', "+final_x+", "+fina ...

- VS2015服务器资源管理器连接Mysql数据库

下载安装文件mysql-for-visualstudio-1.2.3.msi 下载成功后执行安装,选择change-->选择Custom安装成功后,发现vs中没有效果. 注意这里再次执行安装文件 ...

- Core 3 WPF MVVM框架 Prism系列之数据绑定

一.安装Prism 1.使用程序包管理控制台# Install-Package Prism.Unity -Version 7.2.0.1367 也可以去掉‘-Version 7.2.0.1367’获取 ...

- 用fiddler来学http协议:为什么会有“response body is encoded click to decode”

使用fiddler查看服务器返回的响应包的时候,我们常常会看到“response body is encoded click to decode”这样一个提示,只有点击它才能让响应包的主体内容从乱码变 ...

- 【Linux开发】linux设备驱动归纳总结(四):3.抢占和上下文切换

linux设备驱动归纳总结(四):3.抢占和上下文切换 xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx ...

- PHP Excel导入

public function importFile() { $file = request()->file('file'); $params = $this->request->p ...