python urllib应用

urlopen 爬取网页

爬取网页

read() 读取内容

read() , readline() ,readlines() , fileno() , close() :这些方法的使用方式与文件对象完全一样

ret = request.urlopen("http://www.baidu.com")

print(ret.read()) #read() 读取网页

urlretrieve 写入文件

直接 将你要爬取得 网页 写到本地

import urllib.request

ret = urllib.request.urlretrieve("url地址","保存的路径地址")

urlcleanup 清除缓存

清除 request.urlretrieve 产生的缓存

print(request.urlcleanup())

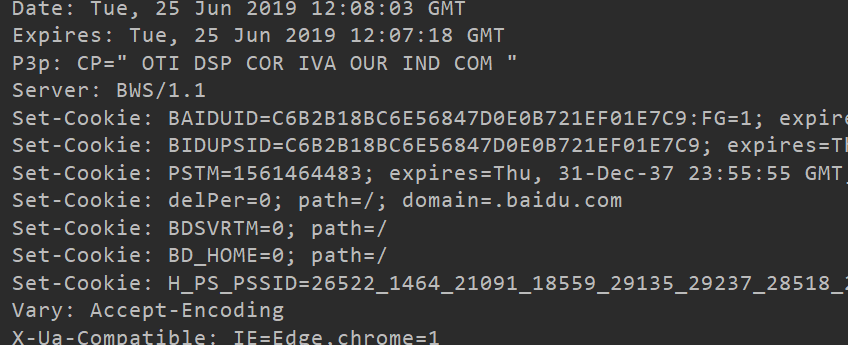

info 显示请求信息

info 返回一个httplib.HTTPMessage对象,表示远程服务器返回的头信息

ret = request.urlopen("http://www.baidu.com")

print(ret.info())

etcode 获取状态码

ret = request.urlopen("http://www.baidu.com")

print(ret.getcode()) # 返回200 就是 正常

geturl 获取当前正在爬取的网址

ret = request.urlopen("http://www.baidu.com")

print(ret.geturl)

超时设置

timeout 是以秒来计算的

ret = request.urlopen("http://www.baidu.com",timeout="设置你的超时时间")

print(ret.read())

模拟get 请求

from urllib import request

name = "python" # 你要搜索的 内容

url = "http://www.baidu.com/s?wd=%s"%name

ret_url = request.Request(url) # 发送请求

ret = request.urlopen(url)

print(ret.read().decode("utf-8"))

print(ret.geturl())

解决中文问题 request.quote

from urllib import request

name = "春生" # 你要搜索的 内容

url = "http://www.baidu.com/s?wd=%s"%name

ret_url = request.Request(url) # 发送请求

ret = request.urlopen(url)

print(ret.read().decode("utf-8"))

print(ret.geturl())

解决 request.quote

name = "春生" # 你要搜索的 内容

name = request.quote(name) # 解决中文问题

url = "http://www.baidu.com/s?wd=%s"%name

ret_url = request.Request(url) # 发送请求

ret = request.urlopen(url)

print(ret.read().decode("utf-8"))

模拟post 请求

from urllib import request, parse

url = "https://www.iqianyue.com/mypost"

mydata = parse.urlencode({

"name":"哈哈",

"pass":"123"

}).encode("utf-8")

ret_url = request.Request(url, mydata) # 发送请求

ret = request.urlopen(ret_url) # 爬取网页

print(ret.geturl()) # 打印当前爬取的url

print(ret.read().decode("utf-8"))

模拟浏览器 发送请求头

request.Request(url, headers=headers) 加上请求头 模拟浏览器

from urllib import request, parse

url = "http://www.xiaohuar.com/"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/75.0.3770.100 Safari/537.36"

}

ret_url = request.Request(url, headers=headers) # 发送请求

ret = request.urlopen(ret_url)

print(ret.geturl())

print(ret.read().decode("gbk"))

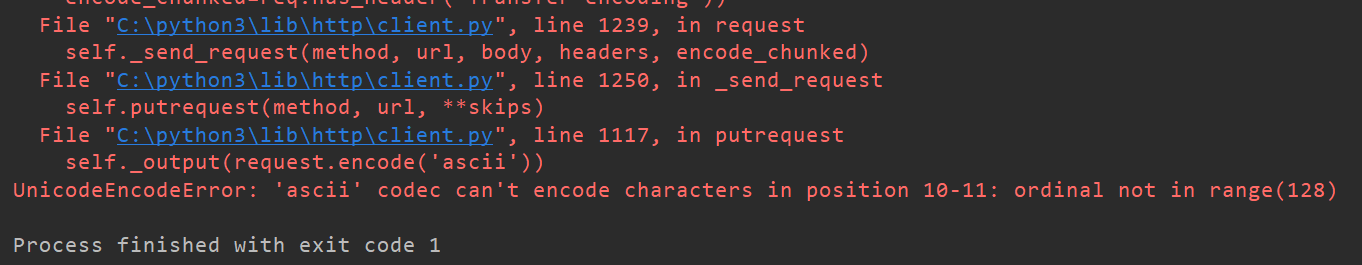

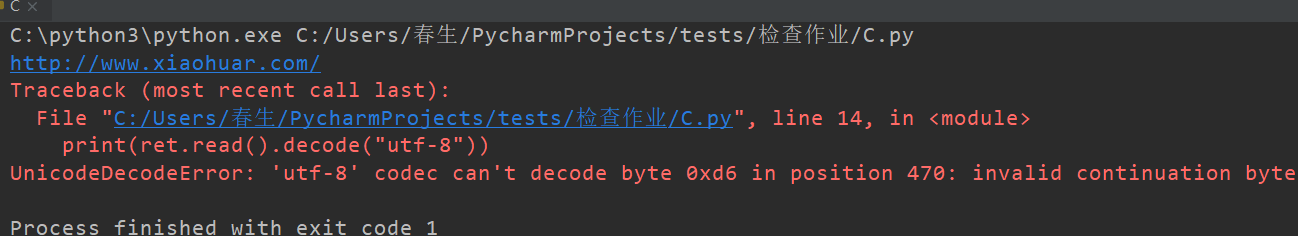

编码出现错误 报错 解决方式

出线的问题

from urllib import request, parse

url = "http://www.xiaohuar.com/"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/75.0.3770.100 Safari/537.36"

}

ret_url = request.Request(url, headers=headers) # 发送请求

ret = request.urlopen(ret_url)

print(ret.geturl())

print(ret.read().decode("utf-8"))

解决问题

decode("utf-8","ignore")

加上 "ignore" 就可以忽略掉

from urllib import request, parse

url = "http://www.xiaohuar.com/"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/75.0.3770.100 Safari/537.36"

}

ret_url = request.Request(url, headers=headers) # 发送请求

ret = request.urlopen(ret_url)

print(ret.geturl())

print(ret.read().decode("utf-8","ignore"))

python urllib应用的更多相关文章

- python urllib模块的urlopen()的使用方法及实例

Python urllib 库提供了一个从指定的 URL 地址获取网页数据,然后对其进行分析处理,获取想要的数据. 一.urllib模块urlopen()函数: urlopen(url, data=N ...

- Python:urllib和urllib2的区别(转)

原文链接:http://www.cnblogs.com/yuxc/ 作为一个Python菜鸟,之前一直懵懂于urllib和urllib2,以为2是1的升级版.今天看到老外写的一篇<Python: ...

- Python urllib和urllib2模块学习(一)

(参考资料:现代魔法学院 http://www.nowamagic.net/academy/detail/1302803) Python标准库中有许多实用的工具类,但是在具体使用时,标准库文档上对使用 ...

- python urllib和urllib2 区别

python有一个基础的库叫httplib.httplib实现了HTTP和HTTPS的客户端协议,一般不直接使用,在python更高层的封装模块中(urllib,urllib2)使用了它的http实现 ...

- Python urllib urlretrieve函数解析

Python urllib urlretrieve函数解析 利用urllib.request.urlretrieve函数下载文件 觉得有用的话,欢迎一起讨论相互学习~Follow Me 参考文献 Ur ...

- python+urllib+beautifulSoup实现一个简单的爬虫

urllib是python3.x中提供的一系列操作的URL的库,它可以轻松的模拟用户使用浏览器访问网页. Beautiful Soup 是一个可以从HTML或XML文件中提取数据的Python库.它能 ...

- HTTP Header Injection in Python urllib

catalogue . Overview . The urllib Bug . Attack Scenarios . 其他场景 . 防护/缓解手段 1. Overview Python's built ...

- python urllib urllib2

区别 1) urllib2可以接受一个Request类的实例来设置URL请求的headers,urllib仅可以接受URL.这意味着,用urllib时不可以伪装User Agent字符串等. 2) u ...

- python urllib基础学习

# -*- coding: utf-8 -*- # python:2.x __author__ = 'Administrator' #使用python创建一个简单的WEB客户端 import urll ...

- python urllib模块

1.urllib.urlopen(url[,data[,proxies]]) urllib.urlopen(url[, data[, proxies]]) :创建一个表示远程url的类文件对象,然后像 ...

随机推荐

- Flink MysqlSink 简单样例

在大数据领域中,有很多nosql 的数据库,典型的 hbase,可以实现大数据量下的快速查询,但是关系型数据的地位还是没办法替代.比如上个项目中,计算完的结果数据,还是会输出到关系型数据库当中.Fli ...

- 迅速生成项目-react-static

推荐指数:

- jquery 单击选中 再次选中取消选中

html: <div id="full" class='weui-popup__container' style="background: #fff"&g ...

- mac的公式编辑器: mathtype/latex

mathtype 收费版,且马上不能在mac系统上使用 latex 搜索一下: ➜ ~ brew search latex ==> Formulae gnome-latex latex2html ...

- 使用mysql连接django时,需要的步骤以及错误解决办法

django默认使用的sqlite3,更改为SQL时需要按照如下操作进行 1.在settings.py中的78行进行更改 DATABASES = { 'default': { 'ENGINE': 'd ...

- 微信开发核心AccessToken实现

Common <?php namespace Proxy\Action; use Think\Action; use Vendor\Func\Red; class CommonAction ex ...

- 014 Android 自定义组合控件

1.需求介绍 将已经编写好的布局文件,抽取到一个类中去做管理,下次还需要使用类似布局时,直接使用该组合控件的对象. 优点:可复用. 例如要重复利用以下布局: <RelativeLayout an ...

- 原生js 实现better-scroll效果,饿了么菜单内容联动,即粘即用

<!DOCTYPE html> <html> <head> <meta http-equiv="Content-Type" content ...

- (二)spring初次遇见shiro

文章目录 集成 Spring 集成中的坑 shiroFilter 的工作原理 权限配置细节 集成 Spring pom.xml 添加shiro相关的依赖 我使用的版本是 ${version.shiro ...

- Python22之lambda表达式

一.Lambda表达式的概念和意义 lambda表达式有称为隐函数,它的定义过程由形参和要返回的表达式组成,它相对于一般函数而言具有以下优势: 1.免去了函数定义的过程,代码变得更加精简 2.省却函数 ...