【Hadoop学习之十】MapReduce案例分析二-好友推荐

环境

虚拟机:VMware 10

Linux版本:CentOS-6.5-x86_64

客户端:Xshell4

FTP:Xftp4

jdk8

hadoop-3.1.1

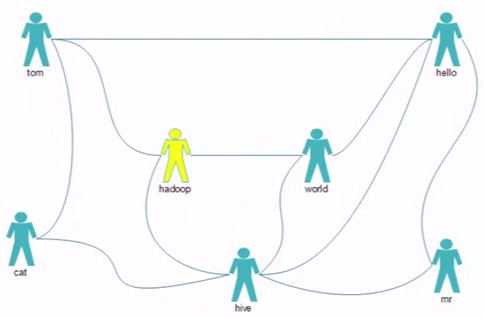

最应该推荐的好友TopN,如何排名?

tom hello hadoop cat

world hadoop hello hive

cat tom hive

mr hive hello

hive cat hadoop world hello mr

hadoop tom hive world

hello tom world hive mr

package test.mr.fof; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

import org.apache.hadoop.util.GenericOptionsParser; public class MyFOF { /**

* 最应该推荐的好友TopN,如何排名? * @param args

* @throws Exception

*/

public static void main(String[] args) throws Exception { Configuration conf = new Configuration(true);

String[] otherArgs = new GenericOptionsParser(conf, args).getRemainingArgs();

conf.set("sleep", otherArgs[2]); Job job = Job.getInstance(conf,"FOF");

job.setJarByClass(MyFOF.class); //Map

job.setMapperClass(FMapper.class);

job.setMapOutputKeyClass(Text.class);

job.setMapOutputValueClass(IntWritable.class); //Reduce

job.setReducerClass(FReducer.class); //HDFS 输入路径

Path input = new Path(otherArgs[0]);

FileInputFormat.addInputPath(job, input );

//HDFS 输出路径

Path output = new Path(otherArgs[1]);

if(output.getFileSystem(conf).exists(output)){

output.getFileSystem(conf).delete(output,true);

}

FileOutputFormat.setOutputPath(job, output ); System.exit(job.waitForCompletion(true) ? 0 :1);

}

// tom hello hadoop cat

// world hadoop hello hive

// cat tom hive

// mr hive hello

// hive cat hadoop world hello mr

// hadoop tom hive world

// hello tom world hive mr }

package test.mr.fof; import java.io.IOException; import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Mapper;

import org.apache.hadoop.util.StringUtils; public class FMapper extends Mapper<LongWritable, Text, Text, IntWritable>{ Text mkey= new Text();

IntWritable mval = new IntWritable(); @Override

protected void map(LongWritable key, Text value,Context context)

throws IOException, InterruptedException { //value: 0-直接关系 1-间接关系

//tom hello hadoop cat : hello:hello 1

//hello tom world hive mr hello:hello 0 String[] strs = StringUtils.split(value.toString(), ' '); String user=strs[0];

String user01=null;

for(int i=1;i<strs.length;i++){

//与好友清单中好友属于直接关系

mkey.set(fof(strs[0],strs[i]));

mval.set(0);

context.write(mkey, mval); for (int j = i+1; j < strs.length; j++) {

Thread.sleep(context.getConfiguration().getInt("sleep", 0));

//好友列表内 成员之间是间接关系

mkey.set(fof(strs[i],strs[j]));

mval.set(1);

context.write(mkey, mval);

}

}

} public static String fof(String str1 , String str2){ if(str1.compareTo(str2) > 0){

//hello,hadoop

return str2+":"+str1;

}

//hadoop,hello

return str1+":"+str2;

} }

package test.mr.fof; import java.io.IOException; import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Reducer; public class FReducer extends Reducer<Text, IntWritable, Text, Text> { Text rval = new Text();

@Override

protected void reduce(Text key, Iterable<IntWritable> vals, Context context)

throws IOException, InterruptedException

{

//是简单的好友列表的差集吗?

//最应该推荐的好友TopN,如何排名? //hadoop:hello 1

//hadoop:hello 0

//hadoop:hello 1

//hadoop:hello 1

int sum=0;

int flg=0;

for (IntWritable v : vals)

{

//0为直接关系

if(v.get()==0){

//hadoop:hello 0

flg=1;

}

sum += v.get();

} //只有间接关系才会被输出

if(flg==0){

rval.set(sum+"");

context.write(key, rval);

}

}

}

【Hadoop学习之十】MapReduce案例分析二-好友推荐的更多相关文章

- MapReduce深度分析(二)

MapReduce深度分析(二) 五.JobTracker分析 JobTracker是hadoop的重要的后台守护进程之一,主要的功能是管理任务调度.管理TaskTracker.监控作业执行.运行作业 ...

- Hadoop学习笔记—20.网站日志分析项目案例(二)数据清洗

网站日志分析项目案例(一)项目介绍:http://www.cnblogs.com/edisonchou/p/4449082.html 网站日志分析项目案例(二)数据清洗:当前页面 网站日志分析项目案例 ...

- 【Hadoop学习之十三】MapReduce案例分析五-ItemCF

环境 虚拟机:VMware 10 Linux版本:CentOS-6.5-x86_64 客户端:Xshell4 FTP:Xftp4 jdk8 hadoop-3.1.1 推荐系统——协同过滤(Collab ...

- Hadoop学习笔记—20.网站日志分析项目案例(一)项目介绍

网站日志分析项目案例(一)项目介绍:当前页面 网站日志分析项目案例(二)数据清洗:http://www.cnblogs.com/edisonchou/p/4458219.html 网站日志分析项目案例 ...

- Hadoop学习笔记—20.网站日志分析项目案例(三)统计分析

网站日志分析项目案例(一)项目介绍:http://www.cnblogs.com/edisonchou/p/4449082.html 网站日志分析项目案例(二)数据清洗:http://www.cnbl ...

- [b0012] Hadoop 版hello word mapreduce wordcount 运行(二)

目的: 学习Hadoop mapreduce 开发环境eclipse windows下的搭建 环境: Winows 7 64 eclipse 直接连接hadoop运行的环境已经搭建好,结果输出到ecl ...

- 【第二课】kaggle案例分析二

Evernote Export 推荐系统比赛(常见比赛) 推荐系统分类 最能变现的机器学习应用 基于应用领域分类:电子商务推荐,社交好友推荐,搜索引擎推荐,信息内容推荐等 **基于设计思想:**基于协 ...

- 【Hadoop学习之十二】MapReduce案例分析四-TF-IDF

环境 虚拟机:VMware 10 Linux版本:CentOS-6.5-x86_64 客户端:Xshell4 FTP:Xftp4 jdk8 hadoop-3.1.1 概念TF-IDF(term fre ...

- 【Hadoop学习之九】MapReduce案例分析一-天气

环境 虚拟机:VMware 10 Linux版本:CentOS-6.5-x86_64 客户端:Xshell4 FTP:Xftp4 jdk8 hadoop-3.1.1 找出每个月气温最高的2天 1949 ...

随机推荐

- 关于webpack,babel,以及es6和commonJS之间的联系(转)

add by zhj: babel是将es6转为es5,而webpack从名字也能看出来,是一个打包工具,根据文件之间的依赖关系,将文件进行打包 原文:https://blog.csdn.net/a2 ...

- ES6 --- JS异步编程的几种解决方法及其优缺点

导言: 我们都知道 JS 是单线程的,这也正是异步编程对于 JS 很重要的原因,因为它无法忍受耗时太长的操作.正因如此有一系列的实现异步的方法. 方法一 setTimeout 常用于:定时器,动画 ...

- 安装Vue Devtools

命令行进入vue-devtools\vue-devtools-master执行 cnpm install (貌似npm不太好使,也可能是我网络代理的原因) (淘宝镜像安装 npm install -- ...

- matlab中的常用函数

1.将变量a保存到a.txt,每个值中间用tab隔开 dlmwrite('a.txt',a,'\t'); 2.对比两个矩阵是否完全一样 isequal(a,b); %返回logic=1,则完全相同 3 ...

- RestFramework——API基本实现及dispatch基本源码剖析

基于Django实现 在使用RestFramework之前我们先用Django自己实现以下API. API完全可以有我们基于Django自己开发,原理是给出一个接口(URL),前端向URL发送请求以获 ...

- mysql在linux上的安装

前提: 环境:workstation 11 + CentOS 7 + mysql-5.6.40 安装前先查看服务器里是否有老版本的mysql已经被安装了 rpm -qa|grep mysql 如果有就 ...

- 安装与破解PyCharm专业版

安装与破解PyCharm专业版(有两种方法) 一.安装与破解PyCharm专业版 1.安装pycharm(建议安装python3) 这是网址:(https://www.jetbrains.com/py ...

- 类属性"get"必须声明主体,因为它未标记为 abstract 或 extern[解决方法]

当在页面cs文件中,写类属性时,运行会碰到以下问题:CS0501: “ASP.default_aspx.Person.Level.get”必须声明主体,因为它未标记为 abstract 或 exter ...

- 第一弹:超全Python学习资源整理(入门系列)

随着人工智能.大数据的时代到来,学习Python的必要性已经显得不言而喻.我经常逛youtube,发现不仅仅是以编程为职业的程序员,证券交易人员,生物老师,高级秘书......甚至许多自由撰稿人,设计 ...

- 使用MySQL的mysqldump命令备份数据库和把数据库备份文件恢复

1,备份数据库 mysql -uroot -p123456 db_name > /root/db_name.dump 2,数据库备份文件恢复 mysql -uroot -p123456 db_n ...