【Spark篇】---Spark初始

一、前述

Spark是基于内存的计算框架,性能要优于Mapreduce,可以实现hadoop生态圈中的多个组件,是一个非常优秀的大数据框架,是Apache的顶级项目。One stack rule them all 霸气。

但不同于MapReduce的是Job中间输出结果可以保存在内存中,从而不再需要读写HDFS,因此Spark能更好地适用于数据挖掘与机器学习等需要迭代的MapReduce的算法

二、具体细节

1、Spark与MapReduce的区别

都是分布式计算框架,Spark基于内存,MR基于HDFS。Spark处理数据的能力一般是MR的十倍以上,Spark中除了基于内存计算外,还有DAG有向无环图来切分任务的执行先后顺序。

2、Spark运行模式

- Local

多用于本地测试,如在eclipse,idea中写程序测试等。

- Standalone

Standalone是Spark自带的一个资源调度框架,它支持完全分布式。

- Yarn

Hadoop生态圈里面的一个资源调度框架,Spark也是可以基于Yarn来计算的。

- Mesos

资源调度框架。

注意:要基于Yarn来进行资源调度,必须实现AppalicationMaster接口,Spark实现了这个接口,所以可以基于Yarn。

3、SparkCore

概念

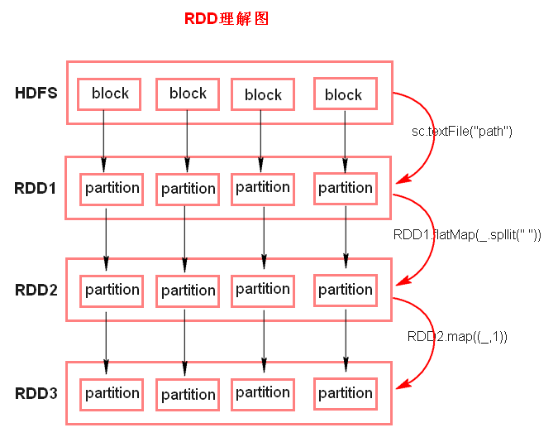

RDD(Resilient Distributed Dateset),弹性分布式数据集。

RDD的五大特性:(比较重要)

- RDD是由一系列的partition组成的。

- 函数是作用在每一个partition(split)上的。

- RDD之间有一系列的依赖关系。

- 分区器是作用在K,V格式的RDD上。

- RDD提供一系列最佳的计算位置。Partiotion对外提供数据处理的本地化,计算移动,数据不移动。

备注:

1、textFile方法底层封装的是读取MR读取文件的方式,读取文件之前先split,默认split大小是一个block大小。每个split对应一个partition。

2、RDD实际上不存储数据,存储的是计算逻辑,这里方便理解,暂时理解为存储数据。

3、什么是K,V格式的RDD?

- 如果RDD里面存储的数据都是二元组对象,那么这个RDD我们就叫做K,V格式的RDD。

4、 哪里体现RDD的弹性(容错)?

- partition数量,大小没有限制,体现了RDD的弹性。Partiotion个数可以控制。可以提高并行度。

- RDD之间依赖关系,可以基于上一个RDD重新计算出RDD。

5、哪里体现RDD的分布式?

- RDD是由Partition组成,partition是分布在不同节点上的。 RDD提供计算最佳位置,体现了数据本地化。体现了大数据中“计算移动数据不移动”的理念。

4、Spark任务执行原理

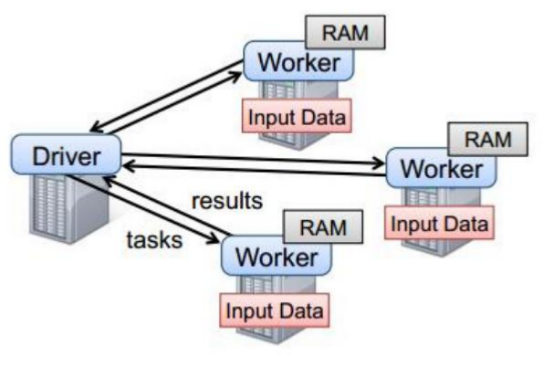

以上图中有四个机器节点,Driver和Worker是启动在节点上的进程,运行在JVM中的进程。

- Driver与集群节点之间有频繁的通信。

- Driver负责任务(tasks)的分发和结果的回收。任务的调度。如果task的计算结果非常大就不要回收了。会造成oom。

- Worker是Standalone资源调度框架里面资源管理的从节点。也是JVM进程。

- Master是Standalone资源调度框架里面资源管理的主节点。也是JVM进程。

5、Spark代码流程

1、创建SparkConf对象

SparkConf conf = new SparkConf().setMaster("local").setAppName("xxx")

- 1.设置运行模式

- 2.设置application name

- 3.设置spark运行参数

2、创建SparkContext对象

集群的唯一入口

3、基于Spark的上下文创建一个RDD,对RDD进行处理。

由SparkContext创建RDD

4、应用程序中要有Action类算子来触发Transformation类算子执行。

5、关闭Spark上下文对象SparkContext。

【Spark篇】---Spark初始的更多相关文章

- Spark中文指南(入门篇)-Spark编程模型(一)

前言 本章将对Spark做一个简单的介绍,更多教程请参考:Spark教程 本章知识点概括 Apache Spark简介 Spark的四种运行模式 Spark基于Standlone的运行流程 Spark ...

- Spark性能优化指南-高级篇(spark shuffle)

Spark性能优化指南-高级篇(spark shuffle) 非常好的讲解

- 【转帖】HBase读写的几种方式(二)spark篇

HBase读写的几种方式(二)spark篇 https://www.cnblogs.com/swordfall/p/10517177.html 分类: HBase undefined 1. HBase ...

- 转载:Spark中文指南(入门篇)-Spark编程模型(一)

原文:https://www.cnblogs.com/miqi1992/p/5621268.html 前言 本章将对Spark做一个简单的介绍,更多教程请参考:Spark教程 本章知识点概括 Apac ...

- Oozie分布式任务的工作流——Spark篇

Spark是现在应用最广泛的分布式计算框架,oozie支持在它的调度中执行spark.在我的日常工作中,一部分工作就是基于oozie维护好每天的spark离线任务,合理的设计工作流并分配适合的参数对于 ...

- 【Spark篇】---SparkSQL on Hive的配置和使用

一.前述 Spark on Hive: Hive只作为储存角色,Spark负责sql解析优化,执行. 二.具体配置 1.在Spark客户端配置Hive On Spark 在Spark客户端安装包下sp ...

- 基于Hive进行数仓建设的资源元数据信息统计:Spark篇

在数据仓库建设中,元数据管理是非常重要的环节之一.根据Kimball的数据仓库理论,可以将元数据分为这三类: 技术元数据,如表的存储结构结构.文件的路径 业务元数据,如血缘关系.业务的归属 过程元数据 ...

- 【转】科普Spark,Spark是什么,如何使用Spark

本博文是转自如下链接,为了方便自己查阅学习和他人交流.感谢原博主的提供! http://www.aboutyun.com/thread-6849-1-1.html http://www.aboutyu ...

- 大数据技术之_19_Spark学习_01_Spark 基础解析 + Spark 概述 + Spark 集群安装 + 执行 Spark 程序

第1章 Spark 概述1.1 什么是 Spark1.2 Spark 特点1.3 Spark 的用户和用途第2章 Spark 集群安装2.1 集群角色2.2 机器准备2.3 下载 Spark 安装包2 ...

- Spark记录-spark编程介绍

Spark核心编程 Spark 核心是整个项目的基础.它提供了分布式任务调度,调度和基本的 I/O 功能.Spark 使用一种称为RDD(弹性分布式数据集)一个专门的基础数据结构,是整个机器分区数据的 ...

随机推荐

- .net core 2.x - 发布到IIS

没啥写的,随便记录下 说明 与ASP.NET时代不同,ASP.NET Core不再是由IIS工作进程(w3wp.exe)托管,而是使用自托管Web服务器(Kestrel)运行,IIS则是作为反向代理的 ...

- 项目管理目标:添加人员并向其分配任务 - Project

已剪辑自: https://support.office.com/zh-cn/article/%E9%A1%B9%E7%9B%AE%E7%AE%A1%E7%90%86%E7%9B%AE%E6%A0%8 ...

- Java中超大文件读写

如果文件过大不能一次加载,就可以利用缓冲区: File file = new File(filepath); BufferedInputStream fis = new BufferedInputSt ...

- 谷歌浏览器F12基本用法

第一步:打开你想进行调试的页面,并按F12进入到调试模式 此处以百度页面为例进行功能展示 这是关于最右侧“元素选择器”的功能展示 关于第二个功能的使用,这个功能是将页面适应成手机屏幕大小, eleme ...

- python no module named _socket 原因

python no module named _socket 原因 Lib/site-packages 不在 sys.path 中

- linux文件夹打包命令

.tar 解包:tar xvf FileName.tar 打包:tar cvf FileName.tar DirName (注:tar是打包,不是压缩!) ---------------------- ...

- linux 存在多个版本的情况下,切换python版本

linux 存在多个版本的情况下 python 命令默认寻找 /usr/bin下的命令 所以先find / -name python* 找一下所有的Python版本 然后 sudo ln /usr/b ...

- go web开发(gin&gorm) 之DB配置及DAO的基本使用

转载请注明出处: https://www.cnblogs.com/funnyzpc/p/9501376.html ``` 我先闲扯下,前天(也就是2018年11月16号)的某个时候,忽然有人在QQ ...

- Android滑动列表(拖拽,左滑删除,右滑完成)功能实现(2)

ItemTouchHelper类 之前我们实现了滑动列表的一些基本功能,为了实现更多的效果,我们来仔细看一下ItemTouchHelper中的类: ItemTouchHelper.SimpleCall ...

- C++第四课:类的使用(二)[个人见解]

前面说到C++类的名字自定义要有含义,成员函数名也同样如此. 一个好的程序员除了让自己能看懂代码外,那是能力,也能让别人看懂,那是本事. 我们来看第一个特性:继承! 什么是继承? 小编不说概念性的定义 ...