django-celery配置

1、项目启动顺序:

启动项目:

python manage.py runserver

启动celery beat

python manage.py celery beat

启动celery worker

python manage celeryd -l info

启动celery flower监控任务运行情况

celery flower --broker=redis://auth:root@localhost:6379

2、Django 结合 celery动态配置任务

1、项目使用的版本 Django==1.11.7 celery==3.1.18 django-celery==3.2.2

安装django-celery 安装celery

pip install celery==3.1.18

pip install django-celrey==3.2.2

2、Django结合celery

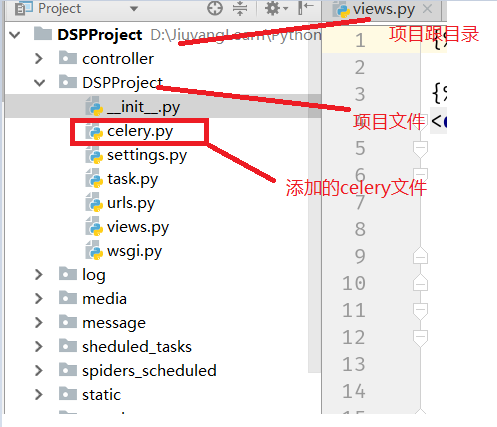

(1)、在项目的初始文件夹下添加celery.py 文件

celery.py

from __future__ import absolute_import, unicode_literals

import os

from celery import Celery from django.conf import settings # noqa # set the default Django settings module for the 'celery' program.

os.environ.setdefault('DJANGO_SETTINGS_MODULE', 'DSPProject.settings') app = Celery('DSPProject') # Using a string here means the worker doesn't have to serialize

# the configuration object to child processes.

# - namespace='CELERY' means all celery-related configuration keys

# should have a `CELERY_` prefix.

app.config_from_object('django.conf:settings') # Load task modules from all registered Django app configs.

app.autodiscover_tasks(lambda: settings.INSTALLED_APPS) @app.task(bind=True)

def debug_task(self):

print('Request: {0!r}'.format(self.request))

(2) 添加 celery配置到项目的settings.py 文件中

settings.py

import djcelery

djcelery.setup_loader() BROKER_URL = 'redis://auth:root@localhost:6379'

CELERYBEAT_SCHEDULER = 'djcelery.schedulers.DatabaseScheduler' # 定时任务

CELERY_RESULT_BACKEND = 'djcelery.backends.database:DatabaseBackend'

# CELERY_RESULT_BACKEND = 'redis://localhost:6379'

CELERY_ACCEPT_CONTENT = ['application/json']

CELERY_TASK_SERIALIZER = 'json'

CELERY_RESULT_SERIALIZER = 'json'

CELERY_TIMEZONE = 'Asia/Shanghai'

CELERY_ENABLE_UTC = False

CELERYD_CONCURRENCY = 10

CELERYD_MAX_TASKS_PER_CHILD = 1 # 每个worker最多执行1个任务就会被销毁,可防止内存泄露 LOGIN_REDIRECT_URL = '/index/'

UPLOAD_FILE_DIR = os.path.join(BASE_DIR, "people/upload/")

CHANGE_UPLOAD_DIR = os.path.join(BASE_DIR, "change/upload/")

LOG_FILE_DIR = os.path.join(BASE_DIR, "log/")

BACKUP_USER_INFO_DIR = '/home/jiuyang/django/backup/user_info/' LOGGING = {

'version': 1,

'disable_existing_loggers': True,

'formatters': {

'standard': {

'format': '%(levelname)s %(asctime)s %(message)s'

},

},

'filters': {

},

'handlers': {

'mail_admins': {

'level': 'ERROR',

'class': 'django.utils.log.AdminEmailHandler',

'formatter':'standard',

},

'people_handler': {

'level':'DEBUG',

'class':'logging.handlers.RotatingFileHandler',

'filename':'%s%s' % (LOG_FILE_DIR, 'people.log'),

'formatter':'standard',

},

'report_handler': {

'level':'DEBUG',

'class':'logging.handlers.RotatingFileHandler',

'filename':'%s%s' % (LOG_FILE_DIR, 'report.log'),

'formatter':'standard',

},

'change_handler': {

'level':'DEBUG',

'class':'logging.handlers.RotatingFileHandler',

'filename':'%s%s' % (LOG_FILE_DIR, 'change.log'),

'formatter':'standard',

},

'dtmt_handler': {

'level':'DEBUG',

'class':'logging.handlers.RotatingFileHandler',

'filename':'%s%s' % (LOG_FILE_DIR, 'dtmt.log'),

'formatter':'standard',

},

'scheduled_tasks_handler': {

'level':'DEBUG',

'class':'logging.handlers.RotatingFileHandler',

'filename':'%s%s' % (LOG_FILE_DIR, 'scheduled_tasks.log'),

'formatter':'standard',

},

'business_query_handler': {

'level':'DEBUG',

'class':'logging.handlers.RotatingFileHandler',

'filename':'%s%s' % (LOG_FILE_DIR, 'business_query.log'),

'formatter':'standard',

},

},

'loggers': {

'django.request': {

'handlers': ['mail_admins'],

'level': 'ERROR',

'propagate': True,

},

'people_log':{

'handlers': ['people_handler'],

'level': 'INFO',

'propagate': False

},

'report':{

'handlers': ['report_handler'],

'level': 'INFO',

'propagate': False

},

'change':{

'handlers': ['change_handler'],

'level': 'INFO',

'propagate': False

},

'dtmt':{

'handlers': ['change_handler'],

'level': 'INFO',

'propagate': False

},

'scheduled_tasks':{

'handlers': ['scheduled_tasks_handler'],

'level': 'INFO',

'propagate': False

},

'business_query':{

'handlers': ['business_query_handler'],

'level': 'INFO',

'propagate': False

},

}

}

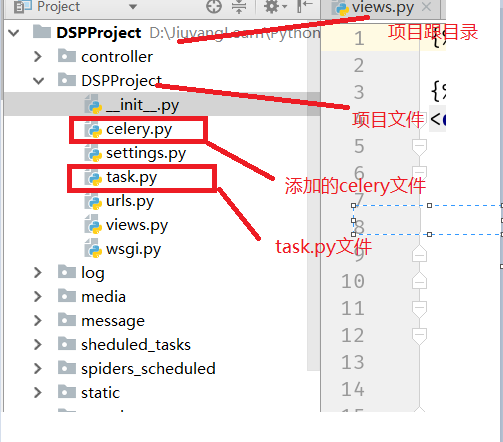

(3)、写celery task实现具体的任务模板

task.py

from celery import shared_task @shared_task(name='run_py')

def run_worke(*args):

# import

for line in args:

print('run,runrurnrurnhr',line)

return 'run python file ok' @shared_task(name='run_add')

def add():

x= 1

y =3

print(x+y,'ppppppppppppppppppppppppppppppppppppppppppppppppppppppppp')

return x + y

(4)实现定时任务添加配置

#主要代码 def add_periodic_task_spiders(request):

# 提交新增周期任务数据

response = HttpResponse()

cur = Currency(request)

rq_post = getattr(cur, 'rq_post')

jdata = rq_post('data')

data = json.loads(jdata)

task_spiders = data['task_spiders']

crontab = data['crontab']

is_enable = data['is_enable']

is_encrypt = data['is_encrypt']

# is_sensitive = data['is_sensitive']

task_name = data['task_name']

task_template = data['task_template'] #将数据信息导入到celery的执行对列中

schedule = CrontabSchedule.objects.get(pk=crontab).schedule

create_or_update_task = DatabaseScheduler.create_or_update_task

schedule_dict = {

'schedule': schedule,

'task': task_template,

'args': [task_spiders],

'enabled': is_enable

}

create_or_update_task(task_name, **schedule_dict)

# mail_excel(mail_header, task_name, sql_list, **mailpara)

response.write(json.dumps({'status': 0, 'msg': ['操作成功']}))

return response

3、celery 实现分布式配置

在成功运行Django-celery之后,copy celery task源码到需要分布式的机器,完成任务配置

django-celery配置的更多相关文章

- 独立两套DJANGO+CELERY配置(生产+测试)时要注意的一些细节

1,生产的NGINX环境,要指定自己的目录,而不是PROJ默认的. upstream ism_host { server ; } server { listen ; server_name local ...

- 基于Django+celery二次开发动态配置定时任务 ( 一 )

需求: 前端时间由于开发新上线一大批系统,上完之后没有配套的报表系统.监控,于是乎开发.测试.产品.运营.业务部.财务等等各个部门就跟那饥渴的饿狼一样需要 各种各样的系统数据满足他们.刚开始一天一个还 ...

- 基于Django+celery二次开发动态配置定时任务 ( 二)

一.需求 结合上一篇,使用djcelery模块开发定时任务时,定时任务的参数都保存在djcelery_periodictask表的args.kwargs字段里,并且是json格式.那么,当定时任务多了 ...

- Django + Celery 实现动态配置定时任务

哈喽,今天给大家分享一篇Django+Celery实现动态配置定时任务,因为最近也是无意间看到一位大佬关于这块的文章,然后自己觉得不错,也想学习写一下,然后最终实现功能是在前端页面统一管理计划任务,大 ...

- django+celery+redis环境搭建

初次尝试搭建django+celery+redis环境,记录下来,慢慢学习~ 1.安装apache 下载httpd-2.0.63.tar.gz,解压tar zxvf httpd-2.0.63.tar. ...

- django+celery +rabbitmq

celery是一个python的分布式任务队列框架,支持 分布的 机器/进程/线程的任务调度.采用典型的生产者-消费者模型 包含三部分:1. 队列 broker :可使用redis ,rabbitmq ...

- 使用django + celery + redis 异步发送邮件

参考:http://blog.csdn.net/Ricky110/article/details/77205291 环境: centos7 + python3.6.1 + django2.0.1 ...

- django+celery 实现定时任务

利用 celery 实现定时任务 celery支持定时任务,设定好任务的执行时间,celery就会定时自动帮你执行, 这个定时任务模块叫celery beat Celery安装 由于celery 4. ...

- django celery异步框架

描述:实现运维平台的异步执行与定时任务,以下简单描述了安装过程及使用. 安装django和celery pip install django pip install celery pip inst ...

- 结合Django+celery二次开发定时周期任务

需求: 前端时间由于开发新上线一大批系统,上完之后没有配套的报表系统.监控,于是乎开发.测试.产品.运营.业务部.财务等等各个部门就跟那饥渴的饿狼一样需要 各种各样的系统数据满足他们.刚开始一天一个还 ...

随机推荐

- Activity之间的跳转和数据传输

1.显式跳转 protected void onCreate(@Nullable Bundle savedInstanceState) { super.onCreate(savedInstanceSt ...

- P4177 [CEOI2008]order 网络流,最小割,最大权闭合子图

题目链接 \(Click\) \(Here\) 如果没有租用机器就是一个裸的最大权闭合子图.现在有了租用机器应该怎么办呢? 单独拆点是不行的,因为会和直接买下的情况脱离关系,租借是和连边直接相关的,那 ...

- python __call__或者说func()()的理解

__call__ 对象后面加括号,触发执行. 注:构造方法的执行是由创建对象触发的,即:对象 = 类名() :而对于 __call__ 方法的执行是由对象后加括号触发的,即:对象() 或者 类()() ...

- Kettle中并行执行测试

整个作业截图: 设置并行方法:右键 START 组件,勾选最后一个选项: Run Next Entries In Parallel 设置aa, bb, cc, dd, ee 都是shell脚本,内容都 ...

- Python 中使用 matplotlib 绘图中文字符显示异常的问题

最近在使用 Python matplotlib 绘制图表时发现中文字符不能正确显示:比如在绘制折线图时,中文全部显示成▢▢▢的格式,虽然将数据改成英文就没什么问题,但是所有数据都这么做时不可行的,于是 ...

- 部署kubernetes-dashboard

1.生成访问证书 | awk '{print $2}' | base64 -d >> kubecfg.crt | awk '{print $2}' | base64 -d >> ...

- 1. Nagios和 NagiosQL安装及配置

目录 1. Nagios 和 NagiosQL简介 2. Nagios+NagiosQL搭建环境说明 3. Nagios.Nagios-plugins和NagiosQL的安装 4. 配置NagiosQ ...

- Java(13) 抽象和封装

一.简述从现实世界中抽象出类的步骤 第一:找出分类(分析出类) 第二:找出类的特征(分析类的相关属性) 第三:找出类的行为(分析类的方法) 二.常量(经常出现的变量值) 2.1 语法: public ...

- vagrant极简教程:快速搭建centos7

作为开发人员,只要你的应用最终是放在linux环境执行,那么最好就是将本地开发环境也线上一致.不管是用windows系统,还是mac系统,即使你本地程序跑得好好的,也经常会出现一上线就各种bug的现象 ...

- selenium定位方式-获取标签元素:find_element_by_xxx

定位方式取舍# 唯一定位方式.多属性定位.层级+角标定位(离目标元素越近,相对定位越好) # 推荐用css selector(很少用递进层次的定位)# 什么时候用xpath呢? 当你定位元素时,必须要 ...