如何让excel文件读取变得更简单

今天给大家安利一款excel文件导入神器,easyexcel,官方地址:(https://github.com/alibaba/easyexcel)。

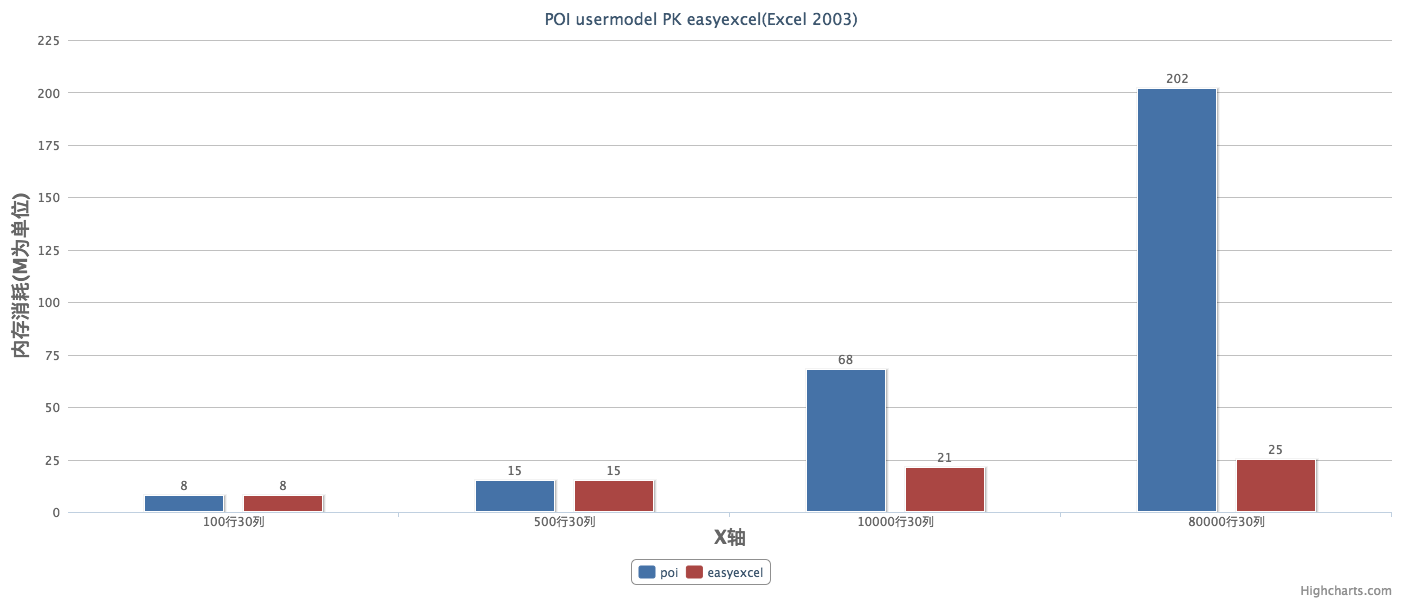

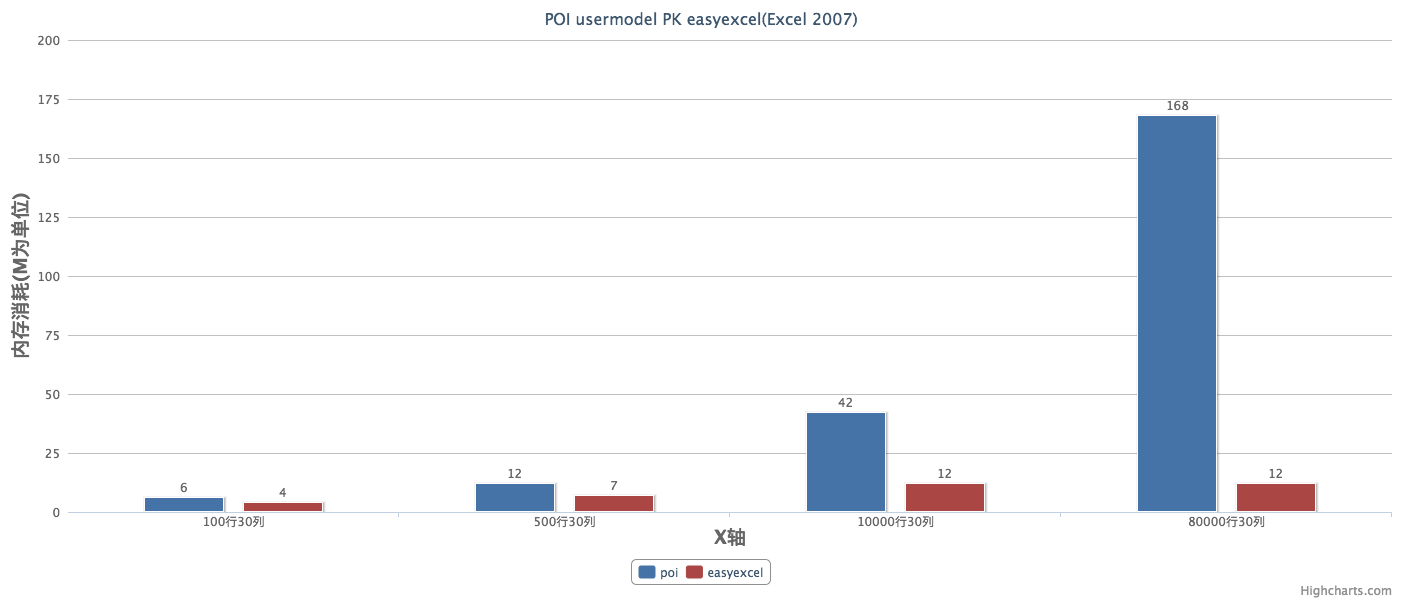

在官网文档中有介绍了其性能。

从上面的性能测试可以看出easyexcel在解析耗时上比poiuserModel模式弱了一些。主要原因是我内部采用了反射做模型字段映射,中间我也加了cache,但感觉这点差距可以接受的。但在内存消耗上差别就比较明显了,easyexcel在后面文件再增大,内存消耗几乎不会增加了。但poi userModel就不一样了,简直就要爆掉了。想想一个excel解析200M,同时有20个人再用估计一台机器就挂了。

如何使用呢

1、引入maven依赖

<dependency>

<groupId>com.alibaba</groupId>

<artifactId>easyexcel</artifactId>

<version>2.0.5</version>

</dependency>

由于改jar包对poi进行了一些封装,因此需要注释掉项目引用的poi依赖,不然会有版本冲突。

2、创建接收excel数据的实体

@Data

public class Person {

@ExcelProperty(value = "姓名",index = 1)

private String name;

@ExcelProperty("性别")

private String sex;

@ExcelProperty("年龄")

private int age;

}

@ExcelProperty 这个注解用于指定该属性对应excel文件中的哪一列数据。里面有两个属性,一个是value,另一个是index(从0开始),这里不建议 index 和 name 同时用,要么一个对象只用index,要么一个对象只用name去匹配。

3、增加person监听器

@Slf4j

public class PersonListener extends AnalysisEventListener<Person> {

/**

* 每隔5条存储数据库,实际使用中可以3000条,然后清理list ,方便内存回收

*/

private static final int BATCH_COUNT = 5;

List<Person> list = new ArrayList();

@Override

public void invoke(Person person, AnalysisContext analysisContext) {

log.info("解析到一条数据:{}",person);

if (list.size() >= BATCH_COUNT) {

saveData();

list.clear();

}

}

@Override

public void doAfterAllAnalysed(AnalysisContext analysisContext) {

saveData();

log.info("所有数据解析完成!");

}

@Override

public void onException(Exception exception, AnalysisContext context) {

log.error("解析失败,但是继续解析下一行", exception);

}

/**

* 加上存储数据库

*/

private void saveData(){

log.info("{}条数据,开始存储数据库!", list.size());

log.info("存储数据库成功!");

}

}

4、文件上传方法

@RestController

@Slf4j

public class PersonController {

@PostMapping("importFile")

public String readPerson(MultipartFile file){

PersonListener personListener = new PersonListener();

try {

// headRowNumber(2) 这里可以设置1,因为头就是一行。如果多行头,可以设置其他值。不传入也可以,他没有指定头,也就是默认1行

EasyExcel.read(file.getInputStream(), Person.class,personListener).sheet().headRowNumber(1).doRead();

}catch (IOException ioe){

log.info("读取excel异常={}",ioe);

}

return "";

}

}

这样代码基本就算完成了。接下来我们看看如何在

spring框架中使用

我们知道,在spring中文件入库的时候可能需要调用service,service调用dao入库。那我们如何在这个PersonListener中调用service呢。

首先,在PersonController中注入service.

@Autowired

private PersonService personService;

然后,在PersonListener中增加一个有参构造器。

private PersonService personService;

public PersonListener(PersonService personService){

this.personService = personService;

}

最后在PersonController中new PersonListener的时候将service传进来即可。

@Autowired

private PersonService personService;

@PostMapping("importFile")

public String readPerson(MultipartFile file){

PersonListener personListener = new PersonListener(personService);

try {

// headRowNumber(2) 这里可以设置1,因为头就是一行。如果多行头,可以设置其他值。不传入也可以,他没有指定头,也就是默认1行

EasyExcel.read(file.getInputStream(), Person.class,personListener).sheet().headRowNumber(2).doRead();

}catch (IOException ioe){

log.info("读取excel异常={}",ioe);

}

return "";

}

接下来我们在看一下,有一个需求是这样的,我们需要统计一下导入成功数和失败数并且要不失败数写入到一个excel中返回给页面,如何实现?

我们调整一下PersonListener

@Slf4j

public class PersonListener extends AnalysisEventListener<Person> {

private int successCount = 0; // 成功量

private int exceptionCount = 0; // 异常量

private List<Person> exceptionList = new ArrayList<>(); // 异常数据

/**

* 每隔5条存储数据库,实际使用中可以3000条,然后清理list ,方便内存回收

*/

private static final int BATCH_COUNT = 5;

List<Person> list = new ArrayList();

private PersonService personService;

public PersonListener(PersonService personService){

this.personService = personService;

}

@Override

public void invoke(Person person, AnalysisContext analysisContext) {

log.info("解析到一条数据:{}",person);

successCount++;

list.add(person);

if (list.size() >= BATCH_COUNT) {

saveData();

list.clear();

}

}

@Override

public void doAfterAllAnalysed(AnalysisContext analysisContext) {

saveData();

log.info("所有数据解析完成!");

}

@Override

public void onException(Exception exception, AnalysisContext context) {

log.error("解析失败,但是继续解析下一行", exception);

Person person = (Person)context.readRowHolder().getCurrentRowAnalysisResult();

exceptionList.add(person);

exceptionCount++;

}

/**

* 加上存储数据库

*/

private void saveData(){

log.info("{}条数据,开始存储数据库!", list.size());

log.info("存储数据库成功!");

}

/**

* 插入结果返回

* @return

*/

public Map<String,Object> getData(){

Map<String,Object> map = new HashMap<>();

map.put("success",successCount);

map.put("exception",exceptionCount);

return map;

}

/**

* 失败数据返回

* @return

*/

public List<Person> getExceptionList(){

return exceptionList;

}

}

在PersonController中将异常数据写入文件。

@RestController

@Slf4j

public class PersonController {

@Autowired

private PersonService personService;

@PostMapping("importFile")

public String readPerson(MultipartFile file){

PersonListener personListener = new PersonListener(personService);

try {

// headRowNumber(1) 这里可以设置1,因为头就是一行。如果多行头,可以设置其他值。不传入也可以,他没有指定头,也就是默认1行

EasyExcel.read(file.getInputStream(), Person.class,personListener).sheet().headRowNumber(1).doRead();

}catch (IOException ioe){

log.info("读取excel异常={}",ioe);

}

Map<String, Object> data = personListener.getData();

String exception = data.get("exception") + "";

int exceptionCount = Integer.parseInt(exception);

if(exceptionCount>0){

String fileName = System.currentTimeMillis() + ".xlsx";

// 这里 需要指定写用哪个class去读,然后写到第一个sheet,名字为模板 然后文件流会自动关闭

EasyExcel.write("E://upload/file/"+fileName, Person.class).sheet("模板").doWrite(personListener.getExceptionList());

data.put("fileName",fileName);

}

return data.toString();

}

}

我们写个页面测试一下

<!DOCTYPE html>

<html lang="en">

<head>

<meta charset="UTF-8">

<title>文件上传</title>

</head>

<body>

<form action="/importFile" method="post" enctype="multipart/form-data">

<input type="file" name="file"/>

<button type="submit">提交</button>

</form>

</body>

</html>

下面是测试的日志文件

2019-10-20 11:21:59.809 INFO 17748 --- [nio-8080-exec-1] c.zhixie.easyexcel.demo.PersonListener : 解析到一条数据:Person(name=执偕, sex=男, age=18)

2019-10-20 11:21:59.811 INFO 17748 --- [nio-8080-exec-1] c.zhixie.easyexcel.demo.PersonListener : 解析到一条数据:Person(name=执偕2, sex=男, age=19)

2019-10-20 11:21:59.811 INFO 17748 --- [nio-8080-exec-1] c.zhixie.easyexcel.demo.PersonListener : 解析到一条数据:Person(name=执偕3, sex=男, age=20)

2019-10-20 11:21:59.811 INFO 17748 --- [nio-8080-exec-1] c.zhixie.easyexcel.demo.PersonListener : 解析到一条数据:Person(name=执偕4, sex=男, age=21)

2019-10-20 11:21:59.812 INFO 17748 --- [nio-8080-exec-1] c.zhixie.easyexcel.demo.PersonListener : 解析到一条数据:Person(name=执偕5, sex=男, age=22)

2019-10-20 11:21:59.812 INFO 17748 --- [nio-8080-exec-1] c.zhixie.easyexcel.demo.PersonListener : 5条数据,开始存储数据库!

2019-10-20 11:21:59.812 INFO 17748 --- [nio-8080-exec-1] c.zhixie.easyexcel.demo.PersonListener : 存储数据库成功!

2019-10-20 11:21:59.812 INFO 17748 --- [nio-8080-exec-1] c.zhixie.easyexcel.demo.PersonListener : 解析到一条数据:Person(name=执偕6, sex=男, age=23)

2019-10-20 11:21:59.812 INFO 17748 --- [nio-8080-exec-1] c.zhixie.easyexcel.demo.PersonListener : 解析到一条数据:Person(name=执偕7, sex=男, age=24)

2019-10-20 11:21:59.813 INFO 17748 --- [nio-8080-exec-1] c.zhixie.easyexcel.demo.PersonListener : 解析到一条数据:Person(name=执偕8, sex=男, age=25)

2019-10-20 11:21:59.813 INFO 17748 --- [nio-8080-exec-1] c.zhixie.easyexcel.demo.PersonListener : 解析到一条数据:Person(name=执偕9, sex=男, age=26)

2019-10-20 11:21:59.813 INFO 17748 --- [nio-8080-exec-1] c.zhixie.easyexcel.demo.PersonListener : 4条数据,开始存储数据库!

2019-10-20 11:21:59.813 INFO 17748 --- [nio-8080-exec-1] c.zhixie.easyexcel.demo.PersonListener : 存储数据库成功!

2019-10-20 11:21:59.813 INFO 17748 --- [nio-8080-exec-1] c.zhixie.easyexcel.demo.PersonListener : 所有数据解析完成!

今天就介绍到这了,文中的代码我已上传到码云上,

地址:https://gitee.com/javaXiaoCaiJi/zhixie-code-example/tree/master/easyexcel

如果文章对您有帮助,请记得点赞关注哟~

欢迎大家关注我的公众号<情系IT>,每日技术推送文章供大家学习参考。

如何让excel文件读取变得更简单的更多相关文章

- 深入解析 Kubebuilder:让编写 CRD 变得更简单

作者 | 刘洋(炎寻) 阿里云高级开发工程师 导读:自定义资源 CRD(Custom Resource Definition)可以扩展 Kubernetes API,掌握 CRD 是成为 Kubern ...

- spring 第一篇(1-1):让java开发变得更简单(下)

切面(aspects)应用 DI能够让你的软件组件间保持松耦合,而面向切面编程(AOP)能够让你捕获到在整个应用中可重用的组件功能.在软件系统中,AOP通常被定义为提升关注点分离的一个技术.系统由很多 ...

- [翻译]Kafka Streams简介: 让流处理变得更简单

Introducing Kafka Streams: Stream Processing Made Simple 这是Jay Kreps在三月写的一篇文章,用来介绍Kafka Streams.当时Ka ...

- Kafka Streams简介: 让流处理变得更简单

Introducing Kafka Streams: Stream Processing Made Simple 这是Jay Kreps在三月写的一篇文章,用来介绍Kafka Streams.当时Ka ...

- spring 第一篇(1-1):让java开发变得更简单(下)转

spring 第一篇(1-1):让java开发变得更简单(下) 这个波主虽然只发了几篇,但是写的很好 上面一篇文章写的很好,其中提及到了Spring的jdbcTemplate,templet方式我之前 ...

- Moq让单元测试变得更简单

[ASP.Net MVC3 ]使用Moq让单元测试变得更简单 前几天调查完了unity.现在给我的任务是让我调查Moq. 以下是自己找了资料,总结并实践的内容.如果有表述和理解错误的地方.恳请指正. ...

- Winform 让跨线程访问变得更简单

Winform 让跨线程访问变得更简单 前言 由于多线程可能导致对控件访问的不一致,导致出现问题.C#中默认是要线程安全的,即在访问控件时需要首先判断是否跨线程,如果是跨线程的直接访问,在运行时会抛出 ...

- EpiiAdmin 开源的php交互性管理后台框架, 让复杂的交互变得更简单!Phper快速搭建交互性平台的开发框架,基于Thinkphp5.1+Adminlte3.0+Require.js。

EpiiAdmin EpiiAdmin php开源交互性管理后台框架,基于Thinkphp5.1+Adminlte3.0+Require.js, 让复杂的交互变得更简单!Phper快速搭建交互性平台的 ...

- 快开宝PDA开单器出入库扫码:让批发零售变得更简单

快开宝PDA开单器出现前 批发商户是这样开单和管理的 ★员工痛苦:需要记客户.价格.库存等等,应对报错价.错漏单.盘错货等各种状况. ★老板麻烦:每天要守店.对单.核账,经常因错漏单.库存乱.积压货. ...

随机推荐

- 小白学习VUE第一篇文章---如何看懂网上搜索到的VUE代码或文章---使用VUE的三种模式:

小白学习VUE第一篇文章---如何看懂网上搜索到的VUE代码或文章---使用VUE的三种模式: 直接引用VUE; 将vue.js下载到本地后本目录下使用; 安装Node环境下使用; ant-desig ...

- 本地代码上传github失败常见错误

1.上传失败 解决办法如下: 可以通过如下命令进行github与本地代码合并: git pull --rebase origin master 重新执行上传命令: git push -u origin ...

- Yum未完成事务问题

1.安装 yum-complete-transaction [root@linux-node1 ~]# yum -y install yum-utils 2.清除yum缓存 [root@linux-n ...

- Android mmap 文件映射到内存介绍

本文链接: Android mmap 文件映射到内存介绍 Android开发中,我们可能需要记录一些文件.例如记录log文件.如果使用流来写文件,频繁操作文件io可能会引起性能问题. 为了降低写文件的 ...

- Java第二次作业第四题

文本行输入学生姓名,下来框选择课程名称,文本行输入课程成绩:点击"录入"按钮,相关信息显示在文本区:点击"统计"按钮,将所有录入的成绩的平均成绩显示在另一个文本 ...

- Anroid逆向学习从编写so到静动态调试分析arm的一次总结

Anroid逆向学习从编写so到静动态调试分析arm的一次总结 一.前言 最近跟着教我兄弟学逆向这篇教程学习Android逆向,在第七课后作业反复折腾了好几天,正好在折腾的时候对前面的学习总结一波,动 ...

- wpf 使用矢量字体 fontawesome

第一步:首先下载矢量字体 :http://www.fontawesome.com.cn/ 第二步:在将fontawesome-webfont.ttf 文件引用到项目 设置fontawesome-web ...

- DeleteFolder

import java.io.IOException; import java.net.URI; import java.net.URISyntaxException; /*** * @author ...

- 关于json字符串与实体之间的严格验证

在一个项目中要求严格验证传入的json字符串与定义的 类匹配,否则不记录.感觉这个严格验证找了好多资料才找到,可能用的人比较少,特摘出来给大家分析,直接上代码了: using Newtonsoft ...

- Oracle clob列union的方法(ORA-00932)

今天在做“站内搜索”数据抽取时,为了能将多个相似的数据库表数据合并,使用了SQL中union关键字,期望将多个单独的SQL查询结果合并到一起.每个单独的SQL都能成功执行,在union合并的过程中遇到 ...