Python爬虫-scrapyd

1、什么是scrapyd

Scrapyd是一个服务,用来运行scrapy爬虫的。

它允许你部署你的scrapy项目以及通过HTTP JSON的方式控制你的爬虫。

官方文档:http://scrapyd.readthedocs.org/

2、安装scrapyd和scrapyd-client

pip install scrapyd(服务器)

pip install scrapyd-client(客户端)

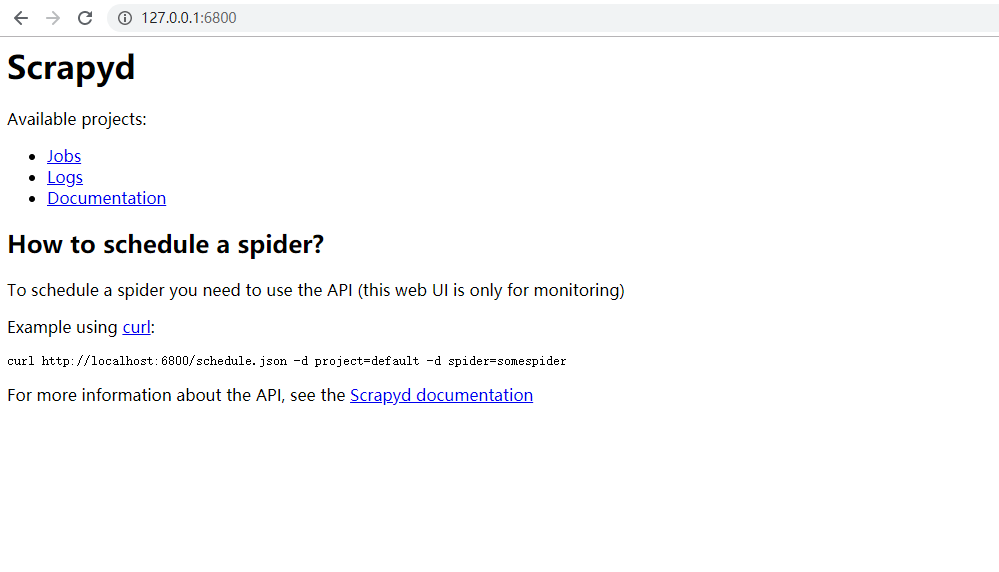

安装完成后,在python安装目录的Scripts的文件下有一个scrapyd.exe,在命令行窗口执行后,可以通过访问http://127.0.0.1:6800,进入

一个很简单的页面,

执行scrapyd这个命令行,表示服务开启了,

在浏览器中访问这个服务,

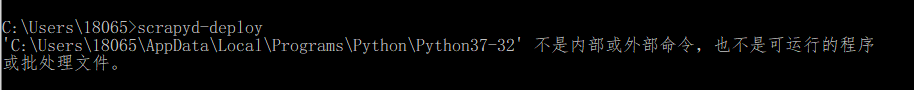

上面表示服务端安装成功,现在来安装测试客户端,安装好后,执行scrapyd-deploy来测试是否安装成功,

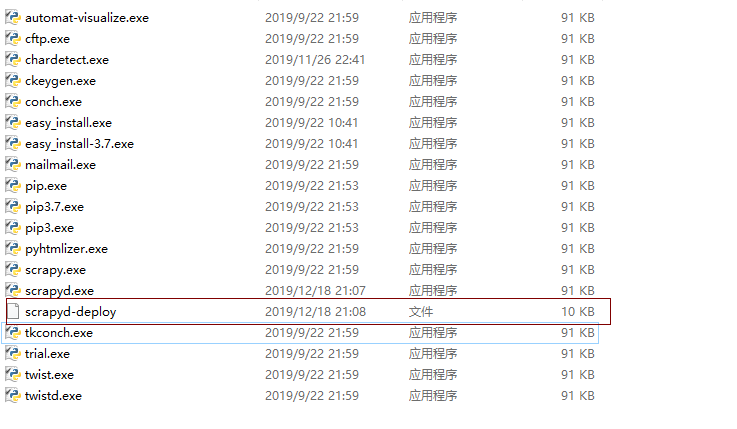

执行失败,我们来看一下Python的Scripts下面是否有一个scrapyd-client.exe命令,

从图片中看到里面有一个scrapyd-deploy文件,但不是可执行文件,打开后发现这个文件是一个包含Python代码的文件,所以要是让它

执行,要不用Python解释器来执行这个文件,要不就是把它编译为可执行文件两种方式。

第一种方式:

在这个文件夹里创建scrapyd-deploy.bat文件,并在里面输入:

@echo off

C:\Users\\AppData\Local\Programs\Python\Python37-\python.exe C:\Users\\AppData\Local\Programs\Python\Python37-\Scripts\scrapyd-deploy %*

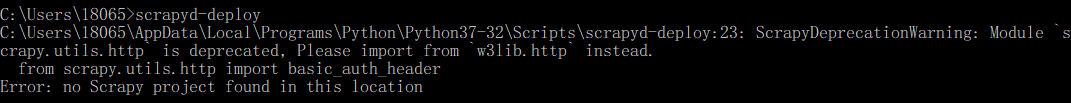

第二行第一个路径是python解释器的绝对路径,第二路径是scrapyd-deploy文件的绝对路径,然后再来执行scrapyd-deploy命令

这样就表明安装成功了

第二种方式:

用可以将python源文件编译为scrapyd-deploy.exe可执行程序的模块pyinstaller

3、上传爬虫项目

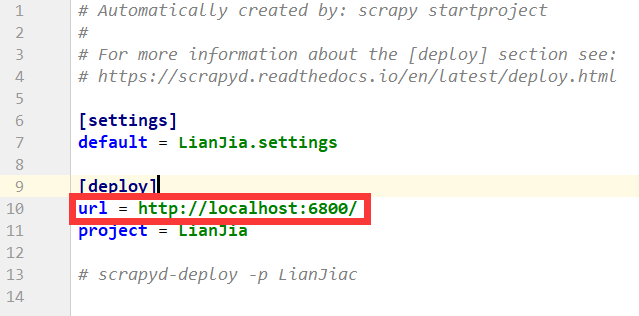

在上传之前必须修改一下配置文件,将scrapy.cfg中的url注释掉

注释掉后,就可以开始正式上传了,上传时必须要在爬虫项目文件中,

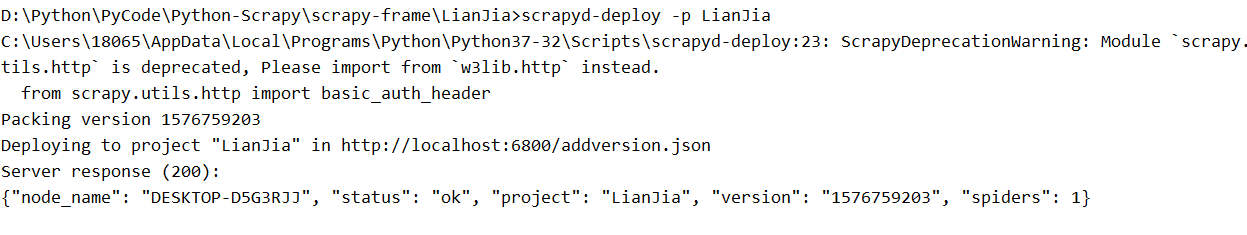

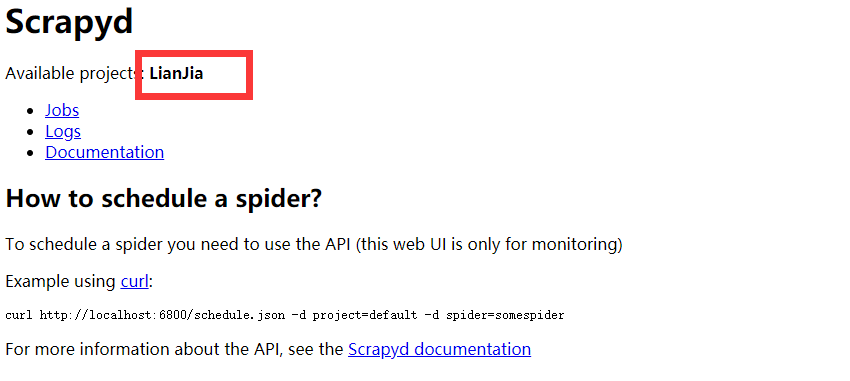

执行scrapyd-deploy -p <projectname>,并出现下图中“status”:“ok”,表示上传成功,可以在http://127.0.0.1:6800页面验证

4、运行爬虫项目

上传过后就可以在命令行窗口开始启动爬虫了

启动命令:curl http://127.0.0.1:6800/schedule.json -d project=<projectname> -d spider=<spidername>

启动后,就可以看到在开启服务的那个命令行窗口不断出现scrapy项目运行时的数据,在http://127.0.0.1:6800/jobs页面显示

爬虫运行信息,在http://127.0.0.1:6800/logs/页面显示运行日志

5、关闭爬虫项目

关闭命令:curl http://127.0.0.1:6800/cancel.json -d project=<projectname> -d job=<jobid>

6、其它命令:

daemonstatus.json #查看爬虫状态

addversion.json #添加版本号

listprojects.json #列出所有已经上传到服务器的爬虫工程名

listversions.json #列出指定工程的版本号

listspiders.json #列出指定工程的爬虫名

listjobs.json #列出指定工程的所有正在上传的,正在运行的,和已经完成的 jobid

delversion.json #删除指定工程的某个版本

delproject.json #删除工程

Python爬虫-scrapyd的更多相关文章

- 初识python爬虫框架Scrapy

Scrapy,按照其官网(https://scrapy.org/)上的解释:一个开源和协作式的框架,用快速.简单.可扩展的方式从网站提取所需的数据. 我们一开始上手爬虫的时候,接触的是urllib.r ...

- 一个Python爬虫工程师学习养成记

大数据的时代,网络爬虫已经成为了获取数据的一个重要手段. 但要学习好爬虫并没有那么简单.首先知识点和方向实在是太多了,它关系到了计算机网络.编程基础.前端开发.后端开发.App 开发与逆向.网络安全. ...

- Python 爬虫模拟登陆知乎

在之前写过一篇使用python爬虫爬取电影天堂资源的博客,重点是如何解析页面和提高爬虫的效率.由于电影天堂上的资源获取权限是所有人都一样的,所以不需要进行登录验证操作,写完那篇文章后又花了些时间研究了 ...

- python爬虫成长之路(一):抓取证券之星的股票数据

获取数据是数据分析中必不可少的一部分,而网络爬虫是是获取数据的一个重要渠道之一.鉴于此,我拾起了Python这把利器,开启了网络爬虫之路. 本篇使用的版本为python3.5,意在抓取证券之星上当天所 ...

- python爬虫学习(7) —— 爬取你的AC代码

上一篇文章中,我们介绍了python爬虫利器--requests,并且拿HDU做了小测试. 这篇文章,我们来爬取一下自己AC的代码. 1 确定ac代码对应的页面 如下图所示,我们一般情况可以通过该顺序 ...

- python爬虫学习(6) —— 神器 Requests

Requests 是使用 Apache2 Licensed 许可证的 HTTP 库.用 Python 编写,真正的为人类着想. Python 标准库中的 urllib2 模块提供了你所需要的大多数 H ...

- 批量下载小说网站上的小说(python爬虫)

随便说点什么 因为在学python,所有自然而然的就掉进了爬虫这个坑里,好吧,主要是因为我觉得爬虫比较酷,才入坑的. 想想看,你可以批量自动的采集互联网上海量的资料数据,是多么令人激动啊! 所以我就被 ...

- python 爬虫(二)

python 爬虫 Advanced HTML Parsing 1. 通过属性查找标签:基本上在每一个网站上都有stylesheets,针对于不同的标签会有不同的css类于之向对应在我们看到的标签可能 ...

- Python 爬虫1——爬虫简述

Python除了可以用来开发Python Web之后,其实还可以用来编写一些爬虫小工具,可能还有人不知道什么是爬虫的. 一.爬虫的定义: 爬虫——网络爬虫(又被称为网页蜘蛛,网络机器人,在FOAF社区 ...

随机推荐

- 文件操作符|-e|-M|-s|-A|_|-r -w $filename|stat|localtime|&|>>|<<

TTY:终端是一种字符型设备,它有多种类型,通常使用tty 来简称各种类型的终端设备 #!/usr/bin/perl use strict; use warnings; print "exi ...

- Educational Codeforces Round 68 差G

Educational Codeforces Round 68 E 题意:有 n 个线段,每个都是平行 x 或者 y 轴,只有互相垂直的两线段才会相交.问形成了多少个矩形. \(n \le 5000, ...

- [GX/GZOI2019]宝牌一大堆(DP)

出这种麻将题有意思吗? 乍看很难实则很水,就是麻将式DP,想必大家很熟悉了吧.首先把“国士无双”和“七对子”两种牌型判掉,然后观察牌胡的形式,发现每多一张牌实际上就是把1个面子变成1个杠子,然后可以直 ...

- Django模型迁移提示版本不匹配解决办法

Django迁移模型时提示django.core.exceptions.ImproperlyConfigured:mysqlclient 1.3.7 or newer is required; you ...

- 二十五、SSH服务企业级应用场景

一.需求分析: 要求所有服务器在同一个用户oldboy1系统用户下,实现A机器从本地分发数据到B\C机器上,在分发过程中不需要B\C的提示系统密码验证,除了分发功能,还需要可以批量查看客户上的cpu. ...

- MDS算法及其matlab实现

问题背景: 在求解MTSP问题的时候,因为已知的为各个巡检点之间路径耗时长度,而这个具体描述采用无向图结构可以很好的描述,在matlab中通过函数(graphallshortestpaths)可以得到 ...

- AOP实现防止接口重复提交

项目中对于状态变更接口存在重复提交的问题. package com.yxx.survey.foundation.aop; import com.alibaba.fastjson.JSON; impor ...

- ACM-ICPC Nanjing Onsite 2018 I. Magic Potion

题意:类似二分图匹配给的题目,不过这次在这里给出了k,表示没人可以再多一次匹配机会,这次匹配不能用上一次被匹配的对象 分析:不能用匈牙利做俩次匹配,因为俩次的最大匹配并不等价于总和的匹配,事实证明,你 ...

- 让mybatis不再难懂(一)

与hibernate相比,我无疑更喜欢mybatis,就因为我觉得它真的好用,哈哈.它简单上手和掌握:sql语句和代码分开,方便统一管理和优化:当然缺点也有:sql工作量很大,尤其是字段多.关联表多时 ...

- 《C Prime Plus》第十节笔记

数组和指针 10.1 数组 10.1.1 初始化数组 标量变量:只储存单个值的变量 创建只读数组,应该用const声明和初始化数组 const int days[] = {1,2,3,5}; 省略方括 ...