Hadoop3集群搭建之——hive安装

现在到hive了。

hive安装比较简单。

下载个包,解压,配置hive-site.xml、hive-env.sh 就好了。

1、下载hive包

官网:http://mirror.bit.edu.cn/apache/hive/hive-2.3.3/

2、解压到hadoop目录

tar -zxvf apache-hive-2.3.-bin.tar.gz #解压

mv apache-hive-2.3.-bin hive2.3.3 #修改目录名,方便使用

3、配置hive环境变量

[hadoop@venn05 ~]$ more .bashrc

# .bashrc # Source global definitions

if [ -f /etc/bashrc ]; then

. /etc/bashrc

fi # Uncomment the following line if you don't like systemctl's auto-paging feature:

# export SYSTEMD_PAGER= # User specific aliases and functions

#jdk

export JAVA_HOME=/opt/hadoop/jdk1.

export JRE_HOME=${JAVA_HOME}/jre

export CLASS_PATH=${JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:$PATH #hadoop

export HADOOP_HOME=/opt/hadoop/hadoop3

export PATH=$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH #hive

export HIVE_HOME=/opt/hadoop/hive2.3.3

export HIVE_CONF_DIR=$HIVE_HOME/conf

export PATH=$HIVE_HOME/bin:$PATH

4、在hdfs上创建hive目录

hive工作目录如下:

<property>

<name>hive.metastore.warehouse.dir</name>

<value>/user/hive/warehouse</value>

<description>location of default database for the warehouse</description>

</property>

<property>

<name>hive.exec.scratchdir</name>

<value>/tmp/hive</value>

<description>HDFS root scratch dir for Hive jobs which gets created with write all () permission. For each connecting user, an HDFS scratch dir: ${hive.exec.scratchdir}/<username> is created, with ${hive.scratch.dir.permission}.</description>

</property>

所以创建如下目录:

hadoop fs -mkdir -p /user/hive/warehouse #hive库文件位置

hadoop fs -mkdir -p /tmp/hive/ #hive临时目录

#授权

hadoop fs -chmod -R 777 /user/hive/warehouse

hadoop fs -chmod -R 777 /tmp/hive

注:必须授权,不然会报错:

Logging initialized using configuration in jar:file:/opt/hadoop/hive2.3.3/lib/hive-common-2.3..jar!/hive-log4j2.properties Async: true

Exception in thread "main" java.lang.RuntimeException: The root scratch dir: /tmp/hive on HDFS should be writable. Current permissions are: rwxr-xr-x

at org.apache.hadoop.hive.ql.session.SessionState.createRootHDFSDir(SessionState.java:)

at org.apache.hadoop.hive.ql.session.SessionState.createSessionDirs(SessionState.java:)

at org.apache.hadoop.hive.ql.session.SessionState.start(SessionState.java:)

at org.apache.hadoop.hive.ql.session.SessionState.beginStart(SessionState.java:)

at org.apache.hadoop.hive.cli.CliDriver.run(CliDriver.java:)

at org.apache.hadoop.hive.cli.CliDriver.main(CliDriver.java:)

at sun.reflect.NativeMethodAccessorImpl.invoke0(Native Method)

at sun.reflect.NativeMethodAccessorImpl.invoke(NativeMethodAccessorImpl.java:)

at sun.reflect.DelegatingMethodAccessorImpl.invoke(DelegatingMethodAccessorImpl.java:)

at java.lang.reflect.Method.invoke(Method.java:)

at org.apache.hadoop.util.RunJar.run(RunJar.java:)

at org.apache.hadoop.util.RunJar.main(RunJar.java:)

5、修改hive-site.xml

cp hive-default.xml.template hive-site.xml

vim hive-site.xml

修改1: 将hive-site.xml 中的 “${system:java.io.tmpdir}” 都缓存具体目录:/opt/hadoop/hive2.3.3/tmp 4处

修改2: 将hive-site.xml 中的 “${system:user.name}” 都缓存具体目录:root 3处

<property>

<name>hive.exec.local.scratchdir</name>

<value>${system:java.io.tmpdir}/${system:user.name}</value>

<description>Local scratch space for Hive jobs</description>

</property>

<property>

<name>hive.downloaded.resources.dir</name>

<value>${system:java.io.tmpdir}/${hive.session.id}_resources</value>

<description>Temporary local directory for added resources in the remote file system.</description>

</property>

<property>

<name>hive.querylog.location</name>

<value>${system:java.io.tmpdir}/${system:user.name}</value>

<description>Location of Hive run time structured log file</description>

</property>

<property>

<name>hive.server2.logging.operation.log.location</name>

<value>${system:java.io.tmpdir}/${system:user.name}/operation_logs</value>

<description>Top level directory where operation logs are stored if logging functionality is enabled</description>

</property>

改为:

<property>

<name>hive.exec.local.scratchdir</name>

<value>/opt/hadoop/hive2.3.3/tmp/root</value>

<description>Local scratch space for Hive jobs</description>

</property>

<property>

<name>hive.downloaded.resources.dir</name>

<value>/opt/hadoop/hive2.3.3/tmp/${hive.session.id}_resources</value>

<description>Temporary local directory for added resources in the remote file system.</description>

</property>

<property>

<name>hive.querylog.location</name>

<value>/opt/hadoop/hive2.3.3/tmp/root</value>

<description>Location of Hive run time structured log file</description>

</property>

<property>

<name>hive.server2.logging.operation.log.location</name>

<value>/opt/hadoop/hive2.3.3/tmp/root/operation_logs</value>

<description>Top level directory where operation logs are stored if logging functionality is enabled</description>

配置元数据库mysql:

mysql> CREATE USER 'hive'@'%' IDENTIFIED BY 'hive'; #创建hive用户

Query OK, rows affected (0.00 sec) mysql> GRANT ALL ON *.* TO 'hive'@'%'; #授权

Query OK, rows affected (0.00 sec)

修改数据库配置:

<!-- mysql 驱动 -->

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

<description>Driver class name for a JDBC metastore</description>

</property>

<!-- 链接地址 -->

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://venn05:3306/hive?createDatabaseIfNotExist=true</value>

<description>

JDBC connect string for a JDBC metastore.

To use SSL to encrypt/authenticate the connection, provide database-specific SSL flag in the connection URL.

For example, jdbc:postgresql://myhost/db?ssl=true for postgres database.

</description>

</property>

<!-- 用户名 -->

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>hive</value>

<description>Username to use against metastore database</description>

</property>

<!-- 密码 -->

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>hive</value>

<description>password to use against metastore database</description>

</property>

6、修改hive-env.sh

cp hive-env.sh.template hive-env.sh

vim hive-env.sh

在末尾添加如下内容:

export HADOOP_HOME=/opt/hadoop/hadoop3

export HIVE_CONF_DIR=/opt/hadoop/hive2.3.3/conf

export HIVE_AUX_JARS_PATH=/opt/hadoop/hive2.3.3/lib

7、上传mysql驱动包

上传到:$HIVE_HOME/lib

8、初始化hive

schematool -initSchema -dbType mysql

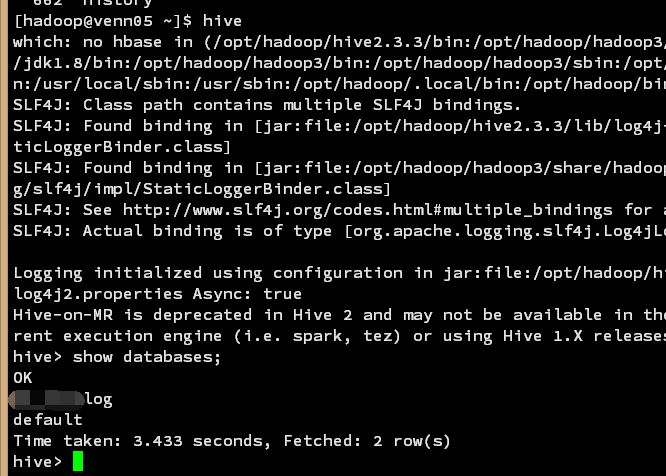

9、启动hive

hive

搞定

Hadoop3集群搭建之——hive安装的更多相关文章

- Hadoop3集群搭建之——hbase安装及简单操作

折腾了这么久,hbase终于装好了 ------------------------- 上篇: Hadoop3集群搭建之——虚拟机安装 Hadoop3集群搭建之——安装hadoop,配置环境 Hado ...

- Hadoop3集群搭建之——hive添加自定义函数UDTF (一行输入,多行输出)

上篇: Hadoop3集群搭建之——虚拟机安装 Hadoop3集群搭建之——安装hadoop,配置环境 Hadoop3集群搭建之——配置ntp服务 Hadoop3集群搭建之——hive安装 Hadoo ...

- Hadoop3集群搭建之——hive添加自定义函数UDTF

上篇: Hadoop3集群搭建之——虚拟机安装 Hadoop3集群搭建之——安装hadoop,配置环境 Hadoop3集群搭建之——配置ntp服务 Hadoop3集群搭建之——hive安装 Hadoo ...

- Hadoop3集群搭建之——hive添加自定义函数UDF

上篇: Hadoop3集群搭建之——虚拟机安装 Hadoop3集群搭建之——安装hadoop,配置环境 Hadoop3集群搭建之——配置ntp服务 Hadoop3集群搭建之——hive安装 Hadoo ...

- Hadoop3集群搭建之——虚拟机安装

现在做的项目是个大数据报表系统,刚开始的时候,负责做Java方面的接口(项目前端为独立的Java web 系统,后端也是Java web的系统,前后端系统通过接口传输数据),后来领导觉得大家需要多元化 ...

- Hadoop3集群搭建之——安装hadoop,配置环境

接上篇:Hadoop3集群搭建之——虚拟机安装 下篇:Hadoop3集群搭建之——配置ntp服务 Hadoop3集群搭建之——hive安装 Hadoop3集群搭建之——hbase安装及简单操作 上篇已 ...

- Hadoop3集群搭建之——配置ntp服务

上篇: Hadoop3集群搭建之——虚拟机安装 Hadoop3集群搭建之——安装hadoop,配置环境 下篇: Hadoop3集群搭建之——hive安装 Hadoop3集群搭建之——hbase安装及简 ...

- Hadoop集群搭建-03编译安装hadoop

Hadoop集群搭建-05安装配置YARN Hadoop集群搭建-04安装配置HDFS Hadoop集群搭建-03编译安装hadoop Hadoop集群搭建-02安装配置Zookeeper Hado ...

- BigData--hadoop集群搭建之hbase安装

之前在hadoop-2.7.3 基础上搭建hbase 详情请见:https://www.cnblogs.com/aronyao/p/hadoop.html 基础条件:先配置完成zookeeper 准备 ...

随机推荐

- 【Android端 adb相关】adb相关总结

一.什么是adb? adb的全称是:Android Debug Bridge,adb命令的构成是三部分,分别是:服务器.客户端.后台程序: (1)客户端:一个在PC上运行的客户端.可以通过shell端 ...

- elasticsearch查询语句总结

query 和 filter 的区别请看:https://www.cnblogs.com/bainianminguo/articles/10396956.html Filter DSL term 过 ...

- scrapy的调试和环境安装技巧

1,先在settings中把ROBOTSTXT_OBEY = False 在主目录下面新建main文件 __autor__ = 'zhouli' __date__ = '2018/11/3 22:39 ...

- git 忽略 IntelliJ .idea文件

git 忽略 IntelliJ .idea文件 2016年10月22日 11:31:27 阅读数:6196 标签: git 更多 个人分类: git 版权声明:本文为博主原创文章,未经博主允许不得 ...

- java 线程Thread 技术--1.5 Executor Executors,ThreadPool,Queue

Executors : Executors ,就是一个线程工具类:大部分操作线程的方法,都可以在这个工具类中就行创建,执行,调用一些线程的方法: Executor : 用于执行和提交一个runnabl ...

- Java_6 方法

1方法的定义和使用的注意事项 方法:一些功能整合成一个功能模块 注意事项: a: 方法不能定义在另一个方法的里面 b: 写错方法名字 c: 写错了参数列表 d: 方法返回值是void,方法中可 ...

- jwplayer使用方法

网盘:https://pan.baidu.com/s/1mmtppZSFOni5tLI2TJWKrw <script type="text/javascript"> v ...

- c# 线程启动while(true) 死循环,里边的return导致线程退出情况,查错

写了一个线程 线程下启动了一个循环 while(true) { 里边有个判断 如果为空不操作, 有余这个线程是后加的,老程序里边因为有个return没关注,导致线程退出而不能不听的监控 } 线程启动一 ...

- Oracle_SQL(3) DML增删改

sql语言按功能分为:数据定义语言DDL.数据操纵语言DML.数据查询语言DQL.数据控制语言DCL 一.数据操纵语言DML1.insert 新增 语法:insert into <表名> ...

- Array Division 808D

D. Array Division time limit per test 2 seconds memory limit per test 256 megabytes input standard i ...