基于tornado的爬虫并发问题

tornado中的coroutine是python中真正意义上的协程,与python3中的asyncio几乎是完全一样的,而且两者之间的future是可以相互转换的,tornado中有与asyncio相兼容的接口。

下面是利用tornado中的coroutine进行并发抓取的代码:

HEADERS = {'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9',

'Accept-Language': 'zh-CN,zh;q=0.8',

'Accept-Encoding': 'gzip, deflate',}

URLS = ['http://www.cnblogs.com/moodlxs/p/3248890.html',

'https://www.zhihu.com/topic/19804387/newest',

'http://blog.csdn.net/yueguanghaidao/article/details/24281751',

'https://my.oschina.net/visualgui823/blog/36987',

'http://blog.chinaunix.net/uid-9162199-id-4738168.html',

'http://www.tuicool.com/articles/u67Bz26',

'http://rfyiamcool.blog.51cto.com/1030776/1538367/',

'http://itindex.net/detail/26512-flask-tornado-gevent']

from tornado.gen import coroutine

from tornado.ioloop import IOLoop

from tornado.httpclient import AsyncHTTPClient, HTTPError

from tornado.httpclient import HTTPRequest #urls与前面相同

class MyClass(object): def __init__(self):

#AsyncHTTPClient.configure("tornado.curl_httpclient.CurlAsyncHTTPClient")

self.http = AsyncHTTPClient() @coroutine

def get(self, url):

#tornado会自动在请求首部带上host首部

request = HTTPRequest(url=url,

method='GET',

headers=HEADERS,

connect_timeout=2.0,

request_timeout=2.0,

follow_redirects=False,

max_redirects=False,

user_agent="Mozilla/5.0+(Windows+NT+6.2;+WOW64)+AppleWebKit/537.36+(KHTML,+like+Gecko)+Chrome/45.0.2454.101+Safari/537.36",)

yield self.http.fetch(request, callback=self.find, raise_error=False) def find(self, response):

if response.error:

print(response.error)

print(response.code, response.effective_url, response.request_time) class Download(object): def __init__(self):

self.a = MyClass()

self.urls = URLS @coroutine

def d(self):

print(u'基于tornado的并发抓取')

t1 = time.time()

yield [self.a.get(url) for url in self.urls]

t = time.time() - t1

print(t) if __name__ == '__main__':

dd = Download()

loop = IOLoop.current()

loop.run_sync(dd.d)

利用coroutine编写并发略显复杂,但这是推荐的写法,如果你使用的是python3,强烈建议你使用coroutine来编写并发抓取。

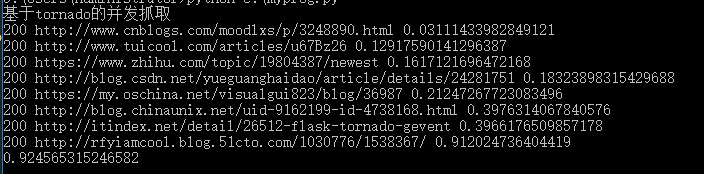

下面是测试结果:

可以看到总共花费了0.92456秒,而这所花费的时间恰恰就是最后一个url抓取所需要的时间,tornado中自带了查看每个请求的相应时间。我们可以从图中看到,最后一个url抓取总共花了0.912秒,相较于其他时间大大的增加,这也是导致我们消耗时间过长的原因。那可以推断出,前面的并发抓取,也在这个url上花费了较多的时间。

转载:https://blog.csdn.net/hjhmpl123/article/details/53378068

基于tornado的爬虫并发问题的更多相关文章

- 基于tornado的文件上传demo

这里,web框架是tornado的4.0版本,文件上传组件,是用的bootstrap-fileinput. 这个小demo,是给合作伙伴提供的,模拟APP上摄像头拍照,上传给后台服务进行图像识别用,识 ...

- 基于golang分布式爬虫系统的架构体系v1.0

基于golang分布式爬虫系统的架构体系v1.0 一.什么是分布式系统 分布式系统是一个硬件或软件组件分布在不同的网络计算机上,彼此之间仅仅通过消息传递进行通信和协调的系统.简单来说就是一群独立计算机 ...

- 基于RTKLIB构建高并发通信测试工具

1. RTKLIB基础动态库生成 RTKLIB是全球导航卫星系统GNSS(global navigation satellite system)的标准&精密定位开源程序包,由日本东京海洋大学的 ...

- 基于tornado实现web camera

基于tornado实现web camera 近期在学习python.找了一个框架学习,我选择的是tornado.由于其不仅仅是一个web开发框架,其还是一个server,异步事件库,一举多得. 我一直 ...

- 基于socket 实现单线程并发

基于socket 实现单线程并发: 基于协程实现内IO的快速切换,我们必须提前导入from gevent import monkey;monkey pacth_all() 以为 gevent spaw ...

- 【redis】基于redis实现分布式并发锁

基于redis实现分布式并发锁(注解实现) 说明 前提, 应用服务是分布式或多服务, 而这些"多"有共同的"redis"; (2017-12-04) 笑哭, 写 ...

- 1.tornado实现高并发爬虫

from pyquery import PyQuery as pq from tornado import ioloop, gen, httpclient, queues from urllib.pa ...

- tornado实现高并发爬虫

from pyquery import PyQuery as pq from tornado import ioloop, gen, httpclient, queues from urllib.pa ...

- AssassinGo: 基于Go的高并发可拓展式Web渗透框架

转载自FreeBuf.COM AssassinGo是一款使用Golang开发,集成了信息收集.基础攻击探测.Google-Hacking域名搜索和PoC批量检测等功能的Web渗透框架,并且有着基于Vu ...

随机推荐

- 001-Go JSON处理

在golang中提供的encoding/json包可以编码JSON以及解码JSON数据. 1.编码JSON 使用json包中的Marshal函数进行编码,源码如下: func Marshal(v in ...

- excel自定义数据验证

1. 判断必须为5位或者9位的数字 2. 自定义限制级别和提示消息

- C++库研究笔记--用__attribute__((deprecated)) 管理过时代码

用__attribute__((deprecated)) 管理过时代码.同一时候保留兼容的接口 Linux下: #define DEPR_AFTER __attribute__((deprecated ...

- 获取ul下li标签里点击的是哪一个li并获取li里a标签的值

$("ul li").click(function(){ //获取当天月份 ).text(); ,) alert(month); }); <!doctype html> ...

- Android——复制项目出现Application Installation Failed

今天把一个项目复制到另一个文件夹下,重新打开结果不能正常安装到虚拟机上了. 解决方法: Build——Clean Project :清除一下项目缓存 Build——Rebuild Project ...

- LeetCode 225 Implement Stack using Queues(用队列来实现栈)(*)

翻译 用队列来实现栈的例如以下操作. push(x) -- 将元素x加入进栈 pop() -- 从栈顶移除元素 top() -- 返回栈顶元素 empty() -- 返回栈是否为空 注意: 你必须使用 ...

- 10个超棒jQuery表单操作代码片段

jQuery绝对是一个伟大的开源javascript类库,是帮助我们快速和高效开发前端应用的利器.可能大家在日常的开发过程中常常会处理表单相关的javascript,在今天这篇代码片段分享文章中,这里 ...

- CString与UTF8互转代码

这个代码网上很多,留在这里做个备份. static std::string ConvertCStringToUTF8( CString strValue ) { std::wstring wbuffe ...

- php与redis使用经验分享 (转载)

一.安装 1.redis的下载及安装: 引用 mkdir /usr/local/redis cd /usr/local/redis wget http://redis.googlecode.com/f ...

- 微信小程序学习点滴《十二》:图片等比例缩放 获取屏幕尺寸图片尺寸 自适应

原文:http://www.wxapp-union.com/portal.php?mod=view&aid=360 早上在论坛上看到有人写了关于图片等比例缩放的文章,只是判断了图片宽是否大于屏 ...