Paper | Residual learning

目录

论文:Deep residual learning for image recognition

He, Kaiming, et al. "Deep residual learning for image recognition." Proceedings of the IEEE conference on computer vision and pattern recognition. 2016.

Over 20000 citations (2019).

解决的问题:使深度网络更容易训练。

To ease the training of networks that are substantially deeper than those used previously.

1. OVERVIEW

首先,堆叠更多层,确实让特征提取更加有效。

Deep networks naturally integrate low/mid/highlevel features [49] and classifiers in an end-to-end multilayer fashion, and the “levels” of features can be enriched by the number of stacked layers (depth).

但网络太深的主要困难,在于梯度消失或爆炸:

An obstacle to answering this question was the notorious problem of vanishing/exploding gradients [14, 1, 8], which hamper convergence from the beginning.

前人的加速方法主要是标准化层和正则初始化:

This problem, however, has been largely addressed by normalized initialization [23, 8, 36, 12] and intermediate normalization layers [16], which enable networks with tens of layers to start converging for stochastic gradient descent (SGD) with backpropagation [22].

具体为什么标准化层可以加快训练,参考这篇博客及其相关论文。

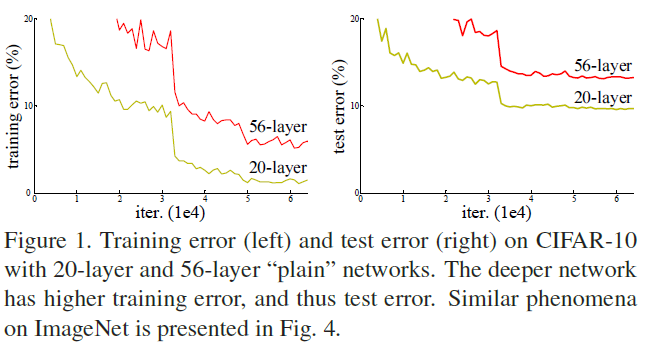

当网络更深时,一个新的问题出现了。我们称之为 Degradation :

如图,在准确率基本饱和时,深层网络的训练误差比浅层网络还高。

实验证明,随着网络加深,这种退化越来越剧烈。

这是因为过拟合吗?

如果是过拟合,那么训练误差不应该随网络加深而上升(过拟合时训练误差应该很低)。

我们继续研究这个问题。

2. DEGRADATION

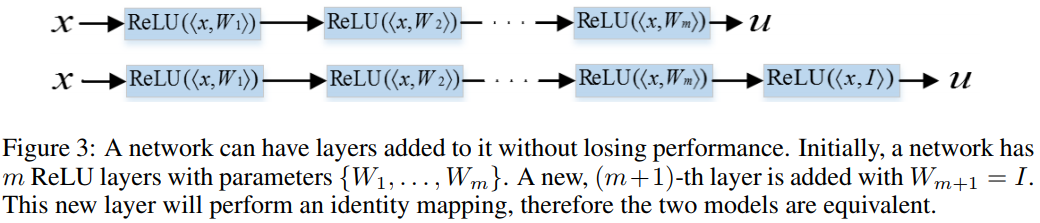

我们先训练好一个 shallower architecture ,其能输出理想的结果。

然后,我们复制该 shallower architecture ,再加上一层或多层网络,得到一个 deeper model ,如图:

我们再训练 deeper model 。

理想情况下, added layers 只需要简单地实现 identity mapping 功能,就可以让训练误差不下降,甚至还有可能上升。

然而实验证实,deeper model 要么耗时过长,要么效果不如预期。

这是深度网络退化问题的一个实验说明。

3. SOLUTION(DEEP RESIDUAL LEARNING)

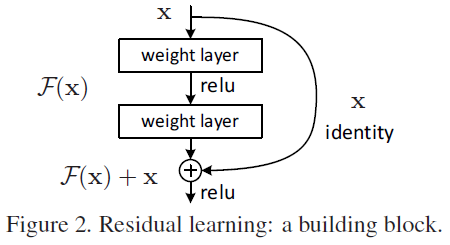

为了解决退化问题,我们引入了 deep residual learning 。其根本思想是:

Instead of hoping each few stacked layers directly fit a desired underlying mapping, we explicitly let these layers fit a residual mapping.

比如,假设原映射是 \(\mathscr H(\mathrm x)\) ,那么我们希望非线性层真正学习的映射就是:

\[

\mathscr F(\mathrm x) := \mathscr H(\mathrm x) - \mathscr x

\]

回到上一节的例子。

我们希望附加层能学到恒等映射,由于该层是非线性层,训练起来依然非常困难。

但是,如果我们学习的是残差映射,即全零的残差,显然容易多了。

思想类似于 SVM ,但是你怎么想不到!!!

4. IMPLEMENTATION(SHORTCUT CONNECTIONS)

思想有了,具体怎么实现呢?

忍不住了:何大神太牛逼了!!!!

回到刚刚的例子。假设:

- added layers 的目标映射是 \(\mathscr H\) ;

- 原 shallower architecture 的输出,是 \(\mathscr H\) 的输入 \(\mathrm x\) 。

为了迫使前面的非线性层学习残差,我们假设网络输出就是残差的情况。

此时,我们应该在计算损失之前,让网络的输出 \(\mathscr H(\mathrm x)\) 与原始输入 \(\mathrm x\) 求和。

因此网络如下:

如此连接是可导的,因此可以应用反向传播算法。

当然,为什么学“全0”更简单,没有详细的理论分析,而需要大量的实验证明。

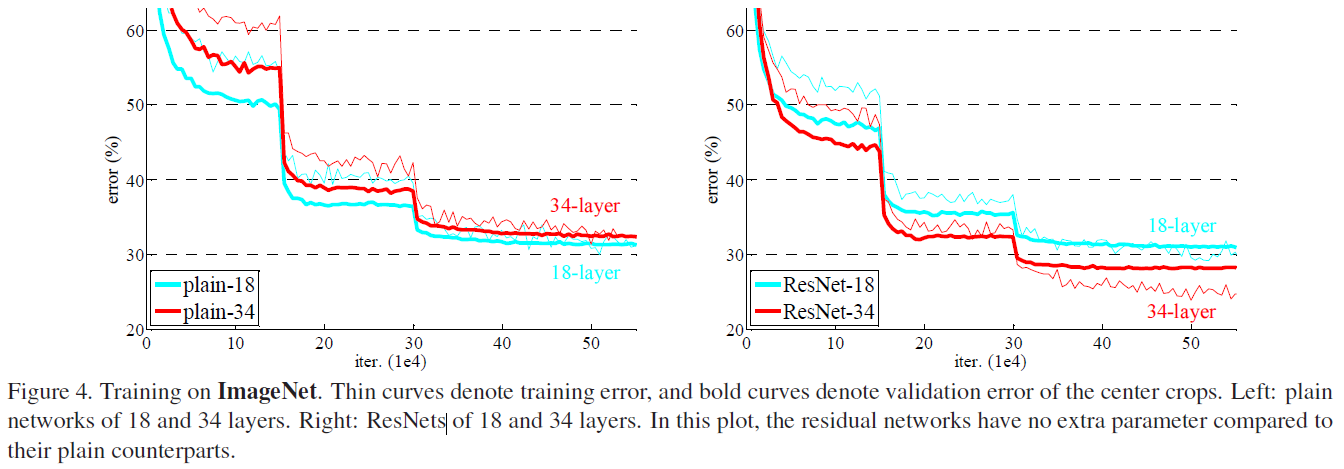

右图实验结果表明,左图的退化问题得到了有效解决。

Paper | Residual learning的更多相关文章

- Paper | Beyond a Gaussian Denoiser: Residual Learning of Deep CNN for Image Denoising

目录 故事背景 网络结构 BN和残差学习 拓展到其他任务 发表在2017 TIP. 摘要 Discriminative model learning for image denoising has b ...

- [论文阅读] Deep Residual Learning for Image Recognition(ResNet)

ResNet网络,本文获得2016 CVPR best paper,获得了ILSVRC2015的分类任务第一名. 本篇文章解决了深度神经网络中产生的退化问题(degradation problem). ...

- 论文笔记——Deep Residual Learning for Image Recognition

论文地址:Deep Residual Learning for Image Recognition ResNet--MSRA何凯明团队的Residual Networks,在2015年ImageNet ...

- Deep Residual Learning for Image Recognition论文笔记

Abstract We present a residual learning framework to ease the training of networks that are substant ...

- 深度学习方法(五):卷积神经网络CNN经典模型整理Lenet,Alexnet,Googlenet,VGG,Deep Residual Learning

欢迎转载,转载请注明:本文出自Bin的专栏blog.csdn.net/xbinworld. 技术交流QQ群:433250724,欢迎对算法.技术感兴趣的同学加入. 关于卷积神经网络CNN,网络和文献中 ...

- Deep Residual Learning for Image Recognition

Kaiming He, Xiangyu Zhang, Shaoqing Ren, Jian Sun Microsoft Research {kahe, v-xiangz, v-sh ...

- 【文献阅读】Deep Residual Learning for Image Recognition--CVPR--2016

最近准备用Resnet来解决问题,于是重读Resnet的paper <Deep Residual Learning for Image Recognition>, 这是何恺明在2016-C ...

- Deep Residual Learning

最近在做一个分类的任务,输入为3通道车型图片,输出要求将这些图片对车型进行分类,最后分类类别总共是30个. 开始是试用了实验室师姐的方法采用了VGGNet的模型对车型进行分类,据之前得实验结果是训练后 ...

- 深度学习基础(五)ResNet_Deep Residual Learning for Image Recognition

ResNet可以说是在过去几年中计算机视觉和深度学习领域最具开创性的工作.在其面世以后,目标检测.图像分割等任务中著名的网络模型纷纷借鉴其思想,进一步提升了各自的性能,比如yolo,Inception ...

随机推荐

- 用GDB调试程序(二)

GDB的命令概貌——————— 启动gdb后,就你被带入gdb的调试环境中,就可以使用gdb的命令开始调试程序了,gdb的命令可以使用help命令来查看,如下所示: /home/hchen> g ...

- 【亲测】在网页上查找接口,Network--XHR,出来的每个Name都是后台的一个接口

- spring梳理

- 06python上

product_list=[ ('Mac',9000), ('kindle',800), ('tesla',900000), ('python book',105), ('bike',2000), ] ...

- pandas 存取数据小笔记

import pandas as pd 1. 读取和保存 csv文件 #读 df = pd.read_csv(read_file_path, header=0) # 其中read_file_pat ...

- Azkaban安装及分布式部署(multiple-executor)

参考文章:https://blog.csdn.net/weixin_35852328/article/details/79327996 官网:https://azkaban.readthedocs.i ...

- 关于EXCEPT和INTERSECT的用法和例子

EXCEPT是指在第一个集合中存在,但是不存在于第二个集合中的数据. INTERSECT是指在两个集合中都存在的数据. select qq from #table1 如下: select qq fro ...

- OkHttp 同步异步操作

OkHttp是一个Java和Android的HTTP和HTTP/2的客户端,负责发送HTTP请求以及接受HTTP响应. 一.使用OkHttp OkHttp发送请求后,可以通过同步或异步地方式获取响应. ...

- cdnbest如何让用户访问走最近最快的线路(分组线路)

用户访问网站有时网络有互通的问题,cdnbest的分组解析可以细分线路,让用户访问自动走最优线路,线路不细分都加默认里,访问的节点是随机分配的 下面我们讲下如何设置: 比如你有电信,移动,和国外的节点 ...

- 清理SqlServer日志

最近做一个数据采集的项目,使用SQLSserver2014数据库 没想到数据才采集两三天,C盘空间已经剩下8M 连忙看了一下SQLSerevr数据库文件夹 位于 C:\Program Files\Mi ...