Hadoop2.6.0伪分布式搭建

环境:

1、Ubuntu14.04

首先要在linux系统上新建一个账户,比如就叫做hadoop,用于专门运行hadoop。

2、配置jdk

我是使用的版本是jdk1.8。

解压:创建/usr/java目录,把下载好了的linux版本的jdk解压到次目录下。

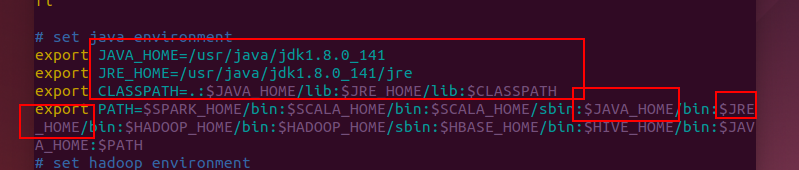

环境变量配置:

命令sudo vim /etc/profile

在文件末端添加如下内容

保存退出后执行 source /etc/profile更新配置。然后执行java -version如果有如下信息就表示jdk配置成功。

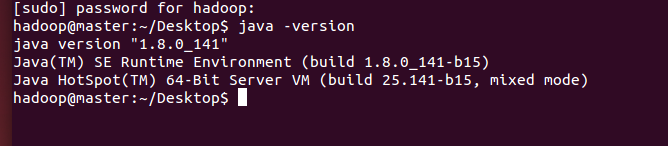

3 配置ssh免密码登录:

首先是下载安装openssh-server服务,执行如下命令:

sudo apt-get install openssh-server

输入如下图命令,就可以配置好ssh免密码登陆了,不过注意一点是第一行命令改成:

ssh-keygen -t rsa

一路回车就行了

这样会在/home/当前用户(比如我的是/home/hadoop)目录产生一个新的目录叫 .ssh,进入发现多了两个文件分别是id_rsa和id_rsa.pub,分别是RSA的私钥和公钥,然后执行如下命令:

cat id_rsa.pub>>authorized_keys

把公钥内容复制并且添加进authorized_keys文件(设置本机ssh免密码登录)

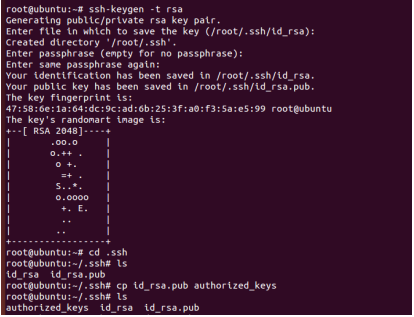

4、hadoop配置

将下载的hadoop2.6.0安装包解压到/usr/local目录下,并且重命名为hadoop。

修改hadoop目录的权限

sudo chown -R hadoop ./hadoop

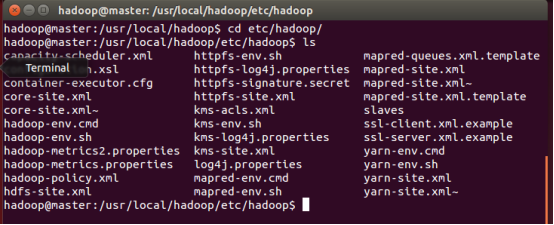

进入hadoop/etc/hadoop目录,ls一下能看到如下这些配置文件:

下面挨个配置:

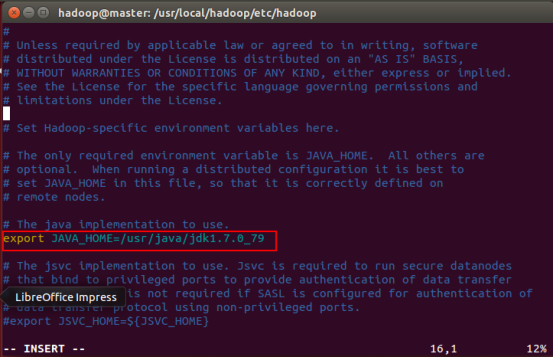

hadoop-env.sh配置

下图用红框框住的一行,“=”之后是你的jdk的绝对路径(我后来把jdk改成1.8了,这个版本仅供参考,大家按照自己系统的具体情况写就好了)。

hdfs-site.xml配置

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/data</value>

</property>

core-site.xml

<property>

<name>hadoop.tmp.dir</name>

<value>file:/usr/local/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://master:9000</value>

</property>

mapred-site.xml

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapred.job.tracker</name>

<value>master:9001</value>

</property>

<property>

<name>mapred.local.dir</name>

<value>/usr/local/hadoop/mapred/local</value>

</property>

<property>

<name>mapred.system.dir</name>

<value>/tmp/hadoop/mapred/system</value>

</property>

yarn-site.xml

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name>

<value>org.apache.hadoop.mapred.ShuffleHandler</value>

</property>

这就大功告成了。

Hadoop2.6.0伪分布式搭建的更多相关文章

- hadoop2.4.0伪分布式搭建以及分布式关机重启后datanode没起来的解决办法

1.准备Linux环境 1.0点击VMware快捷方式,右键打开文件所在位置 -> 双击vmnetcfg.exe -> VMnet1 host-only ->修改subnet ip ...

- hadoop2.2.0伪分布式搭建3--安装Hadoop

3.1上传hadoop安装包 3.2解压hadoop安装包 mkdir /cloud #解压到/cloud/目录下 tar -zxvf hadoop-2.2.0.tar.gz -C /cloud/ 3 ...

- hadoop2.2.0伪分布式搭建

1.准备Linux环境 1.0点击VMware快捷方式,右键打开文件所在位置 -> 双击vmnetcfg.exe -> VMnet1 host-only ->修改subnet ...

- hadoop2.2.0伪分布式搭建1--准备Linux环境

1.0修改网关 点击VMware快捷方式,右键打开文件所在位置 -> 双击vmnetcfg.exe -> VMnet1 host-only ->修改subnet ip 设置网段:19 ...

- hadoop2.2.0伪分布式搭建2--安装JDK

2.1上传FileZilla 上传 https://filezilla-project.org/ 2.2解压jdk #创建文件夹 mkdir /usr/java #解压 tar -zxvf jdk-7 ...

- Hadoop2.5.0伪分布式环境搭建

本章主要介绍下在Linux系统下的Hadoop2.5.0伪分布式环境搭建步骤.首先要搭建Hadoop伪分布式环境,需要完成一些前置依赖工作,包括创建用户.安装JDK.关闭防火墙等. 一.创建hadoo ...

- 在Win7虚拟机下搭建Hadoop2.6.0伪分布式环境

近几年大数据越来越火热.由于工作需要以及个人兴趣,最近开始学习大数据相关技术.学习过程中的一些经验教训希望能通过博文沉淀下来,与网友分享讨论,作为个人备忘. 第一篇,在win7虚拟机下搭建hadoop ...

- bayaim_hadoop1_2.2.0伪分布式搭建

------------------bayaim_hadoop1_2.2.0伪分布式搭建_2018年11月06日09:21:46--------------------------------- 1. ...

- 琐碎-hadoop2.2.0伪分布式和完全分布式安装(centos6.4)

环境是centos6.4-32,hadoop2.2.0 伪分布式文档:http://pan.baidu.com/s/1kTrAcWB 完全分布式文档:http://pan.baidu.com/s/1s ...

随机推荐

- oracle聚簇表的理解 (转自:https://blog.csdn.net/gumengkai/article/details/51009345 )

Oracle支持两种类型的聚簇:索引聚簇和哈希聚簇 一.索引聚簇表的原理 聚簇:如果一些表有一些共同的列,则将这样一组表存储在相同的数据块中 聚簇还表示把相关的数据存储在同一个块上.利用聚簇,一个块可 ...

- call、apply和bind的用法

在改变 this 指向的时候,经常会把这三个方法混淆,下面就详细的整理一下三者的用法和区别 call() 方法 call() 方法可以有无数个参数 第一个参数是改变 this 指向的对象 后面的参数直 ...

- 更换eclipse字体

eclipse自带的字体非常不好,看的我难受,可能是使用myeclipse习惯了,怎么调节都不好使 最后决定下载一个字体包吧! 字体下载地址如下:http://files.cnblogs.com/ic ...

- POJ 2007--Scrambled Polygon(计算凸包,点集顺序)

Scrambled Polygon Time Limit: 1000MS Memory Limit: 30000K Total Submissions: 10094 Accepted: 476 ...

- JAVA Web 项目中用到的技术

JSPServletTomcatMySQL MavenSpringMVCHibernatejQueryBootstrapAngularJSBootStrap Table 下边两个是移动APP开发要用到 ...

- 《python编程从入门到实践》第六章笔记

1.字典 字典:一系列键-值对,每一个键都与每一个值相关联.与键相关联的值可以是数字.字符串.列表和字典. 最简单的字典只有一个键值对. eg: alien = {'color':'green','p ...

- DLX算法一览

目录: 1 X思想的了解. 链表的递归与回溯. 具体操作. 优化. 一些应用与应用中的再次优化(例题). 练手题 X思想的了解. 首先了解DLX是什么? DLX是一种多元未饱和型指令集结构,DLX 代 ...

- C# FTP上传文件时出现"应 PASV 命令的请求,服务器返回了一个与 FTP 连接地址不同的地址。"的错误

FTP上传文件时出现"应 PASV 命令的请求,服务器返回了一个与 FTP 连接地址不同的地址."的错误 解决方法是在原代码上增加这句话 reqFTP.UsePassive = f ...

- HyperLedger Fabric 1.4 超级账本项目(5.4)

超级账本(Hyperledger)项目分框架类和工具类两种项目,框架类有Hyperledger Burrow.Hyperledger Fabric.Hyperledger Indy.Hyperledg ...

- ABAP CDS - Syntax

The syntax of the DDL and of the DCL of the ABAP CDS comprises elements of the general DDL and DCL o ...