Spark on Yarn 集群运行要点

实验版本:spark-1.6.0-bin-hadoop2.6

本次实验主要是想在已有的Hadoop集群上使用Spark,无需过多配置

1、下载&解压到一台使用spark的机器上即可

2、修改配置文件 vi ./conf/spark-env.sh

export HADOOP_HOME=/share/apps/hadoop

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

3、测试验证spark正常运行

./bin/spark-submit --master yarn --name spark-test --class org.apache.spark.examples.SparkPi lib/spark-examples*.jar

部署文章可以参考:

Spark1.0.x入门指南(spark on yarn, standalone) —核心网络 http://demo.netfoucs.com/can007/article/details/37885555

Spark 官方提供了三种集群部署方案: Standalone, Mesos, YARN,区别就在于资源管理调度平台不同。

其中Spark on YARN 支持两种运行模式,分别为yarn-cluster和yarn-client。

yarn-cluster适用于生产环境,yarn-cluster模式下,driver运行在AM(Application Master)中,它负责向YARN申请资源,并监督作业的运行状况。当用户提交了作业之后,就可以关掉Client,作业会继续在YARN上运行。

而yarn-client适用于交互和调试,快速地看到application的输出,yarn-client模式下,Application Master仅仅向YARN请求executor,client会和请求的container通信来调度他们工作,也就是说Client不能离开。

# --deploy-mode 默认值为client

./bin/spark-submit --class path.to.your.Class --master yarn --deploy-mode cluster [options] <app jar> [app options] # debug

yarn logs -applicationId <app ID>

# yarn logs -applicationId application_1452166952348_14773

# spark-submit --master yarn --deploy-mode cluster user_event_withFlow_distributed.py

推荐阅读系列文章: http://www.iteblog.com/archives/1223

Q:scala是否必要?

A:我没有安装,spark可以正常运行。【具体作用求解答】

Q:分布式环境下使用shell

A:

./bin/spark-shell --master yarn --deploy-mode client

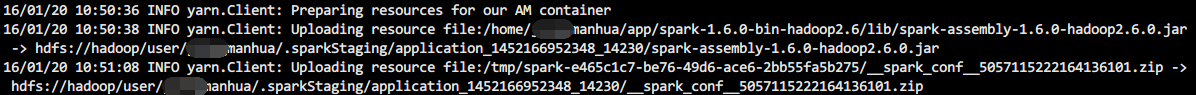

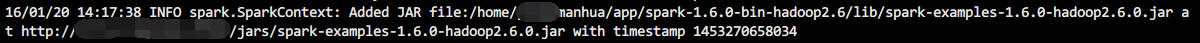

Q:每次提交运行任务时,都会要上传$SPARK_HOME/lib/spark-examples-1.6.0-hadoop2.6.0.jar到HDFS上,好慢

A:在HDFS上面建立一个公共的lib库存放目录,每次运行Spark时,如果程序依赖的Jar包存在HDFS中的lib库中,那么不上传该Jar包。

上传jar包

hadoop fs -mkdir spark_lib

hadoop fs -put /home/manhua/app/spark-1.6.-bin-hadoop2./lib/spark-assembly-1.6.-hadoop2.6.0.jar spark_lib/spark-assembly-1.6.-hadoop2.6.0.jar

修改配置文件

cd spark/conf

cp spark-defaults.conf.template spark-defaults.conf

vi spark-defaults.conf #add

spark.yarn.jar=hdfs:///user/jiangmanhua/spark_lib/spark-assembly-1.6.0-hadoop2.6.0.jar

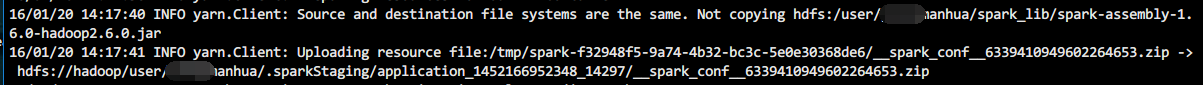

再次运行,已经不用上传了。

./bin/spark-submit --master yarn --name spark-test --class org.apache.spark.examples.SparkPi lib/spark-examples*.jar

该方法理论上同样适用其他的依赖包

Q:如何自定义格式化输出?

A:转换使得RDD的数据结构为[(k,v), (k,v)......],然后使用saveAsNewAPIHadoopFile函数保存到文件系统,输出则为k\tv

u_acts.saveAsNewAPIHadoopFile('tmp/out20160121-1', "org.apache.hadoop.mapreduce.lib.output.TextOutputFormat",

"org.apache.hadoop.io.Text", "org.apache.hadoop.io.Text")

Spark on Yarn 集群运行要点的更多相关文章

- Spark on Yarn集群搭建

软件环境: linux系统: CentOS6.7 Hadoop版本: 2.6.5 zookeeper版本: 3.4.8 主机配置: 一共m1, m2, m3这五部机, 每部主机的用户名都为centos ...

- hadoop - spark on yarn 集群搭建

一.环境准备 1. 机器: 3 台虚拟机 机器 角色 l-qta3.sp.beta.cn0 NameNode,ResourceManager,spark的master l-querydiff1.sp ...

- 配置Spark on YARN集群内存

参考原文:http://blog.javachen.com/2015/06/09/memory-in-spark-on-yarn.html?utm_source=tuicool 运行文件有几个G大,默 ...

- 提交第一个spark作业到集群运行

写在前面 接触spark有一段时间了,但是一直都没有真正意义上的在集群上面跑自己编写的代码.今天在本地使用scala编写一个简单的WordCount程序.然后,打包提交到集群上面跑一下... 在本地使 ...

- spark on yarn 集群部署

概述 hadoop2.7.1 spark 1.5.1 192.168.31.62 resourcemanager, namenode, master 192.168.31.63 nodeman ...

- Spark程序提交到Yarn集群时所遇异常

Exception 1:当我们将任务提交给Spark Yarn集群时,大多会出现以下异常,如下: 14/08/09 11:45:32 WARN component.AbstractLifeCycle: ...

- Yarn 集群环境 HA 搭建

环境准备 确保主机搭建 HDFS HA 运行环境 步骤一:修改 mapred-site.xml 配置文件 [root@node-01 ~]# cd /root/apps/hadoop-3.2.1/et ...

- Flink 集群运行原理兼部署及Yarn运行模式深入剖析

1 Flink的前世今生(生态很重要) 原文:https://blog.csdn.net/shenshouniu/article/details/84439459 很多人可能都是在 2015 年才听到 ...

- 有关python numpy pandas scipy 等 能在YARN集群上 运行PySpark

有关这个问题,似乎这个在某些时候,用python写好,且spark没有响应的算法支持, 能否能在YARN集群上 运行PySpark方式, 将python分析程序提交上去? Spark Applicat ...

随机推荐

- api接口思路介绍

现在很流行api了,但各种api做法不一样,下面我整理了一些自己的想法,也是看了各大门户网站开放的api应用想到的,与大家分享分享,高手跳过. API(Application Programmin ...

- Burp Suite的使用介绍

在网上找了一篇关于Burp Suite的使用介绍,感觉写的基础的,下面就copy了,另外还有一篇<BurpSuite实战指南>的pdf是一位好心的“前辈”共享的https://www.gi ...

- 完全背包【p1832】A+B Problem(再升级)

Description 给定一个正整数n,求将其分解成若干个素数之和的方案总数. Input 一行:一个正整数n Output 一行:一个整数表示方案总数 素数之和 ? 背包啊. 没一遍切的题都不是水 ...

- noi题库 1.7 字符串 10到第15题

10:简单密码 描述 Julius Caesar曾经使用过一种很简单的密码.对于明文中的每个字符,将它用它字母表中后5位对应的字符来代替,这样就得到了密文.比如字符A用F来代替.如下是密文和明文中字符 ...

- POJ 1741 Tree (点分治)

Tree Time Limit: 1000MS Memory ...

- SHELL 在指定行的前/后插入指定内容

#如果知道行号可以用下面的方法 sed -i '88 r b.file' a.file #在a.txt的第88行插入文件b.txt awk '1;NR==88{system("cat ...

- Android的日志工具Log

Android中的日志工具类是Log(android.util.Log),这个类提供了以下几个方法来供我们打印日志. ♦ Log.v():这个方法用于打印那些最为琐碎的,意义最小的日志信息.对应级别v ...

- 面试问题Distilled

1. 你在项目里都用过哪些Spring的组件 2. Spring AOP的实现原理 3. Hibernate的乐观锁和悲观锁 4. Hibernate的缓存机制 5. 对SOA的了解和认识 6. 谈谈 ...

- [BZOJ 3233] 找硬币

Link: BZOJ 3233 传送门 Solution: 在本蒟蒻看来算是一道比较神的$dp$了 一开始转移方程都没看出来…… 首先,如果确定了最大面值,是能推出其他面值的所有可能值的 从而发现最大 ...

- Java高级架构师(一)第19节:X-gen生成相应的Visitor

package cn.javass.themes.smvcsm.visitors; import cn.javass.xgen.genconf.vo.ExtendConfModel; import c ...