Scrapy_redis

简介

scrapy_redis是一个基于Redis的Scrapy组件,用于scrapy项目的分布式部署和开发

你可以启动多个spider对象,互相之间共享有一个redis的request队列,最适合多个域名的广泛内容的爬取

特点

分布式爬取

分布式数据处理

爬取到的item数据被推送到redis中,这意味着你可以启动尽可能多的item处理程序

scrapy即插即用

scrapy调度程序+过滤器,项目管道,base spidre

安装

pip install scrapy-redis

使用

首先创建scrapy的项目

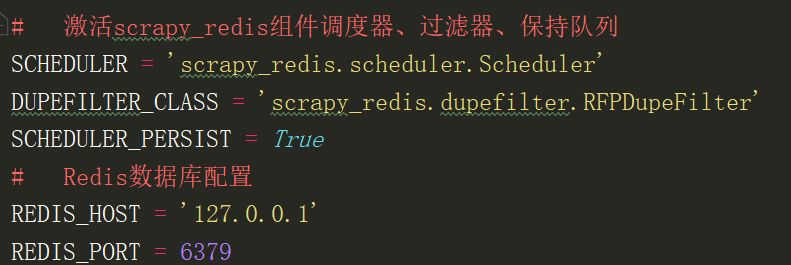

在settings修改默认的调度器和过滤

SCHEDULER = 'scrapy_redis.scheduler.Scheduler'

DUPEFILTER_CLASS = 'scrapy_redis.dupefilter.RFPDupeFilter'

SCHEDULER_PERSIST = True

在spider里面修改继承的类RedisSpider,属性redis_key

常用设置

# 启用调度将请求存储进redis SCHEDULER = "scrapy_redis.scheduler.Scheduler"

# 确保所有spider通过redis共享相同的重复过滤 DUPEFILTER_CLASS = "scrapy_redis.dupefilter.RFPDupeFilter"

# 不清理redis队列,允许暂停/恢复抓取 SCHEDULER_PERSIST = True

# 指定连接到Redis时要使用的主机和端口 REDIS_HOST = 'localhost'

REDIS_PORT = 6379

redis中存储的数据

spidername:items list类型,保存爬虫获取到的数据item内容是json字符串

spidername:dupefilter set类型,用于爬虫访问的URL去重,内容是40个字符的url的hash字符串

spidername:start_urls list类型,用于接收redisspider启动时的第一个url

spidername:requests zset类型,用于存放requests等待调度。内容是requests对象的序列化字符串

Scrapy_redis的更多相关文章

- scrapy分布式爬虫scrapy_redis二篇

=============================================================== Scrapy-Redis分布式爬虫框架 ================ ...

- scrapy分布式爬虫scrapy_redis一篇

分布式爬虫原理 首先我们来看一下scrapy的单机架构: 可以看到,scrapy单机模式,通过一个scrapy引擎通过一个调度器,将Requests队列中的request请求发给下载器,进行页 ...

- scrapy_redis 相关: 多线程更新 score/request.priority

0.背景 使用 scrapy_redis 爬虫, 忘记或错误设置 request.priority(Rule 也可以通过参数 process_request 设置 request.priority), ...

- scrapy_redis 相关: 查看保存的数据

0.参考资料 https://redis.io/topics/data-types-intro An introduction to Redis data types and abstractions ...

- scrapy_redis实现爬虫

1.scrapy_redis的流程 在scrapy_redis中,所有的带抓取的对象和去重的指纹都存在所有的服务器公用的redis中 所有的服务器公用一个redis中的request对象 所有的req ...

- scrapy_redis项目配置

一.创建普通scrapy项目 二.spiders爬虫文件中修改项 import scrapy from XX.items import XXItem import json # ----1 导入类 f ...

- scrapy和scrapy_redis入门

Scarp框架 需求 获取网页的url 下载网页内容(Downloader下载器) 定位元素位置, 获取特定的信息(Spiders 蜘蛛) 存储信息(ItemPipeline, 一条一条从管里走) 队 ...

- 定制起始url(scrapy_redis)

爬虫:(在这里不用配置start_url,直接可以取redis里面取start_url,可以多个) from scrapy_redis.spiders import RedisSpider # cla ...

- [置顶]使用scrapy_redis,自动实时增量更新东方头条网全站新闻

存储使用mysql,增量更新东方头条全站新闻的标题 新闻简介 发布时间 新闻的每一页的内容 以及新闻内的所有图片.项目文件结构. 这是run.py的内容 1 #coding=utf-8 2 from ...

- 使用scrapy_redis,实时增量更新东方头条网全站新闻

存储使用mysql,增量更新东方头条全站新闻的标题 新闻简介 发布时间 新闻的每一页的内容 以及新闻内的所有图片.东方头条网没有反爬虫,新闻除了首页,其余板块的都是请求一个js.抓包就可以看到. 项目 ...

随机推荐

- Leetcode92: Reverse Linked List II 翻转链表问题

问题描述 给定一个链表,要求翻转其中从m到n位上的节点,返回新的头结点. Example Input: 1->2->3->4->5->NULL, m = 2, n = 4 ...

- Xposed反射字段流程分析

在XposedBridge源码中,反射字段的方法封装在de.robv.android.xposed.XposedHelpers类里面.下面来看看Xposed是如何获取和设置字段的值的 获取字段的值 获 ...

- PHP-FPM 使用(含多站点多端口)

PHP-FPM 使用 PHP-FPM 是在 Linux 环境下用来管理调度 PHP 执行的调度器,源码安装时会自动安装,PHP 安装可参考Centos 下安装 PHP (新) 查看版本 # php-f ...

- 收藏收藏:工作用了很久的自主开发的Sql Server代码生成器,我开源了(.NET Winform)

大家好,已经一年没见了,我的技术已经有了惊人的进步.于是乎就来为大家分享技术了,今天呢为大家带来的是很早之前开发的老工具分享给大家. 相信大家都使用过代码生成器,用起来顺手的有多少?根据自己的业务配置 ...

- Dynamics 365需要的最小的权限用来更改用户的业务部门和角色

我是微软Dynamics 365 & Power Platform方面的工程师罗勇,也是2015年7月到2018年6月连续三年Dynamics CRM/Business Solutions方面 ...

- leaflet-webpack 入门开发系列四图层控件样式优化篇(附源码下载)

前言 leaflet-webpack 入门开发系列环境知识点了解: node 安装包下载webpack 打包管理工具需要依赖 node 环境,所以 node 安装包必须安装,上面链接是官网下载地址 w ...

- September 15th, 2019. Sunday, Week 38th.

Break down these walls and come on in. 一路披荆斩棘,勇往直前. We are the only wall that stands in our way to s ...

- 《Web Development with Go》Mangodb查询collection内所有记录

相当于select * from table; package main import ( "fmt" "log" "time" " ...

- [洛谷P1169][题解][ZJOI2007]棋盘制作

我不是题目的说 这道题运用了一种很巧妙的DP方式:悬线法 如图,蓝色为悬线,黄色为向两边延伸的长度 那么显然,最大子矩形的宽一定是这些黄线中最小的(证明从略) 所以我们可以维护三个数组: Up[i][ ...

- linux上安装jenkins过程

最近在学到jenkins分布式构建时,需要一台部署jenkins的主机服务器master,自己用的win10作为slave,所以我想在虚拟机上先部署jenkins. centos还是ubuntu呢,算 ...