jieba的使用

1. 分词

分词是自然语言处理中最基础的一个步骤。而jieba分词是中文分词的一个比较好的工具。下面看看可以怎么用jieba进行分词。

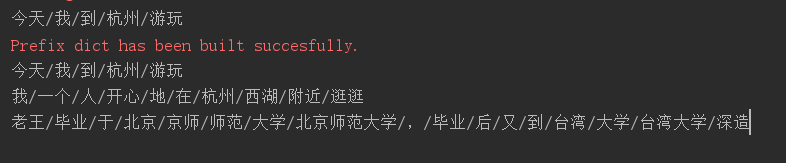

import jieba # 全模式

seg_list1 = jieba.cut('今天我到杭州游玩', cut_all= True)

print('/'.join(seg_list1)) # 精确模式

seg_list2 = jieba.cut('今天我到杭州游玩', cut_all= False)

print('/'.join(seg_list2)) # 默认是精确模式

seg_list4 = jieba.cut('我一个人开心地在杭州西湖附近逛逛')

print('/'.join(seg_list4)) # 搜索引擎模式

seg_list3 = jieba.cut_for_search('老王毕业于北京师范大学,毕业后又到台湾大学深造')

print('/'.join(seg_list3))

结果:

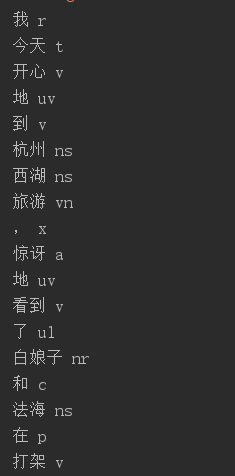

2. 词性识别

import jieba.posseg as psg s = '我今天开心地到杭州西湖旅游,惊讶地看到了白娘子和法海在打架' words = psg.cut(s)

for word, flag in words:

print(word, flag)

结果:

有关于词性识别,还是比较重要的。一般我们识别一句话或一段话,首先要提取的是这句话的主语谓语宾语,接着是形容词等,进而提取有用的情感信息内容。

jieba的使用的更多相关文章

- 中文分词工具探析(二):Jieba

1. 前言 Jieba是由fxsjy大神开源的一款中文分词工具,一款属于工业界的分词工具--模型易用简单.代码清晰可读,推荐有志学习NLP或Python的读一下源码.与采用分词模型Bigram + H ...

- jieba.NET与Lucene.Net的集成

首先声明:我对Lucene.Net并不熟悉,但搜索确实是分词的一个重要应用,所以这里还是尝试将两者集成起来,也许对你有一参考. 看到了两个中文分词与Lucene.Net的集成项目:Lucene.Net ...

- jieba中文分词的.NET版本:jieba.NET

简介 平时经常用Python写些小程序.在做文本分析相关的事情时免不了进行中文分词,于是就遇到了用Python实现的结巴中文分词.jieba使用起来非常简单,同时分词的结果也令人印象深刻,有兴趣的可以 ...

- jieba分词

一.安装 pip 安装 或者 先下载http://pypi.python.org/pypi/jieba/ ,解压后运行python setup.py install 二.功能 1.分词 2.添加自定义 ...

- jieba中文分词(python)

问题小结 1.安装 需要用到python,根据python2.7选择适当的安装包.先下载http://pypi.python.org/pypi/jieba/ ,解压后运行python setup.py ...

- [测]jieba分词

import jieba import os import jieba.analyse with open('src.txt', 'r') as file: data = file.read() se ...

- jieba

# coding: utf-8 # ###jieba特性介绍 # 支持三种分词模式: # 精确模式,试图将句子最精确地切开,适合文本分析: # 全模式,把句子中所有的可以成词的词语都扫描出来, 速度非 ...

- widows下jieba分词的安装

在切词的时候使用到jieba分词器,安装如下: 切入到结巴包,执行 python setup.py install 安装后,可以直接在代码中引用: import jieba

- 【原】关于使用jieba分词+PyInstaller进行打包时出现的一些问题的解决方法

错误现象: 最近在做一个小项目,在Python中使用了jieba分词,感觉非常简洁方便.在Python端进行调试的时候没有任何问题,使用PyInstaller打包成exe文件后,就会报错: 错误原因分 ...

- .net 的一个分词系统(jieba中文分词的.NET版本:jieba.NET)

简介 平时经常用Python写些小程序.在做文本分析相关的事情时免不了进行中文分词,于是就遇到了用Python实现的结巴中文分词.jieba使用起来非常简单,同时分词的结果也令人印象深刻,有兴趣的可以 ...

随机推荐

- [UWP]使用CompositionGeometricClip裁剪复杂图形及进行动画

1. UWP中的其它裁剪方案 之前在 这篇文章 里,我介绍了如何使用UIElement.Clip裁剪UIElement的内容,使用代码如下: <Canvas> <Image Sour ...

- iOS 基本控件的使用以及系统层次架构(1)

User Interface iOS系统架构层次图 -CocoaTouch UI相关 -媒体层(Media) 音频.视频.图形.动画 -核心服务层(Core services) 内存.网络.文件.线 ...

- 源码分析—ThreadPoolExecutor线程池三大问题及改进方案

前言 在一次聚会中,我和一个腾讯大佬聊起了池化技术,提及到java的线程池实现问题,我说这个我懂啊,然后巴拉巴拉说了一大堆,然后腾讯大佬问我说,那你知道线程池有什么缺陷吗?我顿时哑口无言,甘拜下风,所 ...

- [TimLinux] JavaScript input框的onfocus/onblur/oninput/onchange事件介绍

1. onfocus事件 input框获取到焦点时,触发了该事件,比如获取到焦点时,修改input框的背景色.这个功能其实可以使用css的伪类:focus来定义. 2. onblur事件 这个与onf ...

- HDU1846 Brave Game(巴什博弈)

十年前读大学的时候,中国每年都要从国外引进一些电影大片,其中有一部电影就叫<勇敢者的游戏>(英文名称:Zathura),一直到现在,我依然对于电影中的部分电脑特技印象深刻. 今天,大家选择 ...

- io流函数略解(java_input流)[二]

背景 在写这篇随笔之前,已经写了io流函数略解(java_File)(一),主要是总结了File的一些操作,以及一些源码介绍. 在Io实际应用中,实际上运用在如果会操作File,实际上很难写出一点能实 ...

- ARTS-S golang goroutines and channels(二)

向tcp服务端发消息 package main import ( "io" "log" "net" "os" ) fun ...

- Redis 使用消息隊列

關鍵函數 ListRightPush 生產消息 ListRightPop 消費消息 這是從右面增或取 左邊亦然

- Day 06 流程控制和爬虫基础2

目录 if 判断 单分支结构 双分支结构 多分支结构 for循环 for循环的基本用法 for循环嵌套 break continue 爬虫基础2 爬取豆瓣TOP250 爬取豆瓣数据接口(异步数据) 爬 ...

- 超简单!asp.net core前后端分离项目使用gitlab-ci持续集成到IIS

现在好多使用gitlab-ci的持续集成的教程,大部分都是发布到linux系统上的,但是目前还是有很大一部分企业使用的都是windows系统使用IIS在部署.NET应用程序.这里写一下如何使用gitl ...