Ceph添加、删除osd及故障硬盘更换

添加或删除osd均在ceph部署节点的cent用户下的ceph目录进行。

1. 添加osd

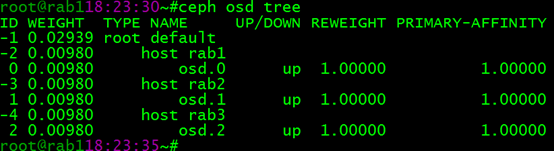

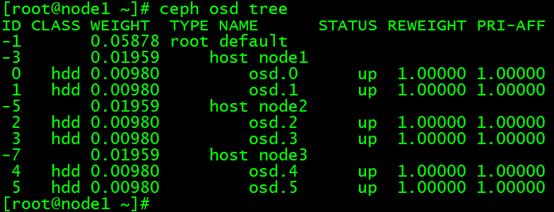

当前ceph集群中有如下osd,现在准备新添加osd:

(1)选择一个osd节点,添加好新的硬盘:

(2)显示osd节点中的硬盘,并重置新的osd硬盘:

列出节点磁盘:

ceph-deploy disk list rab1

擦净节点磁盘:

ceph-deploy disk zap rab1 /dev/sbd(或者)ceph-deploy disk zap rab1:/dev/vdb1

(3)准备Object Storage Daemon:

ceph-deploy osd prepare rab1:/var/lib/ceph/osd1

(4)激活Object Storage Daemon:

ceph-deploy osd activate rab1:/var/lib/ceph/osd1

2. 删除osd

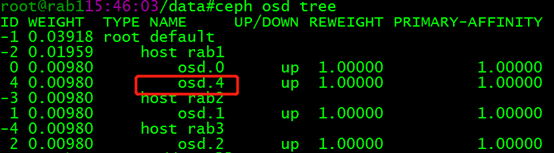

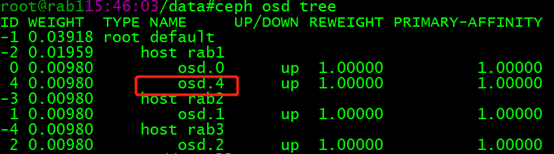

现在要将 rab1中的 osd.4 删除:

(1)把 OSD 踢出集群

ceph osd out osd.

(2)在相应的节点,停止ceph-osd服务

systemctl stop ceph-osd@.service

systemctl disable ceph-osd@.service

(3)删除 CRUSH 图的对应 OSD 条目,它就不再接收数据了

ceph osd crush remove osd.4

(4)删除 OSD 认证密钥

ceph auth del osd.

(5)删除osd.4

ceph osd rm osd.

3. ceph osd故障硬盘更换

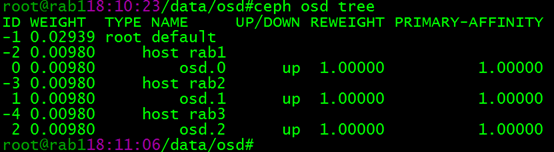

正常状态:

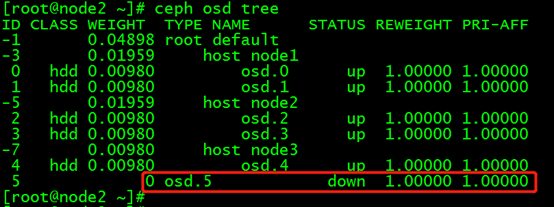

故障状态:

实施更换步骤:

(1)关闭ceph集群数据迁移:

osd硬盘故障,状态变为down。在经过mod osd down out interval 设定的时间间隔后,ceph将其标记为out,并开始进行数据迁移恢复。为了降低ceph进行数据恢复或scrub等操作对性能的影响,可以先将其暂时关闭,待硬盘更换完成且osd恢复后再开启:

for i in noout nobackfill norecover noscrub nodeep-scrub;do ceph osd set $i;done

(2)定位故障osd

ceph osd tree | grep -i down

(3)进入osd故障的节点,卸载osd挂载目录

[root@node3 ~]# umount /var/lib/ceph/osd/ceph-

(4)从crush map 中移除osd

[root@node1 ~]# ceph osd crush remove osd.

removed item id name 'osd.5' from crush map

(5)删除故障osd的密钥

[root@node1 ~]# ceph auth del osd.

updated

(6)删除故障osd

[root@node1 ~]# ceph osd rm

removed osd.

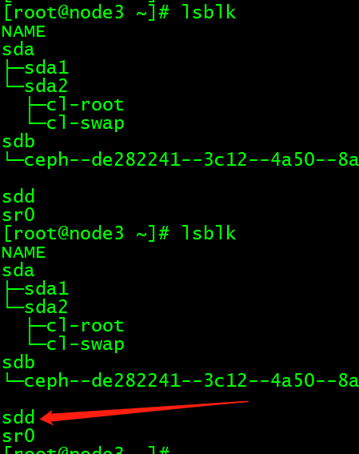

(7)更换完新硬盘后,注意新硬盘的盘符,并创建osd

(8)在部署节点,切换为cent用户,添加新的osd

[cent@deploy ceph]$ ceph-deploy osd create --data /dev/sdd node3

(9)待新osd添加crush map后,重新开启集群禁用标志

for i in noout nobackfill norecover noscrub nodeep-scrub;do ceph osd unset $i;done

ceph集群经过一段时间的数据迁移后,恢复active+clean状态

Ceph添加、删除osd及故障硬盘更换的更多相关文章

- 分布式存储ceph——(4)ceph 添加/删除osd

一.添加osd: 当前ceph集群中有如下osd,现在准备新添加osd:

- ceph添加/删除OSD

一.添加osd: 当前ceph集群中有如下osd,现在准备新添加osd: (1)选择一个osd节点,添加好新的硬盘: (2)显示osd节点中的硬盘,并重置新的osd硬盘: 列出节点磁盘:ceph-de ...

- 分布式存储ceph——(5)ceph osd故障硬盘更换

正常状态:

- Ceph osd故障硬盘更换

正常状态: 故障状态: 实施更换步骤: (1)关闭ceph集群数据迁移: osd硬盘故障,状态变为down.在经过mod osd down out interval 设定的时间间隔后,ceph将其标记 ...

- 分布式存储ceph---ceph osd 故障硬盘更换(6)

正常状态: 故障状态: 实施更换步骤: 1.关闭ceph集群数据迁移: osd硬盘故障,状态变为down.在经过mod osd down out interval 设定的时间间隔后,ceph将其标记为 ...

- 分布式存储ceph--osd故障硬盘更换(6)

正常状态:

- 分布式存储ceph---ceph添加/删除osd(5)

一.添加osd 当前ceph集群中有如下osd,现在准备新添加osd: 1.选择一个osd节点,添加好新的硬盘: 2.显示osd节点中的硬盘,并重置新的osd硬盘: 列出节点磁盘:ceph-deplo ...

- Ceph添加/删除Mon(ceph.conf)

操作环境 ceph 0.87.7 Openstack liberty ubuntu 14.04 当前ceph配置文件如下 [global]fsid = c010eb34-ccc6-458d-9a03- ...

- UNIX故障--sun m4000服务器故障硬盘更换案例

一.故障诊断 查看messages日志c0d0t0这块盘不断报错,类型为:retryable,如下: root@gdhx # more /var/adm/messages Aug 5 16:43:0 ...

随机推荐

- win7安装 nodejs,npm

1. 下载地址:http://nodejs.org/dist/v9.7.1/ 2. 安装 3. 查看是否安装成功,命令行查询 node -v 4. 默认已经安装了npm,直接查询版本 5. 配置np ...

- electron+vue实现菜单栏

公司开发的产品都是用c++写的,而且还都是几个人,老板想搞下创新,就是看看能否通过其它的方式来实现前后端分离.然后我就了解到了electron这个东西,之前学安卓的时候看到过flutter,不经意间看 ...

- SGU 128. Snake --- 暴力枚举+并查集+贪心+计算几何

<传送门> 128. Snake time limit per test: 0.25 sec. memory limit per test: 4096 KB There are N poi ...

- FORMAT 的用法

https://www.cnblogs.com/gaodu2003/archive/2008/12/22/1359927.html Format 格式指令具有以下的形式:"%" [ ...

- Django-07-Model操作

一.数据库的配置 1. 数据库支持 django默认支持sqlite.mysql.oracle.postgresql数据库 <1> sqlite django默认使用sqlite的数据库 ...

- golang使用json格式实现增删查改

需求和思路 在一般的小项目或者一个小软件,例如客户端之类的小程序中,可能会需要数据的持久化.但是使用一般的数据库(Mysql)之类的不合适.使用sqlite3这种嵌入式的是个较好的方法,但是Go语言中 ...

- 【LEETCODE】69、动态规划,easy,medium级别,题目:198、139、221

package y2019.Algorithm.dynamicprogramming.easy; /** * @ProjectName: cutter-point * @Package: y2019. ...

- python递归函数和河内塔问题

关于递归函数: 函数内部调用自身的函数. 以n阶乘为例: f(n) = n ! = 1 x 2 x 3 x 4 x...x(n-1)x(n) = n x (n-1) ! def factorial(n ...

- 小程序canvas绘制base64数据格式图片

翻了微信小程序官方文档,看了看画板drawImage的用法,官方对所要绘制的图片资源路径并没有很详细,模棱两可,没说支持什么格式的路径.今天我就试一下支不支持base64格式的图片 随便找张图片从网上 ...

- kafka学习笔记(二)——基础入门

1.集群规划 从官网下载jar包 http://kafka.apache.org/downloads.html,我选择的是kafka_2.11-0.11.0.0.tgz版本 规划一下集群环境先~ ha ...