容错(Fault-tolerance)

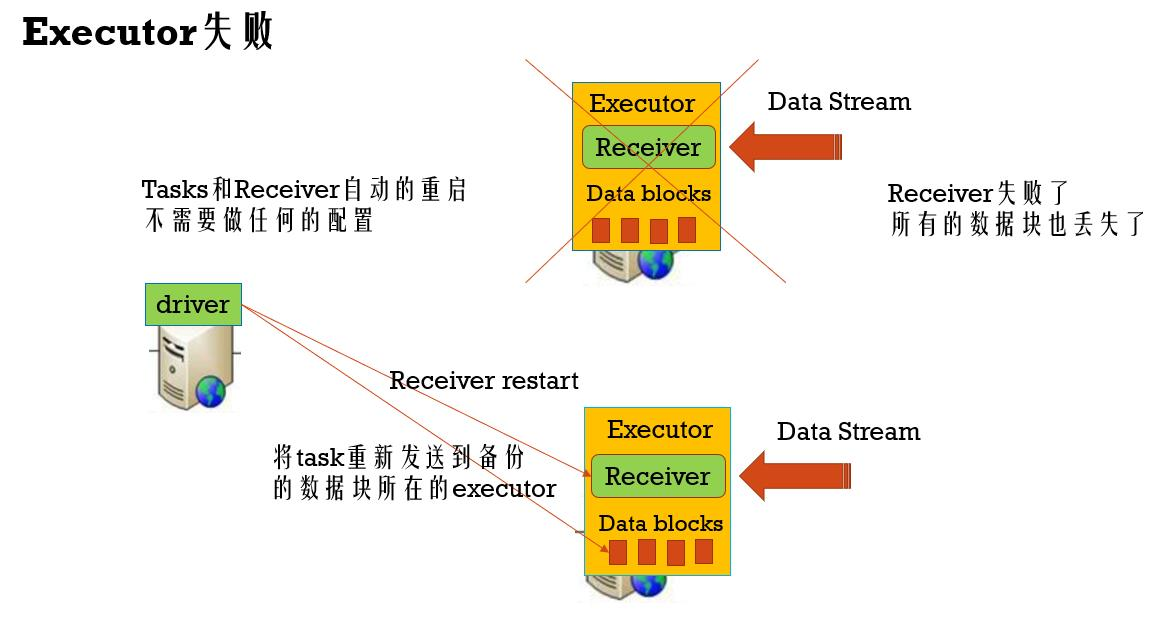

Executor失败容错

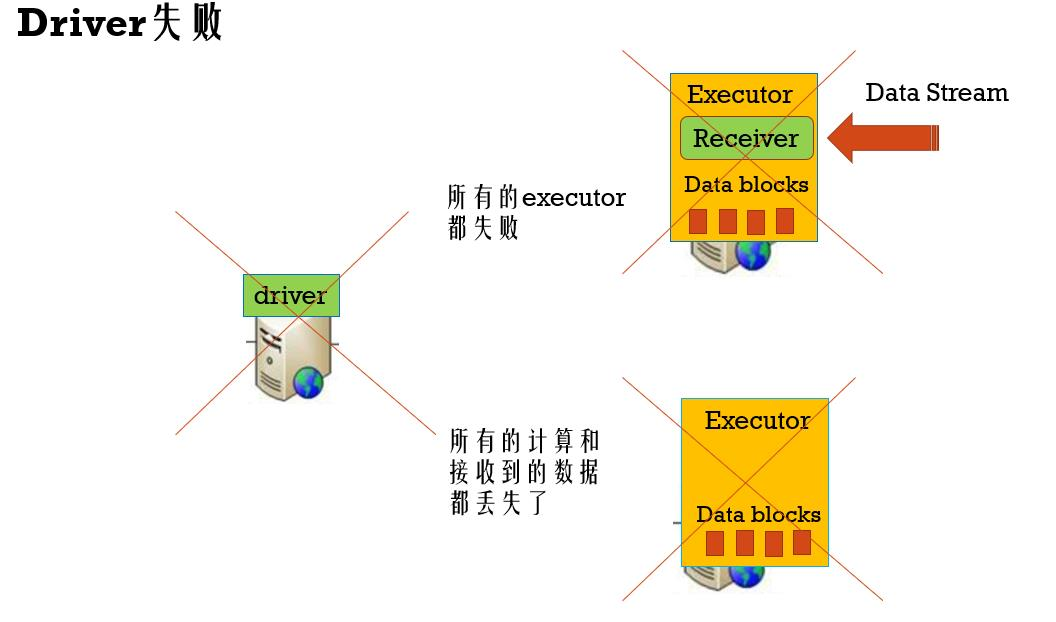

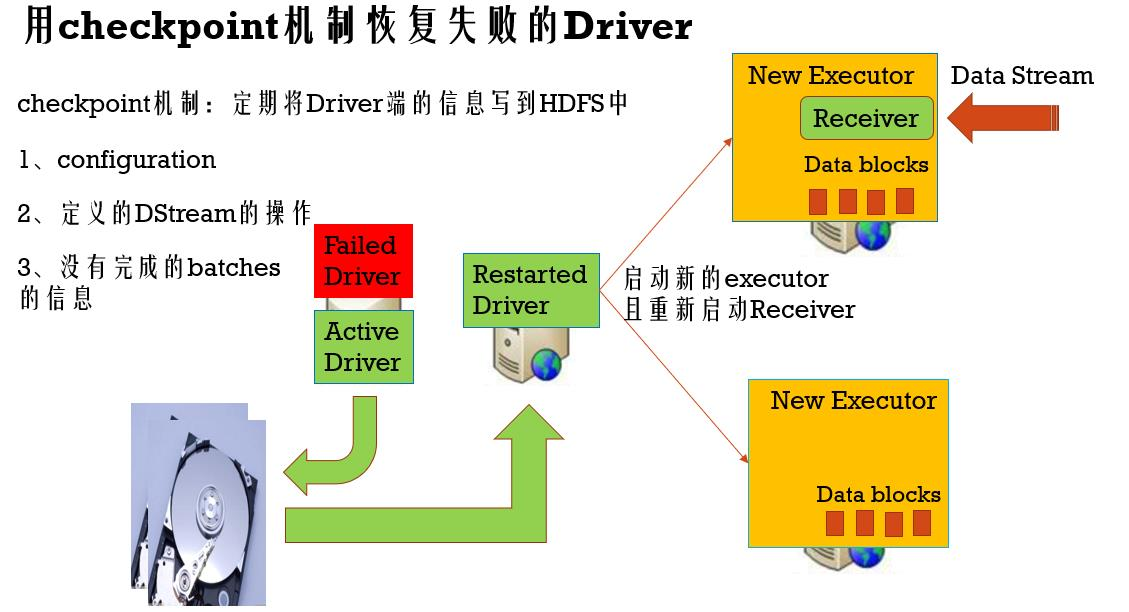

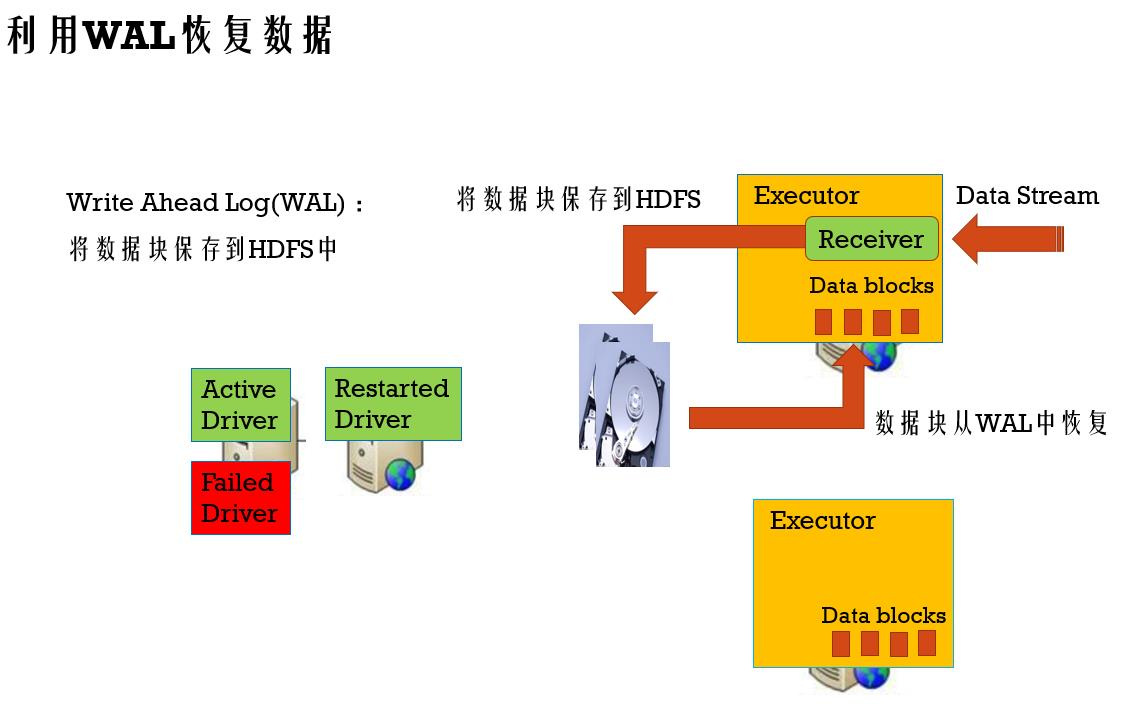

Driver失败容错

import org.apache.spark.storage.StorageLevel

import org.apache.spark.streaming.{Seconds, StreamingContext}

import org.apache.spark.{SparkConf, SparkContext} /**

* WordCount程序,Spark Streaming消费TCP Server发过来的实时数据的例子:

*

* 1、在master服务器上启动一个Netcat server

* `$ nc -lk 9998` (如果nc命令无效的话,我们可以用yum install -y nc来安装nc)

*

* 2、用下面的命令在在集群中将Spark Streaming应用跑起来

* spark-submit --class com.twq.wordcount.JavaNetworkWordCount \

* --master spark://master:7077 \

* --deploy-mode cluster \

* --driver-memory 512m \

* --executor-memory 512m \

* --total-executor-cores 4 \

* --executor-cores 2 \

* /home/hadoop-twq/spark-course/streaming/spark-streaming-basic-1.0-SNAPSHOT.jar

*/

object NetworkWordCount {

def main(args: Array[String]) { val checkpointDirectory = "hdfs://master:9999/user/hadoop-twq/spark-course/streaming/chechpoint" def functionToCreateContext(): StreamingContext = {

val sparkConf = new SparkConf()

.setAppName("NetworkWordCount")

val sc = new SparkContext(sparkConf) // Create the context with a 1 second batch size

val ssc = new StreamingContext(sc, Seconds(1)) //创建一个接收器(ReceiverInputDStream),这个接收器接收一台机器上的某个端口通过socket发送过来的数据并处理

val lines = ssc.socketTextStream("master", 9998, StorageLevel.MEMORY_AND_DISK_SER_2)// 提高数据块的高可用性,备份两份,但会占用一定的内存 //处理的逻辑,就是简单的进行word count

val words = lines.flatMap(_.split(" "))

val wordCounts = words.map(x => (x, 1)).reduceByKey(_ + _) //将结果输出到控制台

wordCounts.print()

ssc.checkpoint(checkpointDirectory)

ssc

}

// 代码

val ssc = StreamingContext.getOrCreate(checkpointDirectory, functionToCreateContext _) //启动Streaming处理流

ssc.start() //等待Streaming程序终止

ssc.awaitTermination()

}

}

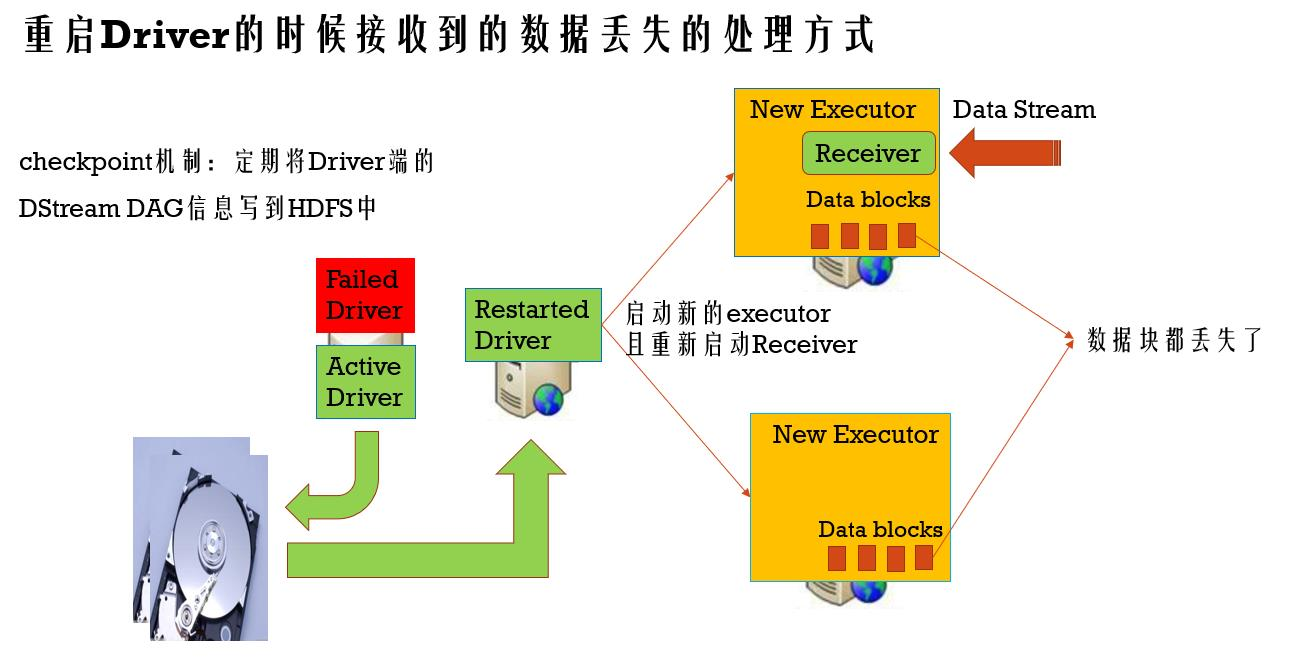

接收到的数据丢失的容错

checkpoint机制:定期将Driver端的DStream DAG信息写到HDFS中(写内存和写磁盘同时进行)

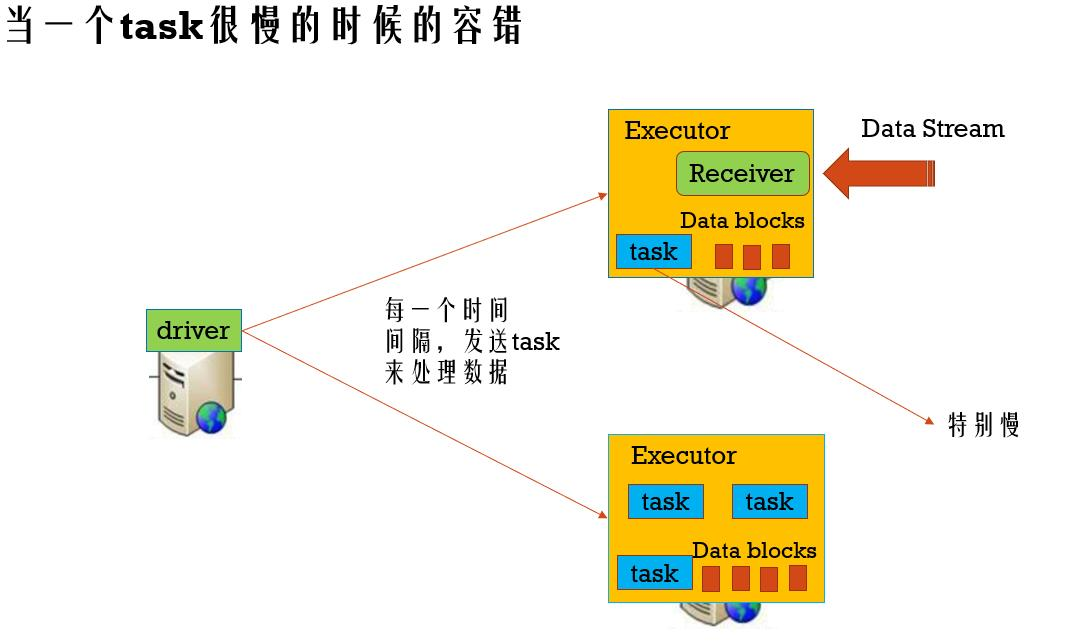

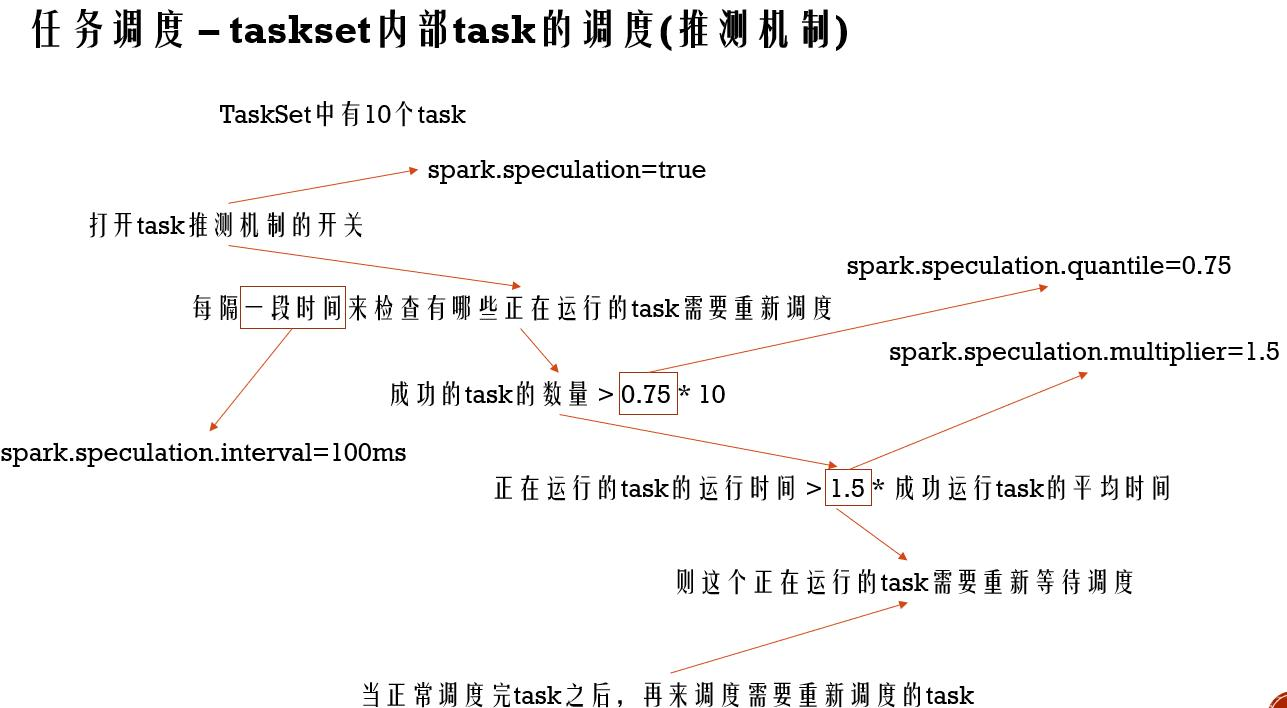

当一个task很慢的容错

容错(Fault-tolerance)的更多相关文章

- Flink Program Guide (7) -- 容错 Fault Tolerance(DataStream API编程指导 -- For Java)

false false false false EN-US ZH-CN X-NONE /* Style Definitions */ table.MsoNormalTable {mso-style-n ...

- Fault Tolerance —— Storm的故障容错性

——本文讲解了Storm故障容忍性(Fault-Tolerance)的设计细节:当Worker.节点.Nimbus或者Supervisor出现故障时是如何实现故障容忍性,以及Nimbus是否存在单点 ...

- Flink Program Guide (9) -- StateBackend : Fault Tolerance(Basic API Concepts -- For Java)

State Backends 本文翻译自文档Streaming Guide / Fault Tolerance / StateBackend ----------------------------- ...

- VMware vSphere服务器虚拟化实验十一高可用性之三Fault Tolerance

VMware vSphere服务器虚拟化实验十一高可用性之三Fault Tole ...

- VMware Fault Tolerance 概述及功能

VMware Fault Tolerance - 为您的应用程序提供全天候可用性 通过为虚拟机启用 VMware Fault Tolerance,最大限度地延长数据中心的正常运行时间,减少停机管理成本 ...

- Flink Program Guide (8) -- Working with State :Fault Tolerance(DataStream API编程指导 -- For Java)

Working with State 本文翻译自Streaming Guide/ Fault Tolerance / Working with State ---------------------- ...

- Storm系列之三——Fault Tolerance

本文介绍Storm容错的设计细节. 1.当一个worker进程死了会发生什么? 当worker死了,supervisor会重启它.如果它尝试开启多次失败并且不能与nimbus发送心跳,Nimbus会重 ...

- Storm介绍(二)

作者:Jack47 转载请保留作者和原文出处 欢迎关注我的微信公众账号程序员杰克,两边的文章会同步,也可以添加我的RSS订阅源. 本文是Storm系列之一,主要介绍Storm的架构设计,推荐读者在阅读 ...

- JSP之WEB服务器:Apache与Tomcat的区别 ,几种常见的web/应用服务器

注意:此为2009年的blog,注意时效性(针对常见服务器) APACHE是一个web服务器环境程序 启用他可以作为web服务器使用 不过只支持静态网页 如(asp,php,cgi,jsp)等 ...

- WEB服务器、应用程序服务器、HTTP服务器区别

很清晰的解释了WEB服务器.应用程序服务器.HTTP服务器区别 转载自 http://www.cnblogs.com/zhaoyl/archive/2012/10/10/2718575.html WE ...

随机推荐

- springmvc+spring+mybatis的整合(推荐新手看看)

下面开始整合(由于有点多就不一一介绍了) 配置sqlMapConfig.xml(空文件即可) <?xml version="1.0" encoding="UTF-8 ...

- chamfer_pcd

import tensorflow as tf import numpy as np def distance_matrix(array1, array2): """ a ...

- [十一集训] Day1 (2018-2019 ACM-ICPC Nordic Collegiate Programming Contest (NCPC 2018))

A Altruistic Amphibians 原题 题目大意: n只青蛙在高度为d的井中,每只有跳跃距离.重量和高度,每只青蛙可以借助跳到别的青蛙的背上而跳出井,每只青蛙能承受的最大重量是自身重量, ...

- c++连接打印机(转载)

Visual C++6.0是开发Windows应用程序的强大工具,但是要通过它实现程序的打印功能,一直是初学者的一个难点,经常有朋友询问如何在VC中实现打印功能,他们往往感到在MFC提供的框架内实现这 ...

- zap+日志分级分文件+按时间切割日志整合demo

实现功能 info debug 级别的日志输出到 /path/log/demo.log warn error .... 级别的日志输出到 /path/log/demo_error.lo ...

- 关于python、pip、anaconda安装的一些记录

写这篇博客是因为自己这段时间总是倒腾python的环境,其间倒腾崩了好几次.....无奈之下还是梳理一下. PYTHON 首在安装python3.6的之后,我安装了anaconda3,这样我的电脑上p ...

- resnet的理解-- 面试笔记

上周参加了XX大学研究生推免的面试,面试老爷问到了resnet主要解决了什么问题,我下意识的回答到解决了当网络加深的时候会出现的vanishing/exploding gradients,然后面试老爷 ...

- 分享大麦UWP版本开发历程-03.GridView或ListView 滚动底部自动加载后续数据

今天跟大家分享的是大麦UWP客户端,在分类.订单或是搜索时都用到的一个小技巧,技术粗糙大神勿喷. 以大麦分类举例,默认打开的时候,会为用户展示20条数据,当用户滚动鼠标或者使用手势将列表滑动到倒数第二 ...

- 1.ASP.NET Core介绍

优点: 1.跨平台,高性能,开源,运行在.Net Core 或.Net Framework框架上(asp.net core 3.0及以后只支持.Net Core). 2.各平台上开发工具支持,能够开发 ...

- Python接口自动化基础---环境准备

安装requests模块 pip install requests request帮助文档查看 import requests print(help(requests)) Help on packag ...