Hadoop源码分析之产生InputSplit文件过程

static {

try {

META_SPLIT_FILE_HEADER = "META-SPL".getBytes("UTF-8");

} catch (UnsupportedEncodingException u) {

throw new RuntimeException(u);

}

}

public static final TaskSplitMetaInfo EMPTY_TASK_SPLIT = new TaskSplitMetaInfo();

.png)

private long startOffset:该InputSplit在job.split文件中的偏移量

private long inputDataLength:该 InputSplit 的长度

private String[] locations:该 InputSplit 所在的host 列表

.png)

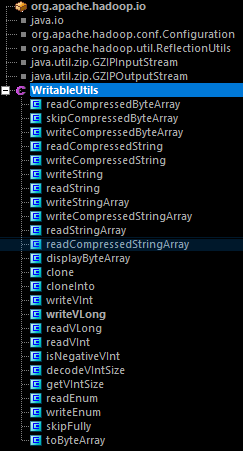

public void readFields(DataInput in) throws IOException {

int len = WritableUtils.readVInt(in);

locations = new String[len];

for (int i = 0; i < locations.length; i++) {

locations[i] = Text.readString(in);

}

startOffset = WritableUtils.readVLong(in);

inputDataLength = WritableUtils.readVLong(in);

}

public void write(DataOutput out) throws IOException {

WritableUtils.writeVInt(out, locations.length);

for (int i = 0; i < locations.length; i++) {

Text.writeString(out, locations[i]);

}

WritableUtils.writeVLong(out, startOffset);

WritableUtils.writeVLong(out, inputDataLength);

}

public interface Writable {

/**

* Serialize the fields of this object to <code>out</code>.

*

* @param out <code>DataOuput</code> to serialize this object into.

* @throws IOException

*/

void write(DataOutput out) throws IOException;

/**

* Deserialize the fields of this object from <code>in</code>.

*

* <p>For efficiency, implementations should attempt to re-use storage in the

* existing object where possible.</p>

*

* @param in <code>DataInput</code> to deseriablize this object from.

* @throws IOException

*/

void readFields(DataInput in) throws IOException;

private TaskSplitIndex splitIndex:Split元信息在 jib.split 文件中的位置

private long inputDataLength:InputSplit的数据长度

private String[] locations:InputSplit所在的host列表

private String splitLocation:job.split文件的位置

private long startOffset:InputSplit在 job.split 文件中的位置

public void readFields(DataInput in) throws IOException {

splitLocation = Text.readString(in);

startOffset = WritableUtils.readVLong(in);

}

public void write(DataOutput out) throws IOException {

Text.writeString(out, splitLocation);

WritableUtils.writeVLong(out, startOffset);

}

Hadoop源码分析之产生InputSplit文件过程的更多相关文章

- hadoop源码分析(2):Map-Reduce的过程解析

一.客户端 Map-Reduce的过程首先是由客户端提交一个任务开始的. 提交任务主要是通过JobClient.runJob(JobConf)静态函数实现的: public static Runnin ...

- Hadoop源码分析(1):HDFS读写过程解析

一.文件的打开 1.1.客户端 HDFS打开一个文件,需要在客户端调用DistributedFileSystem.open(Path f, int bufferSize),其实现为: public F ...

- Hadoop源码分析之数据节点的握手,注册,上报数据块和心跳

转自:http://www.it165.net/admin/html/201402/2382.html 在上一篇文章Hadoop源码分析之DataNode的启动与停止中分析了DataNode节点的启动 ...

- angular源码分析:injector.js文件分析——angular中的依赖注入式如何实现的(续)

昨天晚上写完angular源码分析:angular中jqLite的实现--你可以丢掉jQuery了,给今天定了一个题angular源码分析:injector.js文件,以及angular的加载流程,但 ...

- SpringBoot源码分析之SpringBoot的启动过程

SpringBoot源码分析之SpringBoot的启动过程 发表于 2017-04-30 | 分类于 springboot | 0 Comments | 阅读次数 SpringB ...

- Envoy 源码分析--程序启动过程

目录 Envoy 源码分析--程序启动过程 初始化 main 入口 MainCommon 初始化 服务 InstanceImpl 初始化 启动 main 启动入口 服务启动流程 LDS 服务启动流程 ...

- Spring源码分析专题 —— IOC容器启动过程(上篇)

声明 1.建议先阅读<Spring源码分析专题 -- 阅读指引> 2.强烈建议阅读过程中要参照调用过程图,每篇都有其对应的调用过程图 3.写文不易,转载请标明出处 前言 关于 IOC 容器 ...

- Spring源码分析之Bean的创建过程详解

前文传送门: Spring源码分析之预启动流程 Spring源码分析之BeanFactory体系结构 Spring源码分析之BeanFactoryPostProcessor调用过程详解 本文内容: 在 ...

- Hadoop源码分析之Configuration

转自:http://www.it165.net/admin/html/201312/2178.html org.apache.hadoop.conf.Configuration类是Hadoop所有功能 ...

随机推荐

- 12-18Windows窗体应用小程序之记事本(1)

一.记事本制作(1) C#结合窗体制作小程序,相比较之前的控制台应用程序可能要改善了好多,最起码界面看起来可以高仿一下了,但是最重要的还是要看其里面的功能是否实现.所以,要以实现其实用功能为主.今天利 ...

- Tomcat 不能正常启动

启动过程提示: Stopping ProtocolHandler ["http-bio-8080"] the JRE_HOME environment variable is no ...

- ffmpeg/ffplay源码剖析笔记<转>

转载:http://www.cnblogs.com/azraelly/ http://www.cnblogs.com/azraelly/archive/2013/01/18/2865858.html ...

- DAY19-上传头像并预览

一个简单的注册页面: <!DOCTYPE html> <html lang="en"> <head> <meta charset=&quo ...

- [patl2-014]列车调度

解题关键:由Dilworth定理(最小反链划分 == 最长链)可知最少的下降序列个数就等于整个序列最长上升子序列的长度,此题即转化为求最长上升子序列的长度. #include<cstdio> ...

- oracle行转列练习

----------------------第一题--------------------------- create table STUDENT_SCORE ( name ), subject ), ...

- 我们为什么要在C++中使用虚函数

类中的成员函数分为静态成员函数和非静态成员函数,而非静态成员函数又分为普通函数和虚函数. 至于为什么虚函数必须是非静态成员函数,可以看一下:http://blog.csdn.net/leiming32 ...

- MySql 5.7中添加用户,新建数据库,用户授权,删除用户,修改密码

转自http://blog.csdn.net/w690333243/article/details/76576952 1.新建用户 创建test用户,密码是1234. MySQL -u root -p ...

- 在Ubuntu里安装Mysql5.7.23

准备在Linux里安装Mysql,安装过程中遇到很多问题,这里记录下我成功安装的过程. 操作系统:Ubuntu 18.04 数据库:Mysql 5.7.23 安装步骤: 1.下载一个apt,下载mys ...

- 动态tab页

1.前台代码 <%-- builed by manage.aspx.cmt [ver:2015.25.26] at 2015-06-26 15:25:42 --%> <%@ Pag ...