cookie操作和代理

cookie操作

爬取豆瓣个人主页

# -*- coding: utf-8 -*-

import scrapy class DoubanSpider(scrapy.Spider):

name = 'douban'

#allowed_domains = ['www.douban.com']

start_urls = ['https://www.douban.com/accounts/login'] #重写start_requests方法

def start_requests(self):

#将请求参数封装到字典

data = {

'source': 'index_nav',

'form_email': '',

'form_password': 'bobo@15027900535'

}

for url in self.start_urls:

yield scrapy.FormRequest(url=url,formdata=data,callback=self.parse)

#针对个人主页页面数据进行解析操作

def parseBySecondPage(self,response):

fp = open('second.html', 'w', encoding='utf-8')

fp.write(response.text) #可以对当前用户的个人主页页面数据进行指定解析操作 def parse(self, response):

#登录成功后的页面数据进行存储

fp = open('main.html','w',encoding='utf-8')

fp.write(response.text) #获取当前用户的个人主页

url = 'https://www.douban.com/people/185687620/'

yield scrapy.Request(url=url,callback=self.parseBySecondPage)

因为要进行登录操作,所以一定要使用post请求进行表单提交,那么就必须重写start_requests()方法;观察代码就可以发现,当登录成功之后再次请求个人主页,不再需要

刻意地处理cookie,那是因为scrapy已经帮我们省去了这样的操作:第一次请求返回的cookie会在第二请求发送的时候被携带。

代理

import scrapy class ProxydemoSpider(scrapy.Spider):

name = 'proxyDemo'

#allowed_domains = ['www.baidu.com/s?wd=ip']

start_urls = ['https://www.baidu.com/s?wd=ip'] def parse(self, response):

fp = open('proxy.html','w',encoding='utf-8')

fp.write(response.text)

配置好配置文件,然后再执行,在proxy.html文件中就会看到本机ip的浏览器页面,ip就是真实的本机ip。

那如何更改ip呢?就用到了代理,在scrapy中使用代理操作需要对下载中间件下手。

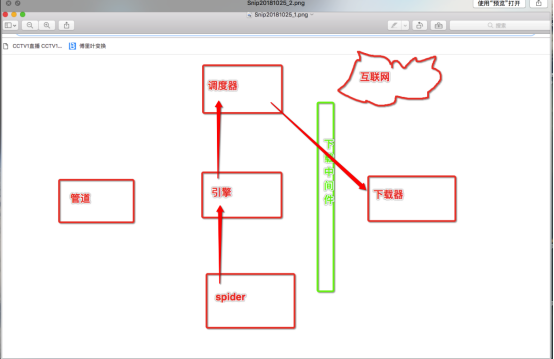

那么什么是下载中间件呢?

下载中间件的作用就是拦截请求,将请求的ip进行更换。

流程:

1. 下载中间件类的自制定

a) 继承object

b) 重写process_request(self,request,spider)的方法

2. 配置文件中进行下载中间价的开启。

middlewares.py 就是下载中间件的定义文件

from scrapy import signals #自定义一个下载中间件的类,在类中实现process_request(处理中间价拦截到的请求)方法

class MyProxy(object):

def process_request(self,request,spider):

#请求ip的更换

request.meta['proxy'] = "https://178.128.90.1:8080" # 这里需要一个有效的代理ip

开启下载中间件

# Enable or disable downloader middlewares

# See https://doc.scrapy.org/en/latest/topics/downloader-middleware.html

DOWNLOADER_MIDDLEWARES = {

'proxyPro.middlewares.MyProxy': 543, # 数字大小代表优先级

}

再次执行,打开页面发现ip就被更改了!

cookie操作和代理的更多相关文章

- 爬虫--requests模块高级(代理和cookie操作)

代理和cookie操作 一.基于requests模块的cookie操作 引言:有些时候,我们在使用爬虫程序去爬取一些用户相关信息的数据(爬取张三“人人网”个人主页数据)时,如果使用之前requests ...

- Python脚本控制的WebDriver 常用操作 <二十八> 超时设置和cookie操作

超时设置 测试用例场景 webdriver中可以设置很多的超时时间 implicit_wait.识别对象时的超时时间.过了这个时间如果对象还没找到的话就会抛出异常 Python脚本 ff = webd ...

- cookie操作大全

JavaScript中的另一个机制:cookie,则可以达到真正全局变量的要求. cookie是浏览器 提供的一种机制,它将document 对象的cookie属性提供给JavaScript.可以由J ...

- js 判断js函数、变量是否存在 JS保存和删除cookie操作,判断cookie是否存在的方法

//是否存在指定函数 function isExitsFunction(funcName) { try { if (typeof(eval(funcName)) == " ...

- JS封装cookie操作函数实例(设置、读取、删除)

本文实例讲述了JS封装cookie操作函数.分享给大家供大家参考,具体如下: ? 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 ...

- 网上收集的WebBrowser的Cookie操作

原文:网上收集的WebBrowser的Cookie操作 1.WebBrowser设置Cookie Code highlighting produced by Actipro CodeHighlight ...

- 学习笔记: JavaScript/JQuery 的cookie操作

转自:http://blog.csdn.net/barryhappy/archive/2011/04/27/6367994.aspx cookie是网页存储到用户硬盘上的一小段信息.最常见的作用是判断 ...

- js实用方法记录-简单cookie操作

js实用方法记录-简单cookie操作 设置cookie:setCookie(名称,值,保存时间,保存域); 获取cookie:setCookie(名称); 移除cookie:setCookie(名称 ...

- 前端cookie操作用到的一些小总结

前后端完全分离的是目前web开发的大趋势,包括现下流行的前端框架的应用vue,angular,在不同页面跳转时,前端需要对用户登录状态进行判断,拿到用户的id,除了Ajax从服务器端获取数据外,对co ...

随机推荐

- Mysql远程连接授权IP

新增法 我们现在增加一个'username'用户,密码为'password',让其能够从外部访问MYSQL. grant all on * to 'username' identified by ...

- div模拟textarea自适应高度

之前在公司做项目的时候,有这么一个需求,要我写一个评论框,可以随着评论的行数增加而自动扩大,最开始我想用textarea实现,但是后来尝试后发现textarea并不适合,textarea的高度不会随着 ...

- 我的Android开发之路——百度地图开源工具获取定位信息

定位技术在现在的移动设备上是必不可少的,许多app都会使用定位功能. 通常定位方式有两种:GPS定位:网络定位. Android系统对这两种定位方式都提供了相应的API支持,但是因为google的网络 ...

- win10 mstsc 远程,登录失败,账号限制

问题: win7操作系统在局域网共享文件时,有时会遇到“登录失败:用户账户限制.可能的原因包括不允许空密码,登录时间限制,或强制的策略限制.”的情况,这要怎么解决呢 解决步骤: 1.按WIN+R,调出 ...

- HTML5开发,背后的事情你知道吗?

现在的H5越来越受到企业或者是开发者的一个大力的追捧,已经成为网络推广必不可少的一个使用的工具,相信还有很多朋友现在都不知道H5是个什么东西,本文将为大家讲的是关于H5一些分类的问题,让你进一步的去学 ...

- LA 3938 动态最大连续和

题目链接:https://vjudge.net/contest/146667#problem/C 题意:动态的求一个区间的最大连续和. 分析: 看上去可以RMQ去做,但是,当分成两个部分,原来的部分的 ...

- php图像处理插件imagick安装(仅适用于86位,php5.4非安全环境-16px)

phpImageMagick-6.7.7-5-Q16-windows-dll(加测试代码,经测试,仅适用于86位,php5.4安全环境-16px) 下载地址:http://pan.baidu.com/ ...

- 剑指offer28 字符串的排列

1.全局变量可以在最后去定义并初始化,不一定非要在开头 2.此题有一种特殊情况需要考虑,比如字符串是“aa”,那输出应该是“aa”,而不是“aa,aa”,即相同的不输出.实现这个处理用了c++中的容器 ...

- [转] JAVA中读取网络中的图片资源导入到EXCEL中

需求 导出人员的信息并且加上人员的照片至EXCEL中 完整的代码 //创建一个表格 HSSFWorkbook wb = new HSSFWorkbook(); HSSFSheet sheet = wb ...

- MAC os x 系统java开发环境搭建教程

https://jingyan.baidu.com/article/3d69c55147a3baf0cf02d7ca.html