Hadoop 安装(本地、伪分布、分布式模式)

本地模式

环境介绍

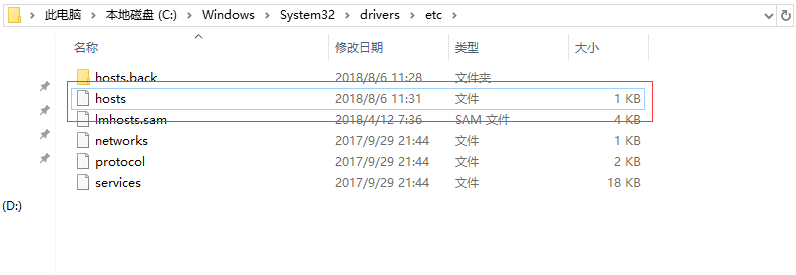

一共三台测试机

master 192.168.4.91

slave1 192.168.4.45

slave2 192.168.4.96

操作系统配置

1、Centos7操作系统

2、防火墙,selinux都关闭(在学习的时候,基本都是关闭防火墙,生产环境,防火墙都是打开的,不仅有Linux自带的主机防火墙,还有其他的物理防火墙)

*** 以下操作需要root权限 *** () Centos7关闭防火墙命令

#systemctl stop firewalld

#systemctl disable firewalld Centos6关闭防火墙

#/etc/init.d/iptables stop

#chkconfig iptables off () 关闭Selinux

#sed -i 's/enforcing/disabled/g' /etc/selinux/config 通常情况下,设置完selinux需要重启操作系统,如果不想重启,可以临时关闭selinux。

#setenforce 表示临时关闭selinux () 修改操作系统ulimit的限制(可以使用ulimit -a参数看当前系统的ulimit限制值)

#echo "* - nofile 65535" >> /etc/security/limits.conf 修改最大文件数。

#echo "* - nproc 65535" >> /etc/security/limits.d/-nproc.conf 修改最大进程数

注意:修改完以后,如果想要生效,需要重新打开会话。 () 关闭ipv6

#echo "net.ipv6.conf.all.disable_ipv6 = 1" >> /etc/sysctl.conf

#echo "net.ipv6.conf.default.disable_ipv6 = 1" >> /etc/sysctl.conf

#sysctl -p () 修改/etc/hosts文件,添加主机名和ip的映射

() 创建管理集群的用户

#useradd -m -d /home/hadoop hadoop

#passwd hadoop #修改密码

() 创建数据目录

#mkdir /data/hadoop

#chown hadoop:hadoop /data/hadoop

#su - hadoop #切换到hadoop用户

() 设置主机之间免密登录

#ssh-keygen -t rsa -N '' -f ~/.ssh/id_rsa (在每台机器执行)

拷贝分发秘钥

下载软件包

下载Hadoop:http://www.apache.org/dyn/closer.cgi/hadoop/common/hadoop-2.9.2/hadoop-2.9.2.tar.gz

如果想下载最新版的二进制包,到官网下载。

安装配置JDK和Hadoop

1、安装JDK以及配置环境变量

$ tar zxvf jdk-8u181-linux-x64.tar.gz -C /data/hadoop

$ cd /data/hadoop

$ ln -s jdk1..0_181/ jdk

$ vim ~/.bashrc 文件最后追加

export JAVA_HOME=/data1/hadoop/jdk

export PATH=${JAVA_HOME}/bin:$PATH $source /etc/profile #让jdk生效

$java -version #查看jdk是否生效,如果输入如下,说明配置成功。

java version "1.8.0_181"

Java(TM) SE Runtime Environment (build 1.8.0_181-b13)

Java HotSpot(TM) -Bit Server VM (build 25.181-b13, mixed mode)

2、安装Hadoop以及配置

解压

$ tar zxvf tar zxvf hadoop-2.9..tar.gz -C /data/hadoop/

$ cd /data/hadoop

$ ln -s hadoop-2.9.2/ hadoop 配置环境变量

$ vim ~/.bashrc,追加如下配置 export HADOOP_HOME=/data1/hadoop/hadoop/ export PATH=${HADOOP_HOME}/bin:${HADOOP_HOME}/sbin:$PATH $ source ~/.bashrc

3、本地模式下,各个进程运行在一台机器上,占用的jvm进程数为1,在跑MapReduce时,从本地读取文件,输出到本地文件。

(1)、在本地系统创建一个文件

#cat test.txt

11 22 33

22 33 44

44 22 11

运行hadoop自带的MapReduce程序

$ hadoop jar /data/hadoop-2.9.2/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.9.2.jar wordcount test.txt test.out

这里可以看到job ID中有local字样,说明是运行在本地模式下的。

(2)查看输出的文件。在本地模式下,输出文件是在本地。

# ll test.out

输出目录中有_SUCCESS文件说明JOB运行成功;part-r-00000是输出结果文件,r说明是reduce产生的结果,如果是m的话,则是map阶段产生的。

如果要查看具体的信息:

# cat test.out/part-r-00000

伪分布搭建

特点:伪分布模式下,多个进程运行在不同的jvm内

以下配置只在master节点操作

Hadoop配置

1、配置hadoop-env.sh

$ cd /data/hadoop/hadoop/etc/hadoop/

$ echo "export JAVA_HOME=/data/hadoop/jdk" >> hadoop-env.sh

2、配置core-site.xml文件

在<configuration>下面添加 fs.defaultFS参数配置的是HDFS的地址。 <property>

<!-- hdfs 地址 -->

<name>fs.defaultFS</name>

<value>hdfs://master:8020</value>

</property> <!-- 指定hadoop临时目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/data/hadoop/hadoop/tmp</value>

</property> hadoop.tmp.dir 是hdfs文件系统产生数据所存放的临时目录 创建目录: $ mkdir /data/hadoop/hadoop/tmp

3、配置hdfs-site.xml文件

在<configuration>下面添加 <property>

<name>dfs.replication</name> #这里指定hdfs产生数据时备份的机器数量,由于只有一台机器,所以为1.

<value></value>

</property> <property>

<name>dfs.namenode.name.dir</name>

<value>/data/hadoop/hadoop/name</value> #指定namenode数据存放的目录

</property> <property>

<name>dfs.datanode.data.dir</name>

<value>/data/hadoop/hadoop/data</value> #指定datanode数据存放的目录 </property> $ mkdir /data/hadoop/hadoop/name $ mkdir /data/hadoop/hadoop/data

4、接下来格式化hdfs

$ hadoop namenode -format

格式化是对HDFS这个分布式文件系统中的DataNode进行分块,统计所有分块后的初始元数据的存储在NameNode中。

格式化后,查看core-site.xml里hadoop.tmp.dir(本例是/data/hadoop/hadoop/目录)指定的目录下是否有了dfs目录,如果有,说明格式化成功。

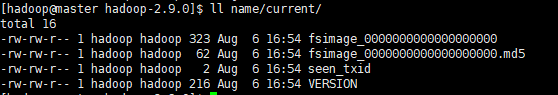

$ ll /data/hadoop/hadoop/name/current,以下图片可能目录不正确,我查看的是以前安装的集群信息

fsimage_XXX 是namenode元数据存满以后持久化到磁盘的文件。

fsimage*.md5 是校验文件,校验fsimage的完整性。

seen_txid 是hadoop的版本

$ cat VERSION

namespaceID=271252846 #namenode的唯一id

clusterID=CID-97e864b1-262d-4ce0-93d9-9dd96953ecc5 #集群id

cTime=1533545685716

storageType=NAME_NODE #存储类型

blockpoolID=BP-1051333686-192.168.4.91-1533545685716

layoutVersion=-63

当然,NameNode和DataNode的集群ID应该一致,表明这是一个集群,datenode的id可以到/data/hadoop/hadoop/data 这个目录下查看。

♥ 启动namenode、datanode、SecondaryNameNode

$ hadoop-daemon.sh start namenode $ hadoop-daemon.sh start datanode $ hadoop-daemon.sh start secondarynamenode

使用jps命令查看是否启动成功

$ jps

3022 NameNode

10578 Jps

2099 DateNode

12768 SecondaryNameNode

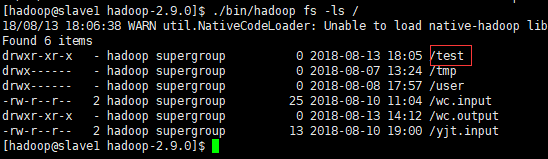

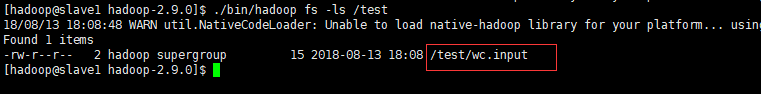

♥ hdfs分布式文件系统测试

在hdfs上创建目录:

$ hadoop fs -mkdir /test

查看目录:

#

上传本地文件到hdfs:

$ ./bin/hadoop fs -put wc.input /test

#

从hdfs分布式文件系统上面下载文件到本地系统

$ ./bin/hadoop fs -get /test/wc.put

5、配置 mapred-site.xml

在 <configuration>下面添加

<!-- 指定mr运行在yarn框架上 -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

6、配置yarn.site.xml

在 <configuration>下面添加

<property>

<name>yarn.nodemanager.aux-services</name> #yarn默认混洗方式 <value>mapreduce_shuffle</value>

</property> <property>

<name>yarn.resourcemanager.hostname</name> #指定resourcemanager的主机名称

<value>master</value>

</property>

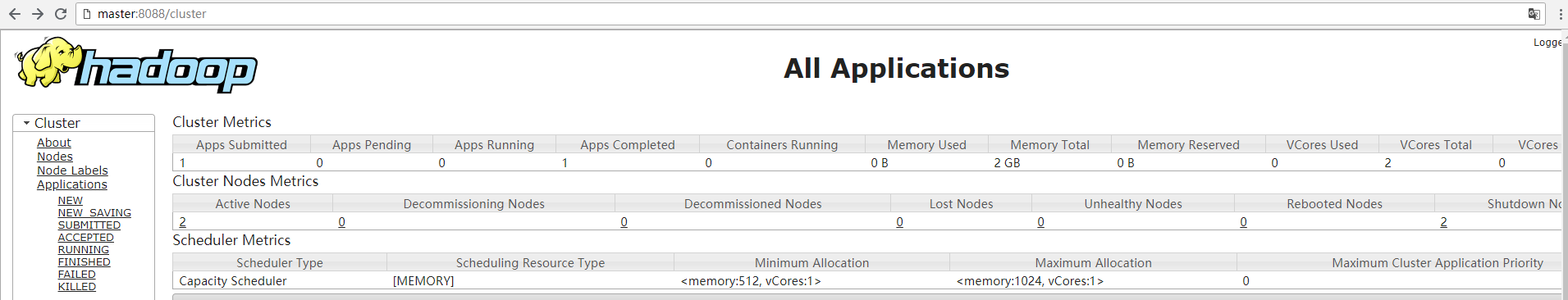

♥启动resourcemanager

${HADOOP_HOME}/sbin/yarn-daemon.sh start resourcemanager

♥启动nodemanager

${HADOOP_HOME}/sbin/yarn-daemon.sh start nodemanager

使用jps查看是否启动成功,如果有 resourcemanager nodemanager 则说明成功。

♥ 查看yarn的外部界面,

如果你要在Windows里面通过主机名去访问Linux里面的主机,那么你需要在Windows的hosts主机里面添加Linux主机名和其IP地址的映射关系。

这样才能正常从Windows浏览器通过主机名访问Linux,当然,你直接输入IP地址就不需要这一步了。

有时候你在修改Windows 下的/etc/hosts完成以后,保存时提示没有权限,该怎么做呢:

如图:hosts文件右键——> 安全----->指定users用户,在权限这里,把允许下面的都勾选上。

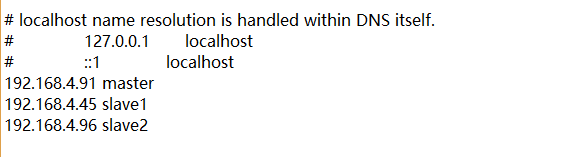

♥ 允许MapReduce

在本地系统创建测试用的文件

#cat wc.put

上传到hdfs文件系统

# hadoop fs -put wc.put /

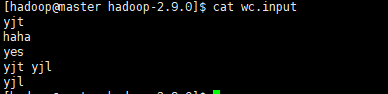

运行Wordcount MapReduce job

$ cd /data/hadoop/hadoop $ hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.9.2.jar wordcount /wc.input /wc.output

查看输出结果

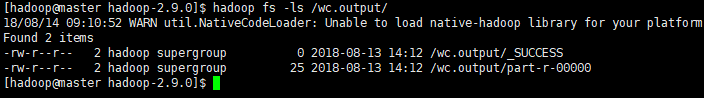

$ hadoop fs -ls /wc.output/

有SUCCESS就代表这个job执行成功,这是一个空文件;part-r-00000既是输出结果,其中r表示是reduce阶段产生的结果,mapreduce程序执行时,可以没有reduce阶段,但是肯定会有map阶段,如果没有reduce阶段这个地方有是-m-,一个reduce会产生一个part-r-开头的文件。

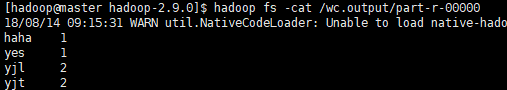

• 查看结果

# hadoop fs -cat /wc.output/part-r-00000

其结果可以看出来是按照键值排好序的。

♥ 如何停止hadoop?

(1)一个一个进程慢慢停止

$./sbin/hadoop-daemon.sh stop namenode

$./sbin/hadoop-daemon.sh stop datenode

$ ./sbin/yarn-daemon.sh stop resourcemanager

$ ./sbin/yarn-daemon.sh stop nodemanager

(2) hadoop有一个脚本文件,可以直接停止集群,这个脚本文件分开来的话就是停止hdfs和yarn。启动整个集群也可以使用 ./sbin/start-all.sh

#./sbin/stop-all.sh

♥ 各个功能模块的介绍

(1) yarn

这是一个资源调度框架,在hadoop2.x中,主要就是管理整个集群资源的分配和调度,具体请查看 https://blog.csdn.net/liuwenbo0920/article/details/43304243

(2) hdfs

hdfs分布式文件系统主要用来将大文件分块以后进行分布式存储数据的,突破了单台机器磁盘存储限制,这是一个相对独立的模块,能够为yarn、hbase等模块提供服务。

(3)MapReduce

MapReduce是一个计算框架,通过map、reduce阶段来分布式的对数据进行流处理,适用于对数据的流处理,对实时性要求高的应用不太适合,在hadoop1.0中,MapReduce是出于霸主级别,但是在hadoop2.0中,提供了一个更高效的处理引擎--spark。

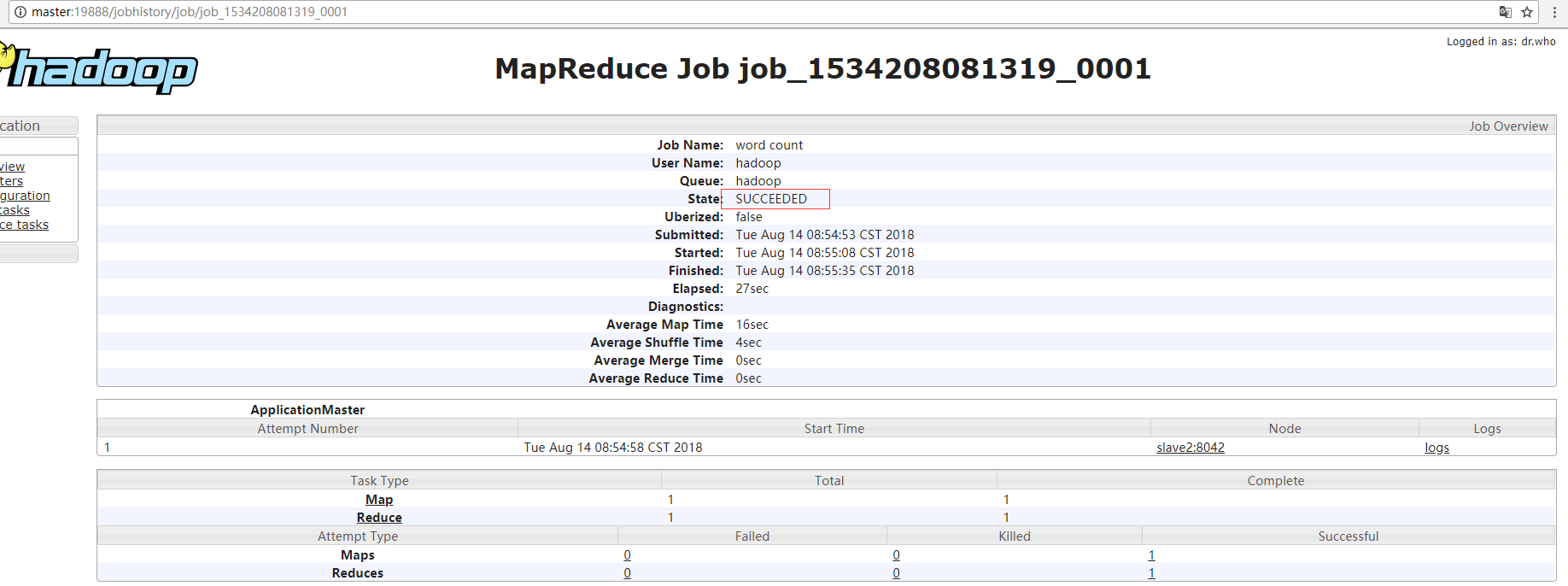

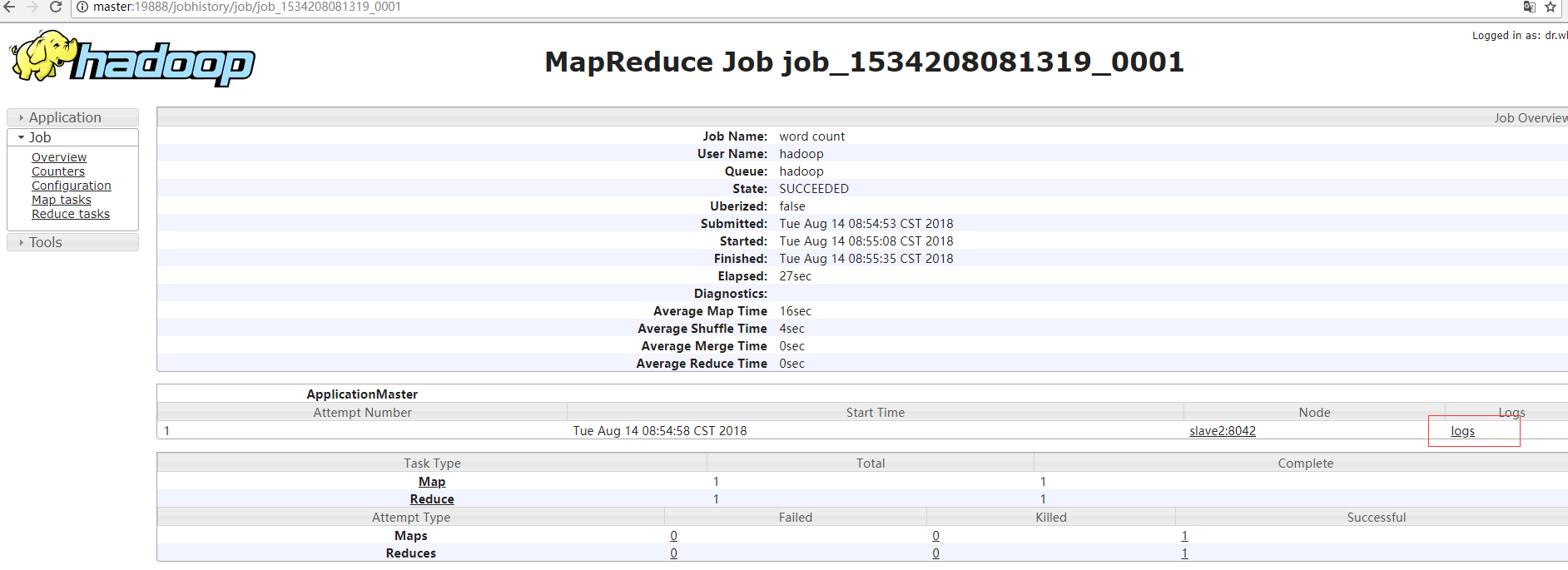

♥ 如何开启历史服务?

(1) #./sbin/mr-jobhistory-daemon.sh start historyserver

开启以后通过web界面可以查看,点开下图的history,可以查看历史信息。

历史服务器的端口是19888.

♥ 如果想在web界面查看日志该如何做呢?那就是开启日志聚集,日志聚集是在yarn框架的,所以在配置的时候是在yarn.site.xml文件里面配置

(1)日志聚集介绍

MapReduce是在各个机器上运行的,在运行过程中产生的日志存在于各个机器上,为了能够统一查看各个机器的运行日志,将日志集中存放在HDFS上,这个过程就是日志聚集。

(2)日志聚集默认是未开启的,通过配置yarn.site.xml来开启。

<property>

<name>yarn.log-aggregation-enable</name> # 是否开启日志聚集

<value>true</value>

</property>

<property>

<name>yarn.log-aggregation.retain-seconds</name> #日志保存时间,以秒为单位。

<value></value>

</property>

(3)配置完以后重启yarn进程

# stop-yarn.sh

# start-yarn.sh

(4)现在就可以去web界面查看map、reduce阶段产生的日志。

当然,在执行这一步的时候,是因为我们上面刚刚跑过MapReduce程序,如果你没有跑MapReduce,则这个界面不会有这些信息。

如果是在完全分布式或者ha完全分布式集群里面,当配置完成以后,需要把配置文件拷贝到其他节点在重新启动yarn进程。

分布式模式

前提是前面的JDK在三台机器都已经安装好。

1、停止伪分布式模式下搭建的集群

$ stop-all.sh

2、删除伪分布式模式下生成的数据

$ rm -rf /data/hadoop/hadoop/name

$ rm -ff /data/hadoop/hadoop/data

3、修改/data/hadoop/hadoop/etc/hadoop/slaves,添加需要启动的datanode、nodemanagerjied

slave1

slave2

4、分发hadoop到其他机器

$ scp -r /data/hadoop/hadoop slave1:/data/hadoop

$ scp -r /data/hadoop/hadoop slave2:/data/hadoop

5、启动集群

$ start-all.sh

Hadoop 安装(本地、伪分布、分布式模式)的更多相关文章

- Hadoop安装-单机-伪分布式简单部署配置

最近在搞大数据项目支持所以有时间写下hadoop随笔吧. 环境介绍: Linux: centos7 jdk:java version "1.8.0_181 hadoop:hadoop-3.2 ...

- ubantu18.04下Hadoop安装与伪分布式配置

1 下载 下载地址:http://mirror.bit.edu.cn/apache/hadoop/common/stable2/ 2 解压 将文件解压到 /usr/local/hadoop cd ~ ...

- hadoop 2.6伪分布安装

hadoop 2.6的“伪”分式安装与“全”分式安装相比,大部分操作是相同的,主要区别在于不用配置slaves文件,而且其它xxx-core.xml里的参数很多也可以省略,下面是几个关键的配置: (安 ...

- Hadoop2.6.0安装—单机/伪分布

目录 环境准备 创建hadoop用户 更新apt 配置SSH免密登陆 安装配置Java环境 安装Hadoop Hadoop单机/伪分布配置 单机Hadoop 伪分布Hadoop 启动Hadoop 停止 ...

- hadoop安装配置——伪分布模式

1. 安装 这里以安装hadoop-0.20.2为例 先安装java,参考这个 去着下载hadoop 解压 2. 配置 修改环境变量 vim ~/.bashrc export HADOOP_HOME= ...

- hadoop local、伪分布 模式

local模式: 把安装包 解压到 /usr/local 下 [hadoop@master local]$ sudo tar -zxvf hadoop-2.7.3.tar.gz 创建一个软连接 ...

- Hadoop.2.x_伪分布环境搭建

一. 基本环境搭建 1. 设置主机名.静态IP/DNS.主机映射.windows主机映射(方便ssh访问与IP修改)等 设置主机名: vi /etc/sysconfig/network # 重启系统生 ...

- 配置hadoop集群,完全分布式模式

[/soft/hadoop/etc/hadoop] [hdfs-site.xml] <configuration> <property> <name>dfs.rep ...

- hadoop2.7【单节点】单机、伪分布、分布式安装指导

问题导读 1.从本文部署实际部署,总结本地模式.伪分布.分布式的区别是什么?2.单机是否是伪分布?3.本地模式是否可以运行mapreduce? 来源:about云 http://www.aboutyu ...

随机推荐

- 免root xshell连接termux

免root实现xshell连接termux termux为安卓手机上的一款模拟linux终端的应用,由于手机上打字比较麻烦,所以想到了用电脑上的xshell通过ssh连接termux,以实现电脑控制t ...

- 远程 Linux(Ubuntu 18)添加字体

安装 xshell与xftp 连接xshell 点击 xshell上方工具栏中的xftp图标, 自动连接xftp linux下创建字体目录 su cd / cd usr/share/fonts mkd ...

- jQuery遍历(2)

上期我们讲了遍历的祖先和后代的问题,现在我们讲讲遍历同胞 同胞拥有相同的父元素. 通过 jQuery,您能够在 DOM 树中遍历元素的同胞元素. jQuery siblings() 方法 siblin ...

- js入门之对象

一.对象理解 现实世界 万物皆对象, 一切事物都是对象 对象还是一个具体的事物 对象: 特征和行为组成 特征是名词 用来描述对象的, 行为是动词 程序中的对象 是对现实世界中事物的抽象 1. js中的 ...

- 微信小程序开发demo

自己写的小程序,欢迎下载 https://gitee.com/lijunchengit/chengZiShengHuoBang

- 只需五分钟-用Maven快速搭建Spring Cloud微服务

Maven安装手册 1.准备安装包 安装包: apache-maven-3.5.4-bin.zip (最好JDK 1.7及以上版本) 集成包: eclipse-maven3-plugin.zip 2 ...

- 【清单】值得「等待」的12个指示加载状态的 js 库

以下优选 GitHub 上高 star 的指示加载状态的 JavaScript 库.另外这里还有10个有意思的 JavaScript 实战小项目供大家学习. 上期入口:一份数据分析学习清单.xls M ...

- MySQL面试问题

1.MySQL的复制原理以及流程 (1).复制基本原理流程 1. 主:binlog线程——记录下所有改变了数据库数据的语句,放进master上的binlog中: 2. 从:io线程——在使用start ...

- 1204 中间件以及cookie,session

目录 一 .cookie与session原理 1.cookie 操作 1.1 设置cookie set_cookie 1.2 获取cookie request.COOKIES.get('k1') 1. ...

- 《hello--world团队》第四次作业:项目需求调研与分析

项目 内容 这个作业属于哪个课程 2016级计算机科学与工程学院软件工程(西北师范大学) 这个作业的要求在哪里 实验八 团队作业4:基于原型的团队项目需求调研与分析 团队名称 <hello--w ...