[Spark RDD_1] RDD 基本概念

0. 说明

RDD 概述 && 创建 RDD 的方式 && RDD 编程 API(Transformation 和 Action Operations) && RDD 的依赖关系

1. RDD 概述

Spark 围绕弹性分布式数据集(RDD)的概念展开,RDD 是可以并行操作的容错的容错集合。

resilient distributed dataset,弹性分布式数据集。

不可变集合,可以进行并行操作的分区化数据集合。

该类包含了 RDD 常见操作,比如 map、filter、persist 等。

对于 key-value 的 RDD,会自动转换成(隐式转换)PairRDDFunction,该类提供了所有的 ByKey 操作。

内部,每个 RDD 主要含有 5 个主要属性:

- 分区列表(轻量级数据集合,没有实际数据)

- 计算每个切片的计算函数

- 和其他RDD的依赖列表

- 针对 K-V 类型 RDD,还有一个分区类(可选)

- 计算每个切片的首选位置列表(可选)

2. 创建 RDD 的方式

创建 RDD 有两种方法

【方法一】

并行化 驱动程序中的现有集合。

例子如下

【方法二】

引用外部存储系统中的数据集,例如共享文件系统,HDFS,HBase 或提供 Hadoop InputFormat 的任何数据源。

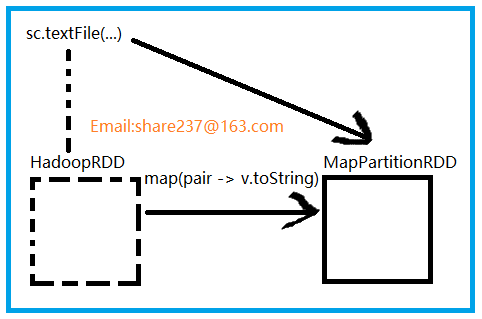

textFile() 方法最初创建的是 HadoopRDD,HadoopRDD 提供了读取 HDFS 文件核心功能。

sc.textFile()

产生了两个 RDD

HadoopRDD -> MapPartitionRDD

3. RDD 编程 API(Transformation 和 Action Operations)

【变换 Transformation】

返回值为新的 RDD

map

flatMap

filter()

reduceByKey()

【动作 Actions】

返回值为具体的值

collect()

save()

reduce()

count()

4. RDD 的依赖关系

【依赖】

RDD 的依赖是 子 RDD 上的每个分区和父 RDD 分区数量上的对应关系

Dependency

|----ShuffleDependency (宽依赖)

|----NarrowDependency (窄依赖:子 RDD 的每个分区依赖少量的父 RDD 分区)

|-----One2OneDependency (一对一依赖)

|-----RangeDependency(范围依赖)

|-----PruneDependency(Prune 依赖)

【说明】

构造 RDD 时使用的是 One2OneDependency

[Spark RDD_1] RDD 基本概念的更多相关文章

- 【原】Learning Spark (Python版) 学习笔记(一)----RDD 基本概念与命令

<Learning Spark>这本书算是Spark入门的必读书了,中文版是<Spark快速大数据分析>,不过豆瓣书评很有意思的是,英文原版评分7.4,评论都说入门而已深入不足 ...

- Learning Spark (Python版) 学习笔记(一)----RDD 基本概念与命令

<Learning Spark>这本书算是Spark入门的必读书了,中文版是<Spark快速大数据分析>,不过豆瓣书评很有意思的是,英文原版评分7.4,评论都说入门而已深入不足 ...

- Spark RDD基本概念与基本用法

1. 什么是RDD RDD(Resilient Distributed Dataset)叫做分布式数据集,是Spark中最基本的数据抽象,它代表一个不可变.可分区.里面的元素可并行计算的集合.RDD具 ...

- 关于Spark中RDD的设计的一些分析

RDD, Resilient Distributed Dataset,弹性分布式数据集, 是Spark的核心概念. 对于RDD的原理性的知识,可以参阅Resilient Distributed Dat ...

- Spark中的一些概念

最近工作用到Spark,这里记一些自己接触到的Spark基本概念和知识. 本文链接:https://www.cnblogs.com/hhelibeb/p/10288915.html 名词 RDD:在高 ...

- spark中RDD的转化操作和行动操作

本文主要是讲解spark里RDD的基础操作.RDD是spark特有的数据模型,谈到RDD就会提到什么弹性分布式数据集,什么有向无环图,本文暂时不去展开这些高深概念,在阅读本文时候,大家可以就把RDD当 ...

- Spark集群基础概念 与 spark架构原理

一.Spark集群基础概念 将DAG划分为多个stage阶段,遵循以下原则: 1.将尽可能多的窄依赖关系的RDD划为同一个stage阶段. 2.当遇到shuffle操作,就意味着上一个stage阶段结 ...

- 大话Spark(1)-Spark概述与核心概念

说到Spark就不得不提MapReduce/Hadoop, 当前越来越多的公司已经把大数据计算引擎从MapReduce升级到了Spark. 至于原因当然是MapReduce的一些局限性了, 我们一起先 ...

- Spark之RDD的定义及五大特性

RDD是分布式内存的一个抽象概念,是一种高度受限的共享内存模型,即RDD是只读的记录分区的集合,能横跨集群所有节点并行计算,是一种基于工作集的应用抽象. RDD底层存储原理:其数据分布存储于多台机器上 ...

随机推荐

- netty源码解解析(4.0)-4 线程模型-概览

netty线程体系概览 netty的高并发能力很大程度上由它的线程模型决定的,netty定义了两种类型的线程: I/O线程: EventLoop, EventLoopGroup.一个EventLoop ...

- es6学习笔记1

最近在阅读<探索es6>,就把自己认为重要的做一点笔记,方便日后学习. 1.获取更多的es6资源的办法 有两组 ES6 资源: “ ECMAScript 6 Tools ”,作者 Addy ...

- BFS算法(——模板习题与总结)

首先需要说明的是BFS算法(广度优先算法)本质上也是枚举思想的一种体现,本身效率不是很高,当数据规模很小的时候还是可以一试的.其次很多人可能有这样的疑问,使用搜索算法的时候,到底选用DFS还是BFS, ...

- 分布式理论(四)—— 一致性协议之 3PC

前言 我们说为了实现 BASE 理论,需要在可用性和一致性之间找到一个合适的一致性理论,于是,我们在上篇文章中了解了 2PC 理论,也就是两阶段提交,二阶段提交原理简单,实现方便,但是缺点则是同步阻塞 ...

- Java面试——你必须知道的122题

1.Java面向对象中所有类的最终基类是什么? 参考答案 object,所有类都默认最终继承object,object是所有类的基类 2.什么是Java虚拟机?为什么Java被称作是“平台无关的编程语 ...

- 使用Docker调试Asp.Net Core

使用 Docker 进行部署 目前还是使用将发布出来的文件打包进docker镜像的形式 $ docker build -t pims . $ docker run --name pims --rm - ...

- LDA(线性判别分析,Python实现)

源代码: #-*- coding: UTF-8 -*- from numpy import * import numpy def lda(c1,c2): #c1 第一类样本,每行是一个样本 #c2 第 ...

- [日常] Go语言圣经--复合数据类型,数组习题

go语言圣经-复合数据类型 1.以不同的方式组合基本类型可以构造出来的复合数据类型 2.四种类型——数组.slice.map和结构体 3.数组是由同构的元素组成——每个数组元素都是完全相同的类型——结 ...

- 【ZeroMQ】1、ZeroMQ(java)入门之Requerst/Response模式

自己最开始是在cloud foundry中接触过消息服务器(nats),或者说是消息中间件,也算是初步知道了一个消息服务器对于分布式的网络系统的重要性,后来自己也曾想过在一些项目中使用它,尤其是在一些 ...

- Python os、sys、pickle、json等模块

1.os 所有和操作系统相关的内容都在os模块,一般用来操作文件系统 import os os.makedirs('dirname1/dirname2') # 可生成多层递归目录 os.removed ...