在 R 中估计 GARCH 参数存在的问题(续)

在 R 中估计 GARCH 参数存在的问题(续)

本文承接《在 R 中估计 GARCH 参数存在的问题》

在之前的博客《在 R 中估计 GARCH 参数存在的问题》中,Curtis Miller 讨论了 fGarch 包和 tseries 包估计 GARCH(1, 1) 模型参数的稳定性问题,结果不容乐观。本文承接之前的博客,继续讨论估计参数的稳定性,这次使用的是前文中提到,但没有详尽测试的 rugarch 包。

rugarch 包的使用

rugarch 包中负责估计 GARCH 模型参数的最主要函数是 ugarchfit,不过在调用该函数值前要用函数 ugarchspec 创建一个特殊对象,用来固定 GARCH 模型的阶数。

srs = ...

garch_mod = ugarchspec(

variance.model = list(

garchOrder = c(1, 1)),

mean.model = list(

armaOrder = c(0, 0),

include.mean = FALSE))

g <- ugarchfit(spec = garch_mod, data = srs)

需要注意的是 g 是一个 S4 类。

简单实验

首先用 1000 个模拟样本,

library(rugarch)

library(ggplot2)

library(fGarch)

set.seed(110117)

x <- garchSim(

garchSpec(

model = list(

"alpha" = 0.2, "beta" = 0.2, "omega" = 0.2)),

n.start = 1000,

n = 1000)

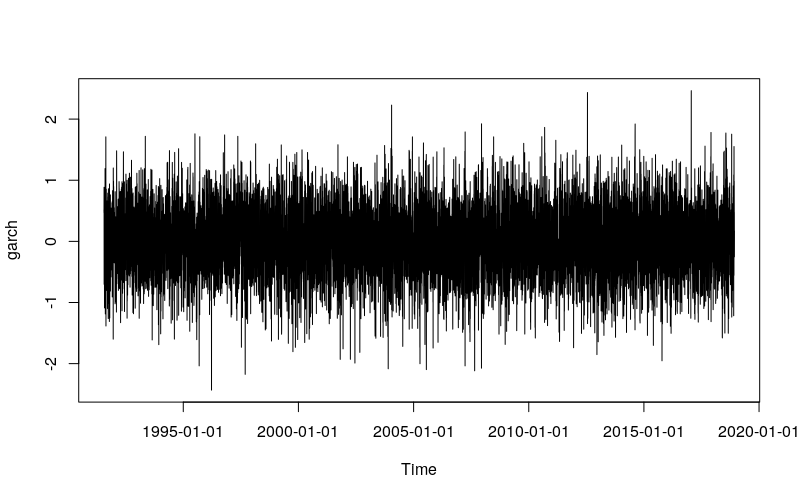

plot(x)

garch_spec = ugarchspec(

variance.model = list(garchOrder = c(1, 1)),

mean.model = list(

armaOrder = c(0, 0), include.mean = FALSE))

g_all <- ugarchfit(

spec = garch_spec, data = x)

g_50p <- ugarchfit(

spec = garch_spec, data = x[1:500])

g_20p <- ugarchfit(

spec = garch_spec, data = x[1:200])

结果同样不容乐观,

coef(g_all)

# omega alpha1 beta1

# 2.473776e-04 9.738059e-05 9.989026e-01

coef(g_50p)

# omega alpha1 beta1

# 2.312677e-04 4.453120e-10 9.989998e-01

coef(g_20p)

# omega alpha1 beta1

# 0.03370291 0.09823614 0.79988068

再用 10000 个模拟样本试试,如果使用日线级别的数据的话,这相当于 40 年长度的数据量,

set.seed(110117)

x <- garchSim(

garchSpec(

model = list(

"alpha" = 0.2, "beta" = 0.2, "omega" = 0.2)),

n.start = 1000, n = 10000)

plot(x)

g_all <- ugarchfit(

spec = garch_spec, data = x)

g_50p <- ugarchfit(

spec = garch_spec, data = x[1:5000])

g_20p <- ugarchfit(

spec = garch_spec, data = x[1:2000])

coef(g_all)

# omega alpha1 beta1

# 0.1955762 0.1924522 0.1967614

coef(g_50p)

# omega alpha1 beta1

# 0.2003755 0.1919633 0.1650453

coef(g_20p)

# omega alpha1 beta1

# 1.368689e-03 6.757177e-09 9.951920e-01

看来数据量极端大的时候,估计才可能是合理的、稳定的。

rugarch 参数估计的行为

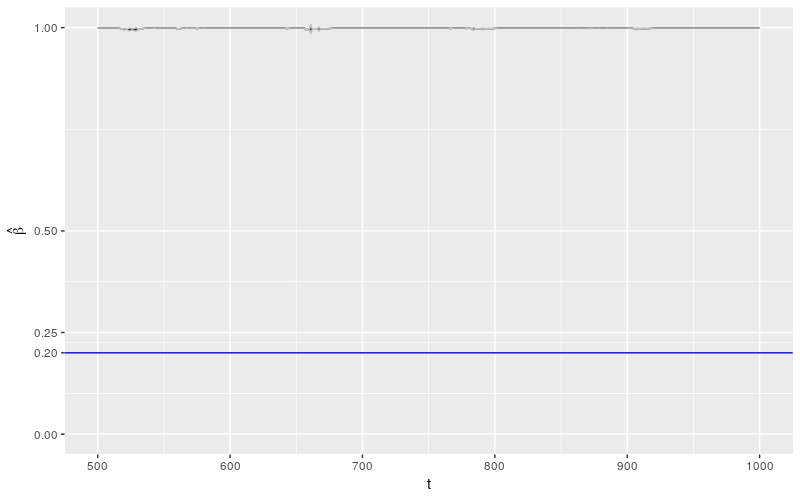

首先使用 1000 个模拟样本做连续估计,样本数从 500 升至 1000。

library(doParallel)

cl <- makeCluster(detectCores() - 1)

registerDoParallel(cl)

set.seed(110117)

x <- garchSim(

garchSpec(

model = list(alpha = 0.2, beta = 0.2, omega = 0.2)),

n.start = 1000, n = 1000)

params <- foreach(

t = 500:1000,

.combine = rbind,

.packages = c("rugarch")) %dopar%

{

getFitDataRugarch(x[1:t])

}

rownames(params) <- 500:1000

params_df <- as.data.frame(params)

params_df$t <- as.numeric(rownames(params))

ggplot(params_df) +

geom_line(

aes(x = t, y = beta1)) +

geom_hline(

yintercept = 0.2, color = "blue") +

geom_ribbon(

aes(x = t,

ymin = beta1 - 2 * beta1.se,

ymax = beta1 + 2 * beta1.se),

color = "grey", alpha = 0.5) +

ylab(expression(hat(beta))) +

scale_y_continuous(

breaks = c(0, 0.2, 0.25, 0.5, 1)) +

coord_cartesian(ylim = c(0, 1))

几乎所有关于 \(\beta\) 的估计都非常肯定的被认为是 1!这个结果相较于 fGarch 包来说,更加糟糕。

让我们看看其他参数的行为。

library(reshape2)

library(plyr)

library(dplyr)

param_reshape <- function(p)

{

p <- as.data.frame(p)

p$t <- as.integer(rownames(p))

pnew <- melt(p, id.vars = "t", variable.name = "parameter")

pnew$parameter <- as.character(pnew$parameter)

pnew.se <- pnew[grepl("*.se", pnew$parameter), ]

pnew.se$parameter <- sub(".se", "", pnew.se$parameter)

names(pnew.se)[3] <- "se"

pnew <- pnew[!grepl("*.se", pnew$parameter), ]

return(

join(

pnew, pnew.se,

by = c("t", "parameter"),

type = "inner"))

}

ggp <- ggplot(

param_reshape(params),

aes(x = t, y = value)) +

geom_line() +

geom_ribbon(

aes(ymin = value - 2 * se,

ymax = value + 2 * se),

color = "grey",

alpha = 0.5) +

geom_hline(yintercept = 0.2, color = "blue") +

scale_y_continuous(

breaks = c(0, 0.2, 0.25, 0.5, 0.75, 1)) +

coord_cartesian(ylim = c(0, 1)) +

facet_grid(. ~ parameter)

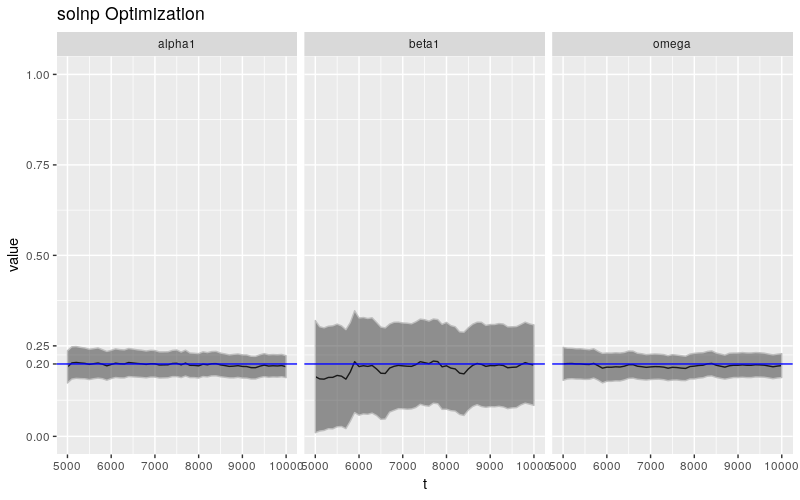

print(ggp + ggtitle("solnp Optimization"))

这种现象不仅限于 \(\beta\),\(\omega\) 和 \(\alpha\) 也表现出极端不良行为。

极端大样本

下面将样本总数扩充至 10000,连续估计的样本数从 5000 升至 10000,情况有会怎么样?

set.seed(110117)

x <- garchSim(

garchSpec(

model = list(alpha = 0.2, beta = 0.2, omega = 0.2)),

n.start = 1000, n = 10000)

params10k <- foreach(

t = seq(5000, 10000, 100),

.combine = rbind,

.packages = c("rugarch")) %dopar%

{

getFitDataRugarch(x[1:t])

}

rownames(params10k) <- seq(5000, 10000, 100)

params10k_df <- as.data.frame(params10k)

params10k_df$t <- as.numeric(rownames(params10k))

ggplot(params10k_df) +

geom_line(

aes(x = t, y = beta1)) +

geom_hline(

yintercept = 0.2, color = "blue") +

geom_ribbon(

aes(x = t,

ymin = beta1 - 2 * beta1.se,

ymax = beta1 + 2 * beta1.se),

color = "grey", alpha = 0.5) +

ylab(expression(hat(beta))) +

scale_y_continuous(

breaks = c(0, 0.2, 0.25, 0.5, 1)) +

coord_cartesian(ylim = c(0, 1))

结果堪称完美!之前的猜测是对的,样本要极端大才能保证估计的质量。

其他参数的行为。

ggp10k <- ggplot(

param_reshape(params10k),

aes(x = t, y = value)) +

geom_line() +

geom_ribbon(

aes(ymin = value - 2 * se,

ymax = value + 2 * se),

color = "grey",

alpha = 0.5) +

geom_hline(yintercept = 0.2, color = "blue") +

scale_y_continuous(

breaks = c(0, 0.2, 0.25, 0.5, 0.75, 1)) +

coord_cartesian(ylim = c(0, 1)) +

facet_grid(. ~ parameter)

print(ggp10k + ggtitle("solnp Optimization"))

相较于 \(\beta\),\(\omega\) 和 \(\alpha\) 的估计值更加稳定,这一节论和之前文章中的结论大体一致,参数估计的不稳定性集中体现在 \(\beta\) 身上。

结论

在一般大小样本量的情况下,rugarch 和 fGarch 的表现都不好,即使改变函数的最优化算法(相关代码未贴出)也于事无补。不过当样本量极端大时,rugarch 的稳定性大幅改善,这似乎印证了机器学习中的一个常见观点,即大样本 + 简单算法胜过小样本 + 复杂算法。

为了解决非大样本情况下估计的稳定性问题,有必要找到一种 bootstrap 方法,人为扩充现实问题中有限的样本量;或者借鉴机器学习的思路,对参数施加正则化约束。

在 R 中估计 GARCH 参数存在的问题(续)的更多相关文章

- 在 R 中估计 GARCH 参数存在的问题(基于 rugarch 包)

目录 在 R 中估计 GARCH 参数存在的问题(基于 rugarch 包) 导论 rugarch 简介 指定一个 \(\text{GARCH}(1, 1)\) 模型 模拟一个 GARCH 过程 拟合 ...

- 在 R 中估计 GARCH 参数存在的问题

目录 在 R 中估计 GARCH 参数存在的问题 GARCH 模型基础 估计 GARCH 参数 fGarch 参数估计的行为 结论 译后记 在 R 中估计 GARCH 参数存在的问题 本文翻译自< ...

- R语言命令行参数

批量画图任务中,需要在R中传入若干参数,之前对做法是在perl中每一个任务建立一个Rscript,这种方式超级不cool,在群里学习到R的@ARGV调用方式,差不多能够达到批量任务的要求: a ...

- 使用RStudio调试(debug)基础学习(二)和fGarch包中的garchFit函数估计GARCH模型的原理和源码

一.garchFit函数的参数--------------------------------------------- algorithm a string parameter that deter ...

- R中的par()函数的参数

把R中par()函数的主要参数整理了一下(另外本来还整理了每个参数的帮助文档中文解释,但是太长,就分类之后,整理为图表,excel不便放上来,就放了这些表的截图)

- shell中调用R语言并传入参数的两种步骤

shell中调用R语言并传入参数的两种方法 第一种: Rscript myscript.R R脚本的输出 第二种: R CMD BATCH myscript.R # Check the output ...

- R中的参数传递函数:commandArgs(),getopt().

1.commandArgs(),是R自带的参数传递函数,属于位置参数. ##test.R args=commandArgs(T) print (args[1])##第一个外部参数 print (arg ...

- 简单介绍一下R中的几种统计分布及常用模型

统计学上分布有很多,在R中基本都有描述.因能力有限,我们就挑选几个常用的.比较重要的简单介绍一下每种分布的定义,公式,以及在R中的展示. 统计分布每一种分布有四个函数:d――density(密度函数) ...

- R中的统计模型

R中的统计模型 这一部分假定读者已经对统计方法,特别是回归分析和方差分析有一定的了解.后面我们还会假定读者对广义线性模型和非线性模型也有所了解.R已经很好地定义了统计模型拟合中的一些前提条件,因此我们 ...

随机推荐

- 《Spring实战》-- 'cvc-complex-type.2.4.c: The matching wildcard is strict, but no declaration can be found for element' 错误的解决办法

在Eclipse中新建了一个maven项目学习Spring,在 service.xml 中配置 Spring,想要学习'面向切面的Spring',service.xml 内容如下: <beans ...

- flutter .g文件生成不了

[SEVERE] Conflicting outputs were detected and the build is unable to prompt for permission to remov ...

- 大数据【五】Hive(部署;表操作;分区)

一 概述 就像我们所了解的sql一样,Hive也是一种数据仓库,不同的是hive是在hadoop大数据生态圈中所用.这篇博客我主要介绍Hive的简单表运用. Hive是Hadoop 大数据生态圈中的数 ...

- 联想ThinkPadE455实现FN禁用(F1-F12标准功能与特殊功能切换)

系统:Win7 64 位 机型:联想ThinkPadE455笔记本 方法一:键盘Fn热键切换功能(亲测可用) Fn+Esc FnLk 组合键方法启用或禁用Fn锁定功能 具体说明(这个逻辑 ...

- TFS命令行操作

前言 本文主要介绍如何通过TFS(Team Foundation Server)命令行强制解锁(UnDo)项目成员对项目文件的占用. 正文 在多人同时开发项目的时候,如果遇到项目组成员独占签出文件后未 ...

- 转:.NET基础篇——反射的奥妙

反射是一个程序集发现及运行的过程,通过反射可以得到*.exe或*.dll等程序集内部的信息.使用反射可以看到一个程序集内部的接口.类.方法.字段.属性.特性等等信息.在System.Reflectio ...

- JAVA随机数之多种方法从给定范围内随机N个不重复数

一.JAVA中生成随机数的方式 1.在j2se中使用Math.random()令系统随机选取一个0~1之间的double类型小数,将其乘以一个数,比如25,就能得到一个0~25范围内的随机数,这个在j ...

- 【2017下集美大学软工1412班_助教博客】团队作业4——Alpha冲刺日志公示

作业要求 团队作业4--第一次项目冲刺(Alpha版本) 团队评分结果和评分标准 检查项 总分 会议内容 代码签入 心得体会或其他记录 燃尽图 会议照片 评论区反馈 组别 分值 10 2 2 2 1 ...

- ECStore图片云端集群存储实践-又拍云存储

通过又拍云存储REST API ,为ECStore新增图片存储引擎,从而达到图片数据与主站数据分离.提高网站性能. 图片存储引擎相关文件添加与修改 一共涉及到ECStore 2个APP 的文件添加和修 ...

- JSSDK图像接口多张图片上传下载并将图片流写入本地

<span style="font-size: 14px;"><!DOCTYPE html> <html lang="en"> ...