Centos 搭建Hadoop

Centos搭建Hadoop

- 一、搭建Hadoop需要JDK环境,首先配置JDK

- 二、下载haoop

- 三、在Centos服务器上解压下载好的安装包

- 四、修改配置文件

- 五、配置环节变量/etc/profile

- 六、格式化NameNode

- 七、启动hadoop进程

- 八、测试访问50070端口

- 九、启动yarn

- 踩坑填坑记录:

- 官网下载hadoop包,切记要下载好正确的tar.gz包,第一次因为下错包,导致各种各样的错误出现。

- 配置文件的修改,修改配置文件时,一定要细心细心再细心,常常因为输入一个字母或符号导致出错,之前配置时,因为多输入一个:,导致排查错误很多次。

- 配置文件(*-site.xml)中的主机名都可以换为ip。

- 如果使用主机名配置时,需要注意修改系统主机名和映射文件

- 启动yarn和dfs时,如果不想重复输入密码,则需要进行ssh免密码登录配置。

- WARNING: HADOOP_SECURE_DN_USER has been replaced by HDFS_DATANODE_SECURE_USER.

- hadoop 3.x 启动过程中 Permission denied (publickey,gssapi-keyex,gssapi-with-mic,password).

- hadoop 集群开启之后datanode没有启动

一、搭建Hadoop需要JDK环境,首先配置JDK

二、下载haoop

官网地址:hadoop官网下载地址

三、在Centos服务器上解压下载好的安装包

tar -zxvf hadoop-3.1.2.tar.gz

四、修改配置文件

进入到/hadoop/etc/hadoop目录,首先修改

4.1 hadoop-env.sh

添加export JAVA_HOME=/usr/java/jdk1.8.0.144;

添加:

# set hadoop environment virables

export HADOOP_HOME=/usr/local/hadoop

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

export HADOOP_OPTS="-Djava.library.path=$HADOOP_HOME/lib:$HADOOP_COMMON_LIB_NATIVE_DIR"

4.2 core-site.xml

添加如下信息:

<configuration>

<property>

<name>fs.default.name</name>

# 此处可能会埋坑,也可直接根据Ip进行设置如:hdfs://192.168.x.xx:9000

<value>hdfs://alary001:9000</value>

</property>

</configuration>

4.3 hdfs-site.xml

<configuration>

<property>

<name>dfs.name.dir</name>

# 需要在目录/usr/local/处新建一个名为data的文件夹

<value>/usr/local/data/datanode</value>

</property>

<property>

<name>dfs.data.dir</name>

<value>/usr/local/data/tmp</value>

</property>

<property>

# hadoop的备份系数

<name>dfs.replication</name>

<value>3</value>

</property>

</configuration>

dfs.replication一般设置多大的值比较合适?

dfs.replication=3表示冗余份数,这是hdfs的容错机制,防止有磁盘受损后数据损害。

Hadoop的备份系数是指每个block在hadoop集群中有几份,系数越高,冗余性越好,占用存储也越多。备份系数在hdfs-site.xml中定义,默认值为3.

4.4 mapred-site.xml

首先,需要查看是否有该配置文件,若无该文件,可以通过重命名mv mapred-site.xml.template mapred-site.xml改成此文件名。

修改内容如下:

<configuration>

<property>

# 指的是使用yarn运行mapreduce程序

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

启动了HDFS之后,就可以启动yarn了。执行命令start-yarn.sh即可启动MapReduce集群。

4.5 yarn-site.xml

修改内容如下:

<configuration>

<!-- Site specific YARN configuration properties -->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>alary001</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>

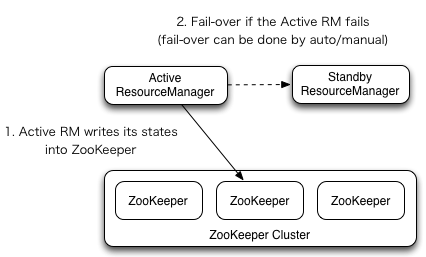

YARN中的资源管理器(Resource Manager)负责整个系统的资源管理和调度,并内部维护了各个应用程序的ApplictionMaster信息,NodeManager信息,资源使用信息等。在2.4版本之后,Hadoop Common同样提供了HA的功能,解决了这样一个基础服务的可靠性和容错性问题。

ResourceManager (RM)负责跟踪集群中的资源,以及调度应用程序(例如,MapReduce作业)。在Hadoop 2.4之前,集群中只有一个ResourceManager,当其中一个宕机时,将影响整个集群。高可用性特性增加了冗余的形式,即一个主动/备用的ResourceManager对,以便可以进行故障转移。

YARN HA的架构如下图所示:

五、配置环节变量/etc/profile

需要配置JAVA_HOME以及HADOOP的相关配置,配置内容如下:

export JAVA_HOME=/usr/local/java/jdk1.8.0_131

export CLASS_PATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

# set hadoop environment

export HADOOP_HOME=/usr/local/hadoop

export HADOOP_COMMON_HOME=$HADOOP_HOME

export HADOOP_HDFS_HOME=$HADOOP_HOME

export HADOOP_MAPRED_HOME=$HADOOP_HOME

export HADOOP_YARN_HOME=$HADOOP_HOME

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

export HADOOP_OPTS="-Djava.library.path=$HADOOP_HOME/lib"

export PATH=$JAVA_HOME/bin:$HADOOP_HOME/bin:$PATH:$HADOOP_HOME/sbin

然后执行source /etc/profile,让配置文件生效

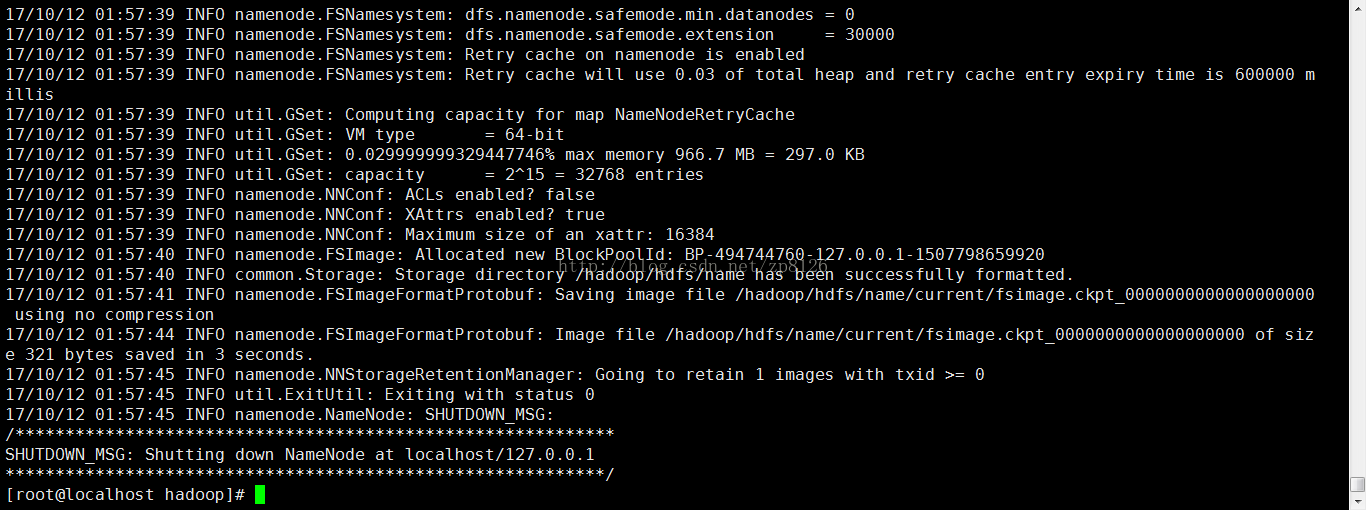

六、格式化NameNode

在任意目录下(配置Hadoop环境变量的情况下)执行命令:

hdfs namenode -format或者hadoop namenode -format

实现格式化。

七、启动hadoop进程

执行start-dfs.sh(注意中间没有空格);没有配置ssh免密登录之前,会不停的需要输入yes和密码,最后界面如图:

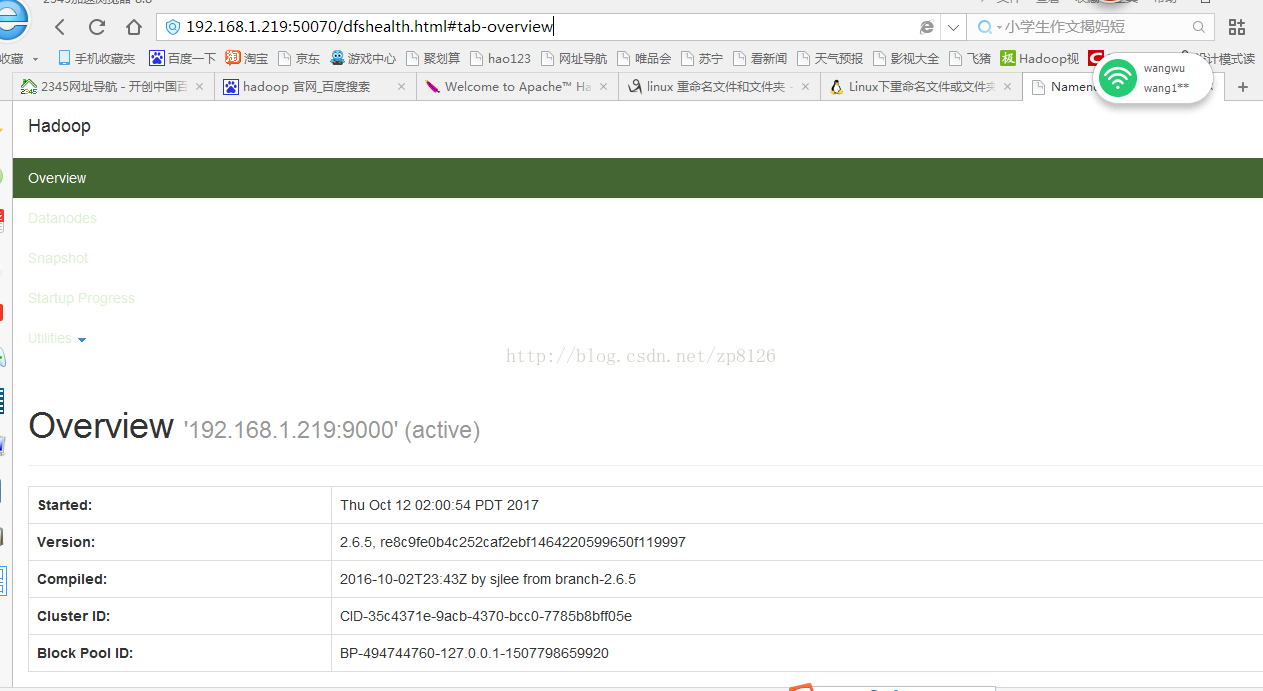

八、测试访问50070端口

关闭防火墙后,

service iptables stop

打开浏览器输入:http://192.168.x.xxx:50070/

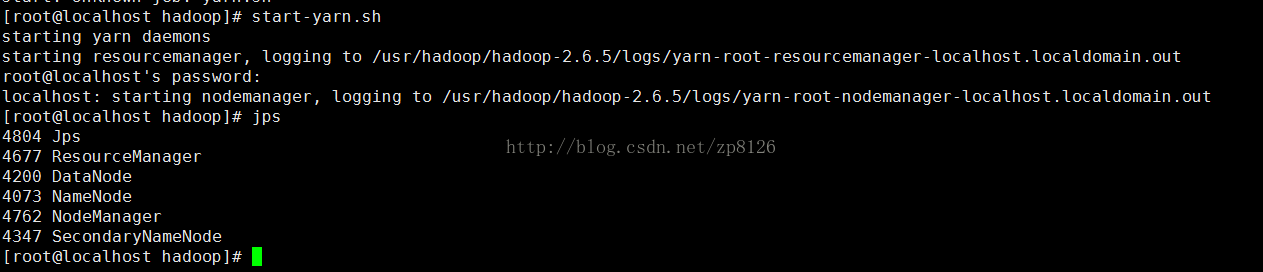

九、启动yarn

执行start-yarn.sh启动yarn计算进程。

在浏览器中:http://192.168.x.xxx:8088/打开主页面:

踩坑填坑记录:

官网下载hadoop包,切记要下载好正确的tar.gz包,第一次因为下错包,导致各种各样的错误出现。

配置文件的修改,修改配置文件时,一定要细心细心再细心,常常因为输入一个字母或符号导致出错,之前配置时,因为多输入一个:,导致排查错误很多次。

配置文件(*-site.xml)中的主机名都可以换为ip。

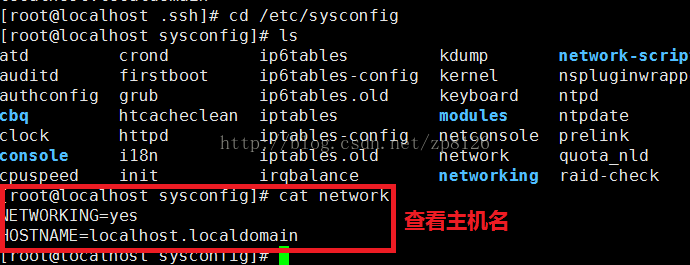

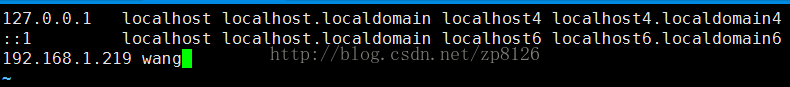

如果使用主机名配置时,需要注意修改系统主机名和映射文件

修改主机名称:

vi /etc/sysconfig/network

HOSTNAME=xxxx

配置映射信息:

启reboot,之后就可以使用主机名访问了 ,但是使用主机名访问只能虚拟机内。若需要在外部也使用主机名访问,在windows中配置hosts即可。

启动yarn和dfs时,如果不想重复输入密码,则需要进行ssh免密码登录配置。

WARNING: HADOOP_SECURE_DN_USER has been replaced by HDFS_DATANODE_SECURE_USER.

adoop启动时WARNING: HADOOP_SECURE_DN_USER has been replaced by HDFS_DATANODE_SECURE_USER. Using value of HADOOP_SECURE_DN_USER.错误。

解决方案,在$ vim sbin/start-dfs.sh $ vim sbin/stop-dfs.sh 将

HDFS_DATANODE_USER=root

HADOOP_SECURE_DN_USER=hdfs

HDFS_NAMENODE_USER=root

HDFS_SECONDARYNAMENODE_USER=root

改为:

HDFS_DATANODE_USER=root

HDFS_DATANODE_SECURE_USER=hdfs

HDFS_NAMENODE_USER=root

HDFS_SECONDARYNAMENODE_USER=root

hadoop 3.x 启动过程中 Permission denied (publickey,gssapi-keyex,gssapi-with-mic,password).

出现这种状况是因为当前账号没有配置ssh免密登录;

hadoop 3.x 启动过程中 Permission denied (publickey,gssapi-keyex,gssapi-with-mic,password).

hadoop 集群开启之后datanode没有启动

这个问题困扰了我很久,Master机器的各项都成功没有问题,slave机器的datanode各种启动不出来,尝试了网上的各种说法,最后还是有问题,但怀疑还是有部分配置没设置对,待查看。

hadoop 集群开启之后datanode没有启动

Centos 搭建Hadoop的更多相关文章

- 基于Centos搭建 Hadoop 伪分布式环境

软硬件环境: CentOS 7.2 64 位, OpenJDK- 1.8,Hadoop- 2.7 关于本教程的说明 云实验室云主机自动使用 root 账户登录系统,因此本教程中所有的操作都是以 roo ...

- Centos搭建spark

Centos搭建spark 一.spark介绍 二.spark安装前提 三.集群规划 四.spark安装 五.修改spark环境变量 六.修改spark-env.sh 七.修改slaves 八.将安装 ...

- hadoop集群搭建--CentOS部署Hadoop服务

在了解了Hadoop的相关知识后,接下来就是Hadoop环境的搭建,搭建Hadoop环境是正式学习大数据的开始,接下来就开始搭建环境!我们用到环境为:VMware 12+CentOS6.4 hadoo ...

- Centos搭建mysql/Hadoop/Hive/Hbase/Sqoop/Pig

目录: 准备工作 Centos安装 mysql Centos安装Hadoop Centos安装hive JDBC远程连接Hive Hbase和hive整合 Centos安装Hbase 准备工作: 配置 ...

- 『实践』VirtualBox 5.1.18+Centos 6.8+hadoop 2.7.3搭建hadoop完全分布式集群及基于HDFS的网盘实现

『实践』VirtualBox 5.1.18+Centos 6.8+hadoop 2.7.3搭建hadoop完全分布式集群及基于HDFS的网盘实现 1.基本设定和软件版本 主机名 ip 对应角色 mas ...

- 基于CentOS与VmwareStation10搭建hadoop环境

基于CentOS与VmwareStation10搭建hadoop环境 目 录 1. 概述.... 1 1.1. 软件准备.... 1 1.2. 硬件准备.... 1 2. 安装与配置虚拟机.. ...

- Hadoop 3.0完全分布式集群搭建方法(CentOS 7+Hadoop 3.2.0)

本文详细介绍搭建4个节点的完全分布式Hadoop集群的方法,Linux系统版本是CentOS 7,Hadoop版本是3.2.0,JDK版本是1.8. 一.准备环境 1. 在VMware worksta ...

- 基于Eclipse搭建Hadoop源码环境

Hadoop使用ant+ivy组织工程,无法直接导入Eclipse中.本文将介绍如何基于Eclipse搭建Hadoop源码环境. 准备工作 本文使用的操作系统为CentOS.需要的软件版本:hadoo ...

- virtualbox 虚拟3台虚拟机搭建hadoop集群

用了这么久的hadoop,只会使用streaming接口跑任务,各种调优还不熟练,自定义inputformat , outputformat, partitioner 还不会写,于是干脆从头开始,自己 ...

随机推荐

- Service Mesh——微服务中的流量管理中间件

Service Mesh--微服务中的流量管理中间件 摘自-https://zhuanlan.zhihu.com/p/28794062 Service mesh 与 Cloud Native Kube ...

- 自家公司关于git commit 的规范

代码提交的commit info提个建议,fix的issue是哪个issue?都要有明确的链接.推荐方式:1.建立issue,说明问题的背景和原因.http://git.startdt.net/pay ...

- Maven安装配置和IDEA创建Maven项目

maven 一个项目架构管理工具(约定大于配置) 1.配置 M2_HOME:指向maven bin目录 以后bootstrop要用 MAVEN_HOME:指向maven目录 path:指向maven ...

- [每日一题]面试官问:Async/Await 如何通过同步的方式实现异步?

关注「松宝写代码」,精选好文,每日一题 时间永远是自己的 每分每秒也都是为自己的将来铺垫和增值 作者:saucxs | songEagle 一.前言 2020.12.23 日刚立的 flag,每日一 ...

- Adnc如何本地调试 - 一个轻量级的.Net Core微服务开发框架

前言 Adnc是一个轻量级的.Net Core微服务开发框架,同样适用于单体架构系统的开发. 如果只是想本地调试,只需要安装必备软件,必备软件除开发工具外,其它软件建议大家都使用`do ...

- 大数据可视化呈现工具LightningChart的用法

LightningChart (LightningChart Ultimate) 软件开发工具包是微软VisualStudio 的一个插件,专攻大数据可视化呈现问题,用于WPF(WindowsPres ...

- JavaScript 内存详解 & 分析指南

前言 JavaScript 诞生于 1995 年,最初被设计用于网页内的表单验证. 这些年来 JavaScript 成长飞速,生态圈日益壮大,成为了最受程序员欢迎的开发语言之一.并且现在的 JavaS ...

- 你还不知道mysql中空值和null值的区别吗?

前言 最近发现带的小伙伴写sql对于空值的判断方法不正确,导致程序里面的数据产生错误,在此进行一下整理,方便大家以后正确的判断空值.以下带来示例给大家进行讲解. 建表 create table tes ...

- 【JAVA并发第三篇】线程间通信

线程间的通信 JVM在运行时会将自己管理的内存区域,划分为不同的数据区,称为运行时数据区.每个线程都有自己私有的内存空间,如下图示: Java线程按照自己虚拟机栈中的方法代码一步一步的执行下去,在这一 ...

- uni-app开发经验分享一: 多页面传值的三种解决方法

开发了一年的uni-app,在这里总结一些uni-app开发中的问题,提供几个解决方法,分享给大家: 问题描述:一个主页面,需要联通一到两个子页面,子页面传值到主页面,主页面更新 问题难点: 首先我们 ...