scrapy爬虫框架入门实例(一)

流程分析

抓取内容(百度贴吧:网络爬虫吧)

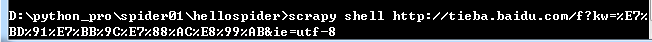

页面: http://tieba.baidu.com/f?kw=%E7%BD%91%E7%BB%9C%E7%88%AC%E8%99%AB&ie=utf-8

数据:1.帖子标题;2.帖子作者;3.帖子回复数

通过观察页面html代码来帮助我们获得所需的数据内容。

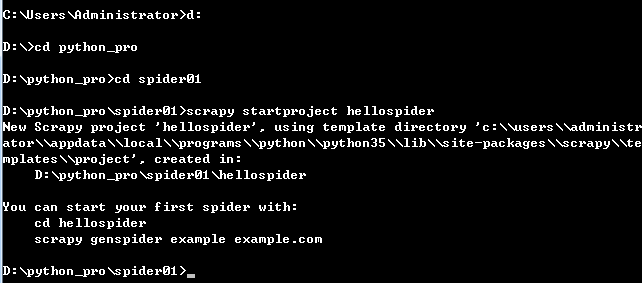

一、工程建立

在控制台模式下进入你要建立工程的文件夹执行如下命令创建工程:

二、实现过程

1、在items.py中定义自己要抓取的数据:

import scrapy class DetailItem(scrapy.Item):

# 抓取内容:1.帖子标题;2.帖子作者;3.帖子回复数

title = scrapy.Field()

author = scrapy.Field()

reply = scrapy.Field()

2、然后在spiders目录下编辑myspider.py那个文件:

import scrapy

from hellospider.items import DetailItem

import sys class MySpider(scrapy.Spider):

"""

name:scrapy唯一定位实例的属性,必须唯一

allowed_domains:允许爬取的域名列表,不设置表示允许爬取所有

start_urls:起始爬取列表

start_requests:它就是从start_urls中读取链接,然后使用make_requests_from_url生成Request,

这就意味我们可以在start_requests方法中根据我们自己的需求往start_urls中写入

我们自定义的规律的链接

parse:回调函数,处理response并返回处理后的数据和需要跟进的url

log:打印日志信息

closed:关闭spider

"""

# 设置name

name = "spidertieba"

# 设定域名

allowed_domains = ["baidu.com"]

# 填写爬取地址

start_urls = [

"http://tieba.baidu.com/f?kw=%E7%BD%91%E7%BB%9C%E7%88%AC%E8%99%AB&ie=utf-8",

] # 编写爬取方法

def parse(self, response):

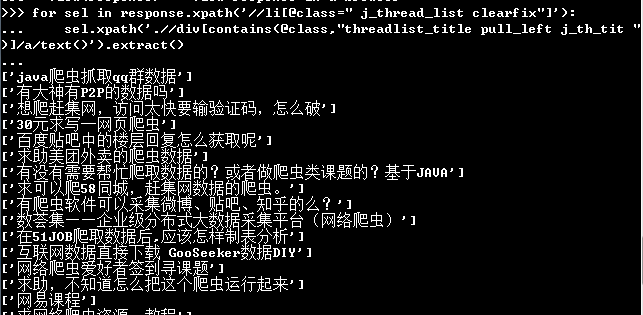

for line in response.xpath('//li[@class=" j_thread_list clearfix"]'):

# 初始化item对象保存爬取的信息

item = DetailItem()

# 这部分是爬取部分,使用xpath的方式选择信息,具体方法根据网页结构而定

item['title'] = line.xpath('.//div[contains(@class,"threadlist_title pull_left j_th_tit ")]/a/text()').extract()

item['author'] = line.xpath('.//div[contains(@class,"threadlist_author pull_right")]//span[contains(@class,"frs-author-name-wrap")]/a/text()').extract()

item['reply'] = line.xpath('.//div[contains(@class,"col2_left j_threadlist_li_left")]/span/text()').extract()

yield item

【注】xpath语法可参考:http://www.w3school.com.cn/xpath/xpath_syntax.asp

3、执行命令 scrapy crawl [类中name值]

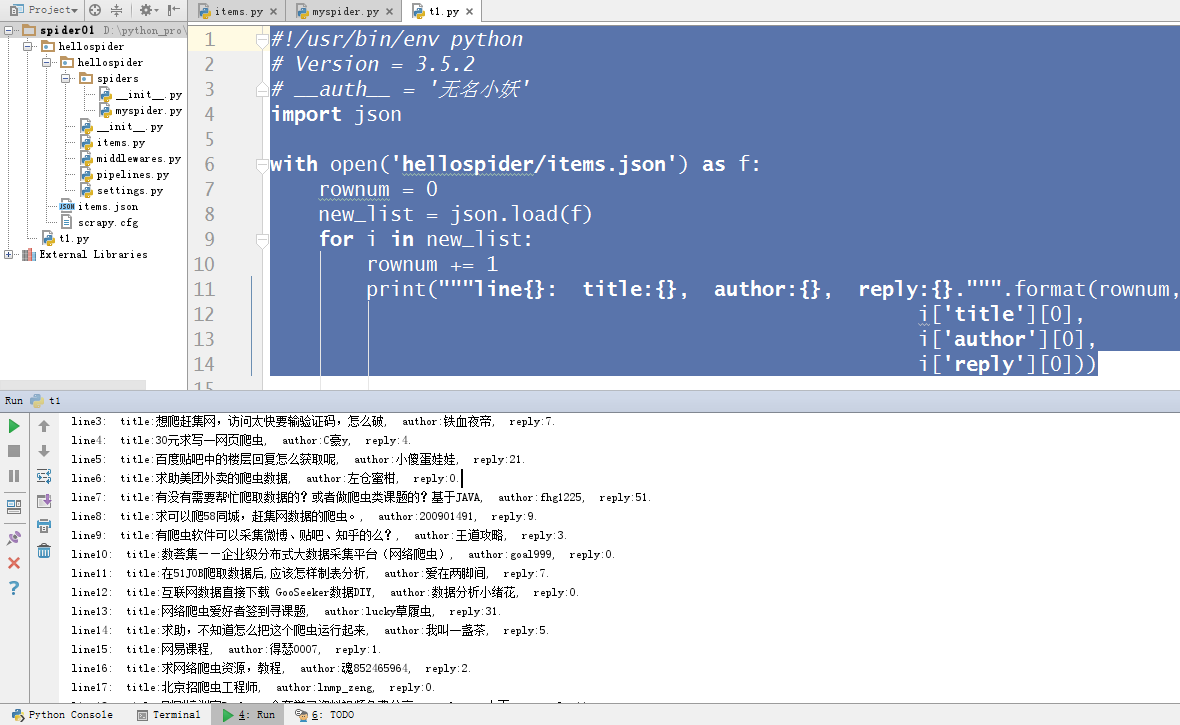

#!/usr/bin/env python

# Version = 3.5.2

# __auth__ = '无名小妖'

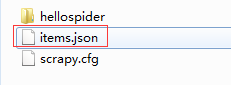

import json with open('hellospider/items.json') as f:

rownum = 0

new_list = json.load(f)

for i in new_list:

rownum += 1

print("""line{}: title:{}, author:{}, reply:{}.""".format(rownum,

i['title'][0],

i['author'][0],

i['reply'][0]))

至此,scrapy的最简单的应用就完成了。

后续还会有更复杂的爬虫示例,敬请关注!

scrapy爬虫框架入门实例(一)的更多相关文章

- Python之Scrapy爬虫框架 入门实例(一)

一.开发环境 1.安装 scrapy 2.安装 python2.7 3.安装编辑器 PyCharm 二.创建scrapy项目pachong 1.在命令行输入命令:scrapy startproject ...

- Scrapy 爬虫框架入门案例详解

欢迎大家关注腾讯云技术社区-博客园官方主页,我们将持续在博客园为大家推荐技术精品文章哦~ 作者:崔庆才 Scrapy入门 本篇会通过介绍一个简单的项目,走一遍Scrapy抓取流程,通过这个过程,可以对 ...

- 【python】Scrapy爬虫框架入门

说明: 本文主要学习Scrapy框架入门,介绍如何使用Scrapy框架爬取页面信息. 项目案例:爬取腾讯招聘页面 https://hr.tencent.com/position.php?&st ...

- [Python] Scrapy爬虫框架入门

说明: 本文主要学习Scrapy框架入门,介绍如何使用Scrapy框架爬取页面信息. 项目案例:爬取腾讯招聘页面 https://hr.tencent.com/position.php?&st ...

- scrapy爬虫框架入门教程

scrapy安装请参考:安装指南. 我们将使用开放目录项目(dmoz)作为抓取的例子. 这篇入门教程将引导你完成如下任务: 创建一个新的Scrapy项目 定义提取的Item 写一个Spider用来爬行 ...

- scrapy爬虫框架入门实战

博客 https://www.jianshu.com/p/61911e00abd0 项目源码 https://github.com/ppy2790/jianshu/blob/master/jiansh ...

- Python之Scrapy爬虫框架安装及简单使用

题记:早已听闻python爬虫框架的大名.近些天学习了下其中的Scrapy爬虫框架,将自己理解的跟大家分享.有表述不当之处,望大神们斧正. 一.初窥Scrapy Scrapy是一个为了爬取网站数据,提 ...

- scrapy爬虫框架教程(二)-- 爬取豆瓣电影TOP250

scrapy爬虫框架教程(二)-- 爬取豆瓣电影TOP250 前言 经过上一篇教程我们已经大致了解了Scrapy的基本情况,并写了一个简单的小demo.这次我会以爬取豆瓣电影TOP250为例进一步为大 ...

- scrapy爬虫框架教程(二)-- 爬取豆瓣电影

前言 经过上一篇教程我们已经大致了解了Scrapy的基本情况,并写了一个简单的小demo.这次我会以爬取豆瓣电影TOP250为例进一步为大家讲解一个完整爬虫的流程. 工具和环境 语言:python 2 ...

随机推荐

- 每天一个 Linux 命令(20):find命令之exec

find是我们很常用的一个Linux命令,但是我们一般查找出来的并不仅仅是看看而已,还会有进一步的操作,这个时候exec的作用就显现出来了. exec解释: -exec 参数后面跟的是command ...

- 基于redis分布式锁实现“秒杀”

转载:http://blog.5ibc.net/p/28883.html 最近在项目中遇到了类似“秒杀”的业务场景,在本篇博客中,我将用一个非常简单的demo,阐述实现所谓“秒杀”的基本思路. 业务场 ...

- iOS开发 - OC - 实现本地数据存储的几种方式二(直接使用sqlite)

连接上一篇文章http://www.cnblogs.com/FBiOSBlog/p/5819418.html. 上一篇文章介绍了OC内部一些方法进行数据的本地存储,其中包括 NSUser类.Plist ...

- 【转】HTML5 jQuery图片上传前预览

hTML5实现表单内的上传文件框,上传前预览图片,针刷新预览images,本例子主要是使用HTML5 的File API,建立一個可存取到该 file的url,一个空的img标签,ID为img0,把选 ...

- 转(zip文件格式说明)

zip文件由三部分组成:压缩的文件内容源数据.压缩的目录源数据.目录结束标识结构 1. 压缩的文件内容源数据: 记录着压缩的所有文件的内容信息,其数据组织结构是对于每个文件都由file header ...

- 实战p12文件转pem文件

1.首先生成一个ssl的证书 选择app IDS 后实现下面这个(这里不详细说明怎么生成了) 点击Download按钮,我就下载Development的ssl证书,下载成功后,双击运行,会打开钥匙串程 ...

- ORA-04021 timeout occurred while waiting to lock object

用户要求删除一个数据库的用户 GREENPASS,在删除的过程中,报错如下: drop user GREENPASS * ERROR at line 1: ORA-04021: timeout occ ...

- ios 设置声音和震动,单独控制

一.今天项目中涉及了设置这快的声音震动和响铃,搞的头大,以前搞过,只是简单的调用系统的方法就可以实现,但是现在的公司要求,震动是震动,响铃是响铃,我看了微信,微信也是的分开的,做的很好,但是我就纳闷了 ...

- python2.7.9基础学习

一. 基 础 python python开头两行注释代码意义: #!/usr/bin/python 是用来说明脚本语言是python的,是要用/usr/bin下面的程序(工具)py ...

- Linux Runlevel 启动 脚本

Linux 操作系统自从开始启动至启动完毕需要经历几个不同的阶段,这几个阶段就叫做 Runlevel,同样,当Linux操作系统关闭时也要经历另外几个不同的 Runlevel,下面详细介绍一下 Run ...