高可用Kubernetes集群-3. etcd高可用集群

五.部署高可用etcd集群

etcd是key-value存储(同zookeeper),在整个kubernetes集群中处于中心数据库地位,以集群的方式部署,可有效避免单点故障。

这里采用静态配置的方式部署(另也可通过etcd提供的rest api在运行时动态添加,修改或删除集群成员)。

以kubenode1为例,kubenode2&kubenode3做适当小调整。

1. 下载

[root@kubenode1 ~]# cd /usr/local/src/

[root@kubenode1 src]# wget https://github.com/coreos/etcd/releases/download/v3.3.0/etcd-v3.3.0-linux-amd64.tar.gz

[root@kubenode1 src]# tar -zxvf etcd-v3.3.0-linux-amd64.tar.gz # 解压目录整体拷贝并更名,可执行文件在解压目录中

[root@kubenode1 src]# mv etcd-v3.3.0-linux-amd64/ /usr/local/etcd

2. 创建etcd TLS证书与私钥

客户端(etcdctl)与etcd集群,etcd集群之间通信采用TLS加密。

1)创建etcd证书签名请求

[root@kubenode1 ~]# mkdir -p /etc/kubernetes/etcdssl

[root@kubenode1 ~]# cd /etc/kubernetes/etcdssl/

[root@kubenode1 etcdssl]# touch etcd-csr.json # hosts字段指定使用该证书的ip或域名列表,这里指定了所有节点ip,生成的证书可被etcd集群各节点使用,kubenode2&kubenode3节点可不用生成证书,由kubenode1直接分发即可

[root@kubenode1 etcdssl]# vim etcd-csr.json

{

"CN": "etcd",

"hosts": [

"127.0.0.1",

"172.30.200.21",

"172.30.200.22",

"172.30.200.23"

],

"key": {

"algo": "rsa",

"size": 2048

},

"names": [

{

"C": "CN",

"ST": "ChengDu",

"L": "ChengDu",

"O": "k8s",

"OU": "cloudteam"

}

]

}

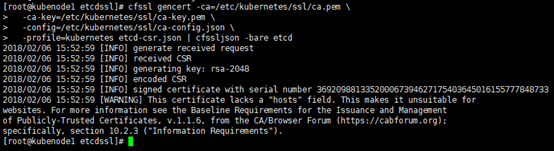

2)生成etcd证书与私钥

# 指定相应的ca证书,秘钥,签名文件等

[root@kubenode1 etcdssl]# cfssl gencert -ca=/etc/kubernetes/ssl/ca.pem \

-ca-key=/etc/kubernetes/ssl/ca-key.pem \

-config=/etc/kubernetes/ssl/ca-config.json \

-profile=kubernetes etcd-csr.json | cfssljson -bare etcd

# 分发etcd.pem,etcd-key.pem,另有ca.pem(前面已分发)

[root@kubenode1 etcdssl]# scp etcd.pem etcd-key.pem root@172.30.200.22:/etc/kubernetes/etcdssl/

[root@kubenode1 etcdssl]# scp etcd.pem etcd-key.pem root@172.30.200.23:/etc/kubernetes/etcdssl/

3. 设置iptables

[root@kubenode1 ~]# vim /etc/sysconfig/iptables

-A INPUT -p tcp -m state --state NEW -m tcp --dport 2379 -j ACCEPT

-A INPUT -p tcp -m state --state NEW -m tcp --dport 2380 -j ACCEPT [root@kubenode1 ~]# service iptables restart

4. 配置etcd的systemd unit文件

# 创建工作目录

[root@kubenode1 ~]# mkdir -p /var/lib/etcd # WorkingDirectory:指定工作/数据目录为上面创建的目录;

# EnvironmentFile:这里将etcd的启动参数放在unit文件之外,方便修改后不用重载;

# ExecStart:启动文件位置,并带上指定参数的变量

[root@kubenode1 ~]# touch /usr/lib/systemd/system/etcd.service

[root@kubenode1 ~]# vim /usr/lib/systemd/system/etcd.service

[Unit]

Description=Etcd Server

Documentation=https://github.com/coreos

After=network.target

After=network-online.target

Wants=network-online.target [Service]

Type=notify

WorkingDirectory=/var/lib/etcd/

EnvironmentFile=/usr/local/etcd/etcd.conf

ExecStart=/usr/local/etcd/etcd $ETCD_ARGS

Restart=on-failure

RestartSec=5

LimitNOFILE=65536 [Install]

WantedBy=multi-user.target # ETCD_ARGS:对应systemd unit文件中ExecStart后的变量;

# --cert-file,--key-file:分别指定etcd的公钥证书和私钥;

# --peer-cert-file,--peer-key-file:分别指定etcd的peers通信的公钥证书和私钥;

# --trusted-ca-file:指定客户端的CA证书;

# --peer-trusted-ca-file:指定peers的CA证书;

# --initial-cluster-state=new:表示这是新初始化集群,--name指定的参数值必须在--initial-cluster中

[root@kubenode1 ~]# touch /usr/local/etcd/etcd.conf

[root@kubenode1 ~]# vim /usr/local/etcd/etcd.conf

ETCD_ARGS="--name=kubenode1 \

--cert-file=/etc/kubernetes/etcdssl/etcd.pem \

--key-file=/etc/kubernetes/etcdssl/etcd-key.pem \

--peer-cert-file=/etc/kubernetes/etcdssl/etcd.pem \

--peer-key-file=/etc/kubernetes/etcdssl/etcd-key.pem \

--trusted-ca-file=/etc/kubernetes/ssl/ca.pem \

--peer-trusted-ca-file=/etc/kubernetes/ssl/ca.pem \

--initial-advertise-peer-urls=https://172.30.200.21:2380 \

--listen-peer-urls=https://172.30.200.21:2380 \

--listen-client-urls=https://172.30.200.21:2379,http://127.0.0.1:2379 \

--advertise-client-urls=https://172.30.200.21:2379 \

--initial-cluster-token=etcd-cluster-1 \

--initial-cluster=kubenode1=https://172.30.200.21:2380,kubenode2=https://172.30.200.22:2380,kubenode3=https://172.30.200.23:2380 \

--initial-cluster-state=new \

--data-dir=/var/lib/etcd"

5. 启动etcd

# 第一个启动的etcd进程会卡顿,等待其他etcd节点启动进程加入集群;

# 如果等待超时,则第一个etcd节点进程启动会失败

[root@kubenode1 ~]# systemctl daemon-reload

[root@kubenode1 ~]# systemctl enable etcd.service

[root@kubenode1 ~]# systemctl restart etcd.service

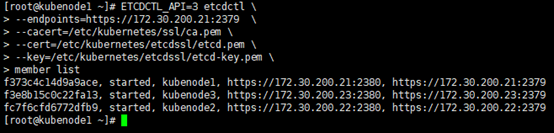

6. 验证

# 查看member list;

# ETCDCTL_API=3:api版本;

# 通信采用TLS加密,客户端访问时间需要指定对应公钥&私钥

[root@kubenode1 ~]# ETCDCTL_API=3 etcdctl \

--endpoints=https://172.30.200.21:2379 \

--cacert=/etc/kubernetes/ssl/ca.pem \

--cert=/etc/kubernetes/etcdssl/etcd.pem \

--key=/etc/kubernetes/etcdssl/etcd-key.pem \

member list

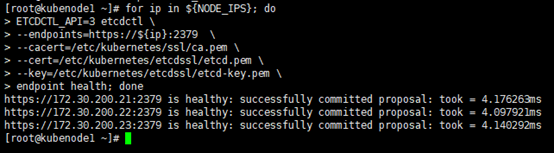

# 查看节点健康状态

[root@kubenode1 ~]# export NODE_IPS="172.30.200.21 172.30.200.22 172.30.200.23"

[root@kubenode1 ~]# for ip in ${NODE_IPS}; do

ETCDCTL_API=3 etcdctl \

--endpoints=https://${ip}:2379 \

--cacert=/etc/kubernetes/ssl/ca.pem \

--cert=/etc/kubernetes/etcdssl/etcd.pem \

--key=/etc/kubernetes/etcdssl/etcd-key.pem \

endpoint health; done

高可用Kubernetes集群-3. etcd高可用集群的更多相关文章

- 基于saltstack自动化部署高可用kubernetes集群

SaltStack自动化部署HA-Kubernetes 本项目在GitHub上,会不定期更新,大家也可以提交ISSUE,地址为:https://github.com/skymyyang/salt-k8 ...

- 高可用Kubernetes集群-16. ansible快速部署

说明 本文档指导采用二进制包的方式快速部署高可用kubernetes集群. 脚本托管:k8s-ansible(持续更新) 参考:高可用kubernetes集群 组件版本 组件 版本 备注 centos ...

- 高可用Kubernetes集群-1. 集群环境

参考文档: 部署kubernetes集群1:https://github.com/opsnull/follow-me-install-kubernetes-cluster 部署kubernetes集群 ...

- 高可用Kubernetes集群原理介绍

■ 文/ 天云软件 云平台开发工程师 张伟 1. 背景 Kubernetes作为容器应用的管理中心,对集群内部所有容器的生命周期进行管理,结合自身的健康检查及错误恢复机制,实现了集群内部应用层的高可用 ...

- 搭建高可用kubernetes集群(keepalived+haproxy)

序 由于单master节点的kubernetes集群,存在master节点异常之后无法继续使用的缺陷.本文参考网管流程搭建一套多master节点负载均衡的kubernetes集群.官网给出了两种拓扑结 ...

- 使用Kubeadm搭建高可用Kubernetes集群

1.概述 Kubenetes集群的控制平面节点(即Master节点)由数据库服务(Etcd)+其他组件服务(Apiserver.Controller-manager.Scheduler...)组成. ...

- K8S 使用Kubeadm搭建高可用Kubernetes(K8S)集群 - 证书有效期100年

1.概述 Kubenetes集群的控制平面节点(即Master节点)由数据库服务(Etcd)+其他组件服务(Apiserver.Controller-manager.Scheduler...)组成. ...

- 基于Containerd安装部署高可用Kubernetes集群

转载自:https://blog.weiyigeek.top/2021/7-30-623.html 简述 Kubernetes(后续简称k8s)是 Google(2014年6月) 开源的一个容器编排引 ...

- hype-v上centos7部署高可用kubernetes集群实践

概述 在上一篇中已经实践了 非高可用的bubernetes集群的实践 普通的k8s集群当work node 故障时是高可用的,但是master node故障时将会发生灾难,因为k8s api serv ...

随机推荐

- JNI由浅入深_2_C语言基础

*含义 1.乘法 3*5 2.定义指针变量 int * p://定义了一个名字叫p的变量,能够存放int数据类型的地址 3.指针运算符, //如果p是一个已经定义好的指针变量则*p表示以p的内容为地址 ...

- HDU 1213(裸并查集)(无变形)

题目链接: http://acm.hdu.edu.cn/showproblem.php?pid=1213 How Many Tables Time Limit: 2000/1000 MS (Java/ ...

- WebRTC博客推荐

1. http://www.cnblogs.com/lingyunhu/ 2. http://www.jianshu.com/u/eadc7531ecb8

- Linux环境下部署SpringBoot项目

1.在pom文件中添加maven插件 <build> <plugins> <plugin> <groupid>org.springframework.b ...

- 小程序的get和post需要注意的地方

在进行异步请求之前先去小程序后台配置好服务器域名. get请求:header: { 'content-type':'json'}就可以. post请求:header: { 'content-type' ...

- [转载]单点登录SSO:概述与示例

原文地址: https://www.cnblogs.com/baibaomen/p/sso.html 目录 概述 演示一:零改造实施单点登录 演示二: 单点注销 演示三:集成AD认证 演示四:客户端单 ...

- staticmethod classmethod

1. 静态方法 @staticmethod 只是名义上归类管,实际上静态方法里访问不了类或者实例中的任何属性 2. 类方法 @classmethod 只能访问类变量,不能访问实例变量 3.属性方法 @ ...

- 菜鸟级渣渣 关于MAC系统开发java的吐槽

最开始买电脑的时候不知道为什么脑子一抽买了个苹果.因为不知道和谁聊的.后期服务器大部分都是linux系统,后期也要学linux系统.mac系统类似linux系统.然后就买了个mac,感觉凭借自己的聪明 ...

- nRF52832 BLE_DFU空中升级OTA(二)编译下载(SDK14.2.0)

上一篇配置好了开发环境,现在就可以试着跑一下例程了,这里需要两个例程,一个是bootloader的,一个是应用程序的,其路径分别为: bootloader:SDK_14.2.0工程\examples\ ...

- 从零开始一个http服务器(六)-多路复用和压力测试

从零开始一个http服务器(六)-多路复用和压力测试 代码地址 : https://github.com/flamedancer/cserver git checkout step6 运行: make ...