机器学习常见的几种评价指标:精确率(Precision)、召回率(Recall)、F值(F-measure)、ROC曲线、AUC、准确率(Accuracy)

原文链接:https://blog.csdn.net/weixin_42518879/article/details/83959319

主要内容:机器学习中常见的几种评价指标,它们各自的含义和计算(注意本文针对二元分类器!)

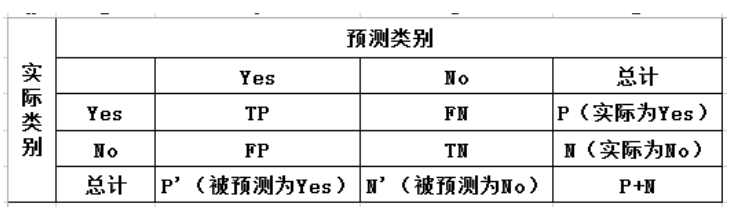

1、混淆矩阵

True Positive(真正,TP):将正类预测为正类的数目

True Negative(真负, TN):将负类预测为负类的数目

False Positive(假正,FP):将负类预测为正类的数目(Type I error)

False Negative(假负,FN):将正类预测为负类的数目(Type II error)

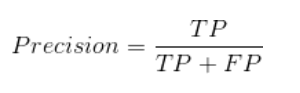

2、精确率(Precision)

精确率表示被分为正例的实例中实际为里正例的比例。

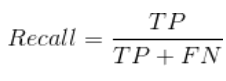

3、召回率(Recall)

召回率表示所有实际为正例的实例被预测为正例的比例,等价于灵敏度(Sensitive)

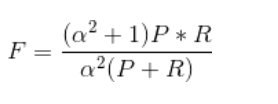

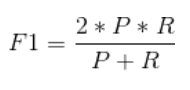

4、综合评价指标(F-Measure)

Precision和Recall有时会出现矛盾的情况,为了综合考虑他们,我们常用的指标就是F-Measure,F值越高证明模型越有效。

F-Measure是Precision和Recall的加权调和平均。

当参数α=1时,就是我们最常见的F1。

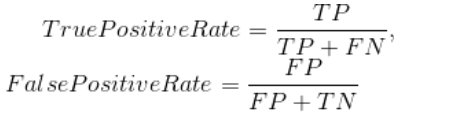

5、ROC曲线和AUC(Area Under Curve)

在二分类中,我们通常会对每个样本计算一个概率值,再根据概率值判断该样本所属的类别,那么这时就需要设定一个阈值来划定正负类。这个阈值的设定会直接影响到Precision和Recall,但是对于AUC的影响较小,因此我们通过做ROC曲线并计算AUC的值来对模型进行更加综合的评价。

ROC曲线的作图原理如下:假设我们的测试集一共有n个样本,那么我们会对每个样本得到一个概率,以每个概率为阈值计算此时的"True Positive Rate"和"False Positive Rate"值,共得到n对值(n个点)。然后以"True Positive Rate"作为纵轴,"False Positive Rate"作为横轴,以这n个点的数据作图画出ROC曲线。

AUC(Area Under Curve)即为ROC曲线下的面积。

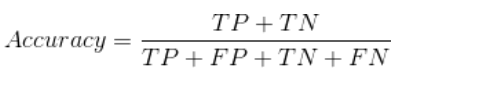

6、准确率(Accuracy)

准确率是我们最常用的评价指标,就是所有实例中被预测正确的比例,但是当数据存在不平衡时,准确率不能很全面地评价模型表现的好坏。

7、具体计算

以上各种评价指标的计算都可以通过sklearn.metrics中的相关功能实现,参考链接:sklearn.metrics中的评估方法介绍

机器学习常见的几种评价指标:精确率(Precision)、召回率(Recall)、F值(F-measure)、ROC曲线、AUC、准确率(Accuracy)的更多相关文章

- 准确率(Accuracy), 精确率(Precision), 召回率(Recall)和F1-Measure

yu Code 15 Comments 机器学习(ML),自然语言处理(NLP),信息检索(IR)等领域,评估(Evaluation)是一个必要的 工作,而其评价指标往往有如下几点:准确率(Accu ...

- 准确率(Accuracy), 精确率(Precision), 召回率(Recall)和F1-Measure(对于二分类问题)

首先我们可以计算准确率(accuracy),其定义是: 对于给定的测试数据集,分类器正确分类的样本数与总样本数之比.也就是损失函数是0-1损失时测试数据集上的准确率. 下面在介绍时使用一下例子: 一个 ...

- 精确率与召回率,RoC曲线与PR曲线

在机器学习的算法评估中,尤其是分类算法评估中,我们经常听到精确率(precision)与召回率(recall),RoC曲线与PR曲线这些概念,那这些概念到底有什么用处呢? 首先,我们需要搞清楚几个拗口 ...

- 目标检测评价指标mAP 精准率和召回率

首先明确几个概念,精确率,召回率,准确率 精确率precision 召回率recall 准确率accuracy 以一个实际例子入手,假设我们有100个肿瘤病人. 95个良性肿瘤病人,5个恶性肿瘤病人. ...

- 机器学习性能指标精确率、召回率、F1值、ROC、PRC与AUC--周振洋

机器学习性能指标精确率.召回率.F1值.ROC.PRC与AUC 精确率.召回率.F1.AUC和ROC曲线都是评价模型好坏的指标,那么它们之间有什么不同,又有什么联系呢.下面让我们分别来看一下这几个指标 ...

- 二分类算法的评价指标:准确率、精准率、召回率、混淆矩阵、AUC

评价指标是针对同样的数据,输入不同的算法,或者输入相同的算法但参数不同而给出这个算法或者参数好坏的定量指标. 以下为了方便讲解,都以二分类问题为前提进行介绍,其实多分类问题下这些概念都可以得到推广. ...

- 准确率、精确率、召回率、F1

在搭建一个AI模型或者是机器学习模型的时候怎么去评估模型,比如我们前期讲的利用朴素贝叶斯算法做的垃圾邮件分类算法,我们如何取评估它.我们需要一套完整的评估方法对我们的模型进行正确的评估,如果模型效果比 ...

- 一文让你彻底理解准确率,精准率,召回率,真正率,假正率,ROC/AUC

参考资料:https://zhuanlan.zhihu.com/p/46714763 ROC/AUC作为机器学习的评估指标非常重要,也是面试中经常出现的问题(80%都会问到).其实,理解它并不是非常难 ...

- [机器学习] 性能评估指标(精确率、召回率、ROC、AUC)

混淆矩阵 介绍这些概念之前先来介绍一个概念:混淆矩阵(confusion matrix).对于 k 元分类,其实它就是一个k x k的表格,用来记录分类器的预测结果.对于常见的二元分类,它的混淆矩阵是 ...

随机推荐

- Python 变量与运算符

变量 基本概念: 1. 变量,名字,数据的唯一标识2.变量命名: 字母.数字.下划线: 不能以数字开头: 区分大小写: 不能使用保留字和关键字: 命名要有意义:(多个单词时,推荐使用下划线连接) 3. ...

- PAT 1010 Radix 进制转换+二分法

Given a pair of positive integers, for example, 6 and 110, can this equation 6 = 110 be true? The an ...

- vue小案例--简易评论区

一.小案例(评论区) 1.流程 (1)分析静态页面.(vue项目创建参考https://www.cnblogs.com/l-y-h/p/11241503.html)(2)拆分静态页面,变成一个个组件. ...

- Mac进行Flutter的相关开发配置

参考链接:https://www.cnblogs.com/tangtianming/p/10797227.html

- MarkDown使用小技巧

写作目的 笔者看完一些MarkDown入门文字后,发现很多文档对一些容易遇到的细微问题缺少解释.本文意欲稍作补充. 目标读者 使用MarkDown仅为了排版出更好看的文章,而不关注技术细节,不懂HTM ...

- Quasar framework 配置vue apollo

Quasar 整合 vue-apollo 确保你已经知道quasar 和 vue apollo 在quasar中使用vue apollo客户端时出现的一点小问题 在quasar项目中使用vue-apo ...

- CCPC2018-湖南全国邀请赛

传送门 A - Easy \(h\)-index 签到. Code /* * Author: heyuhhh * Created Time: 2019/10/29 11:58:23 */ #inclu ...

- 阿里云 centos7安装docker出行的问题;

问题1:yum install **时报Delta RPMs disabled because /usr/... yum -y install deltarpm即可: 问题2:yum install ...

- Acwing43 不分行从上往下打印二叉树

地址 https://www.acwing.com/problem/content/description/41/ 从上往下打印出二叉树的每个结点,同一层的结点按照从左到右的顺序打印. 样例 输入如下 ...

- Java之Random类

什么是Random类 此类的实例用于生成伪随机数,使用此类中的方法能够得到一个随机数. Random使用步骤 查看类 java.util.Random :该类需要 import导入使后使用. 查看构造 ...