Python给小说做词云

闲暇时间喜欢看小说,就想着给小说做词云,展示小说的主要内容。开发语言是Python,主要用到的库有wordcloud、jieba、scipy。代码很简单,首先用jieba.cut()函数做分词,生成以空格分割的字符串,然后新建WordCloud类,保存为图片。

#coding:utf-8

import sys

import jieba

import matplotlib.pyplot as plt

from wordcloud import WordCloud,ImageColorGenerator

from scipy.misc import imread

from datetime import datetime novel=sys.argv[1] #'assz.txt'

imgmask=sys.argv[2] #'assz.jpg'

t=datetime.now()

resimg="word_"+novel.split('.')[0]+"_"+str(t.month)+str(t.day)+str(t.hour)+str(t.minute)+str(t.second)+".jpg" novletext=open(novel).read()

hmseg=jieba.cut(novletext) seg_space=' '.join(hmseg) alice_color=imread(imgmask)

#wordcloud默认不支持中文,这里的font_path需要指向中文字体,不然得到的词云全是乱码

fwc=WordCloud(font_path='msyh.ttc',max_words=700,background_color='white',mask=alice_color,max_font_size=100,font_step=1).generate(seg_space)

imagecolor=ImageColorGenerator(alice_color)

plt.imshow(fwc.recolor(color_func=imagecolor))

plt.axis("off")

plt.show()

fwc.to_file(resimg)

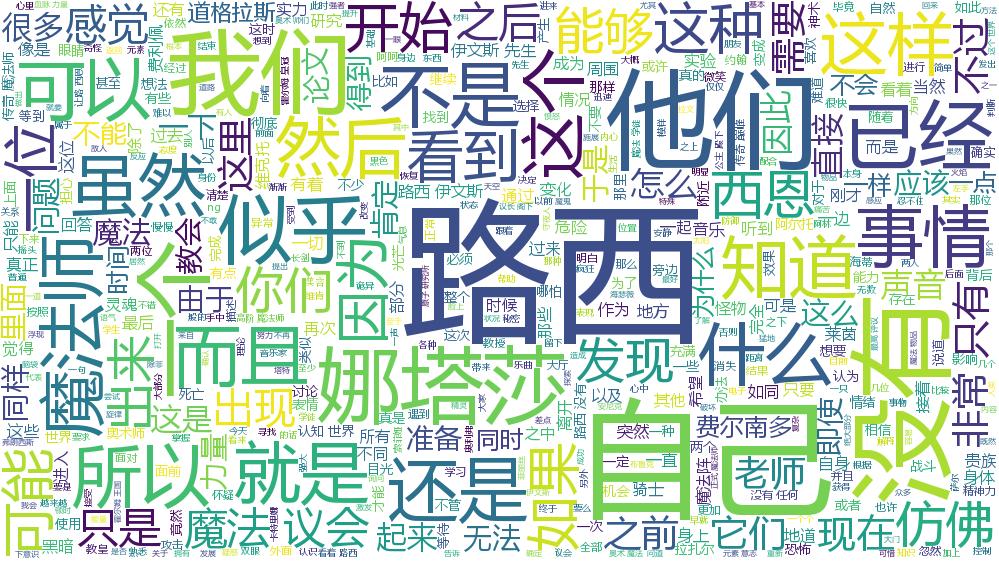

结果如下

得到的结果很不理想,一是角色的名字被分割开,比如“路西恩”被分割成了“路西”、“恩”或者“路”、“西恩”;二是“这样”、“那样”、“他们”这样的常用词太多,盖住了其他词语,让人无法确定小说的内容。

因此在生成词云之前,还得先生成一个过滤表,把“这样”、“那样”、“他们”这样的常用词去掉,不参与词云展示。这里我选了《斗破苍穹》《回到过去变成猫》《奥术神座》《灭运图录》《一世之尊》5本书,求出词频并排序,取每本书出现频率最高的1500个词,如果一个词在这7500个词中出现两次(不含)以上,则认为是高频常用词,写入过滤表中。

#coding:utf-8

import os

import jieba def ff(dd):

return dd[1] def array2dic(arr):

segdict={}

for seg in arr:

if len(seg)<2:

continue

if seg in segdict:

segdict[seg]+=1

else:

segdict[seg]=1

return segdict novels=['斗破苍穹.txt','回到过去变成猫.txt','assz.txt','mytl.txt','yszz.txt']

freq=[]

for novel in novels:

maotext=open(novel).read()

seglist=jieba.cut(maotext)

segdict=array2dic(seglist) c=1

segsort=sorted(segdict.items(),key=ff,reverse=True)

for item in segsort:

#print(item[0]+' '+str(item[1]))

freq.append(item[0])

if c==1500:

break

c+=1 freqdict=array2dic(freq)

freqsort=sorted(freqdict.items(),key=ff,reverse=True)

k=1

f=open('filter3.txt','w+')

for item in freqsort:

if item[1]>3:

f.write(item[0]+" ")

if k%5==0:

f.write("\n")

k+=1

f.close()

print('ok')

同时,在分词之前,添加新词,保证分词准确。修改后的代码如下

#coding:utf-8

import sys

import jieba

import matplotlib.pyplot as plt

from wordcloud import WordCloud,ImageColorGenerator

from scipy.misc import imread

from datetime import datetime jieba.add_word('路西恩')

jieba.add_word('恐怖如斯') def customfilter(segs):

filter=open('filter.txt').read()

resseg=""

for seg in segs:

if seg not in filter:

resseg+=' '+seg

return resseg novel=sys.argv[1] #'assz.txt'

imgmask=sys.argv[2] #'assz.jpg'

t=datetime.now()

resimg="word_"+novel.split('.')[0]+"_"+str(t.month)+str(t.day)+str(t.hour)+str(t.minute)+str(t.second)+".jpg" novletext=open(novel).read()

hmseg=jieba.cut(novletext) seg_space=customfilter(hmseg) alice_color=imread(imgmask) fwc=WordCloud(font_path='msyh.ttc',max_words=700,background_color='white',mask=alice_color,max_font_size=100,font_step=1).generate(seg_space)

imagecolor=ImageColorGenerator(alice_color)

plt.imshow(fwc.recolor(color_func=imagecolor))

plt.axis("off")

plt.show()

fwc.to_file(resimg)

成果代码

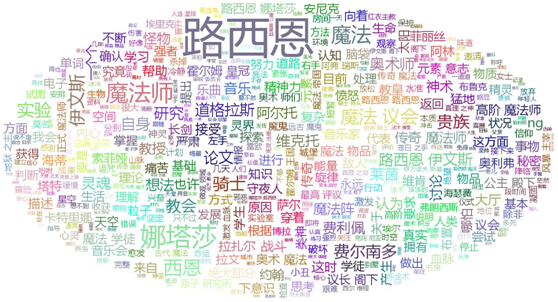

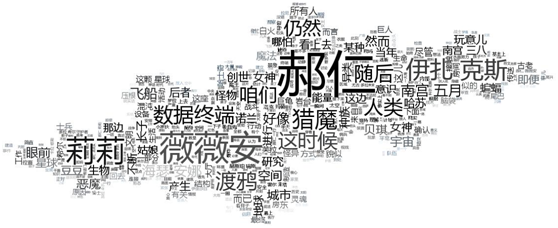

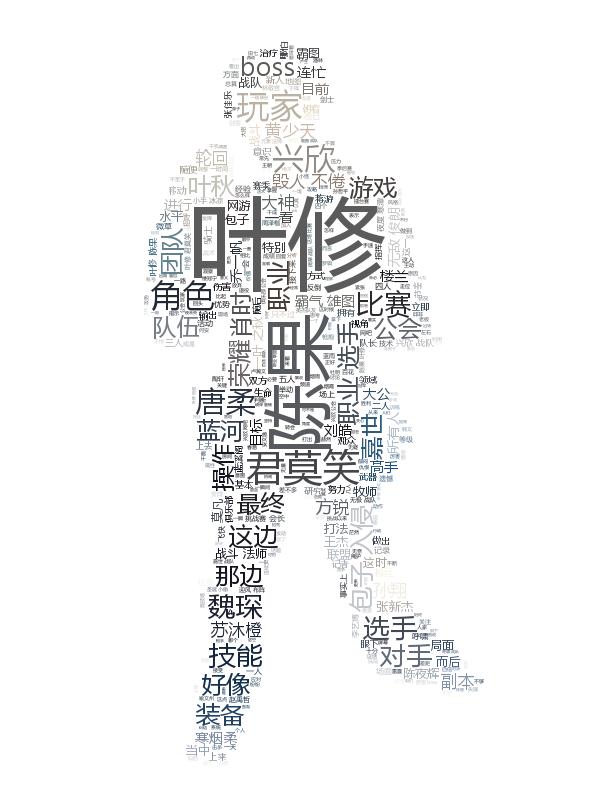

这样的结果比之前进步不小。

从词云上能看出不少有意思的规律,比如:有女主的小说,女主的名字出现频率往往仅次于主角。比如路西恩与娜塔莎,郝仁与薇薇安。但是全职里陈果在词频上享受了女主的待遇,钦点的女主苏沐橙反倒要仔细找才能看到。

Python给小说做词云的更多相关文章

- 如何用Python做词云(收藏)

看过之后你有什么感觉?想不想自己做一张出来? 如果你的答案是肯定的,我们就不要拖延了,今天就来一步步从零开始做个词云分析图.当然,做为基础的词云图,肯定比不上刚才那两张信息图酷炫.不过不要紧,好的开始 ...

- 一步一步教你如何用Python做词云

前言 在大数据时代,你竟然会在网上看到的词云,例如这样的. 看到之后你是什么感觉?想不想自己做一个? 如果你的答案是正确的,那就不要拖延了,现在我们就开始,做一个词云分析图,Python是一个当下很流 ...

- 如何用Python 制作词云-对1000首古诗做词云分析

公号:码农充电站pro 主页:https://codeshellme.github.io 今天来介绍一下如何使用 Python 制作词云. 词云又叫文字云,它可以统计文本中频率较高的词,并将这些词可视 ...

- python3做词云分析

python3做词云 其实词云一般分为两种,一个是权重比,一个是频次分析 主要还是体现在自然语言方向,难度较大,但这里我们用jieba词库 主要思路, 后端算数据+前端生成图(D3-cloud-好像是 ...

- 做词云时报错cannot import name ‘WordCloud‘ from partially initialized module ‘wordcloud‘的解决办法

问题: 在做词云时,运行时出现该问题,wordcloud安装成功,但运行出错,错误提示是:cannot import name 'WordCloud' from partially initializ ...

- 用Python做词云可视化带你分析海贼王、火影和死神三大经典动漫

对于动漫爱好者来说,海贼王.火影.死神三大动漫神作你肯定肯定不陌生了.小编身边很多的同事仍然深爱着这些经典神作,可见"中毒"至深.今天小编利用Python大法带大家分析一下这些神作 ...

- 用Python和WordCloud绘制词云(内附让字体清晰的秘笈)

环境及模块: Win7 64位 Python 3.6.4 WordCloud 1.5.0 Pillow 5.0.0 Jieba 0.39 目标: 绘制安徽省2018年某些科技项目的词云,直观展示热点. ...

- 【python数据挖掘】使用词云分析来分析豆瓣影评数据

概述: 制作词云的步骤: 1.从文件中读取数据 2.根据数据追加在一个字符串里面,然后用jieba分词器将评论分开 3.设置WordCloud词云参数 4.保存最后的结果 数据:使用爬取的豆瓣影评数据 ...

- 使用python制作大数据词云

1 from wordcloud import WordCloud 2 import PIL.Image as image 3 import numpy as np 4 import jieba 5 ...

随机推荐

- NodeJs之fs的读写删移监

NodeJs版本:4.4.4 fs 文件系统模块是一个封装了标准的 POSIX 文件 I/O 操作的集合.Node.js 文件系统(fs 模块)模块中的方法均有异步和同步版本. 图片的复制与粘贴 创建 ...

- 进程间通信系列 之 命名管道FIFO及其应用实例

进程间通信系列 之 概述与对比 http://blog.csdn.net/younger_china/article/details/15808685 进程间通信系列 之 共享内存及其实例 ...

- [进程管理]Load和CPU利用率是如何算出来的

本文内容遵从CC版权协议, 可以随意转载, 但必须以超链接形式标明文章原始出处和作者信息及版权声明 网址: http://www.penglixun.com/tech/system/how_to_ca ...

- Ruby读excel写入mysql

安装mysql2 打开cmd: gem install mysql2 代码 require 'win32ole' require 'mysql2' class String def addslashe ...

- add,update,list.jsp源码

add:<%@ page language="java" contentType="text/html; charset=UTF-8" pageEncod ...

- ESXi5.0误删除虚拟机还有办法恢复吗?答案是可以!

[数据恢复故障描述]故障的虚拟化系统是 ESXi5.0,连接了多个LUN,其中一个1T的LUN上跑有7 台虚拟机,均为Windows Server 2003,管理员因为其它原因误删除了一台虚拟机,此台 ...

- css小细节罗列

有空时候把一些常见可能不是每个人都知道的css小细节总结了下,共勉. 1.line-height 众多周知,line-height是行高的意思,我们时常会使用类似line-height:24px;这样 ...

- [笔记]我的Linux入门之路 - 03.Java环境搭建

其实ubuntu是自带一个叫openJDK的东西的,是谷歌看Oracle不爽而搞的.不过呢...总感觉不太习惯,况且我既然都来Linux了,总是想折腾一把的. 首先先检查下有没有安装java.终端输入 ...

- 域名系统DNS和FTP

域名系统概述 域名系统DNS(Domain Name System)是英特网使用的命名系统,用于把便于人们使用机器名字转化为IP地址. 为什么机器在处理IP数据报时要使用IP地址而不使用域名呢?IP地 ...

- 如何使用.bas文件

1. 确保你安装的是word 2010,打开word文档,,按ALT + F11打开VBE编辑器. 2.点击Normal,右键,在弹出的对话框中选择导入文件. 2. 选择需要使用的脚本的位置,然后点击 ...