【爬虫实战】用python爬豆瓣电影《热烈》短评

一、爬虫对象-豆瓣电影短评

您好!我是@马哥python说,一名10年程序猿。

今天分享一期爬虫案例,爬取的目标是:豆瓣上任意一部电影的短评(注意:是短评,不是影评!),以《热烈》这部电影为例:

爬取以上6个关键字段,含:

页码, 评论者昵称, 评论星级, 评论时间, 评论者IP属地, 有用数, 评论内容。

二、爬取结果

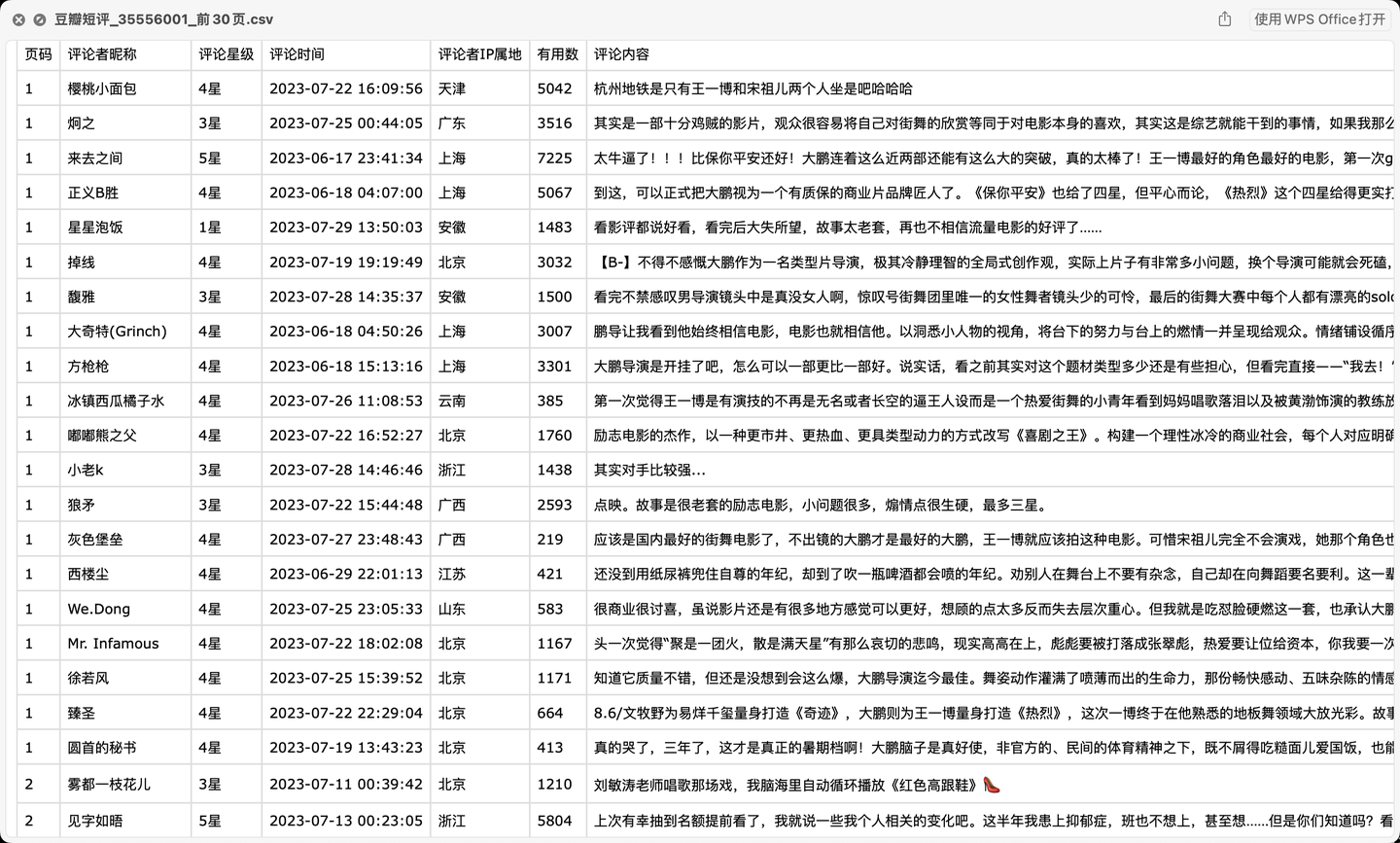

爬取结果截图:

三、爬虫代码讲解

首先,导入需要用到的库:

import requests

from bs4 import BeautifulSoup

import pandas as pd

import os

import random

from time import sleep

定义一个请求头:

# 请求头

h1 = {

'Cookie': '换成自己的cookie',

'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8',

'Accept-Encoding': 'gzip, deflate',

'Host': 'movie.douban.com',

'User-Agent': 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/605.1.15 (KHTML, like Gecko) Version/15.4 Safari/605.1.15',

'Accept-Language': 'zh-CN,zh-Hans;q=0.9',

'Referer': 'https://movie.douban.com/subject/35267224/?from=showing',

'Connection': 'keep-alive'

}

定义请求地址:(规律是:第1页start是0,第2页start是20,第3页start是40,所以总结出:start=(page-1)*20)

# 请求地址

url = 'https://movie.douban.com/subject/{}/comments?start={}&limit=20&status=P&sort=new_score'.format(v_movie_id, (page - 1) * 20)

用requests发送请求:

# 发送请求

response = requests.get(url, headers=h1, verify=False)

用BeautifulSoup解析页面数据:

# 解析页面数据

soup = BeautifulSoup(response.text, 'html.parser')

定义一些空列表,用于存放数据:

user_name_list = [] # 评论者昵称

star_list = [] # 评论星级

time_list = [] # 评论时间

ip_list = [] # 评论者ip属地

vote_list = [] # 有用数

content_list = [] # 评论内容

以"评论内容"字段为例:

for review in reviews:

# 评论内容

content = review.find('span', {'class': 'short'}).text

content = content.replace(',', ',').replace(' ', '').replace('\n', '').replace('\t', '').replace('\r', '')

content_list.append(content)

把所有字段存放的列表数据组成Dataframe格式:

df = pd.DataFrame(

{

'页码': page,

'评论者昵称': user_name_list,

'评论星级': star_list,

'评论时间': time_list,

'评论者IP属地': ip_list,

'有用数': vote_list,

'评论内容': content_list,

}

)

进一步保存到csv文件里:

# 保存到csv

df.to_csv(result_file, mode='a+', header=header, index=False, encoding='utf_8_sig')

print('文件保存成功:', result_file)

以上,核心逻辑讲解完毕。

代码中还含有:转换星级函数、自动翻页、文本清洗等功能,详见文末完整源码。

最后需要说明的是,豆瓣短评页面上最多只能看到30页,再往后翻页面一直显示载入中,所以该代码最多只能爬取30页短评。

三、演示视频

演示视频:【Python爬虫实战】爬取豆瓣电影短评,以《热烈》为例

四、获取完整源码

爱学习的小伙伴,本次分析过程的完整python源码及结果数据,我已打包好,并上传至我的微信公众号"老男孩的平凡之路",后台回复"爬豆瓣短评"即可获取。

我是@马哥python说,一名10年程序猿,持续分享python干货中!

【爬虫实战】用python爬豆瓣电影《热烈》短评的更多相关文章

- Python爬虫实战二之爬取百度贴吧帖子

大家好,上次我们实验了爬取了糗事百科的段子,那么这次我们来尝试一下爬取百度贴吧的帖子.与上一篇不同的是,这次我们需要用到文件的相关操作. 前言 亲爱的们,教程比较旧了,百度贴吧页面可能改版,可能代码不 ...

- Python爬虫实战一之爬取糗事百科段子

大家好,前面入门已经说了那么多基础知识了,下面我们做几个实战项目来挑战一下吧.那么这次为大家带来,Python爬取糗事百科的小段子的例子. 首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把 ...

- 转 Python爬虫实战二之爬取百度贴吧帖子

静觅 » Python爬虫实战二之爬取百度贴吧帖子 大家好,上次我们实验了爬取了糗事百科的段子,那么这次我们来尝试一下爬取百度贴吧的帖子.与上一篇不同的是,这次我们需要用到文件的相关操作. 本篇目标 ...

- 转 Python爬虫实战一之爬取糗事百科段子

静觅 » Python爬虫实战一之爬取糗事百科段子 首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把,这次我们尝试一下用爬虫把他们抓取下来. 友情提示 糗事百科在前一段时间进行了改版,导致 ...

- python简单爬豆瓣电影排名

爬豆瓣电影 网站分析: 1 打开https://movie.douban.com,选择 [排行榜],然后随便选择一类型,我这里选择科幻 2 一直浏览网页,发现没有下一的标签,是下滑再加载的,可 ...

- Python爬虫实战三之爬取嗅事百科段子

一.前言 俗话说,上班时间是公司的,下班了时间才是自己的.搞点事情,写个爬虫程序,每天定期爬取点段子,看着自己爬的段子,也是一种乐趣. 二.Python爬取嗅事百科段子 1.确定爬取的目标网页 首先我 ...

- 8.Python爬虫实战一之爬取糗事百科段子

大家好,前面入门已经说了那么多基础知识了,下面我们做几个实战项目来挑战一下吧.那么这次为大家带来,Python爬取糗事百科的小段子的例子. 首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把 ...

- Python爬虫实战一之爬取QQ音乐

一.前言 前段时间尝试爬取了网易云音乐的歌曲,这次打算爬取QQ音乐的歌曲信息.网易云音乐歌曲列表是通过iframe展示的,可以借助Selenium获取到iframe的页面元素, 而QQ音乐采用的是 ...

- python pandas 豆瓣电影 top250 数据分析

豆瓣电影top250数据分析 数据来源(豆瓣电影top250) 爬虫代码比较简单 数据较为真实,可以进行初步的数据分析 可以将前面的几篇文章中的介绍的数据预处理的方法进行实践 最后用matplotli ...

- 利用Python爬取电影网站

#!/usr/bin/env python #coding = utf-8 ''' 本爬虫是用来爬取6V电影网站上的电影资源的一个小脚本程序,爬取到的电影链接会通过网页的形式显示出来 ''' impo ...

随机推荐

- Kubernetes 证书详解(鉴权)

Kubernetes 证书详解(鉴权) 简介 上一篇 系统分析了 Kubernetes 集群中每个证书的作用和证书认证的原理.对于 Kube-apiserver,Kubelet 来说,它们都能提供 H ...

- Simple Date Format类到底为啥不是线程安全的?

摘要:我们就一起看下在高并发下Simple Date Format类为何会出现安全问题,以及如何解决Simple Date Format类的安全问题. 本文分享自华为云社区<[高并发]Simpl ...

- Kubernetes(k8s)服务service:service的发现和service的发布

目录 一.系统环境 二.前言 三.Kubernetes service简介 四.使用hostPort向外界暴露应用程序 4.1 创建deploy 4.2 使用hostPort向外界暴露pod的端口 五 ...

- 流量劫持 —— GZIP 页面零开销注入 JS

前言 HTTP 代理给页面注入 JS 是很常见的需求.由于上游服务器返回的页面可能是压缩状态的,因此需解压才能注入,同时为了节省流量,返回下游时还得再压缩.为了注入一小段代码,却将整个页面的流量解压再 ...

- ubuntu22.04下编译ffmpeg-6.0,并且激活x264编码功能。记录一下踩坑(ERROR: x264 not found using pkg-config)

一.编译x264(在编译前确保安装了pkg-config,默认在/usr/share下) 1.下载x264源代码:(我下载到了~/Downloads下,各位随意就好) git clone https: ...

- 使用 Sa-Token 实现不同的登录模式:单地登录、多地登录、同端互斥登录

一.需求分析 如果你经常使用腾讯QQ,就会发现它的登录有如下特点:它可以手机电脑同时在线,但是不能在两个手机上同时登录一个账号. 同端互斥登录,指的就是:像腾讯QQ一样,在同一类型设备上只允许单地点登 ...

- 了解前端中的BFC(块级格式化上下文)

BFC(块级格式化上下文) 什么是BFC 指的是一个块级渲染作用域,该区域内拥有一套完整的规则来约束块级盒子的布局,且与区域外部无关. 为什么要使用BFC 当一个盒子不设置高度,当其中的子元素都浮动时 ...

- 【Docker】部署Redis

1.下载镜像 #下载最新版Redis镜像 (其实此命令就等同于 : docker pull redis:latest ) docker pull redis # 下载指定版本的Redis镜像 (xxx ...

- 【转载】Linux虚拟化KVM-Qemu分析(一)

原文信息 作者:LoyenWang 出处:https://www.cnblogs.com/LoyenWang/ 公众号:LoyenWang 版权:本文版权归作者和博客园共有 转载:欢迎转载,但未经作者 ...

- Kerberos、黄金票据与白银票据

kerberos Kerberos是一个网络认证协议,用于验证用户和服务之间的身份,解决分布式计算环境中的身份验证问题.它使用加密技术来提供安全的身份验证,并防止网络中的身份欺骗攻击.Kerberos ...