《Enhanced LSTM for Natural Language Inference》(自然语言推理)

解决的问题

自然语言推理,判断a是否可以推理出b。简单讲就是判断2个句子ab是否有相同的含义。

方法

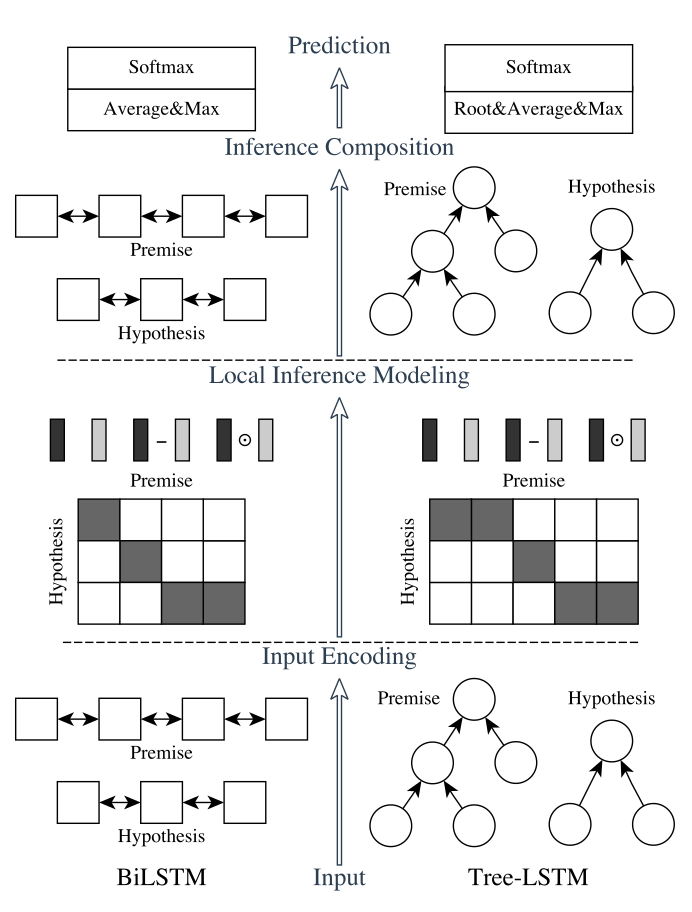

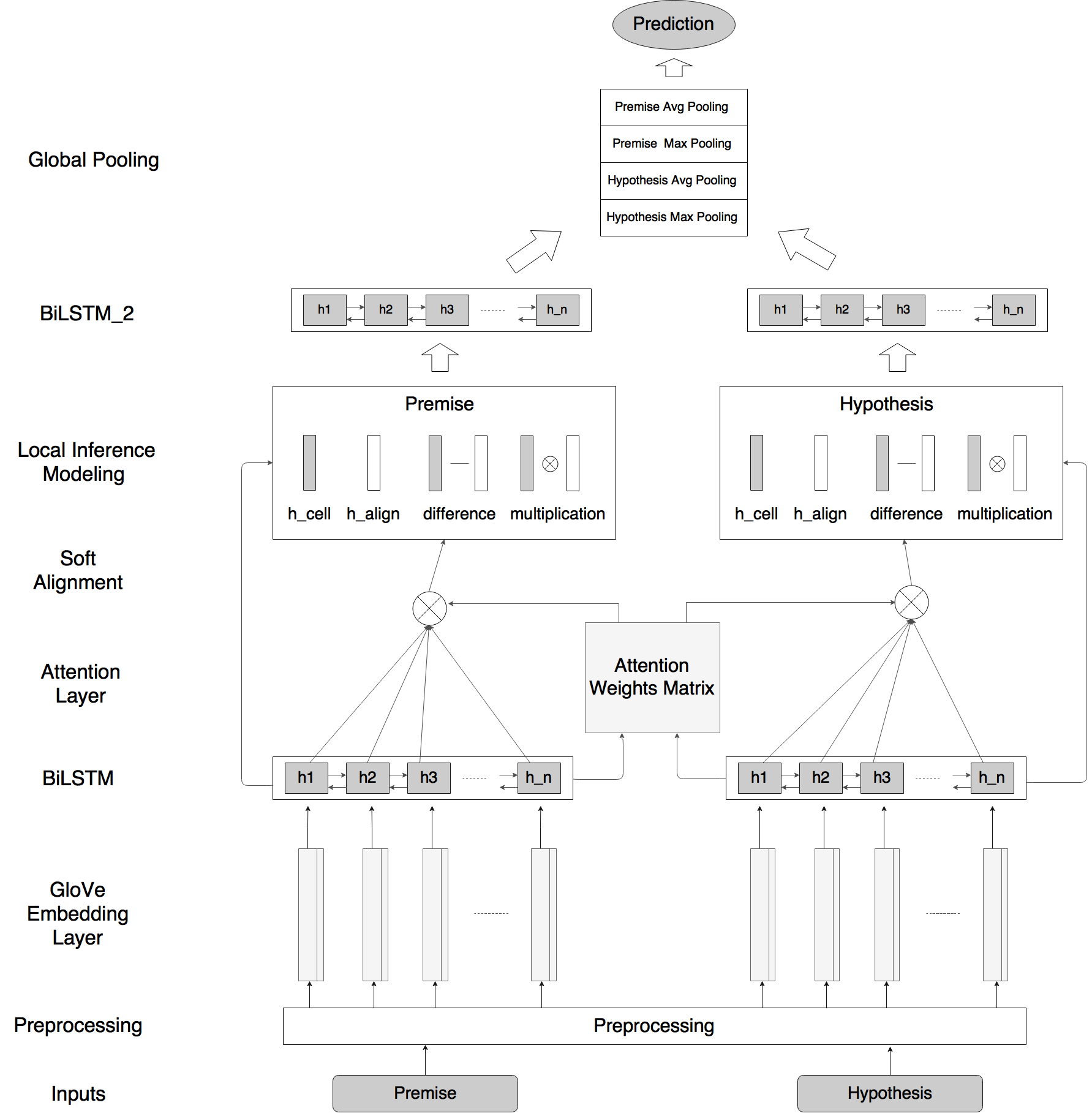

我们的自然语言推理网络由以下部分组成:输入编码(Input Encoding ),局部推理模型(Local Inference Modeling ),和推理合成(inference composition)。结构图如下所示:

垂直来看,上图显示了系统的三个主要组成部分;水平来看,左边代表称为ESIM的序列NLI模型,右边代表包含了句法解析信息的树形LSTM网络。

输入编码

# Based on arXiv:1609.06038

q1 = Input(name='q1', shape=(maxlen,))

q2 = Input(name='q2', shape=(maxlen,)) # Embedding

embedding = create_pretrained_embedding(

pretrained_embedding, mask_zero=False)

bn = BatchNormalization(axis=2)

q1_embed = bn(embedding(q1))

q2_embed = bn(embedding(q2)) # Encode

encode = Bidirectional(LSTM(lstm_dim, return_sequences=True))

q1_encoded = encode(q1_embed)

q2_encoded = encode(q2_embed)

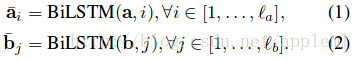

有2种lstm:

A: sequential model 的做法

句子中的每个词都有了包含周围信息的 word representation

B: Tree-LSTM model的做法

树中的每个节点(短语或字句)有了向量表示 htt

关于tree-LSTM 的介绍需要看文章:

[1] Improved semantic representations from tree-structured long short-term memory networks

[2] Natural Language inference by tree-based convolution and heuristic matching

[3] Long short-term memory over recursive structures

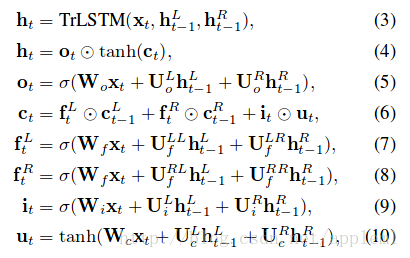

局部推理(Local Inference Modeling )

个人感觉就是一个attention的过程,取了个名字叫局部推理。

A: sequential model

def soft_attention_alignment(input_1, input_2):

"Align text representation with neural soft attention"

attention = Dot(axes=-1)([input_1, input_2]) #计算两个tensor中样本的张量乘积。例如,如果两个张量a和b的shape都为(batch_size, n),

#则输出为形如(batch_size,1)的张量,结果张量每个batch的数据都是a[i,:]和b[i,:]的矩阵(向量)点积。 w_att_1 = Lambda(lambda x: softmax(x, axis=1),

output_shape=unchanged_shape)(attention)

w_att_2 = Permute((2, 1))(Lambda(lambda x: softmax(x, axis=2),

output_shape=unchanged_shape)(attention))

#Permute层将输入的维度按照给定模式进行重排,例如,当需要将RNN和CNN网络连接时,可能会用到该层。

#dims:整数tuple,指定重排的模式,不包含样本数的维度。重拍模式的下标从1开始。

#例如(2,1)代表将输入的第二个维度重拍到输出的第一个维度,而将输入的第一个维度重排到第二个维度 in1_aligned = Dot(axes=1)([w_att_1, input_1])

in2_aligned = Dot(axes=1)([w_att_2, input_2])

return in1_aligned, in2_aligned

两句话相似或相反的对应

B: Tree-LSTM model

待续

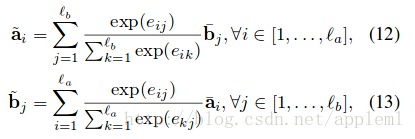

推理合成(inference composition)

a是上层局部推理得到的。

ma 输入LSTM

对 lstm 每个time step 的结果进行pooling.

# Compare

q1_combined = Concatenate()(

[q1_encoded, q2_aligned, submult(q1_encoded, q2_aligned)])

q2_combined = Concatenate()(

[q2_encoded, q1_aligned, submult(q2_encoded, q1_aligned)])

compare_layers = [

Dense(compare_dim, activation=activation),

Dropout(compare_dropout),

Dense(compare_dim, activation=activation),

Dropout(compare_dropout),

]

q1_compare = time_distributed(q1_combined, compare_layers)

q2_compare = time_distributed(q2_combined, compare_layers) # Aggregate

q1_rep = apply_multiple(q1_compare, [GlobalAvgPool1D(), GlobalMaxPool1D()])

q2_rep = apply_multiple(q2_compare, [GlobalAvgPool1D(), GlobalMaxPool1D()])

《Enhanced LSTM for Natural Language Inference》(自然语言推理)的更多相关文章

- <A Decomposable Attention Model for Natural Language Inference>(自然语言推理)

http://www.xue63.com/toutiaojy/20180327G0DXP000.html 本文提出一种简单的自然语言推理任务下的神经网络结构,利用注意力机制(Attention Mec ...

- 论文阅读笔记: Natural Language Inference over Interaction Space

这篇文章提出了DIIN(DENSELY INTERACTIVE INFERENCE NETWORK)模型. 是解决NLI(NATURAL LANGUAGE INFERENCE)问题的很好的一种方法. ...

- <<Natural Language Inference over Interaction Space >> 句子匹配

模型结构 code :https://github.com/YichenGong/Densely-Interactive-Inference-Network 首先是模型图: Embedding Lay ...

- 第四篇:NLP(Natural Language Processing)自然语言处理

NLP自然语言处理: 百度AI的 NLP自然语言处理python语言--pythonSDK文档: https://ai.baidu.com/docs#/NLP-Python-SDK/top 第三方模块 ...

- 《Bilateral Multi-Perspective Matching for Natural Language Sentences》(句子匹配)

问题: Natural language sentence matching (NLSM),自然语言句子匹配,是指比较两个句子并判断句子间关系,是许多任务的一项基本技术.针对NLSM任务,目前有两种流 ...

- Bilateral Multi-Perspective Matching for Natural Language Sentences---读书笔记

自然语言句子的双向.多角度匹配,是来自IBM 2017 年的一篇文章.代码github地址:https://github.com/zhiguowang/BiMPM 摘要 这篇论文主要 ...

- 论文笔记:Tracking by Natural Language Specification

Tracking by Natural Language Specification 2018-04-27 15:16:13 Paper: http://openaccess.thecvf.com/ ...

- 【翻译】Knowledge-Aware Natural Language Understanding(摘要及目录)

翻译Pradeep Dasigi的一篇长文 Knowledge-Aware Natural Language Understanding 基于知识感知的自然语言理解 摘要 Natural Langua ...

- BiMPM:Bilateral Multi-Perspctive Matching for Natural Language Sentences

导言 本论文的工作主要是在 'matching-aggregation'的sentence matching的框架下,通过增加模型的特征(实现P与Q的双向匹配和多视角匹配),来增加NLSM(Natur ...

随机推荐

- 【黑金原创教程】【FPGA那些事儿-驱动篇I 】实验十五:FIFO储存模块(同步)

实验十五:FIFO储存模块(同步) 笔者虽然在实验十四曾解释储存模块,而且也演示奇怪的家伙,但是实验十四只是一场游戏而已.至于实验十五,笔者会稍微严肃一点,手动建立有规格的储存模块,即同步FIFO.那 ...

- C++ 输入/输出

std:: 是什么?有什么作用? 输入和输出的iostream 库.iostream 库的基础是两种命名为 istream 和 ostream 的类型,分别表示输入流和输出流. 标准库定义了 4 个 ...

- html5播放器制作小结

链接:http://snowinmay.net/6rooms/html/music.php 9月份前的版本: 播放,暂停,点赞,播放状态显示. 9.2版本: 下载歌曲,静音,时间倒计时(点击暂停时倒计 ...

- Mac - MySQL初始密码忘记重置MySQL root密码

在什么情况下,需要重置root密码呢?那就是我们忘记了.还有一种比较坑的,那就是笔者的这种情况.按照正常的情况下,MySQL安装完之后,会弹出一个对话框,显示着一个临时的root密码,但无论笔者如何重 ...

- Java IO 详解

Java IO 详解 初学java,一直搞不懂java里面的io关系,在网上找了很多大多都是给个结构图草草描述也看的不是很懂.而且没有结合到java7 的最新技术,所以自己来整理一下,有错的话请指正, ...

- 利用Python读取外部数据文件

不论是数据分析,数据可视化,还是数据挖掘,一切的一切全都是以数据作为最基础的元素.利用Python进行数据分析,同样最重要的一步就是如何将数据导入到Python中,然后才可以实现后面的数据分析.数 ...

- Python面向对象之属性

属性的定义和调用 1,定义时,在普通方法的基础上添加@property装饰器 2,定义时,属性仅有一个self参数 3,调用时,无需括号 vim day7-8.py #!/usr/bin/python ...

- Anaconda中配置Pyspark的Spark开发环境

1.windows下载并安装Anaconda集成环境 URL:https://www.continuum.io/downloads 2.在控制台中测试ipython是否启动正常 3.安装JDK 3.1 ...

- Bazel构建工具的安装

官方Doc:https://docs.bazel.build/versions/master/install-ubuntu.html 使用Bazel定制的APT存储库 (recommended) 1. ...

- POJ 2912 - Rochambeau - [暴力枚举+带权并查集]

题目链接:http://poj.org/problem?id=2912 Time Limit: 5000MS Memory Limit: 65536K Description N children a ...