mac系统上hdfs java api的简单使用

1、背景

在上一节中,我们简单学习了在命令行上如何操作hdfs shell api,此处我们通过java程序来操作一下。

2、环境准备

- 需要在本地环境变量中 配置

HADOOP_HOME或在程序启动的时候通过命令行指定hadoop.home.dir的值,值为HADOOP的home目录地址。可通过org.apache.hadoop.util.Shell#checkHadoopHome方法验证。 - 我们的

HADOOP最好是自己在本地系统进行重新编译,不然可能运行部分java api会出现问题。

3、环境搭建

3.1 引入jar包

<dependencyManagement>

<dependencies>

<dependency>

<groupId>org.junit</groupId>

<artifactId>junit-bom</artifactId>

<version>5.7.1</version>

<type>pom</type>

<scope>import</scope>

</dependency>

</dependencies>

</dependencyManagement>

<dependencies>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>3.3.4</version>

</dependency>

<dependency>

<groupId>org.junit.jupiter</groupId>

<artifactId>junit-jupiter</artifactId>

<scope>test</scope>

</dependency>

<dependency>

<groupId>org.apache.logging.log4j</groupId>

<artifactId>log4j-api</artifactId>

<version>2.14.1</version>

</dependency>

<dependency>

<groupId>org.apache.logging.log4j</groupId>

<artifactId>log4j-core</artifactId>

<version>2.14.1</version>

</dependency>

</dependencies>

3.2 引入log4j.properties配置文件

log4j.appender.console = org.apache.log4j.ConsoleAppender

log4j.appender.console.Target = System.out

log4j.appender.console.layout = org.apache.log4j.PatternLayout

log4j.appender.console.layout.ConversionPattern = [%-5p] %d{ HH:mm:ss,SSS} [%t]:%m%n

log4j.rootLogger = debug,console

引入这个配置是为了,当hadoop报错时,更好的排查问题

3.3 初始化Hadoop Api

@TestInstance(TestInstance.Lifecycle.PER_CLASS)

class HdfsApiTest {

private FileSystem fileSystem;

private static final Logger log = LoggerFactory.getLogger(HdfsApiTest.class);

@BeforeAll

public void setUp() throws IOException, InterruptedException {

// 1、将 HADOOP_HOME 设置到环境变量中

Configuration configuration = new Configuration();

// 2、此处的地址是 NameNode 的地址

URI uri = URI.create("hdfs://192.168.121.140:8020");

// 3、设置用户

String user = "hadoopdeploy";

// 此处如果不设置第三个参数,指的是客户端的身份,默认获取的是当前用户,不过当前用户不一定有权限,需要指定一个有权限的用户

fileSystem = FileSystem.get(uri, configuration, user);

}

@AfterAll

public void tearDown() throws IOException {

if (null != fileSystem) {

fileSystem.close();

}

}

}

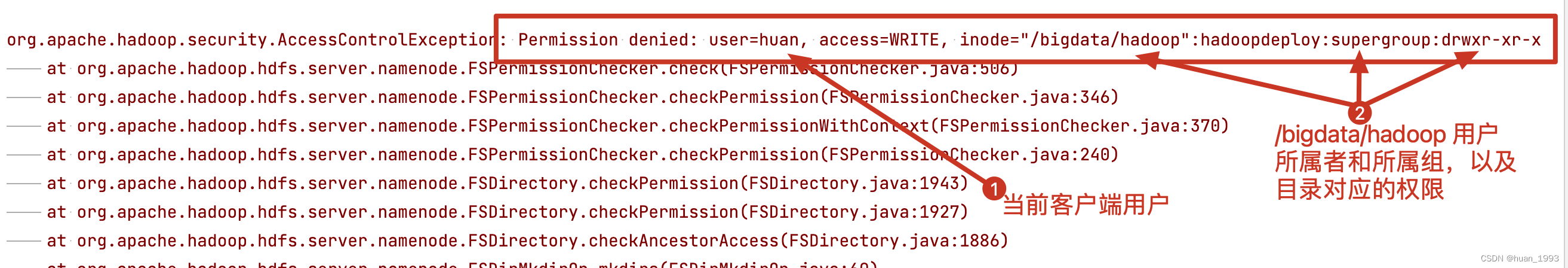

此处我们需要注意的是,需要设置客户端操作的 用户,默认情况下获取的是当前登录用户,否则很有可能会出现如下错误

解决办法:

1、修改目录的访问权限。

2、修改客户端的用户,比如此处修改成hadoopdeploy

4、java api操作

4.1 创建目录

@Test

@DisplayName("创建hdfs目录")

public void testMkdir() throws IOException {

Path path = new Path("/bigdata/hadoop/hdfs");

if (fileSystem.exists(path)) {

log.info("目录 /bigdata/hadoop/hdfs 已经存在,不在创建");

return;

}

boolean success = fileSystem.mkdirs(path);

log.info("创建目录 /bigdata/hadoop/hdfs 成功:[{}?]", success);

}

4.2 上传文件

@Test

@DisplayName("上传文件")

void uploadFile() throws IOException {

/**

* delSrc: 文件上传后,是否删除源文件 true:删除 false:不删除

* overwrite: 如果目标文件存在是否重写 true:重写 false:不重写

* 第三个参数:需要上传的文件

* 第四个参数:目标文件

*/

fileSystem.copyFromLocalFile(false, true,

new Path("/Users/huan/code/IdeaProjects/me/spring-cloud-parent/hadoop/hdfs-api/src/test/java/com/huan/hadoop/HdfsApiTest.java"),

new Path("/bigdata/hadoop/hdfs"));

}

4.3 列出目录下有哪些文件

@Test

@DisplayName("列出目录下有哪些文件")

void testListFile() throws IOException {

RemoteIterator<LocatedFileStatus> iterator = fileSystem.listFiles(new Path("/bigdata"), true);

while (iterator.hasNext()) {

LocatedFileStatus locatedFileStatus = iterator.next();

Path path = locatedFileStatus.getPath();

if (locatedFileStatus.isFile()) {

log.info("获取到文件: {}", path.getName());

}

}

}

4.4 下载文件

@Test

@DisplayName("下载文件")

void testDownloadFile() throws IOException {

fileSystem.copyToLocalFile(false, new Path("/bigdata/hadoop/hdfs/HdfsApiTest.java"),

new Path("/Users/huan/HdfsApiTest.java"), true);

}

4.5 删除文件

@Test

@DisplayName("删除文件")

public void testDeleteFile() throws IOException {

fileSystem.delete(new Path("/bigdata/hadoop/hdfs/HdfsApiTest.java"), false);

}

4.6 检测文件是否存在

@Test

@DisplayName("检查文件是否存在")

public void testFileExists() throws IOException {

Path path = new Path("/bigdata/hadoop/hdfs/HdfsApiTest.java");

boolean exists = fileSystem.exists(path);

log.info("/bigdata/hadoop/hdfs/HdfsApiTest.java 存在:[{}]", exists);

}

5、完整代码

mac系统上hdfs java api的简单使用的更多相关文章

- 在mac电脑上创建java的一些简单操作

首先你要在电脑上下载一个JDK创造出一个java环境 如下第二个: 然后步奏如下: step1:苹果->系统偏好设置->最下边点MySQL 在弹出页面中 关闭mysql服务(点击stop ...

- Java Web项目在Mac系统上启动时提示nodename nor servname provided的解决办法

今天在Mac系统上启动Java Web项目的时候,提示了Java.net.UnknownHostException: yangxiaomindeMacBook-Pro.local nodename n ...

- hadoop集群配置和在windows系统上运用java操作hdfs

安装 配置 概念 hadoop常用shell命令 使用java操作hadoop 本文介绍hadoop集群配置和在windows系统上运用java操作hdfs 安装 http://mirror.bit. ...

- HDFS Java API 常用操作

package com.luogankun.hadoop.hdfs.api; import java.io.BufferedInputStream; import java.io.File; impo ...

- 在MAC系统上进行屏幕录制

最近打算将一些软件操作过程进行屏幕录制进行视频分享,所以寻思着找一块能在MAC上使用的屏幕录制软件.google了一番,没想到MAC系统自带的QuickTime Player已经内置屏幕录像功能,而且 ...

- 关于如何在mac系统上安装Git并在码市上建立项目

对Git一窍不通,为了在mac系统上安装Git,查了很多资料,走了很多弯路,一切搞定后发现其实很简单. 1.在https://brew.sh上按要求安装Homebrew. 2.在电脑终端键入brew ...

- HDFS shell操作及HDFS Java API编程

HDFS shell操作及HDFS Java API编程 1.熟悉Hadoop文件结构. 2.进行HDFS shell操作. 3.掌握通过Hadoop Java API对HDFS操作. 4.了解Had ...

- hadoop hdfs java api操作

package com.duking.util; import java.io.IOException; import java.util.Date; import org.apache.hadoop ...

- HDFS Java API 的基本使用

一. 简介 二.API的使用 2.1 FileSystem 2.2 创建目录 2.3 创建指定权限的目录 2.4 创建文件,并写入内容 ...

- Hadoop 学习之路(七)—— HDFS Java API

一. 简介 想要使用HDFS API,需要导入依赖hadoop-client.如果是CDH版本的Hadoop,还需要额外指明其仓库地址: <?xml version="1.0" ...

随机推荐

- SQL审核平台Yearning

1.关于Yearming Yearming是一个Sql审核平台,底层使用Go语言,安装和部署方式也很便捷 项目地址 https://guide.yearning.io/install.html git ...

- 铁威马NAS添加SSL证书实现HTTPS安全访问

如何让你的铁威马NAS域名可以支持HTTPS呢?其实想要支持HTTPS,只需要获取第三方签发的证书,信任你的域名就可以啦! 在铁威马TOS 4.2系统中,允许用户导入安全证书,或者自我颁发安全证书,这 ...

- 架构设计(四):CDN

架构设计(四):CDN 作者:Grey 原文地址: 博客园:架构设计(四):CDN CSDN:架构设计(四):CDN CDN 全称 Content delivery network ,即:内容分发网络 ...

- 监控Android(生成木马)

生成木马: sudo su msfvenom --platform android -p android/meterpreter/reverse_tcp lhost=IP地址 lport=端口号 R ...

- 连接MySql时提示%d format: a number is required, not str

代码: sql = "select * from appelementinfo" coon = pymysql.connect(user='root', password='', ...

- uniapp微信小程序 下拉刷新(上拉请求下一页数据)

<template>标签中: <view class="" v-if="daShow==1"> <view class=" ...

- Windows上将linux目录映射网络驱动器

我有两台PC,一台操作用的Windows,一台linux.为了方便对linux目录的文件操作.需要在Windows上将linux中的/fdsk目录映射为网络驱动器. a.首先要将linux安装成为sa ...

- Vue中实现自定义excel下载

目录 第一种:后端生成excel 第二种:前端合成excel 总结 参考资料 最近在工作中遇到一个需求,就是需要在前端实现一个错误模板Excel的下载功能. 实现下载有两种方式,一种是后端生成一个ex ...

- [python] 基于matplotlib_venn实现维恩图的绘制

文章目录 VENN DIAGRAM(维恩图) 1. 具有2个分组的基本的维恩图 Venn diagram with 2 groups 2. 具有3个组的基本维恩图 Venn diagram with ...

- ArcGIS Python判断数据是否存在

判断是程序编写的一个基本的操作,也是增强程序稳定性的重要方式.在ArcPy处理数据时,要保证数据存在才能做后续的操作,为源GIS提示使用arcpy自带的Exists函数可判断要素类.表.数据集.sha ...