spark1.6.1 on yarn搭建部署

注:本文是建立在hadoop已经搭建完成的基础上进行的。

Apache Spark是一个分布式计算框架,旨在简化运行于计算机集群上的并行程序的编写。该框架对资源调度,任务的提交、执行和跟踪,节点间的通信以及数据并行处理的内在底层操作都进行了抽象。它提供了一个更高级别的API用于处理分布式数据。从这方面说,它与Apache Hadoop等分布式处理框架类似。但在底层架构上,Spark与它们有所不同。

Spark起源于加利福利亚大学伯克利分校的一个研究项目。学校当时关注分布式机器学习算法的应用情况。因此,Spark从一开始便为应对迭代式应用的高性能需求而设计。在这类应用中,相同的数据会被多次访问。该设计主要靠利用数据集内存缓存以及启动任务时的低延迟和低系统开销来实现高性能。再加上其容错性、灵活的分布式数据结构和强大的函数式编程接口,Spark在各类基于机器学习和迭代分析的大规模数据处理任务上有广泛的应用,这也表明了其实用性。

Spark支持四种运行模式。

- 本地单机模式:所有Spark进程都运行在同一个Java虚拟机(Java Vitural Machine,JVM)中。

- 集群单机模式:使用Spark自己内置的任务调度框架。

- 基于Mesos:Mesos是一个流行的开源集群计算框架。

- 基于YARN:即Hadoop 2,它是一个与Hadoop关联的集群计算和资源调度框架。

spark是由Scala语言编写的,但是运行的环境是jvm,所以需要安装JDK

编译过程:Python、java、Scala编写的代码 -> scala编译器编译解释,生成class文件 -> 由jvm负责执行class文件(与java代码执行一致)

Apache Hadoop YARN (Yet Another Resource Negotiator,另一种资源协调者)是一种新的 Hadoop 资源管理器,它是一个通用资源管理系统,可为上层应用提供统一的资源管理和调度,它的引入为集群在利用率、资源统一管理和数据共享等方面带来了巨大好处

由于 spark是由Scala语言编写的,所以依赖Scala环境,且由Scala编写的执行代码也需要环境进行编译。

hdfs是作为spark的持久层,所以需要安装Hadoop,同时如果需要配置spark on yarn,则Hadoop需要安装yarn版本的

spark官方详细参数配置手册:http://spark.apache.org/docs/latest/configuration.html

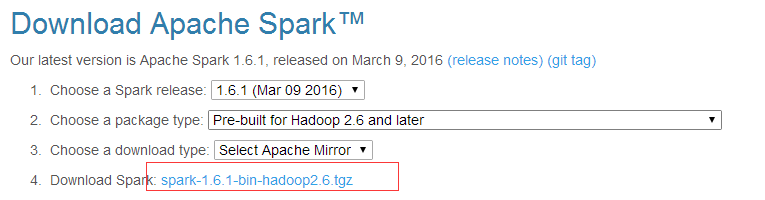

下载地址:http://spark.apache.org/downloads.html

---------------------------------------------------------------------------------------------------------

1、安装Scala

官网下载地址: http://www.scala-lang.org/download/all.html

下载后解压到指定目录,例如 /usr/local/scala

# tar -zxvf scala-2.11.8.tgz ; mv scala-2.11.8 /usr/local/scala

配置环境变量:

# vim /etc/profile

export SCALA_HOME=/usr/local/scala/

export PATH=$SCALA_HOME/bin:$PATH

2、编辑conf/spark-env.sh文件

export HADOOP_HOME=/usr/local/hadoop

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

export SPARK_MASTER_IP=dataMaster30

export SPARK_EXECUTOR_INSTANCES=3

export SPARK_EXECUTOR_CORES=3

export SPARK_EXECUTOR_MEMORY=8g

export SPARK_DRIVER_MEMORY=2g

3、编辑slaves文件

#localhost

dataSlave31

dataSlave32

dataSlave33

dataSlave34

dataSlave35

4、启动spark集群:

/usr/local/spark/sbin/start-all.sh

关闭spark集群:

/usr/local/spark/sbin/stop-all.sh

5、检测是否安装成功:

# jps (Master节点) 此时会多出现一个Master进程

1701 Master

1459 SecondaryNameNode

2242 NameNode

1907 ResourceManage

# jps (Worker节点) 此时会多出现一个Worker进程

5387 Worker

4269 DataNode

4398 NodeManager

执行以下测试命令,查看spark单机运行是否成功:

/usr/local/spark/bin/run-example SparkPi 1000

执行以下测试命令,查看spark集群运行是否成功:

cd /usr/local/spark

./bin/spark-submit --master spark://master60:7077 --class org.apache.spark.examples.SparkPi lib/spark-examples-1.6.1-hadoop2.6.0.jar 1000

如果没有报错的话,则证明spark确实部署成功。

6、查看集群状态:

http://master30:/

最后设置开机自启动:

vim /etc/rc.local

su - hadoop -c "/usr/local/hadoop/sbin/start-all.sh"

su - hadoop -c "/usr/local/spark/sbin/start-all.sh"

spark1.6.1 on yarn搭建部署的更多相关文章

- Spark1.3.1 On Yarn的集群搭建

下面给出的是spark集群搭建的环境: 操作系统:最小安装的CentOS 7(下载地址) Yarn对应的hadoop版本号:Hadoop的Cloudera公司发行版Hadoop2.6.0-CDH5.4 ...

- Spark集群基于Zookeeper的HA搭建部署笔记(转)

原文链接:Spark集群基于Zookeeper的HA搭建部署笔记 1.环境介绍 (1)操作系统RHEL6.2-64 (2)两个节点:spark1(192.168.232.147),spark2(192 ...

- 云服务器+tomcat+mysql+web项目搭建部署

云服务器+tomcat+mysql+web项目搭建部署 1.老样子,开头墨迹两句. 作为我的第二篇文章,有很多感慨,第一篇人气好低啊,有点小丧气,不过相信我还是经验少,分享的都是浅显的,所以大家可能不 ...

- Ubuntu14.04下Ambari安装搭建部署大数据集群(图文分五大步详解)(博主强烈推荐)

不多说,直接上干货! 写在前面的话 (1) 最近一段时间,因担任我团队实验室的大数据环境集群真实物理机器工作,至此,本人秉持负责.认真和细心的态度,先分别在虚拟机上模拟搭建ambari(基于CentO ...

- Ubuntu14.04下Cloudera安装搭建部署大数据集群(图文分五大步详解)(博主强烈推荐)(在线或离线)

第一步: Cloudera Manager安装之Cloudera Manager安装前准备(Ubuntu14.04)(一) 第二步: Cloudera Manager安装之时间服务器和时间客户端(Ub ...

- nginx Win下实现简单的负载均衡(1)nginx搭建部署

快速目录: 一.nginx Win下实现简单的负载均衡(1)nginx搭建部署 二.nginx Win下实现简单的负载均衡(2)站点共享Session 三.nginx Win下实现简单的负载均衡(3) ...

- zabbix环境搭建部署(一)

Linux高端架构师课程 Linux实战运维国内NO.1全套视频课程 QQ咨询:397824870 > 监控报警 > zabbix环境搭建部署(一) zabbix环境搭建部署(一) 监 ...

- 企业级监控软件zabbix搭建部署之zabbix server的安装

企业级监控软件zabbix搭建部署之zabbix server的安装 zabbix线上已经应用半年多了,关于zabbix在生产环境中的使用心得,以及一些经验写下来,希望让大家少走弯路,共同学习! 环境 ...

- 企业级监控软件Zabbix搭建部署之zabbix在WEB页面中的配置

企业级监控软件zabbix搭建部署之zabbix在WEB页面中的配置 企业级监控软件zabbix搭建部署之zabbix在WEB页面中的配置 关于安装请看 http://www.linuxidc.com ...

随机推荐

- 使用IDEA进行Lua代码调试、自动提示、代码跳转、智能重命名

试了几个Lua IDE后,Lua Studio.Lua Glider.VS+babelua插件.Sublime都不是特别满意.直到发现了国人自创的另一个神奇工具:基于IDEA的EmmyLua插件.该插 ...

- Spring MVC 处理异常

SpringMVC处理异常: 1 使用@ExceptionHandler注解 只有ModelAndView可以携带错误信息 @ExceptionHandler public ModelAndView ...

- Servlet --简单用户留言系统

1.创建用户表和留言表 2.编写数据库连接工具类 public class SqlserverDBConn { private Statement stmt; private Connection c ...

- vue使用树形控件z-tree,动态添加数据,默认展开第一行

环境:vue 2.9.3; webpack; 插件:z-tree,jquery(cnpm install xxxx) 问题;由于数据量比较多,需要动态加载数据,默认第一次请求的数据是最高一级,然后子集 ...

- union与union all的用法给区别

用法: 当我们需要把两个或多个sql联合起来查询就用到了union或者union all 区别: 这两者的区别就在于union会自动的把多个sql查出来重复的排除掉,而union all这是会全部显示 ...

- 用excel批量生成insert语句

excel表格中有A.B.C三列数据,分别对应TableName的UserId.UserName.UserPwd三个字段.如下图所示 在excel的D2的位置,也就是A.B.C列的后面一列,添加下面公 ...

- Echarts动态加载饼状图的实例

一.引入echarts.js文件(下载页:http://echarts.baidu.com/download.html) 二.HTML代码: <div style="width: 10 ...

- SDOI2018IIIDX

/* 题目转换为 n个节点的一片森林,n个权值,要给每个节点分配一个权值,保证子节点的权值不小于父节点的权值,并且1~n的权值的字典序最大. 考场上的贪心很显然 建立出 树来 将所有数值从大到小排序 ...

- ping -c 3 localhost

linux指令,ping -c count ip,向指定IP发送指定数量的ping包

- 'pip' 不是内部或外部命令

安装好Python,在环境变量Path中加入相应路径信息后,Python命令没问题,但是运行pip失败: 'pip' 不是内部或外部命令,Pip工具已经自带安装好了,只是跟Python命令一样,需要我 ...