hive 存储格式及压缩

-- 设置参数

set hivevar:target_db_name=db_dw;

use ${hivevar:target_db_name}; -- 创建textfile表

create table file_format_textfile

row format delimited fields terminated by '\001'

stored as textfile

as

select * from smple_table; -- 测试各种压缩的orc表

create table file_format_orc_zlib

row format delimited fields terminated by '\001'

stored as orc tblproperties ("orc.compress"="ZLIB")

as

select * from file_format_textfile

; create table file_format_orc_snappy

row format delimited fields terminated by '\001'

stored as orc tblproperties ("orc.compress"="SNAPPY")

as

select * from file_format_orc_zlib

; create table file_format_orc_none

row format delimited fields terminated by '\001'

stored as orc tblproperties ("orc.compress"="NONE")

as

select * from file_format_orc_zlib

; create table file_format_orc_default

row format delimited fields terminated by '\001'

stored as orc

as

select * from file_format_orc_zlib

; -- 测试各种压缩的parquet表

create table file_format_parquet_zlib

row format delimited fields terminated by '\001'

stored as parquet tblproperties ("parquet.compress"="ZLIB")

as

select * from file_format_orc_zlib

; create table file_format_parquet_snappy

row format delimited fields terminated by '\001'

stored as parquet tblproperties ("parquet.compress"="SNAPPY")

as

select * from file_format_orc_zlib

; create table file_format_parquet_none

row format delimited fields terminated by '\001'

stored as parquet tblproperties ("parquet.compress"="NONE")

as

select * from file_format_orc_zlib

; create table file_format_parquet_default

row format delimited fields terminated by '\001'

stored as parquet

as

select * from file_format_orc_zlib

; -- 测试各种压缩的rcfile表(可能参数没生效,各种压缩后大小一致)

create table file_format_rcfile_zlib

row format delimited fields terminated by '\001'

stored as rcfile tblproperties ("rcfile.compress"="ZLIB")

as

select * from file_format_orc_zlib

; create table file_format_rcfile_snappy

row format delimited fields terminated by '\001'

stored as rcfile tblproperties ("rcfile.compress"="SNAPPY")

as

select * from file_format_orc_zlib

; create table file_format_rcfile_none

row format delimited fields terminated by '\001'

stored as rcfile tblproperties ("rcfile.compress"="NONE")

as

select * from file_format_orc_zlib

; create table file_format_rcfile_default

row format delimited fields terminated by '\001'

stored as rcfile

as

select * from file_format_orc_zlib

;

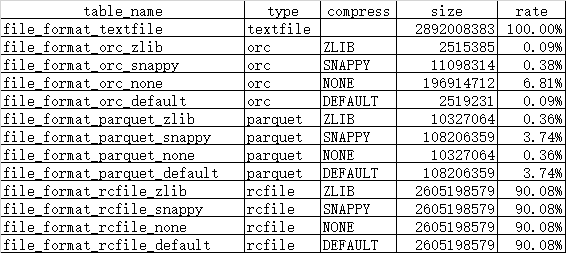

-- 查看各种压缩下的格式大小

dfs -du -s /user/hive/warehouse/${hivevar:target_db_name}.db/file_format_textfile; dfs -du -s /user/hive/warehouse/${hivevar:target_db_name}.db/file_format_orc_zlib;

dfs -du -s /user/hive/warehouse/${hivevar:target_db_name}.db/file_format_orc_snappy;

dfs -du -s /user/hive/warehouse/${hivevar:target_db_name}.db/file_format_orc_none;

dfs -du -s /user/hive/warehouse/${hivevar:target_db_name}.db/file_format_orc_default; dfs -du -s /user/hive/warehouse/${hivevar:target_db_name}.db/file_format_parquet_zlib;

dfs -du -s /user/hive/warehouse/${hivevar:target_db_name}.db/file_format_parquet_snappy;

dfs -du -s /user/hive/warehouse/${hivevar:target_db_name}.db/file_format_parquet_none;

dfs -du -s /user/hive/warehouse/${hivevar:target_db_name}.db/file_format_parquet_default; dfs -du -s /user/hive/warehouse/${hivevar:target_db_name}.db/file_format_rcfile_zlib;

dfs -du -s /user/hive/warehouse/${hivevar:target_db_name}.db/file_format_rcfile_snappy;

dfs -du -s /user/hive/warehouse/${hivevar:target_db_name}.db/file_format_rcfile_none;

dfs -du -s /user/hive/warehouse/${hivevar:target_db_name}.db/file_format_rcfile_default;

-- 统计数据,原文件见文件中的附件

hive 存储格式及压缩的更多相关文章

- Hive存储格式之RCFile详解,RCFile的过去现在和未来

我在整理Hive的存储格式和压缩格式,本来打算一篇发出来,结果其中一小节就有很多内容,于是打算写成Hive存储格式和压缩格式系列. 本节主要讲一下Hive存储格式最早的典型的列式存储格式RCFile. ...

- Hive存储格式之ORC File详解,什么是ORC File

目录 概述 文件存储结构 Stripe Index Data Row Data Stripe Footer 两个补充名词 Row Group Stream File Footer 条纹信息 列统计 元 ...

- Hadoop、Hive【LZO压缩配置和使用】

目录 一.编译 二.相关配置 三.为LZO文件创建索引 四.Hive为LZO文件建立索引 1.hive创建的lzo压缩的分区表 2.给.lzo压缩文件建立索引index 3.读取Lzo文件的注意事项( ...

- Hive性能调优(一)----文件存储格式及压缩方式选择

合理使用文件存储格式 建表时,尽量使用 orc.parquet 这些列式存储格式,因为列式存储的表,每一列的数据在物理上是存储在一起的,Hive查询时会只遍历需要列数据,大大减少处理的数据量. 采用合 ...

- hive 存储格式对比

Apache Hive支持Apache Hadoop中使用的几种熟悉的文件格式,如TextFile,RCFile,SequenceFile,AVRO,ORC和Parquet格式. Cloudera I ...

- Hive(十一)【压缩、存储】

目录 一.Hadoop的压缩配置 1.MR支持的压缩编码 2.压缩参数配置 3.开启Mapper输出阶段压缩 4.开启Reduceer输出阶段 二.文件存储 1.列式存储和行式存储 2.TextFil ...

- hive 存储格式

hive有textFile,SequenceFile,RCFile三种文件格式. textfile为默认格式,建表时不指定默认为这个格式,导入数据时会直接把数据文件拷贝到hdfs上不进行处理. Seq ...

- hive表的存储格式; ORC格式的使用

hive表的源文件存储格式有几类: 1.TEXTFILE 默认格式,建表时不指定默认为这个格式,导入数据时会直接把数据文件拷贝到hdfs上不进行处理.源文件可以直接通过hadoop fs -cat 查 ...

- Hive文件存储格式和hive数据压缩

一.存储格式行存储和列存储 二.Hive文件存储格式 三.创建语句和压缩 一.存储格式行存储和列存储 行存储可以理解为一条记录存储一行,通过条件能够查询一整行数据. 列存储,以字段聚集存储,可以理解为 ...

随机推荐

- day17-jdbc 8.ResultSet介绍

但是这些东西在mysql那里有问题.mysql的驱动不是很完善.getClob().getBlob()不好使不是因为程序的问题,而是因为mysql驱动的问题,oracle驱动就没有这个问题,证明ora ...

- ROS Learning-014 learning_tf(编程) 坐标系变换(tf)广播员 (Python版)

ROS Indigo learning_tf-01 坐标系变换(tf)广播员 (Python版) 我使用的虚拟机软件:VMware Workstation 11 使用的Ubuntu系统:Ubuntu ...

- 数据结构_stack

问题描述 一天,小 L 发现了一台支持一下操作的机器:IN x:将整数 x 入栈POP:将栈顶元素出栈ASUB:出栈两个数,将两数差的绝对值入栈COPY:将栈顶元素(如果有的话)复制一份,入栈现在小 ...

- C++笔记-类层次结构

多重继承 一个类采用多个直接基类的情况称为多重继承,采用一个基类就是单继承. 两个基类中可能会出现名字一样的成员函数 在派生类中就必须消解这两个基类的成员函数带来的歧义性,最好的方法:在派生类中重新定 ...

- C++笔记--指针数组和结构

指针 类型为T*的变量能保存一个类型T对象的地址 Char c=‘a’:Char * p=& c://保存了c的地址 指针的操作一般都是间接的引用,就是相当于引用指针所指的对象. 0是一个特殊 ...

- 开启wifi后不能ping通本机 Cann't ping the local PC while start a wlan

问题如题:今天发现一个问题,测试本机ip时候有时候总是获取失败,后来才发现是wifi共享软件导致的缘故. 本来呢?我买的是小米wifi,但是小米wifi对应的客户端不是很好用,动不动就启动失败,不要问 ...

- git命令(一)

git中每个版本的保存是记录每个版本的快照,只在乎这个文件是否改变. Workspace:工作区 Index / Stage:暂存区 Repository:仓库区(或本地仓库) Remote:远程仓库 ...

- jquery ajax 分页2

/* * 分页 $("#divPager").flexipager * 2015.03.17 */ //初始化列表默认属性 (function($) { $.addFlex = f ...

- 使用Privoxy转化SSH到HTTP代理

为什么要进行转换? 一般我们很容易找到通过SOCKS5代理的方法,如SSH,但是很多浏览器或是软件只支持HTTP方式,所以就需要将我们的SSH代理模式转为HTTP代理方式 如何转换? 使用Privo ...

- Intent要使用的ACTION都有哪些?在哪里能查到详细的ACTION呢?

Intent操作结构之一就是ACTION,这些ACTION都有哪些?在哪里能查到详细的ACTION呢? 官方文档: https://developer.android.com/reference/an ...