【机器学习】TensorFlow学习(一)

感谢中国人民大学胡鹤老师,课讲得非常好~

首先,何谓tensor?即高维向量,例如矩阵是二维,tensor是更广义意义上的n维向量(有type+shape)

TensorFlow执行过程为定义图,其中定义子节点,计算时只计算所需节点所依赖的节点,是一种高效且适应大规模的数据计算,方便分布式设计,对于复杂神经网络的计算,可将其拆开到其他核中同时计算。

Theano——torch———caffe(尤其是图像处理)——deeplearning5j——H20——MXNet,TensorFlow

运行环境

下载docker

打开docker quickstart terminal

标红地方显示该docker虚拟机IP地址(即之后的localhost)

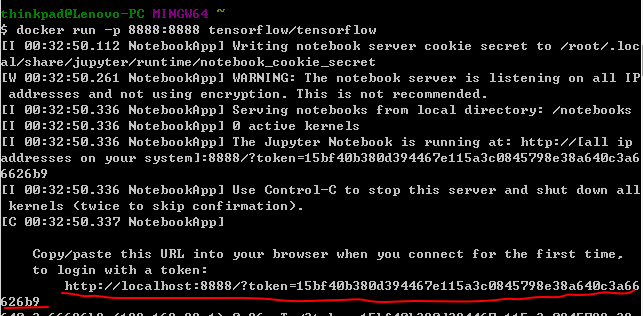

docker tensorflow/tensorflow //自动找到TensorFlow容器并下载

docker images //浏览当前容器

docker run -p 8888:8888 tensorflow/tensorflow //在8888端口运行

会出现一个token,复制该链接并替换掉localhost,既可以打开TensorFlow的一个编写器,jupyter

大体雏形

#python导入

import tensorflow as tf

#定义变量(节点)

x = tf.Variable(3, name="x")

y = tf.Variable(4, name="y")

f = x*x*y + y + 2

#定义session

sess = tf.Session()

#为已经定义的节点赋值

sess.run(x.initializer)

sess.run(y.initializer)

#运行session

result = sess.run(f)

print(result) #

#释放空间

sess.close

还有一个更简洁的一种定义并运行session方法

# a better way

with tf.Session() as sess:

x.initializer.run()

y.initializer.run()

#即evaluate,求解f的值

result = f.eval()

初始化的两行也可以写作

init = tf.global_variables_initializer()

init.run()

而session可以改作sess=tf.InteractiveSession()运行起来更方便

init = tf.global_variables_initializer()

sess = tf.InteractiveSession()

init.run()

result = f.eval()

print(result)

因而TensorFlow的代码分为两部分,定义部分和执行部分

TensorFlow是一个图的操作,有自动缺省的默认图和你自己定义的图

#系统默认缺省的图

>>> x1 = tf.Variable(1)

>>> x1.graph is tf.get_default_graph()

True

#自定义的图

>>> graph = tf.Graph()

>>> with graph.as_default():

x2 = tf.Variable(2)

>>> x2.graph is graph

True

>>> x2.graph is tf.get_default_graph()

False

节点的生命周期

第二种方法可以找出公共部分,避免x被计算2次。

运行结束后所有节点的值都被清空,如果没有单独保存,还需重新run一遍。

w = tf.constant(3)

x = w + 2

y = x + 5

z = x * 3

with tf.Session() as sess:

print(y.eval()) #

print(z.eval()) # with tf.Session() as sess:

y_val, z_val = sess.run([y, z])

print(y_val) #

print(z_val) #

Linear Regression with TensorFlow(线性回归上的应用)

y = wx+b = wx' //这里x'是相较于x多了一维全是1的向量

这里引用California housing的数据

TensorFlow上向量是列向量,需要reshape(-1,1)即转置成列向量

使用normal equation方法求解

import numpy as np

from sklearn.datasets import fetch_california_housing

housing = fetch_california_housing()

#获得数据维度,矩阵的行列长度

m, n = housing.data.shape

#np.c_是连接的含义,加了一个全为1的维度

housing_data_plus_bias = np.c_[np.ones((m, 1)), housing.data]

#数据量并不大,可以直接用常量节点装载进来,但是之后海量数据无法使用(会用minbatch的方式导入数据)

X = tf.constant(housing_data_plus_bias, dtype=tf.float32, name="X")

#转置成列向量

y = tf.constant(housing.target.reshape(-1, 1), dtype=tf.float32, name="y")

XT = tf.transpose(X)

#使用normal equation的方法求解theta,之前线性模型中有提及

theta = tf.matmul(tf.matmul(tf.matrix_inverse(tf.matmul(XT, X)), XT), y)

#求出权重

with tf.Session() as sess:

theta_value = theta.eval()

如果是原本的方法,可能更直接些。但由于使用底层的库不同,它们计算出来的值不完全相同。

#使用numpy

X = housing_data_plus_bias

y = housing.target.reshape(-1, 1)

theta_numpy = np.linalg.inv(X.T.dot(X)).dot(X.T).dot(y)

#使用sklearn

from sklearn.linear_model import LinearRegression

lin_reg = LinearRegression()

lin_reg.fit(housing.data, housing.target.reshape(-1, 1))

这里不禁感到疑惑,为什么TensorFlow感觉变复杂了呢?其实,这不过因为这里数据规模较小,进行大规模的计算时,TensorFlow的自动优化所发挥的效果,是十分厉害的。

使用gradient descent(梯度下降)方法求解

#使用gradient时需要scale一下

from sklearn.preprocessing import StandardScaler

scaler = StandardScaler()

scaled_housing_data = scaler.fit_transform(housing.data)

scaled_housing_data_plus_bias = np.c_[np.ones((m, 1)), scaled_housing_data]

#迭代1000次

n_epochs = 1000

learning_rate = 0.01

#由于使用gradient,写入x的值需要scale一下

X = tf.constant(scaled_housing_data_plus_bias, dtype=tf.float32, name="X")

y = tf.constant(housing.target.reshape(-1, 1), dtype=tf.float32, name="y")

#使用gradient需要有一个初值

theta = tf.Variable(tf.random_uniform([n + 1, 1], -1.0, 1.0), name="theta")

#当前预测的y,x是m*(n+1),theta是(n+1)*1,刚好是y的维度

y_pred = tf.matmul(X, theta, name="predictions")

#整体误差

error = y_pred - y

#TensorFlow求解均值功能强大,可以指定维数,也可以像下面方法求整体的

mse = tf.reduce_mean(tf.square(error), name="mse")

#暂时自己写出训练过程,实际可以采用TensorFlow自带的功能更强大的自动求解autodiff方法

gradients = 2/m * tf.matmul(tf.transpose(X), error)

training_op = tf.assign(theta, theta - learning_rate * gradients)

#初始化并开始求解

init = tf.global_variables_initializer()

with tf.Session() as sess:

sess.run(init)

for epoch in range(n_epochs):

#每运行100次打印一下当前平均误差

if epoch % 100 == 0:

print("Epoch", epoch, "MSE =", mse.eval())

sess.run(training_op)

best_theta = theta.eval()

上述代码中的autodiff如下,可以自动求出gradient

gradients = tf.gradients(mse, [theta])[0]

使用Optimizer

上述的整个梯度下降和迭代方法,都封装了在如下方法中

optimizer = tf.train.GradientDescentOptimizer(learning_rate=learning_rate)

training_op = optimizer.minimize(mse)

这样的optimizer还有很多

例如带冲量的optimizer = tf.train.MomentumOptimizer(learning_rate=learning_rate,momentum=0.9)

Feeding data to training algorithm

当数据量达到几G,几十G时,使用constant直接导入数据显然是不现实的,因而我们用placeholder做一个占位符

(一般行都是none,即数据量是任意的)

真正运行,run的时候再feed数据。可以不断使用新的数据。

>>> A = tf.placeholder(tf.float32, shape=(None, 3))

>>> B = A + 5

>>> with tf.Session() as sess:

... B_val_1 = B.eval(feed_dict={A: [[1, 2, 3]]})

... B_val_2 = B.eval(feed_dict={A: [[4, 5, 6], [7, 8, 9]]})

...

>>> print(B_val_1)

[[ 6. 7. 8.]]

>>> print(B_val_2)

[[ 9. 10. 11.]

[ 12. 13. 14.]]

这样,就可以通过定义min_batch来分批次随机抽取指定数量的数据,即便是几T的数据也可以抽取。

batch_size = 100

n_batches = int(np.ceil(m / batch_size))

#有放回的随机抽取数据

def fetch_batch(epoch, batch_index, batch_size):

#定义一个随机种子

np.random.seed(epoch * n_batches + batch_index) # not shown in the book

indices = np.random.randint(m, size=batch_size) # not shown

X_batch = scaled_housing_data_plus_bias[indices] # not shown

y_batch = housing.target.reshape(-1, 1)[indices] # not shown

return X_batch, y_batch

#开始运行

with tf.Session() as sess:

sess.run(init)

#每次都抽取新的数据做训练

for epoch in range(n_epochs):

for batch_index in range(n_batches):

X_batch, y_batch = fetch_batch(epoch, batch_index, batch_size)

sess.run(training_op, feed_dict={X: X_batch, y: y_batch})

#最终结果

best_theta = theta.eval()

Saving and Restoring models(保存模型)

有时候,运行几天的模型可能因故暂时无法继续跑下去,因而需要暂时保持已训练好的部分模型到硬盘上。

init = tf.global_variables_initializer()

saver = tf.train.Saver()

#保存模型

with tf.Session() as sess:

sess.run(init) for epoch in range(n_epochs):

if epoch % 100 == 0:

#print("Epoch", epoch, "MSE =", mse.eval())

save_path = saver.save(sess, "/tmp/my_model.ckpt")

sess.run(training_op) best_theta = theta.eval()

save_path = saver.save(sess, "/tmp/my_model_final.ckpt")

#恢复模型

with tf.Session() as sess:

saver.restore(sess, "/tmp/my_model_final.ckpt")

best_theta_restored = theta.eval()

关于TensorBoard

众所周知,神经网络和机器学习大多是黑盒模型,让人有点忐忑。TensorBoard所起的功能就是将这个黑盒稍微变白一些~

启用tensorboard

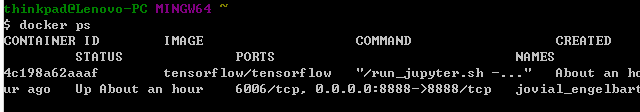

输入docker ps查看当前容器id

进入容器

使用tensorboard --log-dir=tf_logs命令打开已经存入的tf_logs文件,其生成代码如下所示

from datetime import datetime

now = datetime.utcnow().strftime("%Y%m%d%H%M%S")

root_logdir = "tf_logs"

logdir = "{}/run-{}/".format(root_logdir, now)

...

mse_summary = tf.summary.scalar('MSE', mse)

file_writer = tf.summary.FileWriter(logdir, tf.get_default_graph())

...

if batch_index % 10 == 0:

summary_str = mse_summary.eval(feed_dict={X: X_batch, y: y_batch})

step = epoch * n_batches + batch_index

file_writer.add_summary(summary_str, step)

【机器学习】TensorFlow学习(一)的更多相关文章

- TensorFlow机器学习框架-学习笔记-001

# TensorFlow机器学习框架-学习笔记-001 ### 测试TensorFlow环境是否安装完成-----------------------------```import tensorflo ...

- 人工智能新手入门学习路线和学习资源合集(含AI综述/python/机器学习/深度学习/tensorflow)

[说在前面]本人博客新手一枚,象牙塔的老白,职业场的小白.以下内容仅为个人见解,欢迎批评指正,不喜勿喷![握手][握手] 1. 分享个人对于人工智能领域的算法综述:如果你想开始学习算法,不妨先了解人工 ...

- Tensorflow学习笔记2019.01.22

tensorflow学习笔记2 edit by Strangewx 2019.01.04 4.1 机器学习基础 4.1.1 一般结构: 初始化模型参数:通常随机赋值,简单模型赋值0 训练数据:一般打乱 ...

- Tensorflow学习笔记2019.01.03

tensorflow学习笔记: 3.2 Tensorflow中定义数据流图 张量知识矩阵的一个超集. 超集:如果一个集合S2中的每一个元素都在集合S1中,且集合S1中可能包含S2中没有的元素,则集合S ...

- TensorFlow学习笔记之--[compute_gradients和apply_gradients原理浅析]

I optimizer.minimize(loss, var_list) 我们都知道,TensorFlow为我们提供了丰富的优化函数,例如GradientDescentOptimizer.这个方法会自 ...

- 机器学习&深度学习基础(目录)

从业这么久了,做了很多项目,一直对机器学习的基础课程鄙视已久,现在回头看来,系统的基础知识整理对我现在思路的整理很有利,写完这个基础篇,开始把AI+cv的也总结完,然后把这么多年做的项目再写好总结. ...

- TensorFlow学习路径【转】

作者:黄璞链接:https://www.zhihu.com/question/41667903/answer/109611087来源:知乎著作权归作者所有.商业转载请联系作者获得授权,非商业转载请注明 ...

- TensorFlow学习线路

如何高效的学习 TensorFlow 代码? 或者如何掌握TensorFlow,应用到任何领域? 作者:黄璞链接:https://www.zhihu.com/question/41667903/ans ...

- 深度学习-tensorflow学习笔记(1)-MNIST手写字体识别预备知识

深度学习-tensorflow学习笔记(1)-MNIST手写字体识别预备知识 在tf第一个例子的时候需要很多预备知识. tf基本知识 香农熵 交叉熵代价函数cross-entropy 卷积神经网络 s ...

- tensorflow学习笔记(2)-反向传播

tensorflow学习笔记(2)-反向传播 反向传播是为了训练模型参数,在所有参数上使用梯度下降,让NN模型在的损失函数最小 损失函数:学过机器学习logistic回归都知道损失函数-就是预测值和真 ...

随机推荐

- poj3264 最大值与最小值的差

For the daily milking, Farmer John's N cows (1 ≤ N ≤ 50,000) always line up in the same order. One d ...

- spring框架总结(04)----介绍的是Spring中的JDBC模板

1.1 Jdbc模板概述 它是spring框架中提供的一个对象,是对原始Jdbc API对象的简单封装.spring框架为我们提供了很多的操作模板类,入下图所示: 我们今天的主角在spring-jd ...

- Python实战之列表简单练习

['__add__', '__class__', '__contains__', '__delattr__', '__delitem__', '__dir__', '__doc__', '__eq__ ...

- Ubuntu下的终端多标签切换快捷键

ubuntu下由于常在终端下工作,也同样需要在一个终端窗口下开启多个标签方便日常开发工作(vim党,尽量避免使用鼠标) 方法一: alt+1 alt+2 alt+3 方法二: ctrl + pageU ...

- GBK和UTF8有什么区别

GBK编码:是指中国的中文字符,其它它包含了简体中文与繁体中文字符,另外还有一种字符“gb2312”,这种字符仅能存储简体中文字符. UTF-8编码:它是一种全国家通过的一种编码,如果你的网站涉及到多 ...

- 记录一次因为硬盘写满造成的redis无法连接

缘起: 今天早晨收到报警,服务不干活了,赶紧起来看问题... 为了尽快让服务可用,尝试重启服务,发现服务起不来,报错 redis connection failed! 看起来是redis挂了,但是发现 ...

- dom4j之小小工具

dom4j经常不用,方法忘了又记,故做出读取xml和把document写入xml的小小工具~~~ /** * 读取document和将document对象写入到xml的小工具 * 使用该类必须给出do ...

- UWP 手绘视频创作工具技术分享系列 - 位图的绘制

前面我们针对 SVG 的解析和绘制做了介绍,SVG 是图片的一种形式,而另一种很重要的图片是:位图,包括 png.jpeg.bmp 等格式.位图的基本规则是,组成的基本元素是像素点,由宽度 * 高度个 ...

- 详解python命名空间和作用域

1.典型案例 先从几个典型的案例来看下名称空间及作用域对python代码运行的影响,请看下面几个代码实例及其执行结果,是否符合你的预期. 代码1:块作用域 if True: i = 1 print i ...

- java集合相关问题

1.Map/Set 的 key 为自定义对象时,必须重写 hashCode 和 equals: 2.ArrayList 的 subList 结果不可强转成 ArrayList,否则会抛出 ClassC ...