python读写csv文件

文章链接:https://www.cnblogs.com/cloud-ken/p/8432999.html

Python读写csv文件

觉得有用的话,欢迎一起讨论相互学习~Follow Me

前言

逗号分隔值(Comma-Separated Values,CSV,有时也称为字符分隔值,因为分隔字符也可以不是逗号),其文件以纯文本形式存储表格数据(数字和文本)。纯文本意味着该文件是一个字符序列,不含必须像二进制数字那样被解读的数据。CSV文件由任意数目的记录组成,记录间以某种换行符分隔;每条记录由字段组成,字段间的分隔符是其它字符或字符串,最常见的是逗号或制表符。通常,所有记录都有完全相同的字段序列.

特点

- 读取出的数据一般为字符类型,如果是数字需要人为转换为数字

- 以行为单位读取数据

- 列之间以半角逗号或制表符为分隔,一般为半角逗号

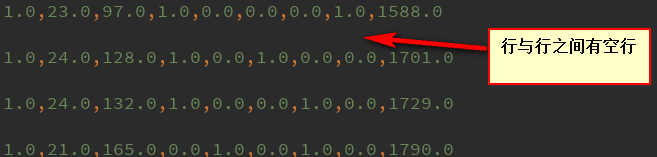

- 一般为每行开头不空格,第一行是属性列,数据列之间以间隔符为间隔无空格,行之间无空行。

行之间无空行十分重要,如果有空行或者数据集中行末有空格,读取数据时一般会出错,引发[list index out of range]错误。PS:已经被这个错误坑过很多次!

使用python I/O写入和读取CSV文件

使用PythonI/O写入csv文件

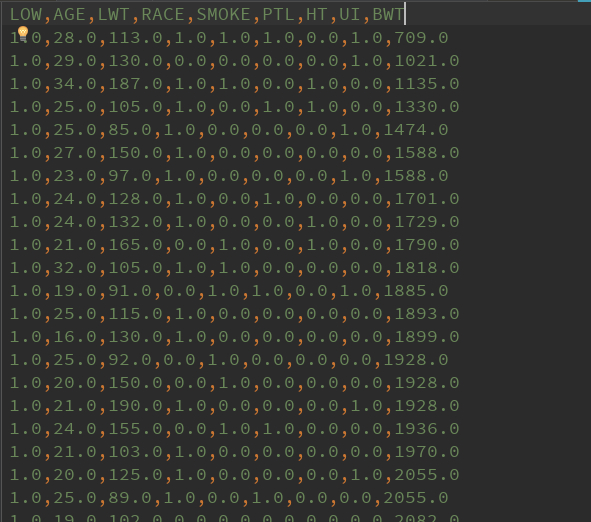

- 以下是将"birthweight.dat"低出生体重的dat文件从作者源处下载下来,并且将其处理后保存到csv文件中的代码。

import csv

import os

import numpy as np

import random

import requests

# name of data file

# 数据集名称

birth_weight_file = 'birth_weight.csv'

# download data and create data file if file does not exist in current directory

# 如果当前文件夹下没有birth_weight.csv数据集则下载dat文件并生成csv文件

if not os.path.exists(birth_weight_file):

birthdata_url = 'https://github.com/nfmcclure/tensorflow_cookbook/raw/master/01_Introduction/07_Working_with_Data_Sources/birthweight_data/birthweight.dat'

birth_file = requests.get(birthdata_url)

birth_data = birth_file.text.split('\r\n')

# split分割函数,以一行作为分割函数,windows中换行符号为'\r\n',每一行后面都有一个'\r\n'符号。

birth_header = birth_data[0].split('\t')

# 每一列的标题,标在第一行,即是birth_data的第一个数据。并使用制表符作为划分。

birth_data = [[float(x) for x in y.split('\t') if len(x) >= 1] for y in birth_data[1:] if len(y) >= 1]

print(np.array(birth_data).shape)

# (189, 9)

# 此为list数据形式不是numpy数组不能使用np,shape函数,但是我们可以使用np.array函数将list对象转化为numpy数组后使用shape属性进行查看。

with open(birth_weight_file, "w", newline='') as f:

# with open(birth_weight_file, "w") as f:

writer = csv.writer(f)

writer.writerows([birth_header])

writer.writerows(birth_data)

f.close()

常见错误list index out of range

- 其中我们重点需要讲的是 with open(birth_weight_file, "w", newline='') as f: 这个语句。表示写入csv文件,如果不加上参数 newline='' 表示以空格作为换行符,而是用 with open(birth_weight_file, "w") as f: 语句。则生成的表格中会出现空行。

- 不仅仅是用python I/O进行csv数据的读写时,利用其余方法读写csv数据,或者从网上下载好csv数据集后都需要查看其每行后有没有空格,或者有没有多余的空行。避免不必要的错误~影响数据分析时的判断。

使用PythonI/O读取csv文件

- 使用python I/O方法进行读取时即是新建一个List 列表然后按照先行后列的顺序(类似C语言中的二维数组)将数据存进空的List对象中,如果需要将其转化为numpy 数组也可以使用np.array(List name)进行对象之间的转化。

birth_data = []

with open(birth_weight_file) as csvfile:

csv_reader = csv.reader(csvfile) # 使用csv.reader读取csvfile中的文件

birth_header = next(csv_reader) # 读取第一行每一列的标题

for row in csv_reader: # 将csv 文件中的数据保存到birth_data中

birth_data.append(row)

birth_data = [[float(x) for x in row] for row in birth_data] # 将数据从string形式转换为float形式

birth_data = np.array(birth_data) # 将list数组转化成array数组便于查看数据结构

birth_header = np.array(birth_header)

print(birth_data.shape) # 利用.shape查看结构。

print(birth_header.shape)

#

# (189, 9)

# (9,)

使用Pandas读取CSV文件

import pandas as pd

csv_data = pd.read_csv('birth_weight.csv') # 读取训练数据

print(csv_data.shape) # (189, 9)

N = 5

csv_batch_data = csv_data.tail(N) # 取后5条数据

print(csv_batch_data.shape) # (5, 9)

train_batch_data = csv_batch_data[list(range(3, 6))] # 取这20条数据的3到5列值(索引从0开始)

print(train_batch_data)

# RACE SMOKE PTL

# 184 0.0 0.0 0.0

# 185 0.0 0.0 1.0

# 186 0.0 1.0 0.0

# 187 0.0 0.0 0.0

# 188 0.0 0.0 1.0使用Tensorflow读取CSV文件

- 本人在平时一般都是使用Tensorflow处理各类数据,所以对于使用Tensorflow读取数据在此不过多的进行解释。下面贴上一段代码,如果有不懂的地方可以看我原来的博客内容。

'''使用Tensorflow读取csv数据'''

filename = 'birth_weight.csv'

file_queue = tf.train.string_input_producer([filename]) # 设置文件名队列,这样做能够批量读取文件夹中的文件

reader = tf.TextLineReader(skip_header_lines=1) # 使用tensorflow文本行阅读器,并且设置忽略第一行

key, value = reader.read(file_queue)

defaults = [[0.], [0.], [0.], [0.], [0.], [0.], [0.], [0.], [0.]] # 设置列属性的数据格式

LOW, AGE, LWT, RACE, SMOKE, PTL, HT, UI, BWT = tf.decode_csv(value, defaults)

# 将读取的数据编码为我们设置的默认格式

vertor_example = tf.stack([AGE, LWT, RACE, SMOKE, PTL, HT, UI]) # 读取得到的中间7列属性为训练特征

vertor_label = tf.stack([BWT]) # 读取得到的BWT值表示训练标签

# 用于给取出的数据添加上batch_size维度,以批处理的方式读出数据。可以设置批处理数据大小,是否重复读取数据,容量大小,队列末尾大小,读取线程等属性。

example_batch, label_batch = tf.train.shuffle_batch([vertor_example, vertor_label], batch_size=10, capacity=100, min_after_dequeue=10)

# 初始化Session

with tf.Session() as sess:

coord = tf.train.Coordinator() # 线程管理器

threads = tf.train.start_queue_runners(coord=coord)

print(sess.run(tf.shape(example_batch))) # [10 7]

print(sess.run(tf.shape(label_batch))) # [10 1]

print(sess.run(example_batch)[3]) # [ 19. 91. 0. 1. 1. 0. 1.]

coord.request_stop()

coord.join(threads)

'''

对于使用所有Tensorflow的I/O操作来说开启和关闭线程管理器都是必要的操作

with tf.Session() as sess:

coord = tf.train.Coordinator() # 线程管理器

threads = tf.train.start_queue_runners(coord=coord)

# Your code here~

coord.request_stop()

coord.join(threads)

'''python读写csv文件的更多相关文章

- 使用Python读写csv文件的三种方法

Python读写csv文件 觉得有用的话,欢迎一起讨论相互学习~Follow Me 前言 逗号分隔值(Comma-Separated Values,CSV,有时也称为字符分隔值,因为分隔字符也可以不是 ...

- (Python基础教程之十二)Python读写CSV文件

Python基础教程 在SublimeEditor中配置Python环境 Python代码中添加注释 Python中的变量的使用 Python中的数据类型 Python中的关键字 Python字符串操 ...

- 使用python读写CSV文件

# -*- coding:UTF-8 -*- __autor__ = 'zhouli' __date__ = '2018/10/25 21:14' import csv with open('resu ...

- python读写csv文件的方法(还没试,先记录一下)

该csv模块定义了以下功能: csv.reader(csvfile,dialect ='excel',** fmtparams ) 返回一个reader对象,它将迭代给定csvfile中的行. csv ...

- python 读写CSV文件

#-*- coding: UTF-8 -*- import csv import os def WriteToCsv(): '''写CSV文件''' titls = ['序号', '链接', '备注' ...

- 一文综述python读写csv xml json文件各种骚操作

Python优越的灵活性和易用性使其成为最受欢迎的编程语言之一,尤其是对数据科学家而言.这在很大程度上是因为使用Python处理大型数据集是很简单的一件事情. 如今,每家科技公司都在制定数据战略. ...

- 如何用python读写CSV 格式文件

工作中经常会碰到读写CSV文件的情况.记录下,方便自己以后查询并与大家一起分享: 写CSV文件方法一: import csv #导入CSV with open("D:\eg ...

- python读取CSV文件

python中有一个读写csv文件的包,直接import csv即可.利用这个python包可以很方便对csv文件进行操作,一些简单的用法如下. 1. 读文件 csv_reader = csv.rea ...

- python3读写csv文件

python读取CSV文件 python中有一个读写csv文件的包,直接import csv即可.利用这个python包可以很方便对csv文件进行操作,一些简单的用法如下. 1. 读文件 csv_ ...

随机推荐

- MySQL Connector 编程

MySQL Connector 是MySQL数据库客户端编程的接口, 它提供了通过网络访问数据库的接口, 这些功能在动态链接库(.dll, .so)或者静态对象库(.lib, .a)中实现. 使用时必 ...

- .Net Core/Framework之Nginx反向代理后获取客户端IP等数据探索

公司项目最近出现获取访问域名.端口.IP错误现象,通过排查发现, 之前项目一直通过Nginx自定义Headers信息来获取,但最近运维人员失误操作造成自定义Header信息丢失,造成项目拿不到对应的数 ...

- GCC编译器原理(一)------GCC 工具:addr2line、ar、as、c++filt和elfedit

1.3 GCC 工具 1.3.1 binutils 工具集 工具 描述 addr2line 给出一个可执行文件的内部地址,addr2line 使用文件中的调试信息将地址翻译成源代码文件名和行号. ar ...

- Spring 快速开始 配置Spring Framework

[配置Spring Framework] 1.XML配置依赖关系 bean是由Springframework管理,我们自己编写bean,Spring也内建了bean,比如ApplicationCont ...

- C# test

//测试对象集合序列化 public void jsonTest() { List<moduleEntity> list = new List<moduleEntity>(); ...

- Linux之恢复误删的文件[针对丢弃到回收站]

1.丢弃到回收站(非RM)掉的文件一般在目录~/.local/share/Trash/files/下: 2.如何恢复呢? 原理很简单,既然它们还在,要么copy,要么移动到一个新的地方即可嘛. //以 ...

- ubuntu下objective-c的编译和运行

ubuntu 下编译objective-c 1.安装编译环境 sudo aptitude install build-essential gobjc gobjc++ gnustep gnustep-d ...

- python 多线程小方法

import time from multiprocessing import Process, Lock, JoinableQueue from multiprocessing import Sem ...

- Linux中的libc和glibc

现在centos6.8-x64系统里的c标准库已经成了glibc,glibc取代了libc,c标准库的位置在/lib64/libc.so.6 以下为转载 一.libc库 Linux平台提供的C标准库包 ...

- Can not deserialize instance of xxx out of START_ARRAY token

Json 反序列化异常 Failed to read HTTP message: org.springframework.http.converter.HttpMessageNotReadableEx ...