Python学习笔记之爬虫

爬虫调度端:启动爬虫,停止爬虫,监视爬虫运行情况

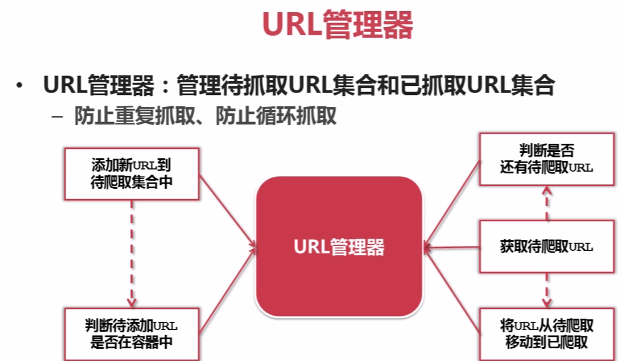

URL管理器:对将要爬取的和已经爬取过的URL进行管理;可取出带爬取的URL,将其传送给“网页下载器”

网页下载器:将URL指定的网页下载,存储成一个字符串,在传送给“网页解析器”

网页解析器:解析网页可解析出①有价值的数据②另一方面,每个网页都包含有指向其他网页的URL,解析出来后可补充进“URL管理器”

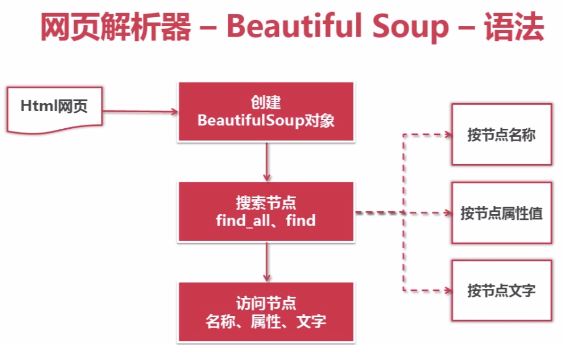

网页解析器——Beautiful Soup-语法:

例如以下代码:

对应的代码:

1、创建BeautifulSoap对象

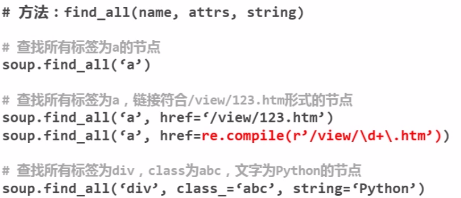

2、搜索节点(find_all,find)

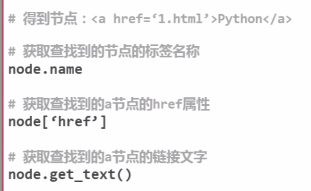

3、访问节点信息

# -*- coding: UTF-8 -*-

from bs4 import BeautifulSoup

import re

html_doc = """

<html><head><title>The Dormouse's story</title></head>

<body>

<p class="title"><b>The Dormouse's story</b></p> <p class="story">Once upon a time there were three little sisters; and their names were

<a href="http://example.com/elsie" class="sister" id="link1">Elsie</a>,

<a href="http://example.com/lacie" class="sister" id="link2">Lacie</a> and

<a href="http://example.com/tillie" class="sister" id="link3">Tillie</a>;

and they lived at the bottom of a well.</p> <p class="story">...</p>

""" soup = BeautifulSoup(html_doc,'html.parser', from_encoding='utf-8')#(文档字符串,解析器,指定编码utf-8)

print('获取所有的连接:')

links = soup.find_all('a')

for link in links:

print link.name, link['href'],link.get_text() print('获取Lacie的连接:')

link_node = soup.find('a', href='http://example.com/lacie')#text='Lacie'

print link_node.name,link_node['href'],link_node.get_text() print('正则匹配')

link_node = soup.find('a', href=re.compile(r'ill'))

print link_node.name,link_node['href'],link.get_text() print('获取p段落文字:')

p_node = soup.find('p', class_='title')#class_

print p_node.name, p_node.get_text()

Python学习笔记之爬虫的更多相关文章

- python学习笔记:"爬虫+有道词典"实现一个简单的英译汉程序

1.有道的翻译 网页:www.youdao.com Fig1 Fig2 Fig3 Fig4 再次点击"自动翻译"->选中'Network'->选中'第一项',如下: F ...

- 吴裕雄--python学习笔记:爬虫基础

一.什么是爬虫 爬虫:一段自动抓取互联网信息的程序,从互联网上抓取对于我们有价值的信息. 二.Python爬虫架构 Python 爬虫架构主要由五个部分组成,分别是调度器.URL管理器.网页下载器.网 ...

- Python学习笔记——与爬虫相关的网络知识

1 关于URL URL(Uniform / Universal Resource Locator):统一资源定位符,用于完整地描述Internet上网页和其他资源的地址的一种标识方法 URL是爬虫的入 ...

- 吴裕雄--python学习笔记:爬虫包的更换

python 3.x报错:No module named 'cookielib'或No module named 'urllib2' 1. ModuleNotFoundError: No module ...

- 吴裕雄--python学习笔记:爬虫

import chardet import urllib.request page = urllib.request.urlopen('http://photo.sina.com.cn/') #打开网 ...

- Python学习笔记_爬虫数据存储为xlsx格式的方法

import requests from bs4 import BeautifulSoup import openpyxl wb=openpyxl.Workbook() sheet=wb.active ...

- golang学习笔记17 爬虫技术路线图,python,java,nodejs,go语言,scrapy主流框架介绍

golang学习笔记17 爬虫技术路线图,python,java,nodejs,go语言,scrapy主流框架介绍 go语言爬虫框架:gocolly/colly,goquery,colly,chrom ...

- python学习笔记目录

人生苦短,我学python学习笔记目录: week1 python入门week2 python基础week3 python进阶week4 python模块week5 python高阶week6 数据结 ...

- Python学习笔记之基础篇(-)python介绍与安装

Python学习笔记之基础篇(-)初识python Python的理念:崇尚优美.清晰.简单,是一个优秀并广泛使用的语言. python的历史: 1989年,为了打发圣诞节假期,作者Guido开始写P ...

随机推荐

- vuejs实现数据驱动视图原理

什么是数据驱动 数据驱动是vuejs最大的特点.在vuejs中,所谓的数据驱动就是当数据发生变化的时候,用户界面发生相应的变化,开发者不需要手动的去修改dom. 比如说我们点击一个button,需要元 ...

- css实现0.5像素的边框

公司的设计师在做设计图的时候都是以iphone6(宽为750物理像素)为基准进行设计的.iphone6的设备像素比(即css像素与物理像素的比例)是2,所以设计师在设计图画了边框为1px的box的时候 ...

- bzoj千题计划153:bzoj2431: [HAOI2009]逆序对数列

http://www.lydsy.com/JudgeOnline/problem.php?id=2431 dp[i][j] 表示i的排列,有j个逆序对的方案数 加入i+1,此时i+1是排列中最大的数, ...

- Visual Studio Code 教程之————入门篇

Visual Studio代码是一个轻量级但功能强大的源代码编辑器,可在您的桌面上运行,适用于Windows,macOS和Linux.它内置对JavaScript,TypeScript和Node.js ...

- python 分布式进程体验

抽了点时间体验了一把python 分布式进程,有点像分布式计算的意思,不过我现在还没有这个需求,先把简单体验的脚本发出来,供路过的各位高手指教 注:需要先下载multiprocessing 的pyth ...

- CentOS 6 / RHEL 6配置bonding 4模式

实现bond 802.3ad or 4 模式:(IEEE 802.3ad), 方式:创建一个整合的组,这个组会共享网速和网络双工(duplex)设置.模式 4 会根据 IEEE 802.3ad 标准使 ...

- Linux的基础优化-2

1.启动网卡 ifup eth0 2.SSH链接 ifconfig 查看IP后SSH终端连接3.更新源 最小化安装是没有wget工具的,必须先安装再修改源 yum install wget 备份原系统 ...

- prim算法记录路径

题目链接:https://vjudge.net/contest/66965#problem/H 代码: #include<iostream> #include<string> ...

- [转载]Windows服务编写原理及探讨(3)

(三)对服务的深入讨论之下 现在我们还剩下一个函数可以在细节上讨论,那就是服务的CtrlHandler函数. 当调用RegisterServiceCtrlHandler函数时,SCM得到并保存这个回调 ...

- Owin WebApi版本控制

public class WebApiControllerSelector : IHttpControllerSelector { private const string NamespaceKey ...