[matlab工具箱] 神经网络Neural Net

//目的是学习在BP神经网络的基础上添加遗传算法,蚁群算法等优化算法来优化网络,这是后话。

先简单了解了MATLAB中的神经网络工具箱,工具箱功能还是非常强大的,已经可以拟合出非常多的曲线来分析了。

神经网络工具箱选择(4种)

今天下载了自带的example跑了一次试一下

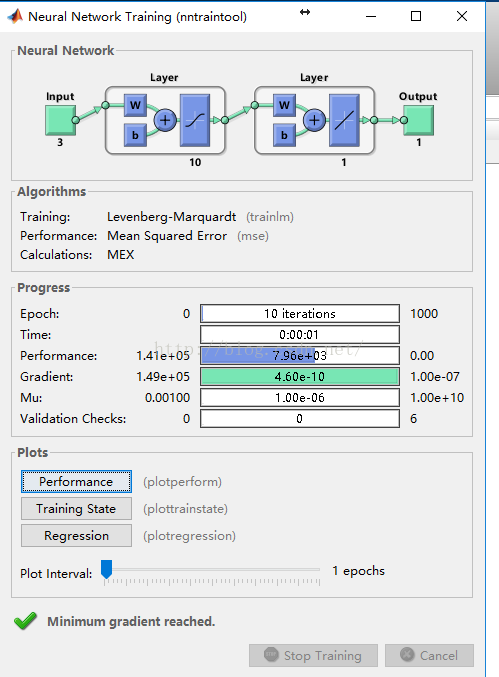

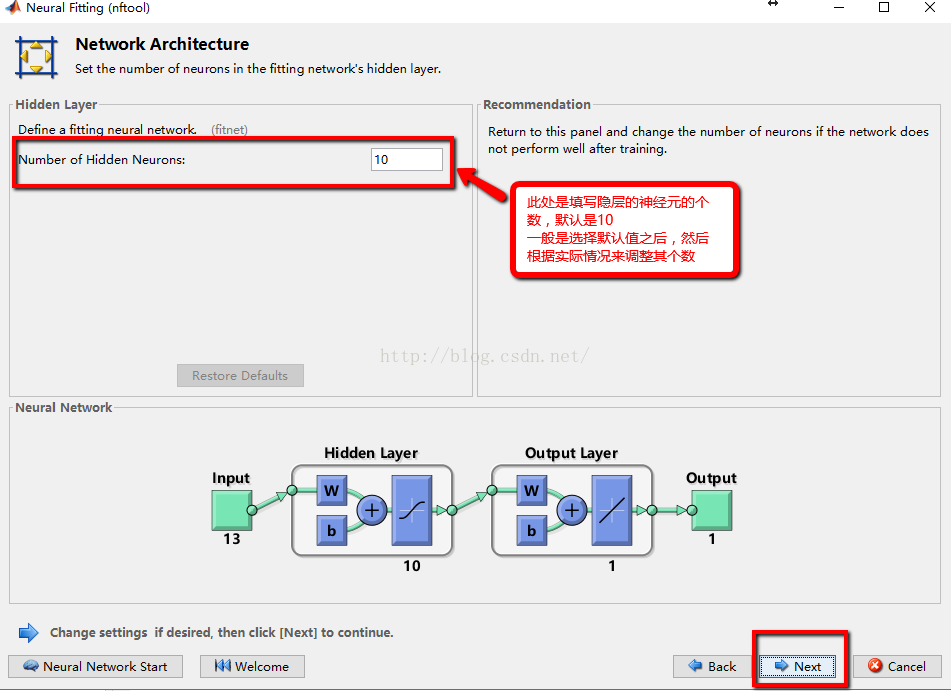

选择隐藏神经元个数

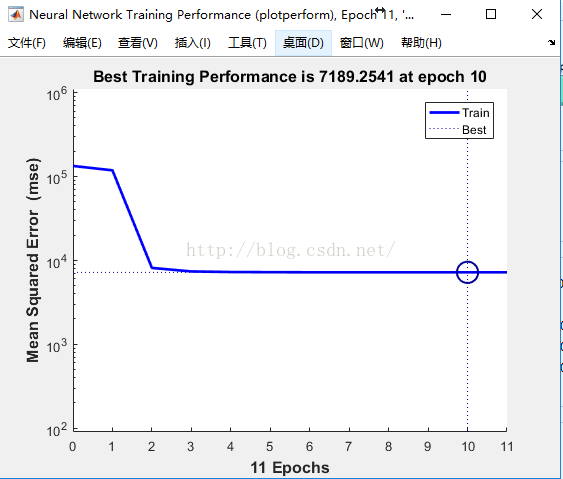

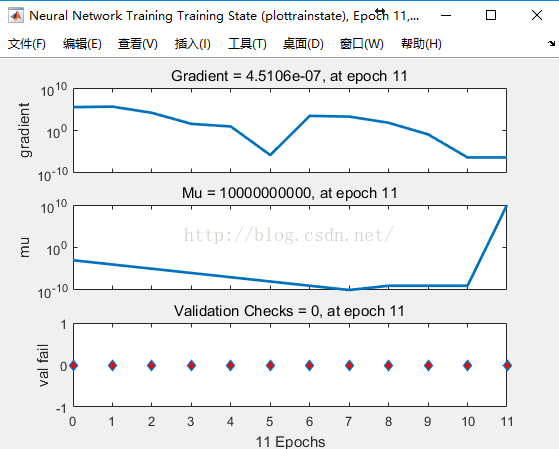

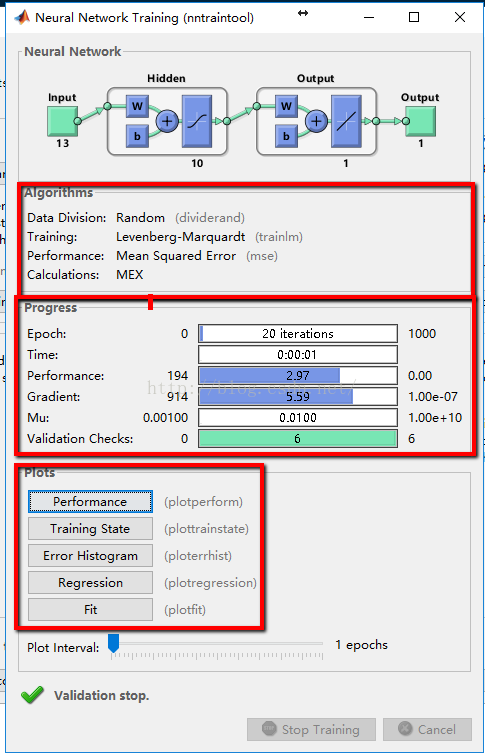

训练结束后可以在plot查看各种图表,这里只对工具箱操作做简单介绍

最近一段时间在研究如何利用预测其销量个数,在网上搜索了一下,发现了很多模型来预测,比如利用回归模型、时间序列模型,GM(1,1)模型,可是自己在结合实际的工作内容,发现这几种模型预测的精度不是很高,于是再在网上进行搜索,发现神经网络模型可以来预测,并且有很多是结合时间序列或者SVM(支持向量机)等组合模型来进行预测,本文结合实际数据,选取了常用的BP神经网络算法,其算法原理,因网上一大堆,所以在此不必一一展示,并参考了bp神经网络进行交通预测的Matlab源代码这篇博文,运用matlab 2016a,给出了下面的代码,并最终进行了预测

clc

clear all

close all

%bp 神经网络的预测代码

%载入输出和输入数据

load C:\Users\amzon\Desktop\p.txt;

load C:\Users\amzon\Desktop\t.txt;

%保存数据到matlab的工作路径里面

save p.mat;

save t.mat;%注意t必须为行向量

%赋值给输出p和输入t

p=p;

t=t;

%数据的归一化处理,利用mapminmax函数,使数值归一化到[-1.1]之间

%该函数使用方法如下:[y,ps] =mapminmax(x,ymin,ymax),x需归化的数据输入,

%ymin,ymax为需归化到的范围,不填默认为归化到[-,]

%返回归化后的值y,以及参数ps,ps在结果反归一化中,需要调用

[p1,ps]=mapminmax(p);

[t1,ts]=mapminmax(t);

%确定训练数据,测试数据,一般是随机的从样本中选取70%的数据作为训练数据

%%的数据作为测试数据,一般是使用函数dividerand,其一般的使用方法如下:

%[trainInd,valInd,testInd] = dividerand(Q,trainRatio,valRatio,testRatio)

[trainsample.p,valsample.p,testsample.p] =dividerand(p,0.7,0.15,0.15);

[trainsample.t,valsample.t,testsample.t] =dividerand(t,0.7,0.15,0.15);

%建立反向传播算法的BP神经网络,使用newff函数,其一般的使用方法如下

%net = newff(minmax(p),[隐层的神经元的个数,输出层的神经元的个数],{隐层神经元的传输函数,输出层的传输函数},'反向传播的训练函数'),其中p为输入数据,t为输出数据

%tf为神经网络的传输函数,默认为'tansig'函数为隐层的传输函数,

%purelin函数为输出层的传输函数

%一般在这里还有其他的传输的函数一般的如下,如果预测出来的效果不是很好,可以调节

%TF1 = 'tansig';TF2 = 'logsig';

%TF1 = 'logsig';TF2 = 'purelin';

%TF1 = 'logsig';TF2 = 'logsig';

%TF1 = 'purelin';TF2 = 'purelin';

TF1='tansig';TF2='purelin';

net=newff(minmax(p),[,],{TF1 TF2},'traingdm');%网络创建

%网络参数的设置

net.trainParam.epochs=;%训练次数设置

net.trainParam.goal=1e-;%训练目标设置

net.trainParam.lr=0.01;%学习率设置,应设置为较少值,太大虽然会在开始加快收敛速度,但临近最佳点时,会产生动荡,而致使无法收敛

net.trainParam.mc=0.9;%动量因子的设置,默认为0.

net.trainParam.show=;%显示的间隔次数

% 指定训练参数

% net.trainFcn = 'traingd'; % 梯度下降算法

% net.trainFcn = 'traingdm'; % 动量梯度下降算法

% net.trainFcn = 'traingda'; % 变学习率梯度下降算法

% net.trainFcn = 'traingdx'; % 变学习率动量梯度下降算法

% (大型网络的首选算法)

% net.trainFcn = 'trainrp'; % RPROP(弹性BP)算法,内存需求最小

% 共轭梯度算法

% net.trainFcn = 'traincgf'; %Fletcher-Reeves修正算法

% net.trainFcn = 'traincgp'; %Polak-Ribiere修正算法,内存需求比Fletcher-Reeves修正算法略大

% net.trainFcn = 'traincgb'; % Powell-Beal复位算法,内存需求比Polak-Ribiere修正算法略大

% (大型网络的首选算法)

%net.trainFcn = 'trainscg'; % ScaledConjugate Gradient算法,内存需求与Fletcher-Reeves修正算法相同,计算量比上面三种算法都小很多

% net.trainFcn = 'trainbfg'; %Quasi-Newton Algorithms - BFGS Algorithm,计算量和内存需求均比共轭梯度算法大,但收敛比较快

% net.trainFcn = 'trainoss'; % OneStep Secant Algorithm,计算量和内存需求均比BFGS算法小,比共轭梯度算法略大

% (中型网络的首选算法)

%net.trainFcn = 'trainlm'; %Levenberg-Marquardt算法,内存需求最大,收敛速度最快

% net.trainFcn = 'trainbr'; % 贝叶斯正则化算法

% 有代表性的五种算法为:'traingdx','trainrp','trainscg','trainoss', 'trainlm'

%在这里一般是选取'trainlm'函数来训练,其算对对应的是Levenberg-Marquardt算法

net.trainFcn='trainlm';

[net,tr]=train(net,trainsample.p,trainsample.t);

%计算仿真,其一般用sim函数

[normtrainoutput,trainPerf]=sim(net,trainsample.p,[],[],trainsample.t);%训练的数据,根据BP得到的结果

[normvalidateoutput,validatePerf]=sim(net,valsample.p,[],[],valsample.t);%验证的数据,经BP得到的结果

[normtestoutput,testPerf]=sim(net,testsample.p,[],[],testsample.t);%测试数据,经BP得到的结果

%将所得的结果进行反归一化,得到其拟合的数据

trainoutput=mapminmax('reverse',normtrainoutput,ts);

validateoutput=mapminmax('reverse',normvalidateoutput,ts);

testoutput=mapminmax('reverse',normtestoutput,ts);

%正常输入的数据的反归一化的处理,得到其正式值

trainvalue=mapminmax('reverse',trainsample.t,ts);%正常的验证数据

validatevalue=mapminmax('reverse',valsample.t,ts);%正常的验证的数据

testvalue=mapminmax('reverse',testsample.t,ts);%正常的测试数据

%做预测,输入要预测的数据pnew

pnew=[,,]';

pnewn=mapminmax(pnew);

anewn=sim(net,pnewn);

anew=mapminmax('reverse',anewn,ts);

%绝对误差的计算

errors=trainvalue-trainoutput;

%plotregression拟合图

figure,plotregression(trainvalue,trainoutput)

%误差图

figure,plot(:length(errors),errors,'-b')

title('误差变化图')

%误差值的正态性的检验

figure,hist(errors);%频数直方图

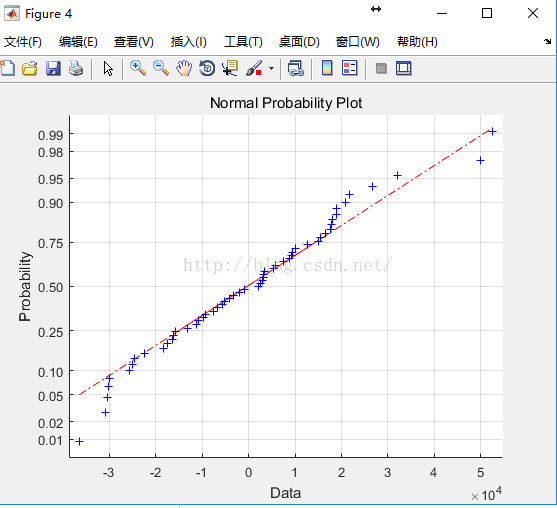

figure,normplot(errors);%Q-Q图

[muhat,sigmahat,muci,sigmaci]=normfit(errors);%参数估计 均值,方差,均值的0.95置信区间,方差的0.95置信区间

[h1,sig,ci]= ttest(errors,muhat);%假设检验

figure, ploterrcorr(errors);%绘制误差的自相关图

figure, parcorr(errors);%绘制偏相关图

运行之后的,结果如下:

BP神经网络的结果分析图

训练数据的梯度和均方误差之间的关系图

验证数据的梯度与学习次数

残差的正态的检验图(Q-Q图)

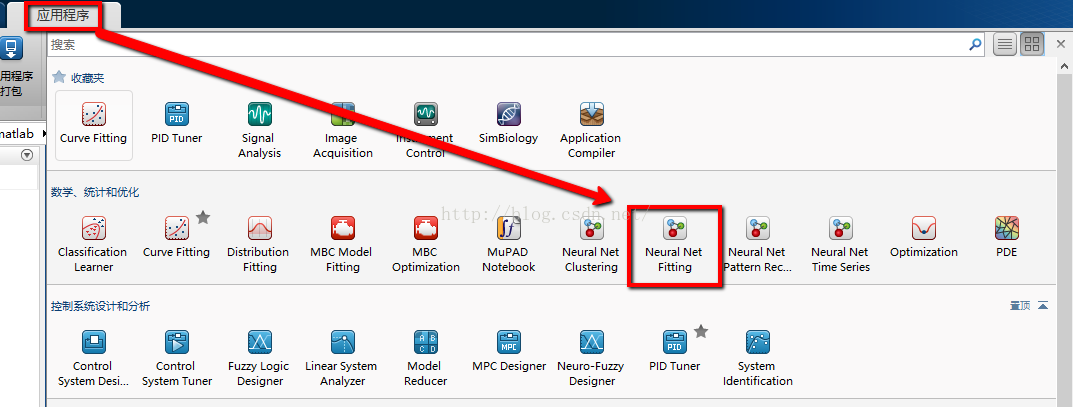

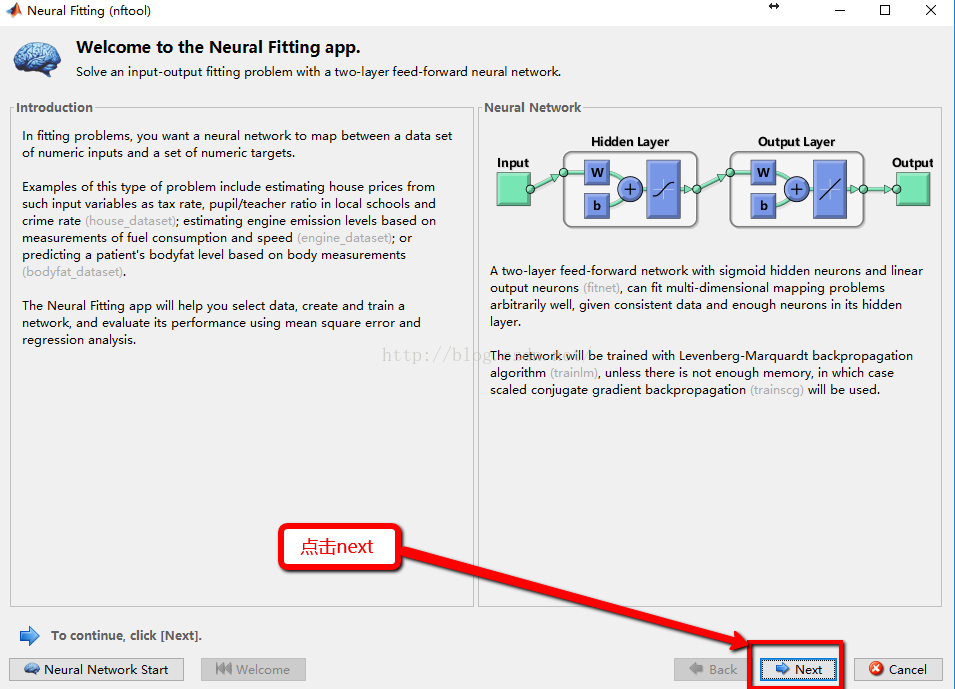

在网上,发现可以通过神经网络工具箱这个GUI界面来创建神经网络,其一般的操作步骤如下:

1:在输入命令里面输入nntool命令,或者在应用程序这个选项下找到Netrual Net Fitting 这个应用程序,点击打开,就能看见如下界面

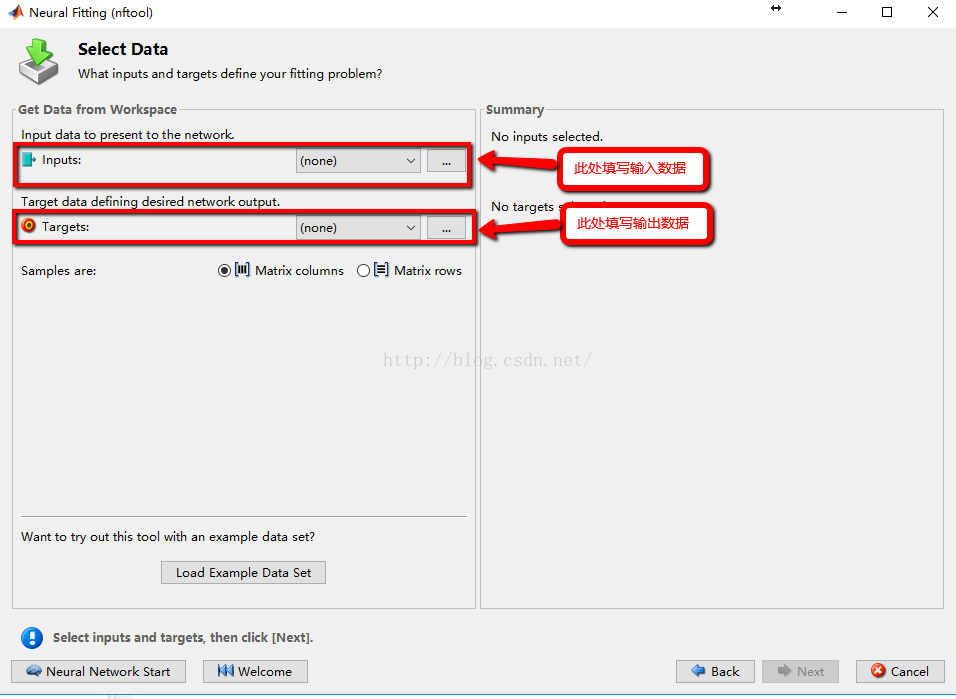

2:输入数据和输出数据的导入(在本文中选取了matlab自带的案例数据)

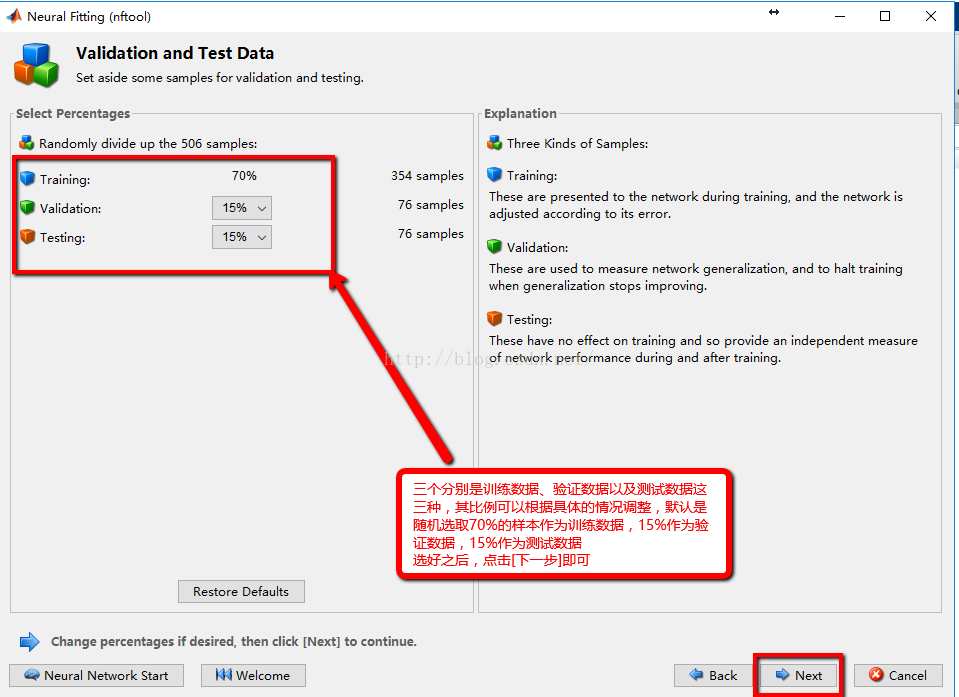

3:随机选择三种类型的数据所占的样本量的比例,一般选取默认即可

4:隐层神经元的确定

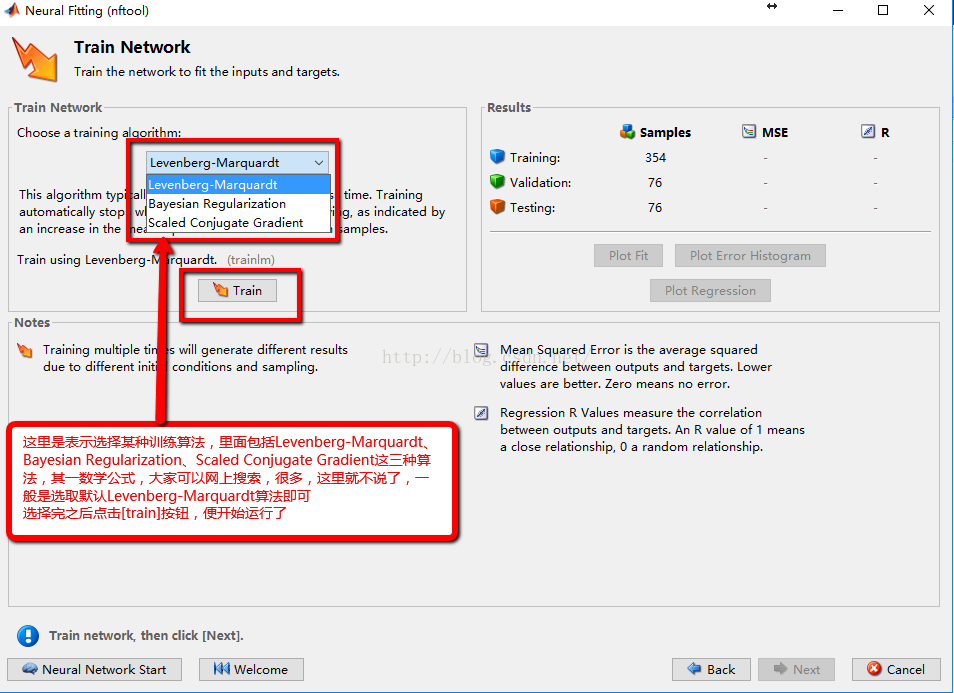

5:训练算法的选取,一般是选择默认即可,选择完成后点击<train>按钮即可运行程序

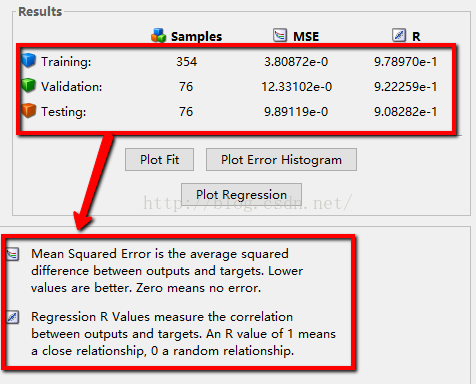

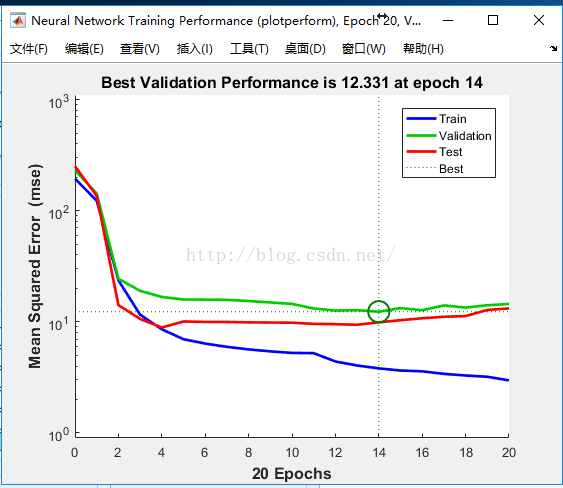

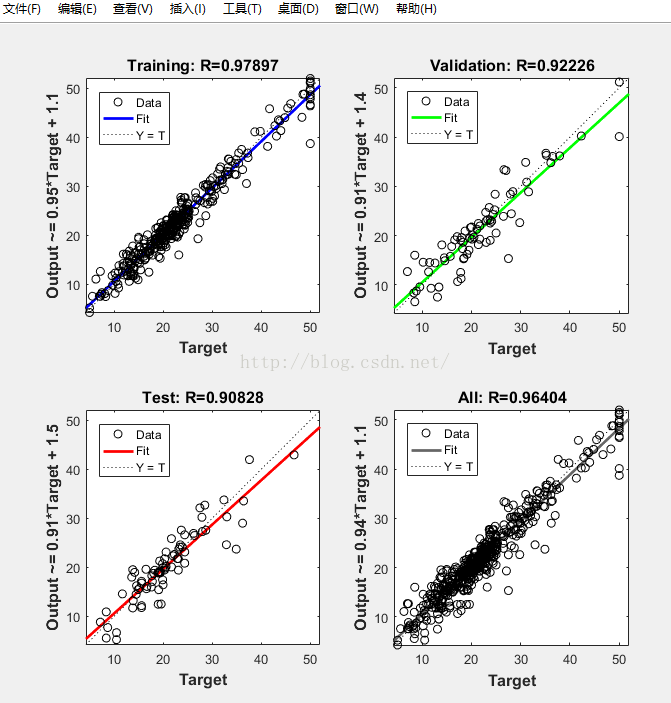

6:根据得到的结果,一般是MSE的值越小,R值越接近1,其训练的效果比较,并第二张图给出了神经网络的各参数的设置以及其最终的结果,其拟合图R越接近1,模型拟合的更好

最终的结果图

7:如果所得到的模型不能满足你的需求,则需重复上述的步骤直至能够得到你想要的精确度

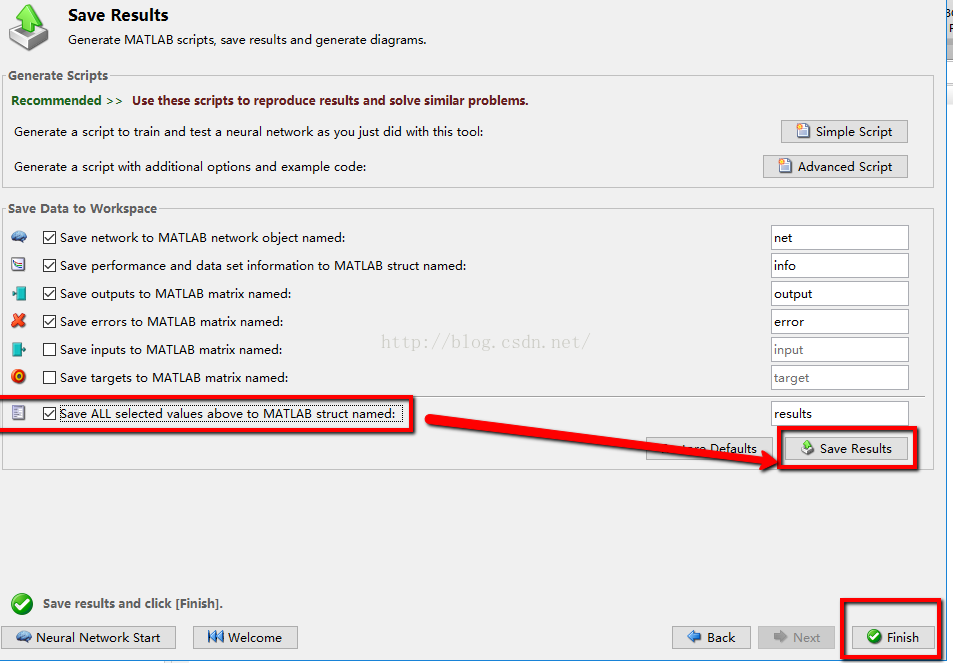

8:将最终的得到的各种数据以及其拟合值进行保存,然后查看,就可以得到所要的拟合值

最后参考了网上和MATLAB的帮助,给出了一些与神经网络相关的函数,希望能够帮助大家。。

图形用户界面功能。

nnstart - 神经网络启动GUI

nctool - 神经网络分类工具

nftool - 神经网络的拟合工具

nntraintool - 神经网络的训练工具

nprtool - 神经网络模式识别工具

ntstool - NFTool神经网络时间序列的工具

nntool - 神经网络工具箱的图形用户界面。

查看 - 查看一个神经网络。

网络的建立功能。

cascadeforwardnet - 串级,前馈神经网络。

competlayer - 竞争神经层。

distdelaynet - 分布时滞的神经网络。

elmannet - Elman神经网络。

feedforwardnet - 前馈神经网络。

fitnet - 函数拟合神经网络。

layrecnet - 分层递归神经网络。

linearlayer - 线性神经层。

lvqnet - 学习矢量量化(LVQ)神经网络。

narnet - 非线性自结合的时间序列网络。

narxnet - 非线性自结合的时间序列与外部输入网络。

newgrnn - 设计一个广义回归神经网络。

newhop - 建立经常性的Hopfield网络。

newlind - 设计一个线性层。

newpnn - 设计概率神经网络。

newrb - 径向基网络设计。

newrbe - 设计一个确切的径向基网络。

patternnet - 神经网络模式识别。

感知 - 感知。

selforgmap - 自组织特征映射。

timedelaynet - 时滞神经网络。

利用网络。

网络 - 创建一个自定义神经网络。

SIM卡 - 模拟一个神经网络。

初始化 - 初始化一个神经网络。

适应 - 允许一个神经网络来适应。

火车 - 火车的神经网络。

DISP键 - 显示一个神经网络的属性。

显示 - 显示的名称和神经网络属性

adddelay - 添加延迟神经网络的反应。

closeloop - 神经网络的开放反馈转换到关闭反馈回路。

formwb - 表格偏见和成单个向量的权重。

getwb - 将它作为一个单一向量中的所有网络权值和偏差。

noloop - 删除神经网络的开放和关闭反馈回路。

开环 - 转换神经网络反馈,打开封闭的反馈循环。

removedelay - 删除延迟神经网络的反应。

separatewb - 独立的偏见和重量/偏置向量的权重。

setwb - 将所有与单个矢量网络权值和偏差。

Simulink的支持。

gensim - 生成Simulink模块来模拟神经网络。

setsiminit - 集神经网络的Simulink模块的初始条件

getsiminit - 获取神经网络Simulink模块的初始条件

神经元 - 神经网络Simulink的模块库。

培训职能。

trainb - 批具有重量与偏见学习规则的培训。

trainbfg - 的BFGS拟牛顿倒传递。

trainbr - 贝叶斯规则的BP算法。

trainbu - 与重量与偏见一批无监督学习规则的培训。

trainbuwb - 与体重无监督学习规则与偏见一批培训。

trainc - 循环顺序重量/偏见的培训。

traincgb - 共轭鲍威尔比尔重新启动梯度反向传播。

traincgf - 共轭弗莱彻-里夫斯更新梯度反向传播。

traincgp - 共轭波拉克- Ribiere更新梯度反向传播。

traingd - 梯度下降反向传播。

traingda - 具有自适应LR的反向传播梯度下降。

traingdm - 与动量梯度下降。

traingdx - 梯度下降瓦特/惯性与自适应LR的反向传播。

trainlm - 采用Levenberg -马奎德倒传递。

trainoss - 一步割线倒传递。

trainr - 随机重量/偏见的培训。

trainrp - RPROP反向传播。

trainru - 无监督随机重量/偏见的培训。

火车 - 顺序重量/偏见的培训。

trainscg - 规模化共轭梯度BP算法。

绘图功能。

plotconfusion - 图分类混淆矩阵。

ploterrcorr - 误差自相关时间序列图。

ploterrhist - 绘制误差直方图。

plotfit - 绘图功能适合。

plotinerrcorr - 图输入错误的时间序列的互相关。

plotperform - 小区网络性能。

plotregression - 线性回归情节。

plotresponse - 动态网络图的时间序列响应。

plotroc - 绘制受试者工作特征。

plotsomhits - 小区自组织图来样打。

plotsomnc - 小区自组织映射邻居的连接。

plotsomnd - 小区自组织映射邻居的距离。

plotsomplanes - 小区自组织映射重量的飞机。

plotsompos - 小区自组织映射重量立场。

plotsomtop - 小区自组织映射的拓扑结构。

plottrainstate - 情节训练状态值。

plotwb - 图寒春重量和偏差值图。

列出其他神经网络实现的功能。

nnadapt - 适应职能。

nnderivative - 衍生功能。

nndistance - 距离函数。

nndivision - 除功能。

nninitlayer - 初始化层功能。

nninitnetwork - 初始化网络功能。

nninitweight - 初始化权函数。

nnlearn - 学习功能。

nnnetinput - 净输入功能。

nnperformance - 性能的功能。

nnprocess - 处理功能。

nnsearch - 线搜索功能。

nntopology - 拓扑结构的功能。

nntransfer - 传递函数。

nnweight - 重量的功能。

nndemos - 神经网络工具箱的示威。

nndatasets - 神经网络工具箱的数据集。

nntextdemos - 神经网络设计教科书的示威。

nntextbook - 神经网络设计教科书的资讯。

[matlab工具箱] 神经网络Neural Net的更多相关文章

- [matlab]bp神经网络工具箱学习笔记

基本就三个函数: newff():创建一个bp神经网络 train():训练函数 sim():仿真函数 同时具有可视化界面,但目前不知道可视化界面如何进行仿真,且设置不太全 工具箱:Neural ne ...

- [zz] MATLAB工具箱介绍

http://blog.sina.com.cn/s/blog_57235cc701012kfb.html Toolbox工具箱 序号 工具箱 备注 数学.统计与优化 1 Symbolic Ma ...

- Matlab 工具箱介绍

Toolbox工具箱 序号 工具箱 备注 数学.统计与优化 1 Symbolic Math Toolbox 符号数学工具箱 2 Partial Differential Euqation Toolbo ...

- Stanford机器学习笔记-4. 神经网络Neural Networks (part one)

4. Neural Networks (part one) Content: 4. Neural Networks (part one) 4.1 Non-linear Classification. ...

- Matlab与神经网络入门

第一节.神经网络基本原理 1. 人工神经元( Artificial Neuron )模型 人工神经元是神经网络的基本元素,其原理可以用下图表示: 图1. 人工神经元模型 图中x1~xn是从其他神经 ...

- 机器学习公开课笔记(4):神经网络(Neural Network)——表示

动机(Motivation) 对于非线性分类问题,如果用多元线性回归进行分类,需要构造许多高次项,导致特征特多学习参数过多,从而复杂度太高. 神经网络(Neural Network) 一个简单的神经网 ...

- 几个模式识别和计算机视觉相关的Matlab工具箱

模式识别.计算机视觉.图像处理等领域大部分是对一些图像等数据的处理,比较常用的语言是C++和Matlab,相应也对应很多库,象opencv等,都是很好用功能也很强大,但是对于数据处理更方便的应该还是M ...

- paper 75:使用MATLAB的神经网络工具箱创建神经网络

% 生成训练样本集 clear all; clc; P=[110 0.807 240 0.2 15 1 18 2 1.5; 110 2.865 240 0.1 15 2 12 1 2; 110 2.5 ...

- MATLAB的神经网络工具箱介绍

一.使用matlab2010b以后的版本会有完整的神经网络工具箱,使用nnstart可以调出toolbox,然后选择需要的功能,导入数据,选择训练参数和每层神经元个数,最后训练会输出网络与结果. 二. ...

随机推荐

- vue 项目之后生成的 dist 文件该怎么在本地启动运行

简单高效 npm i -g servecd distserve

- java 堆 排序学习

/** * <html> * <body> * <P> Copyright 1994 JsonInternational</p> * <p> ...

- C#判断字符串中包含某个字符的个数

//定义字符串 var Email= "humakesdkj@idsk@"; //获取@字符出现的次数 int num = Regex.Matches(Email, "@ ...

- PreparedStatement和批处理

1.概述 PreparedStatement 接口继承了 Statement,并与之在两方面有所不同,它表示预编译的 SQL 语句对象. 首先,数据库会对预编译语句提供性能优化.因为预编译语句有可能被 ...

- JavaScript中匿名函数this指向问题

this对象是在运行时基于函数执行环境绑定的,在全局函数中,this=window,在函数被作为某个对象的方法调用时,this等于这个对象. 但是匿名函数的执行环境是全局性的,所以匿名函数的this指 ...

- Qt 窗口相关的常用操作

PS: 本文使用的是Qt 4.8.4版本,不同版本代码可能会有差异 设置窗口标题 setWindowTitle(QString::fromLocal8Bit("易语言")); 禁用 ...

- Android 低功耗蓝牙BLE 开发注意事项

基本概念和问题 1.蓝牙设计范式? 当手机通过扫描低功耗蓝牙设备并连接上后,手机与蓝牙设备构成了客户端-服务端架构.手机通过连接蓝牙设备,可以读取蓝牙设备上的信息.手机就是客户端,蓝牙设备是服务端. ...

- Jmeter学习笔记(八)——监听器元件之聚合报告

1.聚合报告添加 聚合报告是常用的监听器之一,添加路径: 点击线程组->添加->监听器->聚合报告 2.聚合报告界面及说明 Label:请求的名称,就是我们在进行测试的httpreq ...

- mysqldump 全备

[root@db01 b]#mysqldump -uroot -poldboy123 -A -R --triggers --master-data=2 --single-transaction | g ...

- vue-cli3.0 脚手架搭建项目的过程详解

1.安装vue-cli 3.0 ? 1 2 3 npm install -g @vue/cli # or yarn global add @vue/cli 安装成功后查看版本:vue -V(大写的V) ...